数据传输服务DTS(Data Transmission Service)支持数据迁移、数据订阅和数据实时同步功能,帮助您实现多种典型应用场景。

不停机迁移数据库

传输方式:数据迁移

为了保证数据的一致性,传统的迁移过程需要您在迁移数据时停止向源数据库写入数据。 根据数据量和网络条件,迁移过程可能需要几个小时甚至几天的时间。 这个漫长的过程可能会对您的业务产生很大的影响。

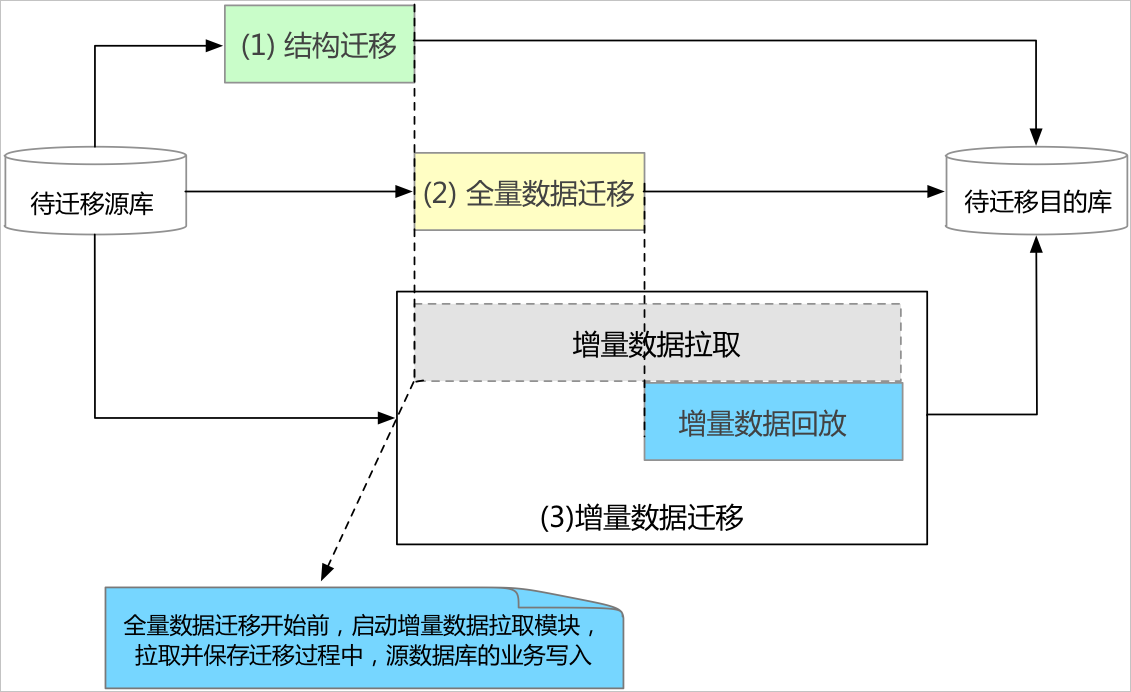

DTS则可以帮助您以最小化的停机时间迁移您的数据。 在数据迁移期间,您的应用程序仍可以保持运行状态。 唯一的停机时间是当您将应用程序切换到目标数据库时。 通常,您可以将此切换窗口降低到分钟级别。 数据迁移的流程如下图所示。

数据迁移过程包括三个阶段,即结构迁移、全量数据迁移和增量数据迁移。 在增量数据迁移期间,源数据库中正在进行的数据变更会实时同步到目标数据库。 迁移完成后,您可以验证迁移到目标数据库的数据和结构是否与您的应用程序完全兼容。 当验证通过后,即可将应用程序切换到目标数据库,从而实现平滑迁移。

数据异地灾备

传输方式:数据同步

如果您的应用程序部署在单个地域中,可能会因为断电、网络中断等不可抗因素而导致服务中断。

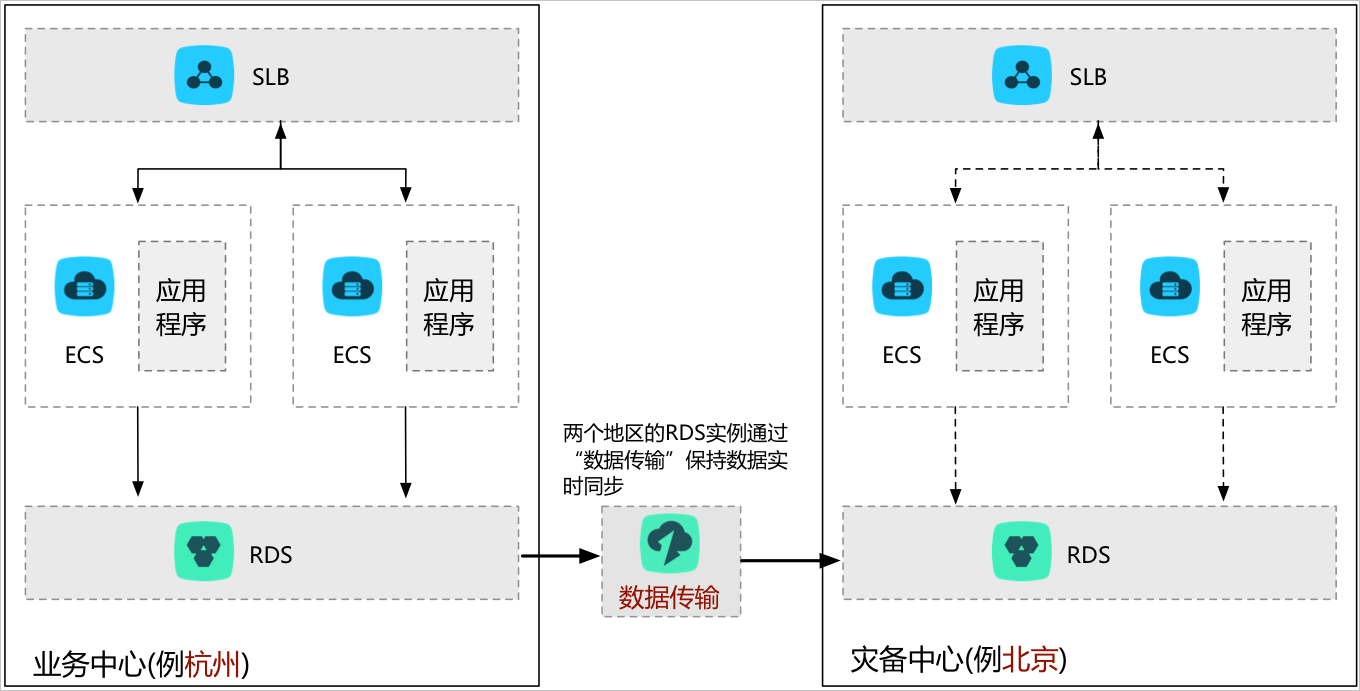

针对这种情况,您可以在另一个地域构建灾备中心,以提高服务可用性。 DTS会在业务中心和灾备中心之间持续同步数据更新,并保持地域间副本同步。 如果主地域发生故障,您可以将用户请求切换到灾备地域。

异地多活

随着业务的快速发展和用户数量的增长,如果业务部署在单个地域中,可能会面临如下问题:

- 用户在地理位置上分布较广,地理位置较远的用户访问延迟较高,影响用户体验。

- 单个地域底层基础设施的能力限制了业务扩展,例如供电能力,网络带宽建设能力等。

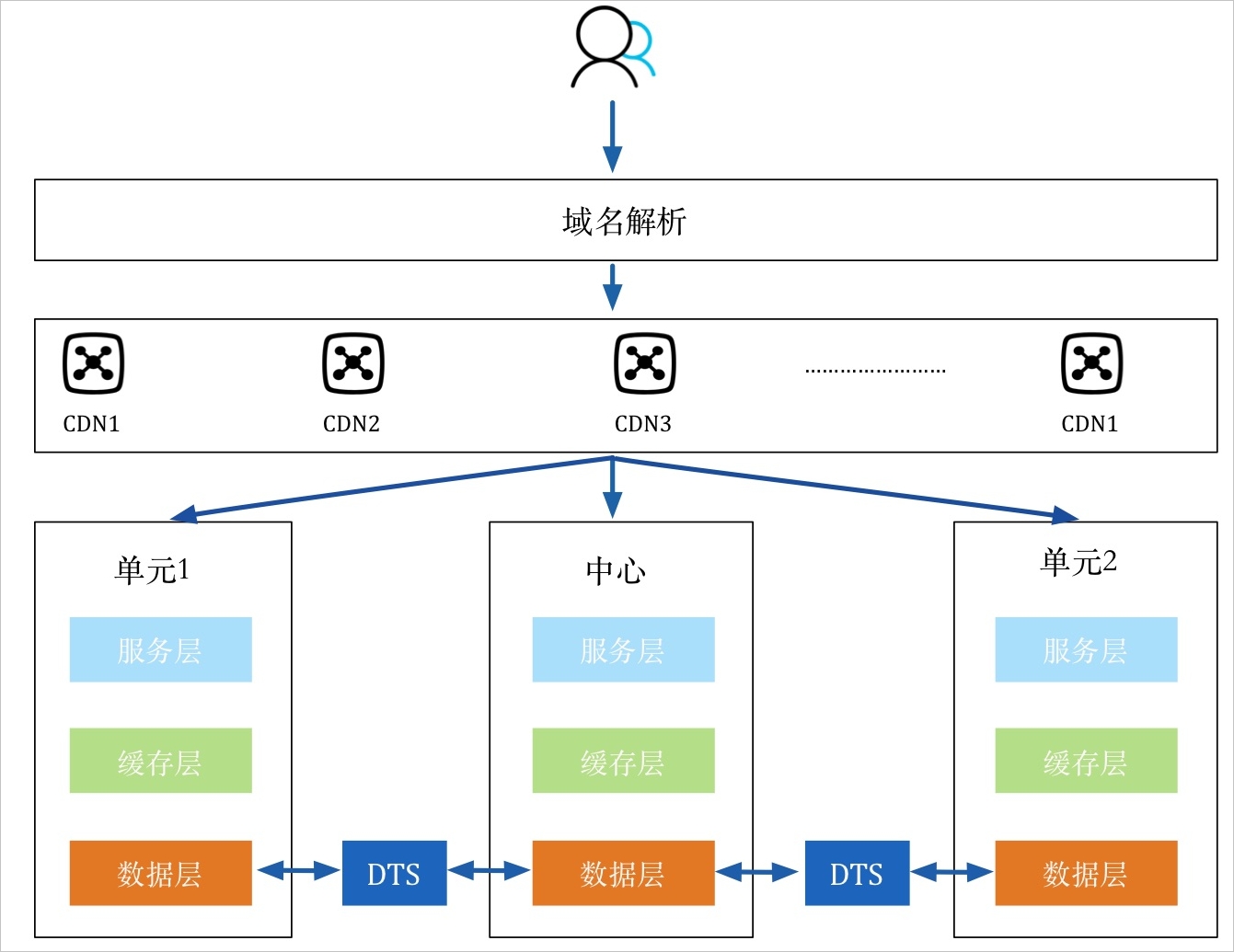

为解决上述问题,您可以在同城/异地构建多个业务单元。各个业务单元之间通过DTS实现数据的双向实时同步,保障全局数据的一致性。当任何一个单元出现故障时,您只需将该单元的流量切换至其他单元即可,可实现业务的秒级恢复,有效地保障了服务的高可用性。

您还可以根据业务的某个维度将业务流量分流至各个业务单元。例如,按照用户所属区域划分各单元的流量,实现用户就近访问,降低网络延迟,提升用户体验。同时,各个业务单元分布在不同的地域,可以有效解决单地域的基础设施限制业务扩展的问题。

加速全球化业务访问速度

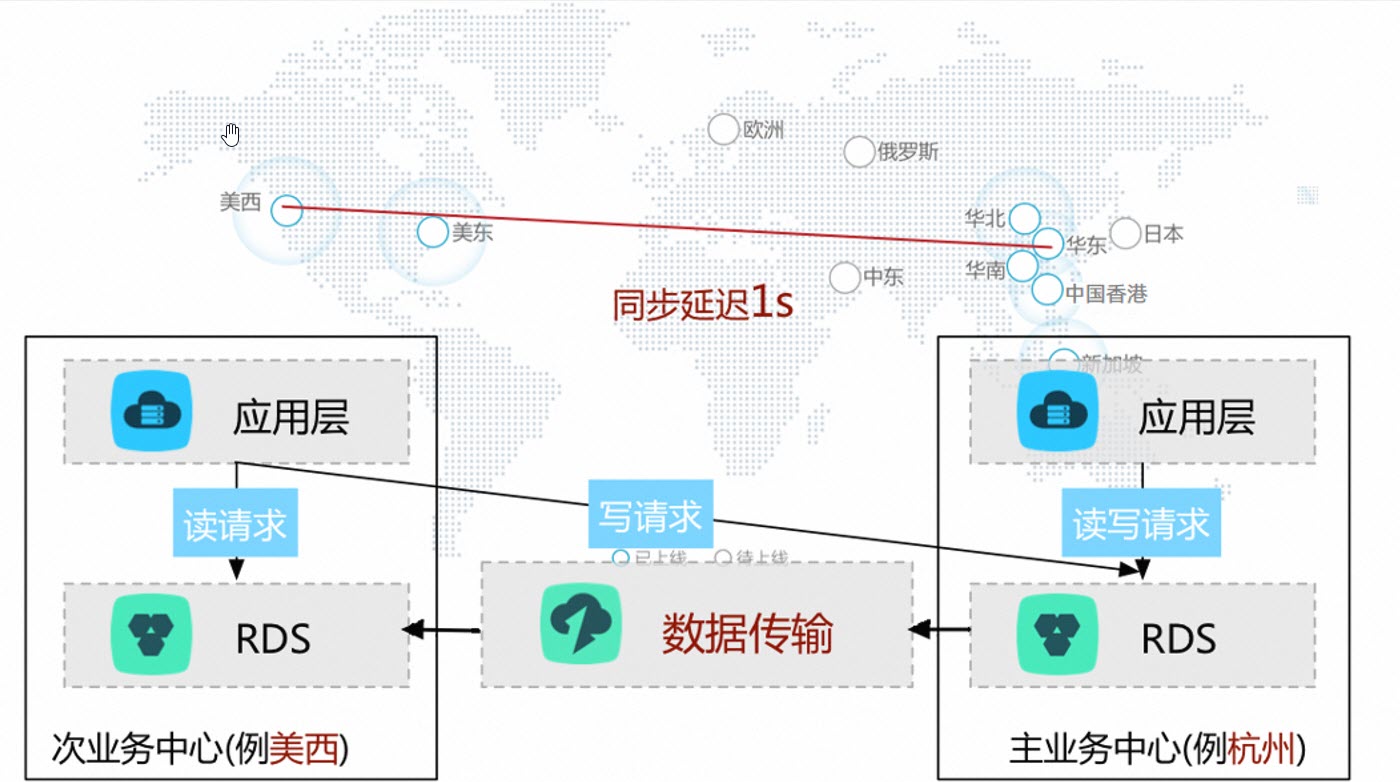

对于全球化业务,如果按照传统架构只在单个地区部署业务,那么跨境访问的用户访问服务时,访问延迟非常大,用户体验较差。为加速全球化业务访问速度,优化访问体验,您可以将架构调整如下。

本方案中,所有地区用户的写请求全部路由回主业务中心。通过DTS将主业务中心的数据实时同步至次业务中心,各个地区的用户的读请求,则路由至就近的次业务中心,从而避免远距离访问,加速了全球化业务的访问速度。

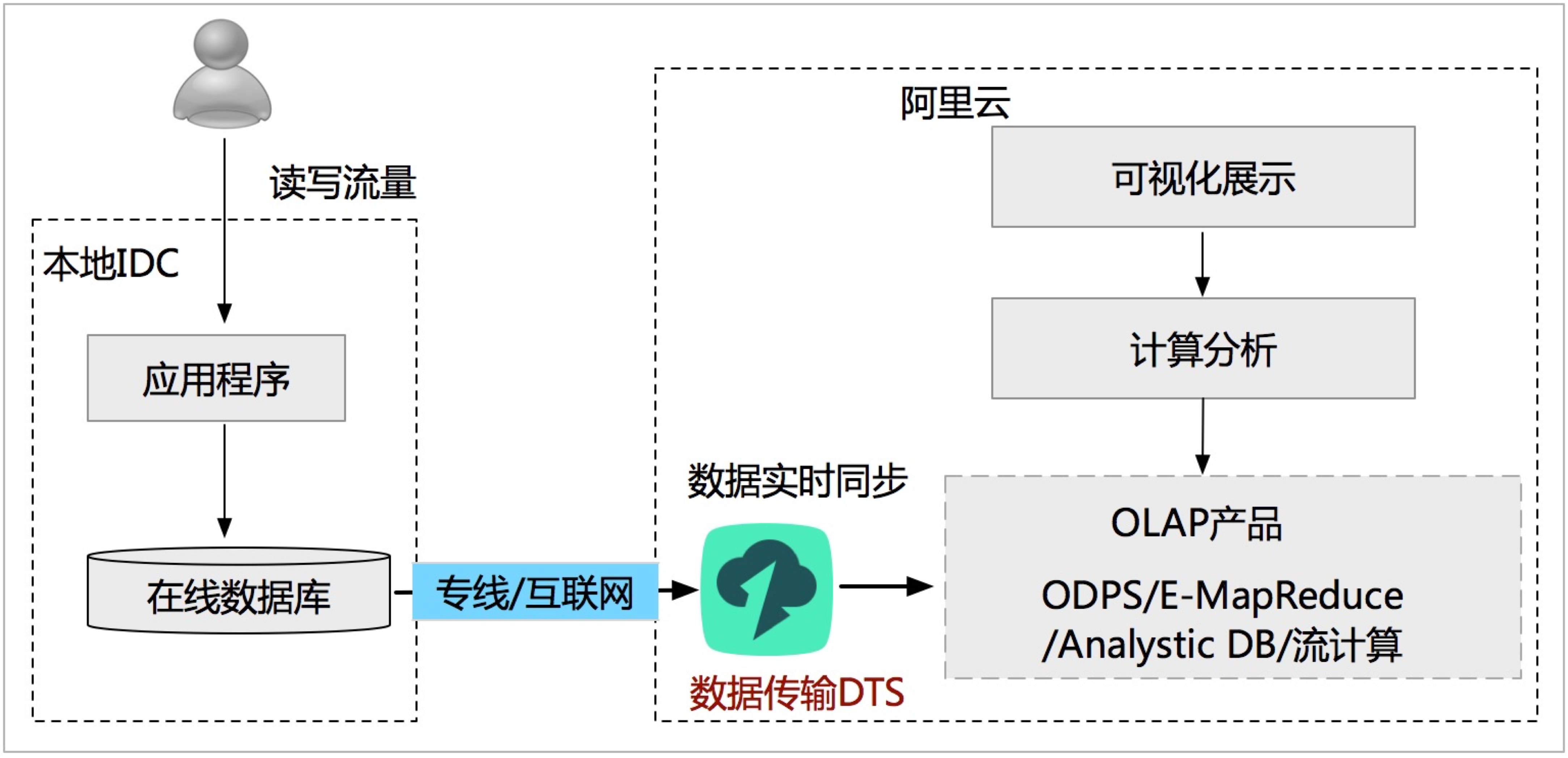

助力快速搭建定制化BI系统

传输方式:数据同步

由于自建BI系统的复杂性,自建BI不能满足越来越高的实时性要求。阿里云提供了非常完善的BI体系,DTS可以帮助您将自建数据库实时同步至阿里云的BI存储系统(例如MaxCompute、分析型数据库或流计算等),助力您在阿里云上快速搭建满足自身业务的定制化BI系统。

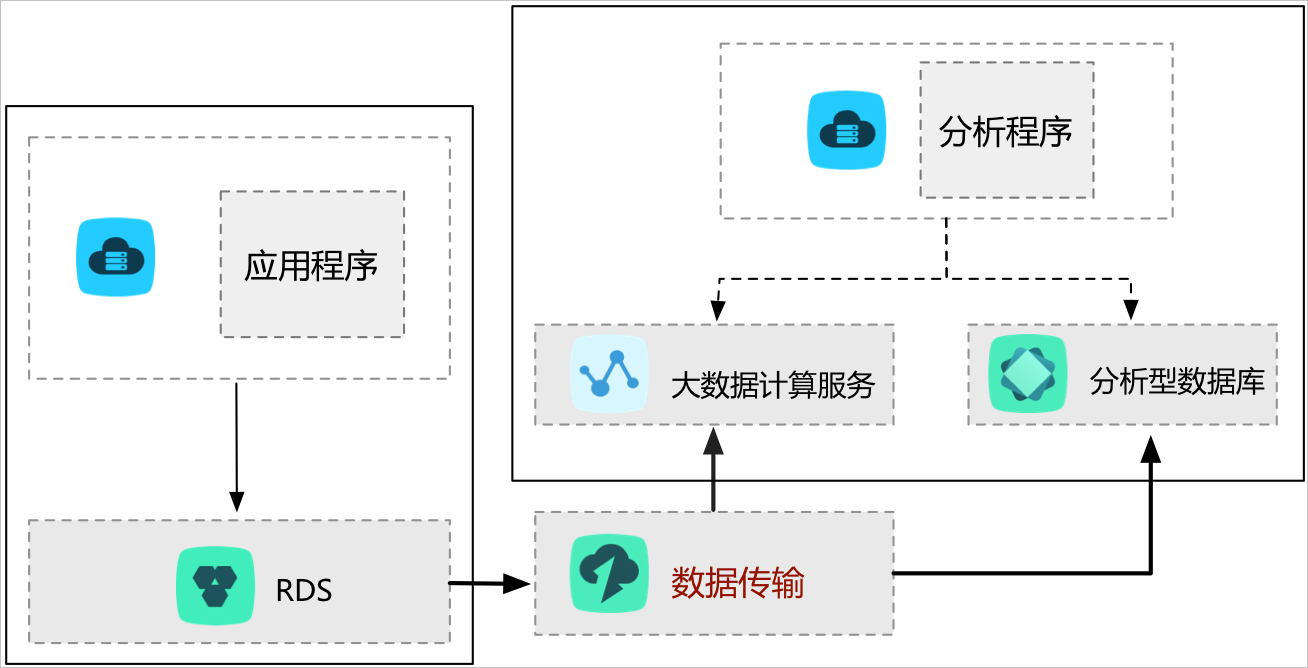

数据实时分析

传输方式:数据订阅

数据分析在提高企业洞察力和用户体验方面发挥着举足轻重的作用,且实时数据分析能够让企业更快速、灵活地调整市场策略,适应快速变化的市场方向和消费者体验。

DTS提供的数据订阅功能,可以在不影响线上业务的情况下,帮助您获取实时增量数据。通过DTS提供的SDK,您可以将订阅到的增量数据同步至分析系统中进行实时分析。

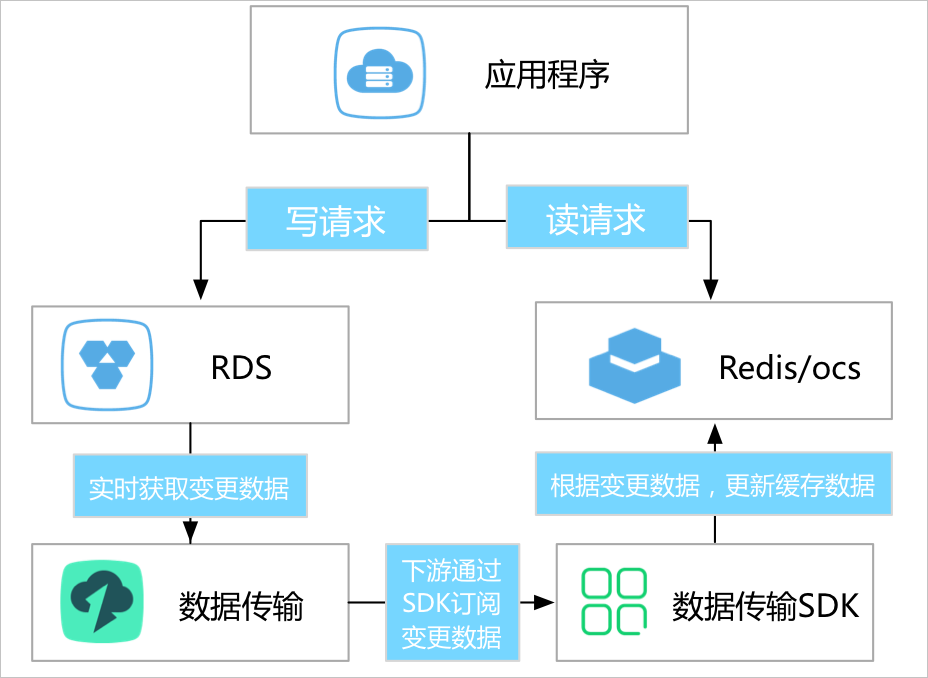

轻量级缓存更新策略

传输方式:数据订阅

为提高业务访问速度,提升业务读并发,通常的做法是在业务架构中引入缓存层,让业务所有读请求全部路由到缓存层,通过缓存的内存读取机制来提升业务读取性能。由于缓存中的数据不能持久化 ,一旦缓存异常退出,那么内存中的数据将会丢失。

DTS提供的数据订阅功能,可以帮助您异步订阅数据库的增量数据,并更新缓存的数据,实现轻量级的缓存更新策略。

该架构具有以下优势:

- 更新路径短,延迟低

业务完成更新数据库后直接返回,不需要关心缓存失效流程,整个更新路径短、延迟低。

- 应用简单可靠

应用无需实现复杂双写逻辑,只需启动异步线程监听增量数据,更新缓存数据即可。

- 应用更新无额外性能消耗

数据订阅通过解析数据库的增量日志来获取增量数据,不会对业务和数据库性能造成影响。

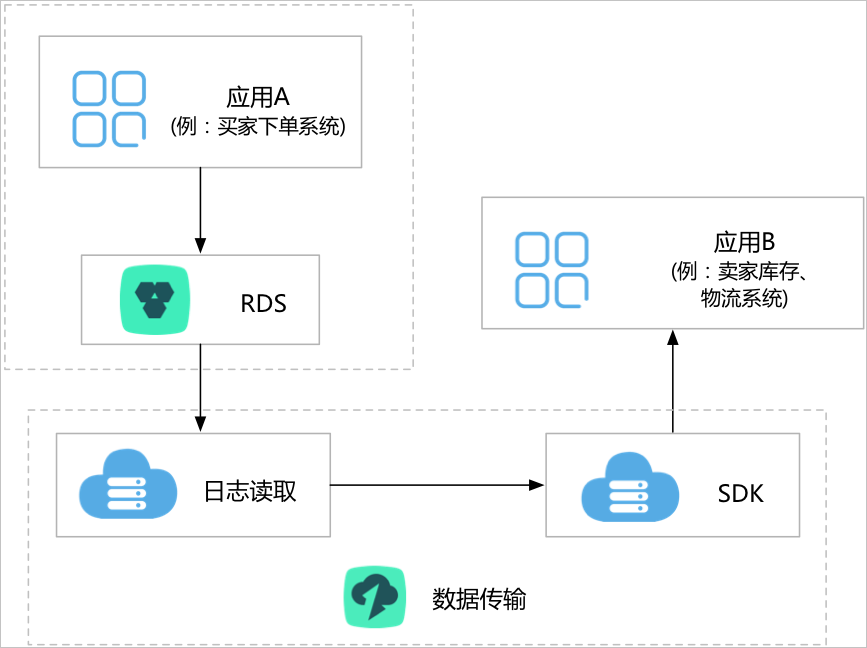

业务异步解耦

传输方式:数据订阅

电商行业涉及下单系统、卖家库存、物流发货等多个业务逻辑。如果将这些逻辑全部在下单流程中,需要全部变更完成后,才能返回下单结果。这种业务逻辑存在如下问题:

- 下单流程和耗费的时间较长,用户体验差。

- 系统稳定性差,任何一个下游发生故障,将直接影响整个业务系统的可用性。

为提升核心应用用户体验和稳定性,您可以通过DTS提供的数据订阅,将深耦合业务优化为通过实时消息通知实现的异步耦合,让核心业务逻辑更简单可靠,具体调整为:

该场景中,买家下单系统只要完成下单操作,就直接返回,底层通过DTS的数据订阅实时获取订单系统的变更数据,业务通过SDK订阅这些变更数据,并触发库存、物流等下游业务逻辑,实现了整个业务系统的简单可靠。

该应用场景在阿里巴巴内部得到了广泛的应用,例如淘宝订单系统每天有上万个下游业务,通过数据订阅获取订单系统的实时数据更新,触发自身的变更逻辑。

横向扩展读能力

传输方式:数据同步

对于有大量读请求的应用场景,单个数据库实例可能无法承担全部的读取压力。您可以借助DTS的实时同步功能构建只读实例,将读请求分流至这些只读实例中,实现读能力的弹性扩展,分担主数据库实例的压力。

用于数据仓库的任务调度

传输方式:数据迁移

对于每天处理大量事务数据的大型在线应用程序,您可能需要采用“次日仓库策略”,定期将数据传输到数据仓库。 例如,您希望将迁移安排在业务低峰期,以便将当天的事务数据传输到数据仓库。 通过该部署,您的分析系统可以处理一天前的数据。