使用裸金属GPU服务器、CPFS和Perseus框架,搭建NLP训练环境。

直达最佳实践

更多最佳实践

场景描述

本方案适用于自然语言训练场景,使用神龙GPU云服务器(SCCGN6)+CPFS进行NLP的训练,采用Bert模型。这里不使用容器,直接使用裸机进行NLP的Bert训练,使用飞天AI加速训练工具可以有效提升多机多卡的训练效率。

解决的问题

- 使用神龙GPU云服务器搭建NLP训练环境

- 使用SCC的RDMA网络

- 使用CPFS存储训练数据

- 使用飞天AI加速训练工具加速训练

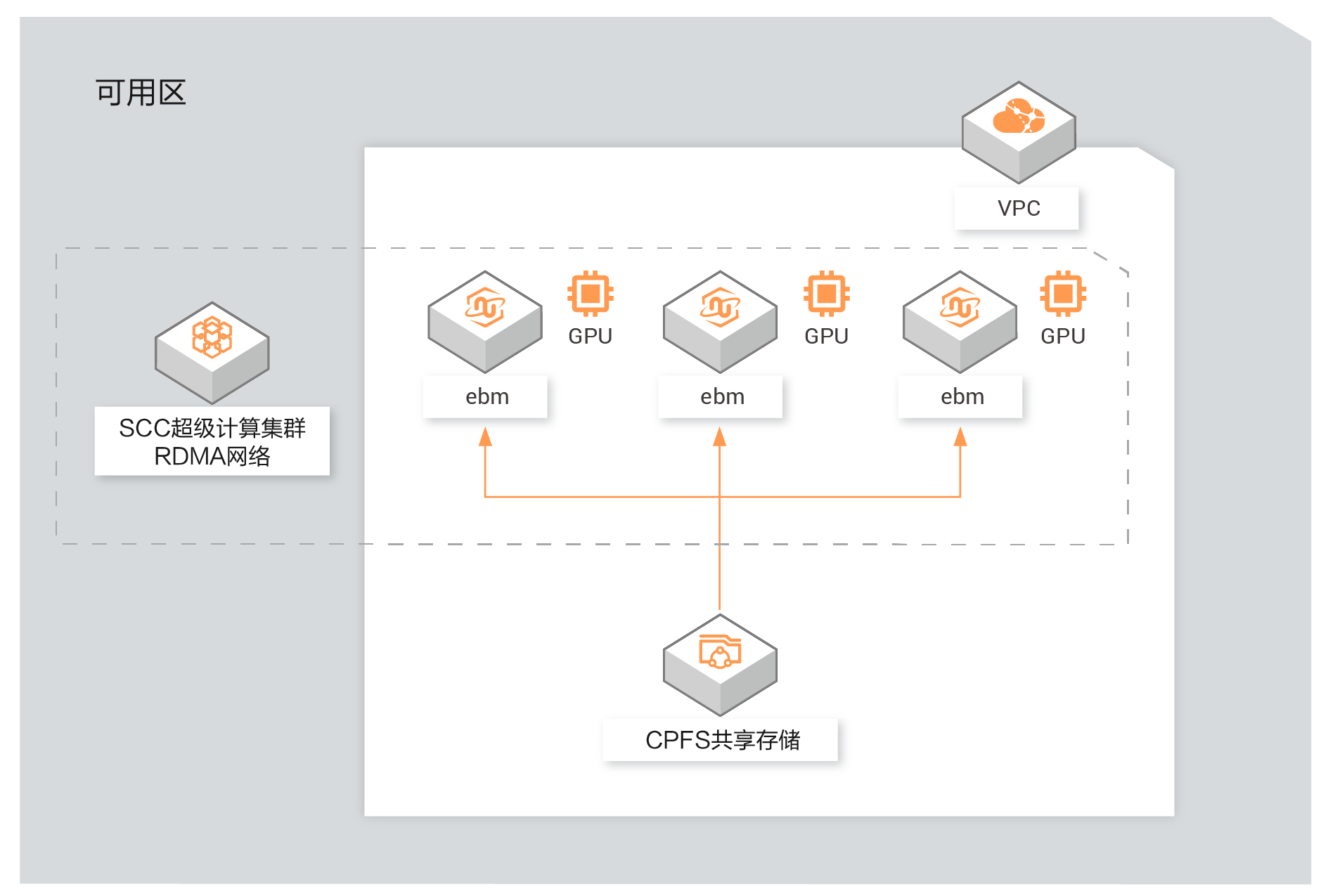

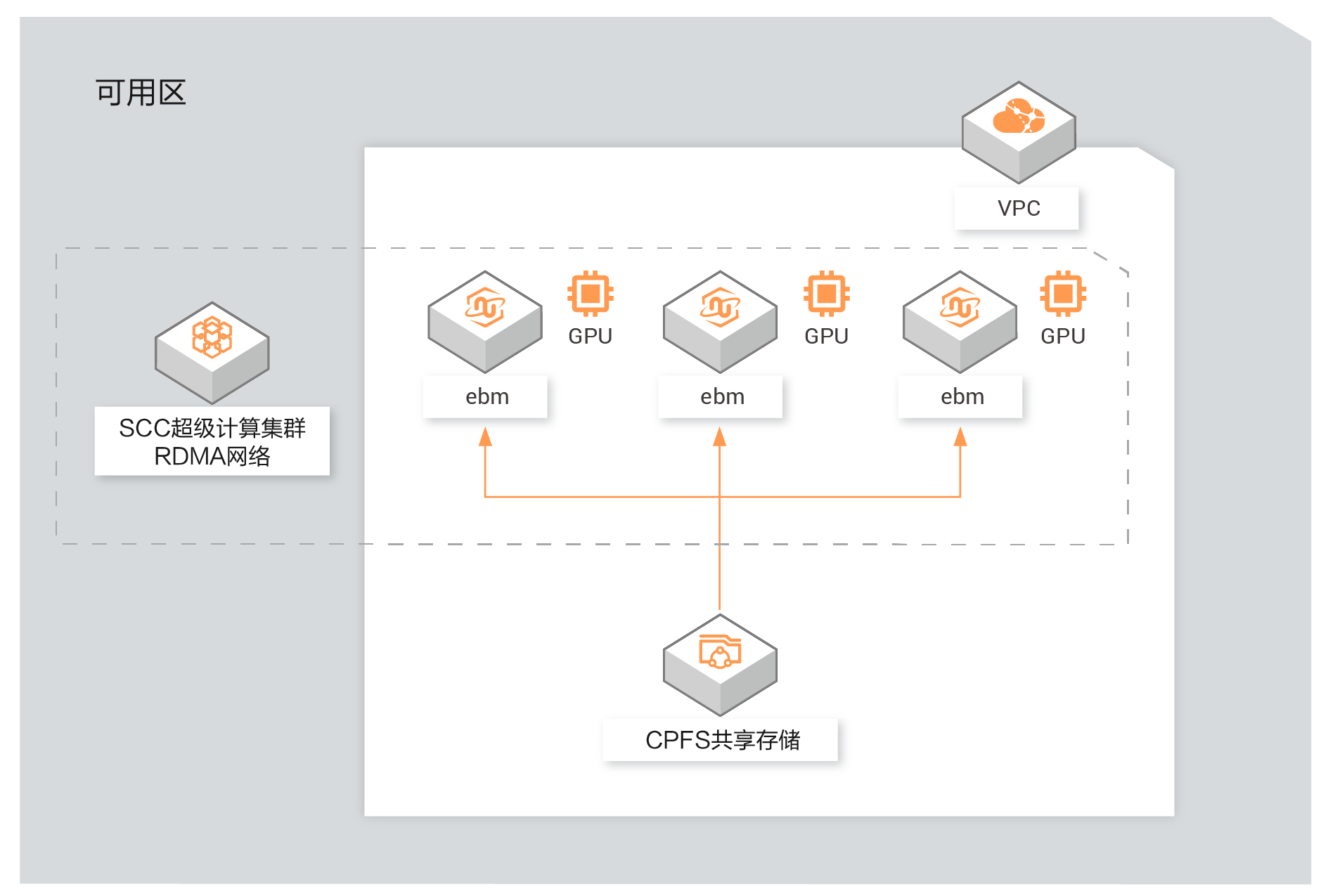

部署架构图

使用裸金属GPU服务器、CPFS和Perseus框架,搭建NLP训练环境。

本方案适用于自然语言训练场景,使用神龙GPU云服务器(SCCGN6)+CPFS进行NLP的训练,采用Bert模型。这里不使用容器,直接使用裸机进行NLP的Bert训练,使用飞天AI加速训练工具可以有效提升多机多卡的训练效率。