快速给接口添加多层内容安全校验

给工作流快速添加内容安全校验

方案概览

用户在已有工作流的基础上,对于文本和图片内容分别追加对应的节点用于安全校验,当文本安全校验不通过,工作流会直接执行结束,并且抛出包含敏感信息类型的错误信息,当图片安全校验不通过,工作流会返回默认的图片告知用户图片包含敏感信息。

环境准备

如果已经在控制台部署好了一份可运行的工作流,可以直接开始下一步,否则参考下面的文档进行基础环境配置:快速创建一个生成漫画插图接口

使用步骤

环境准备好后,获得一个可以运行的工作流如下:

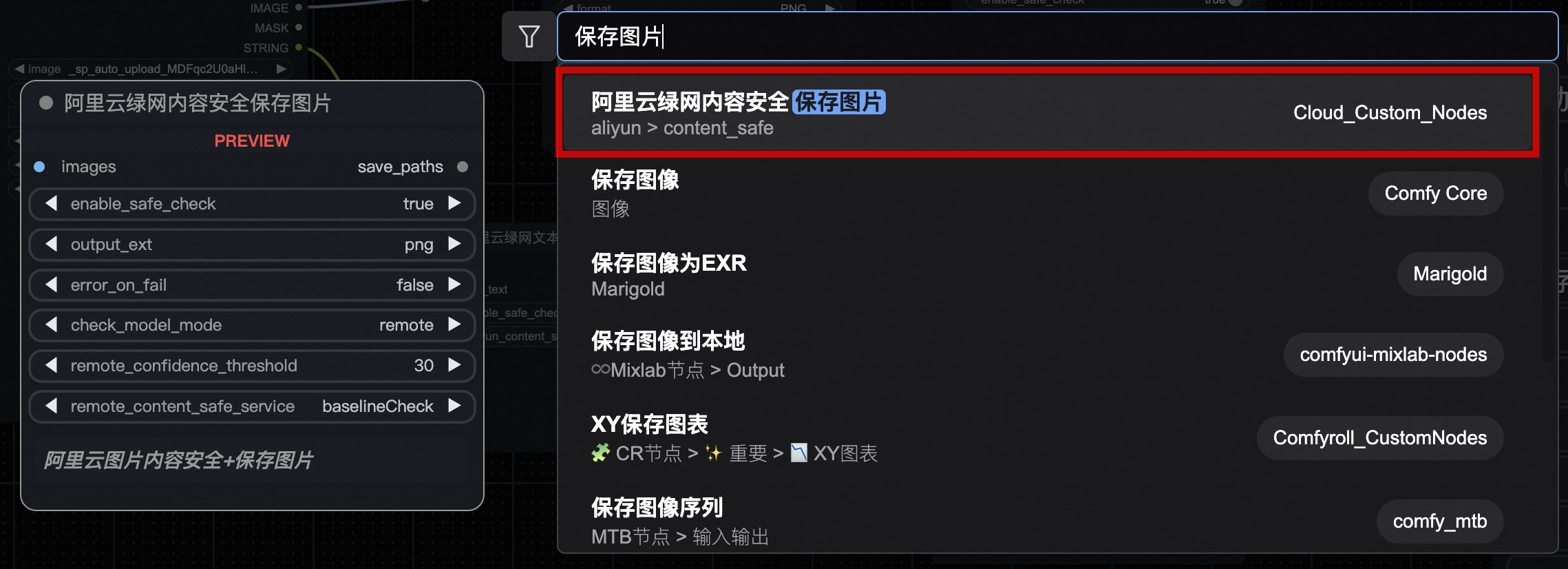

保存图片内容安全校验(本地 + 远程)

将上图中原始的 保存图片 节点删除,双击界面空白处搜索 阿里云绿网内容安全保存图片,选择添加:

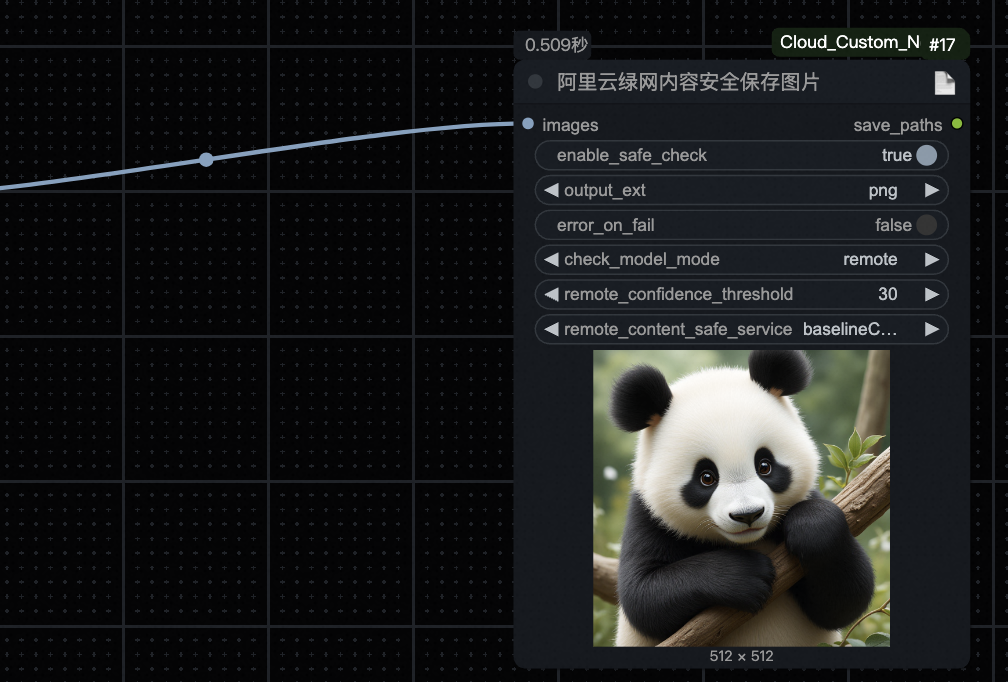

添加到工作流的结尾。添加后的效果如下如所示:

参数说明(重要):

enable_safe_check:boolean 类型,是否启用图片安全监测

output_ext:图片保存格式,默认 png

error_on_fail:boolean 类型,如果检测失败,是否抛出异常,否则返回默认图片

check_model_mode:安全检查模式, 默认是基于remote,local 是基于本地模型检测

remote_confidence_threshold:int类型,默认30,置信度阈值,当检测违规置信度大于该值时,则认定违规,所以该值越小,可能的误判越高,但是也更加安全:图片审核增强版2.0版同步检测API

remote_content_safe_service:审核服务类型,包括:baselineCheck:通用基线检测;baselineCheck_pro:通用基线检测_专业版;baselineCheck_cb:通用基线检测_出海版;tonalityImprove:内容治理检测;tonalityImprove_cb:内容治理检测_出海版;aigcCheck:AIGC图片风险;aigcCheck_cb:AIGC图片风险检测_出海版;profilePhotoCheck:头像图片检测;postImageCheck:帖子评论图片检测;advertisingCheck:营销素材检测;liveStreamCheck:视频\直播截图检测;riskDetection:恶意图片检测

正向提示词输入 暴力,测试运行效果:

上传图片内容安全校验(本地 + 远程)

双击界面空白处搜索 阿里云绿网内容安全上传图片,选择添加,效果如图所示:

参数说明(重要):

enable_safe_check:boolean 类型,是否启用图片安全监测

check_model_mode:安全检查模式, 默认是基于remote,local 是基于本地模型检测

remote_confidence_threshold:int类型,默认30,置信度阈值,当检测违规置信度大于该值时,则认定违规,所以该值越小,可能的误判越高,但是也更加安全:图片审核增强版2.0版同步检测API

remote_content_safe_service:审核服务类型,包括:baselineCheck:通用基线检测;baselineCheck_pro:通用基线检测_专业版;baselineCheck_cb:通用基线检测_出海版;tonalityImprove:内容治理检测;tonalityImprove_cb:内容治理检测_出海版;aigcCheck:AIGC图片风险;aigcCheck_cb:AIGC图片风险检测_出海版;profilePhotoCheck:头像图片检测;postImageCheck:帖子评论图片检测;advertisingCheck:营销素材检测;liveStreamCheck:视频\直播截图检测;riskDetection:恶意图片检测

测试运行效果,运行时候会直接抛出异常:

文本内容安全校验

阿里云绿网文本内容安全(远程)

搜索 阿里云绿网文本内容安全,添加

将 正向提示词 的 CLIP文本编码器文本框转换为输入:

连接内容安全的输出和文本编码器的输入:

参数说明(重要):

origin_text:待检查文本

enable_safe_check:boolean 类型,是否开启图片内容安全校验,默认是开启

aliyun_content_safe_service:审核服务类型,包括:nickname_detection:用户昵称检测;chat_detection:私聊互动内容检测;comment_detection:公聊评论内容检测;ai_art_detection:AIGC文字检测;ad_compliance_detection:广告法合规检测;pgc_detection:PGC教学物料检测;

测试效果,输入违禁词,点击运行:

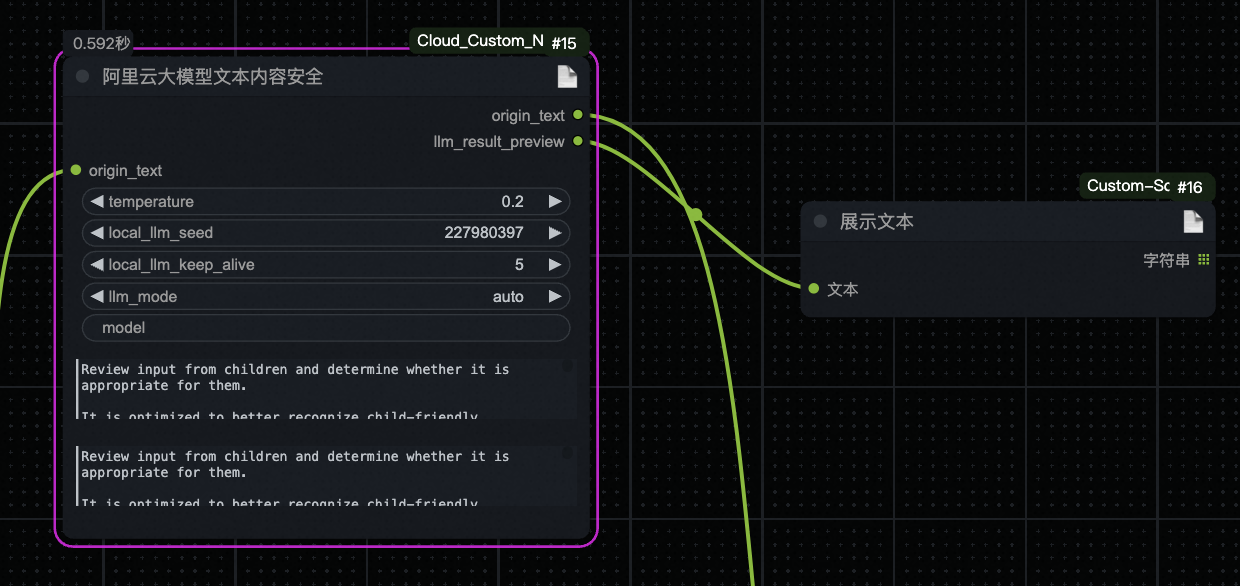

阿里云大模型文本内容安全(远程 + 本地)

搜索 阿里云绿网文本内容安全,添加

将 正向提示词 的 CLIP文本编码器文本框转换为输入:

连接内容安全的输出和文本编码器的输入:

参数说明(重要):

origin_text:待检查文本

temperature: 本地 LLM temperature

local_llm_seed:本地 LLM 种子

local_llm_keep_alive:本地LLM保持 alive 时间

llm_mode:LLM 模式, auto 基于显存,来决定是调用本地 ollama 还是远程千问; remote 远程千问; local 本地 ollama

model:LLM 模型名字, 本地 LLM 默认 qwen2.5:7b,远程 LLM 默认 qwen-plus

local_llm_system_prompt:本地 LLM 系统提示词。如需修改,保留返回的值为bool,否则节点安全监测报错将失效

remote_llm_system_prompt:远程 LLM 系统提示词。如需修改,保留返回的值为bool,否则节点安全监测报错将失效

测试效果,输入 暴力,点击运行:

发布为接口后,内容安全返回效果

保存图片安全监测失败

返回的图片名字为default.png,如需要监测,可以判断当前字符串是否存在。

{

"status": 10,

"apiInvokeId": "i_660d04736d74470025e691d0",

"data": {

"images": [

"http://sd-fc-shanghai-daily.oss-cn-shanghai.aliyuncs.com/default.png"

],

"taskId": "co6fcikahf3lhj6cl1d0",

"status": "succeeded"

},

"subErrCode": null,

"subErrMessage": null,

"errCode": null,

"errMessage": null,

"startTime": null,

"endTime": null

}返回默认的图片URL:

上传图片内容安全监测失败

上传图片节点在阿里云图片安全监测不通过时,会直接报错(注意保存图片节点检测失败会替换默认图不报错)返回参数如下:

{

"status": 20,

"apiInvokeId": "i_66167aba6d744700257a1c84",

"data": null,

"subErrCode": "P_Request_ContentSafe",

"sub_err_message": "{'labels': 'political_politicalFigure', 'code': 'content_safe_check_failed'}",

"errCode": "B_API_ServiceError",

"errMessage": "api调用下游服务错误",

"startTime": null,

"endTime": null

}文本安全监测失败

文本安全监测会直接失败,返回如下格式错误。

{

"status": 20,

"apiInvokeId": "i_66167aba6d744700257a1c84",

"data": null,

"subErrCode": "P_Request_ContentSafe",

"subErrMessage": "包含的具体错误码",

"errCode": "B_API_ServiceError",

"errMessage": "api调用下游服务错误",

"startTime": null,

"endTime": null

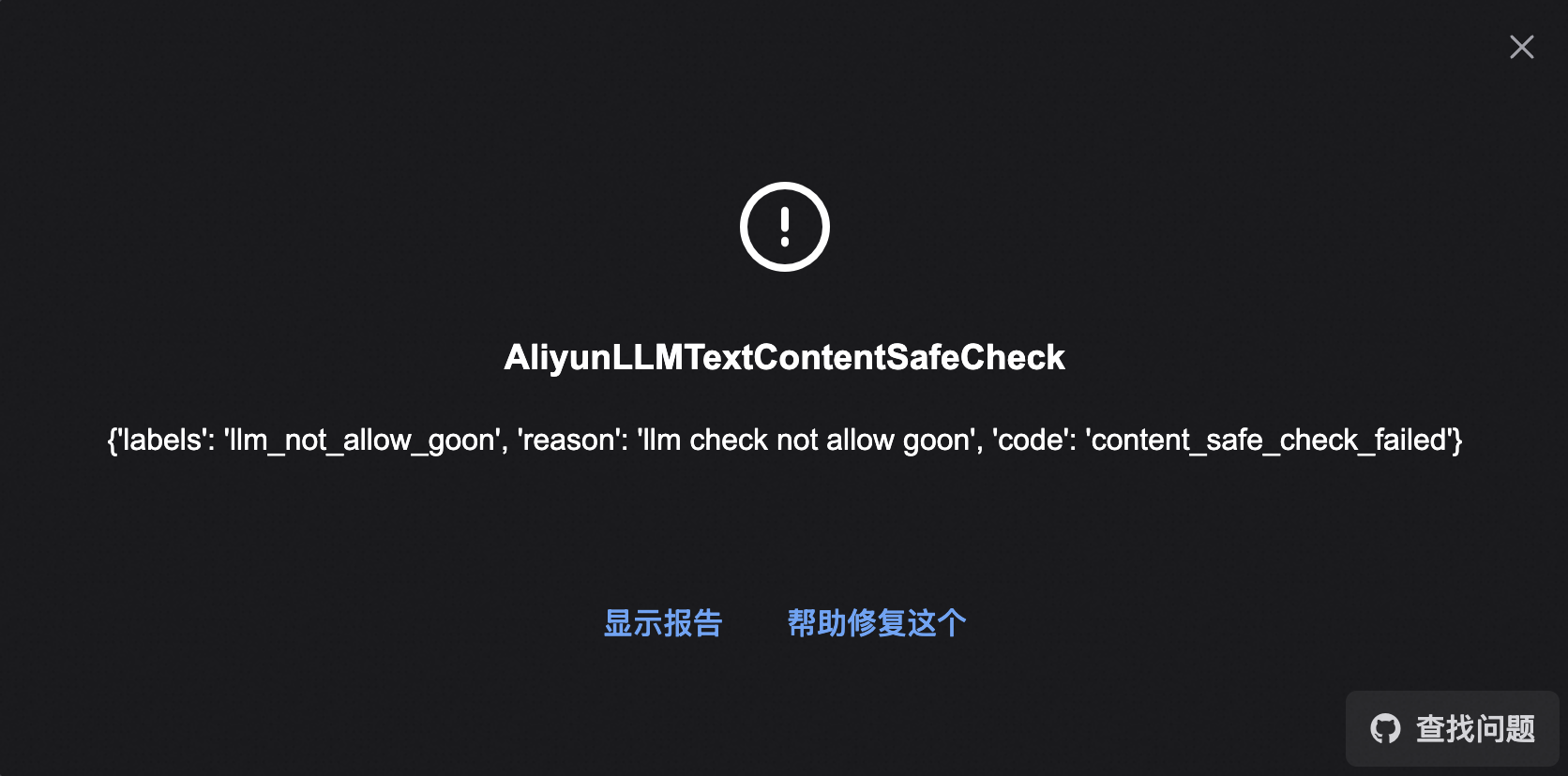

}大模型校验不通过返回参数示例如下:

{

"status": 20,

"err_code": "B_API_ServiceError",

"errMessage": "api调用下游服务错误",

"sub_err_code": "P_Request_ContentSafe",

"sub_err_message": "{'labels': 'llm_not_allow_goon', 'reason': 'llm check not allow goon', 'code': 'content_safe_check_failed'}",

"api_invoke_id": "i_66c7f9789b8059002559f670",

"data": null

}阿里云文本安全监测不通过,返回参数如下:

{

"status": 20,

"apiInvokeId": "i_66167aba6d744700257a1c84",

"data": null,

"subErrCode": "P_Request_ContentSafe",

"subErrMessage": "{'labels': 'sexual_content', 'reason': '{\"riskLevel\":\"medium\",\"riskTips\":\"色情_低俗\",\"riskWords\":\"色情\"}', 'code': 'content_safe_check_failed'}",

"errCode": "B_API_ServiceError",

"errMessage": "api调用下游服务错误",

"startTime": null,

"endTime": null

}具体的错误码可以参考:文本审核增强版API