部署集是控制ECS实例分布的策略,该策略将ECS实例分散部署在不同的物理服务器上,提升业务的高可用性和底层容灾能力。通过为节点池指定部署集,能够保证节点池弹出的ECS实例不会分布于同一物理机上,并通过亲和性配置,使您的应用对底层的节点拓扑进行感知,使其均匀地分布在不同节点上,保证应用的容灾能力和高可用性。

前提条件

已创建部署集。具体操作,请参见创建部署集。

背景信息

在同一个可用区下,为了保证高可用性,您通常会选择跨主机部署服务。但当一台物理机出现问题时,会影响到应用的所有副本。为了解决这个问题,ECS提供了部署集功能。部署集内的所有ECS实例会在指定地域内严格分散在不同的物理服务器上,满足服务相互隔离的应用架构,大幅降低服务不可用的几率。关于部署集的更多信息,请参见部署集。

使用限制

集群中功能使用须知

部署集仅支持ACK托管集群和ACK专有集群。

部署集仅在新建节点池时支持指定,不支持为已有节点池开启。每个节点池仅支持绑定一个部署集。

部署集不支持手动添加或移除节点。您可以通过扩缩容节点池的操作,调整部署集中的节点数。具体操作,请参见创建和管理节点池。

开启部署集功能后,不支持创建抢占式实例。

部署集配额与规格限制

部署集配额限制:

支持的实例规格族限制:

不同部署策略仅支持创建特定的实例规格族,具体信息如下。

说明您也可以调DescribeDeploymentSetSupportedInstanceTypeFamily指定部署集策略来获取各部署集策略支持的实例规格族。

部署策略

支持的实例规格族

高可用策略和部署集组高可用策略

g9i、g8a、g8i、g8y、g7se、g7a、g7、g7h、g7t、g7ne、g7nex、g6、g6e、g6a、g6h、g5、g5ne、sn2ne

c9i、c8a、c8i、c8y、c7se、c7、c7t、c7nex、c7a、c6、c6a、c6e、c5、ic5、sn1ne

r9i、r8a、r8i、r8y、r7、r7se、r7t、r7a、r6、r6e、r6a、re6、re6p、r5、re4、se1ne、se1

hfg9i、hfr9i、hfc9i、hfc8i、hfg8i、hfr8i、hfc7、hfg7、hfr7、hfc6、hfg6、hfr6、hfc5、hfg5

d3s、d3c、d2s、d2c、d1、d1ne、d1-c14d3、d1-c8d3

i4、i4g、i4r、i3g、i3、i2、i2g、i2ne、i2gne、i1

ebmg5、ebmc7、ebmg7、ebmr7、sccgn6、scch5、scch5s、sccg5、sccg5s

e、s6、t6、xn4、mn4、n4、e4

gn6i

u1

网络低时延策略

g9i、g8a、g8i、g8ae、g8y

c9i、c8a、c8i、c8ae、c8y

ebmc8i、ebmg8i、ebmr8i

r9i、r8a、r8i、r8ae、r8y

i4

hfg9i、hfr9i、hfc9i、hfc8i、hfg8i、hfr8i

ebmgn7ex、ebmc7、ebmg7、ebmr7

通过控制台为节点池指定部署集

使用案例

在同一个节点池中,同一个工作负载的Pod之间反亲和,一个节点只能调度一个Pod

本示例介绍如何将Deployment中的三个Pod副本调度到三个不同节点上,操作步骤如下。

创建节点池包含三个节点,并为节点池指定部署集ID。具体操作,请参见通过控制台为节点池指定部署集。

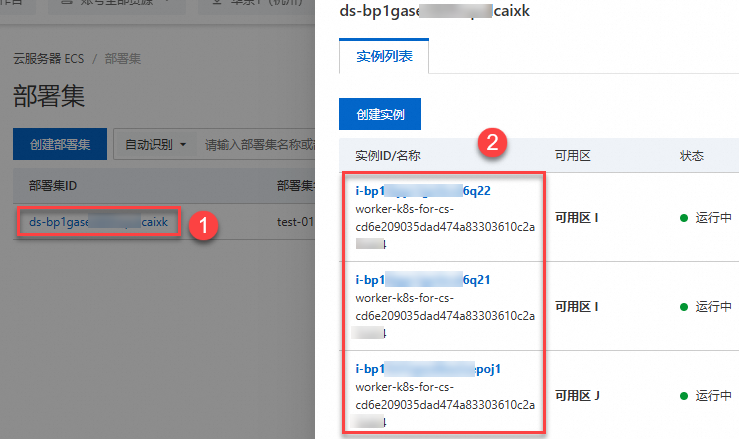

创建节点池完成后,在节点池页面,单击目标节点池,然后在节点管理页签,可以查看到成功创建的三个节点。

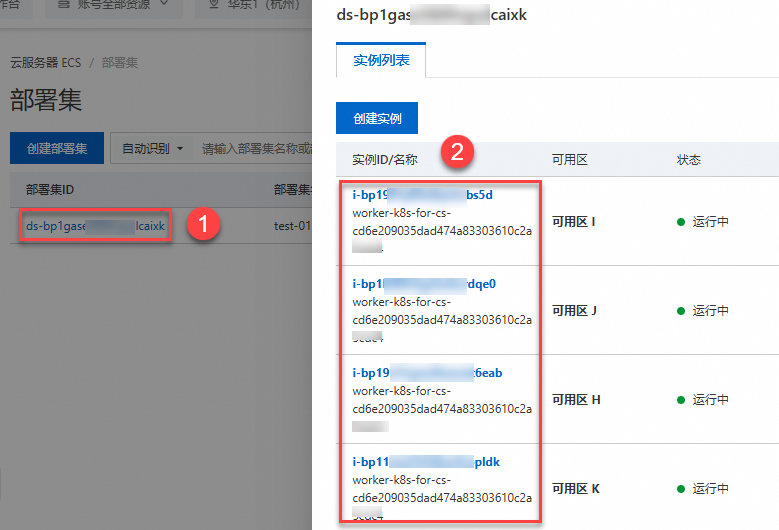

登录ECS控制台,在左侧导航栏选择,在部署集页面,可以查看到节点池中的三个节点均属于所选的部署集。

使用以下示例内容,配置应用YAML。

通过反亲和性配置三个应用Pod,将不同的Pod调度到节点池不同节点上。

apiVersion: apps/v1 kind: Deployment metadata: name: nginx labels: app: nginx spec: replicas: 3 selector: matchLabels: app: nginx template: metadata: name: nginx labels: app: nginx spec: affinity: podAntiAffinity: requiredDuringSchedulingIgnoredDuringExecution: # 设置调度策略。 - labelSelector: matchExpressions: - key: app operator: In values: - nginx topologyKey: kubernetes.io/hostname nodeSelector: alibabacloud.com/nodepool-id: <nodepool-id> # 指定节点池ID。 containers: - name: nginx image: anolis-registry.cn-zhangjiakou.cr.aliyuncs.com/openanolis/nginx:1.14.1-8.6 resources: limits: cpu: 1 requests: cpu: 1执行结果

在无状态页面,单击目标Deployment,在容器组页签,可以看到三个不同的Pod调度到节点池不同节点上。

在同一个节点池中,同一个工作负载的Pod之间按照可用区和节点均匀调度打散

创建节点池包含四个节点,为节点池指定部署集ID,并选择多可用区的VSwitch。具体操作,请参见通过控制台为节点池指定部署集。

创建完成后,在节点池页面,单击目标节点池,然后在节点管理页签可以查看到四个节点,并选择了四个可用区。根据ESS的均匀分布策略,弹出的ECS实例将分布在不同的四个可用区,且均加入了部署集。

登录ECS控制台,在左侧导航栏选择,在部署集页面,可以查看到节点池中的四个节点均属于所选的部署集。

使用以下示例内容,配置应用YAML。

通过Pod拓扑分布约束,将同一个应用的Pod之间按照可用区和节点均匀调度打散。更多信息,请参见Pod 拓扑分布约束。

apiVersion: apps/v1 kind: Deployment metadata: name: nginx labels: app: nginx spec: replicas: 4 selector: matchLabels: app: nginx template: metadata: name: nginx labels: app: nginx spec: topologySpreadConstraints: - maxSkew: 1 topologyKey: kubernetes.io/hostname whenUnsatisfiable: DoNotSchedule labelSelector: matchLabels: app: nginx - maxSkew: 1 topologyKey: topology.kubernetes.io/zone whenUnsatisfiable: DoNotSchedule labelSelector: matchLabels: app: nginx nodeSelector: alibabacloud.com/nodepool-id: <nodepool-id> #指定节点池ID。 containers: - name: nginx image: anolis-registry.cn-zhangjiakou.cr.aliyuncs.com/openanolis/nginx:1.14.1-8.6 resources: limits: cpu: 1 requests: cpu: 1执行结果

在无状态页面,单击目标Deployment,在容器组页签,可以看到同一个应用的Pod之间按照可用区和节点已均匀调度打散。

相关文档

您也可以通过Terraform为节点池指定部署集。

关于更多集群高可用架构的推荐配置,请参见集群高可用架构推荐配置。