Control Center是云消息队列 Confluent 版的核心管理服务,提供了一个可视化的监控平台。本文介绍Control Center平台上的基本操作。

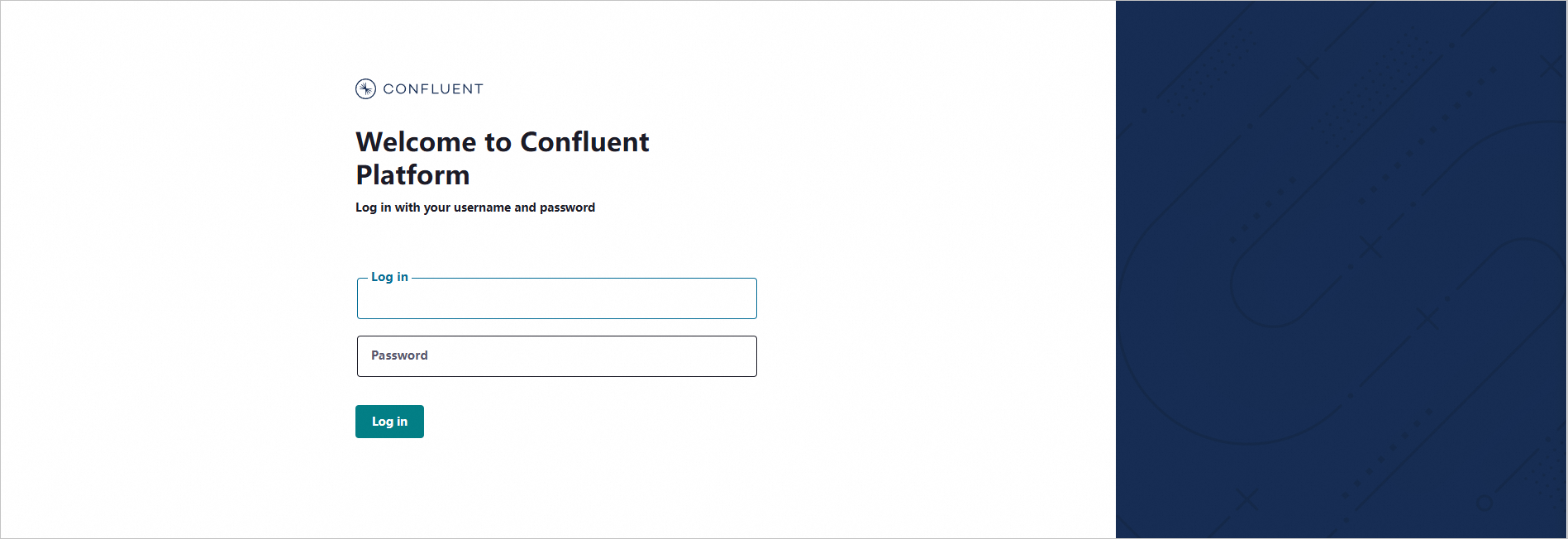

登录Control Center

登录云消息队列 Confluent 版控制台,在左侧导航栏,单击实例列表。

在顶部菜单栏,选择地域,然后在实例列表页面,单击目标实例名称。

在实例详情页面,单击右上角的登录控制台进行Control Center登录。

说明Control Center控制台的登录用户名和密码为部署实例时配置名为root的用户名和密码。

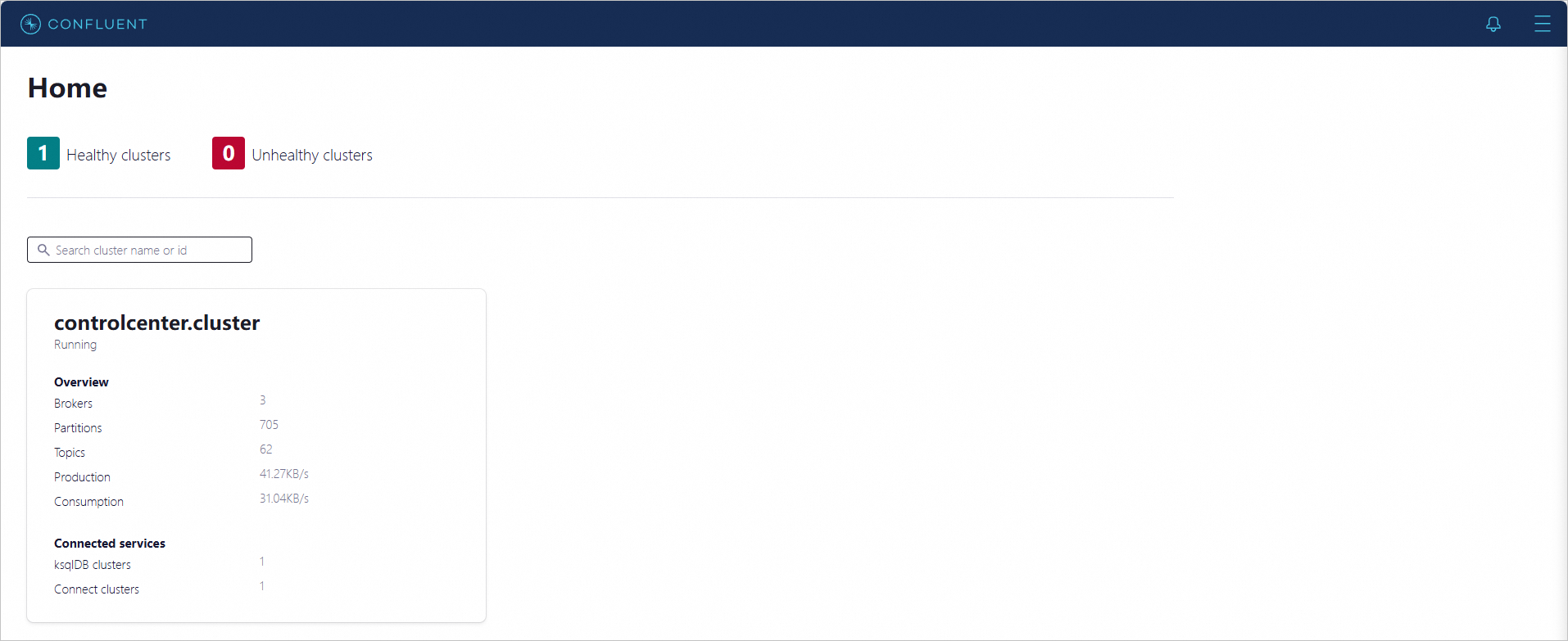

登录完成后,进入Control Center控制台的Home页面。

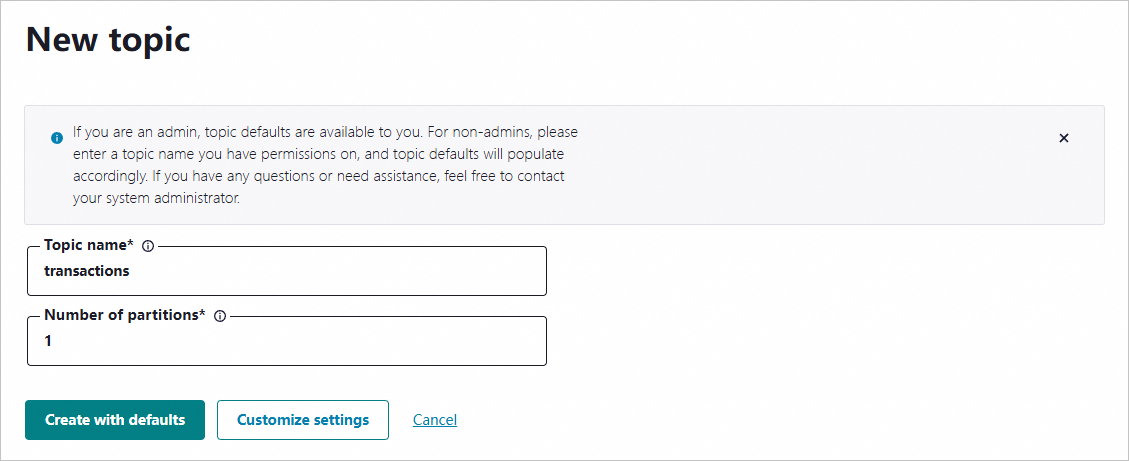

创建Topic

登录Control Center控制台,在Home页面单击controlcenter.clusterk卡片,进入到Cluster overview页面。

在左侧导航栏,单击Topics,然后在Topic列表页面单击+ Add topic。

在New topic页面,设置Topic名称和分区数,然后单击Create with defaults。

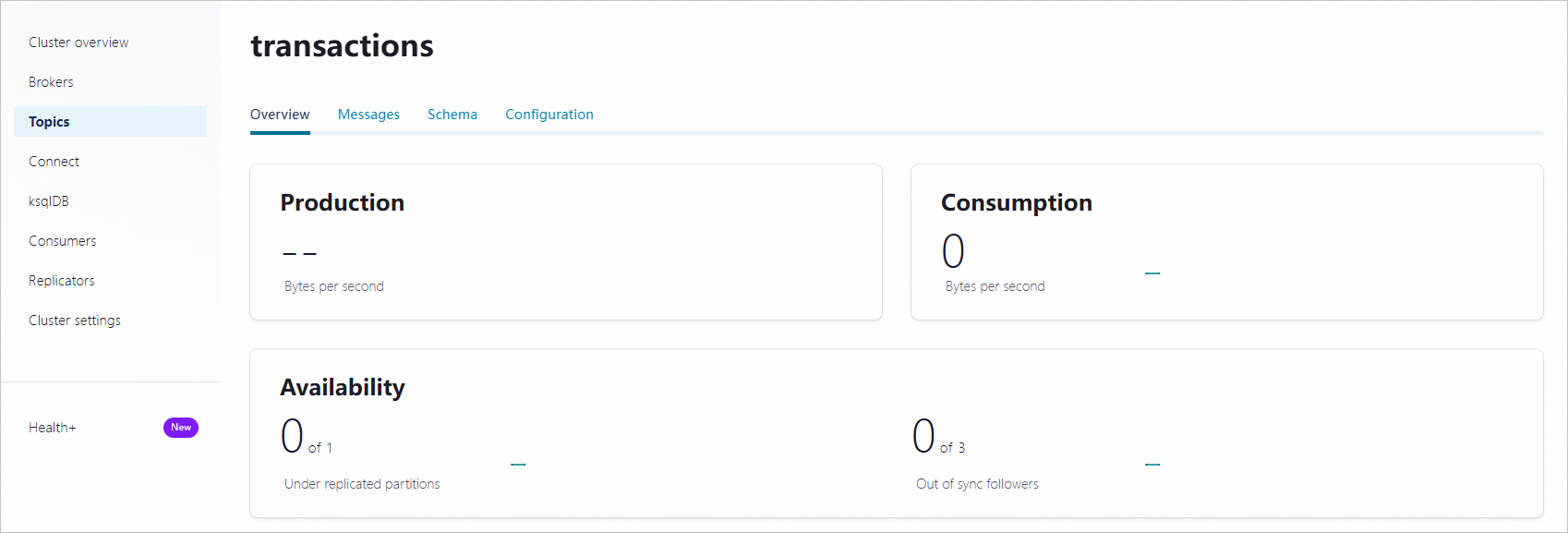

创建完成后,进入到Topic详情页面。

开启Schema格式校验

创建Schema

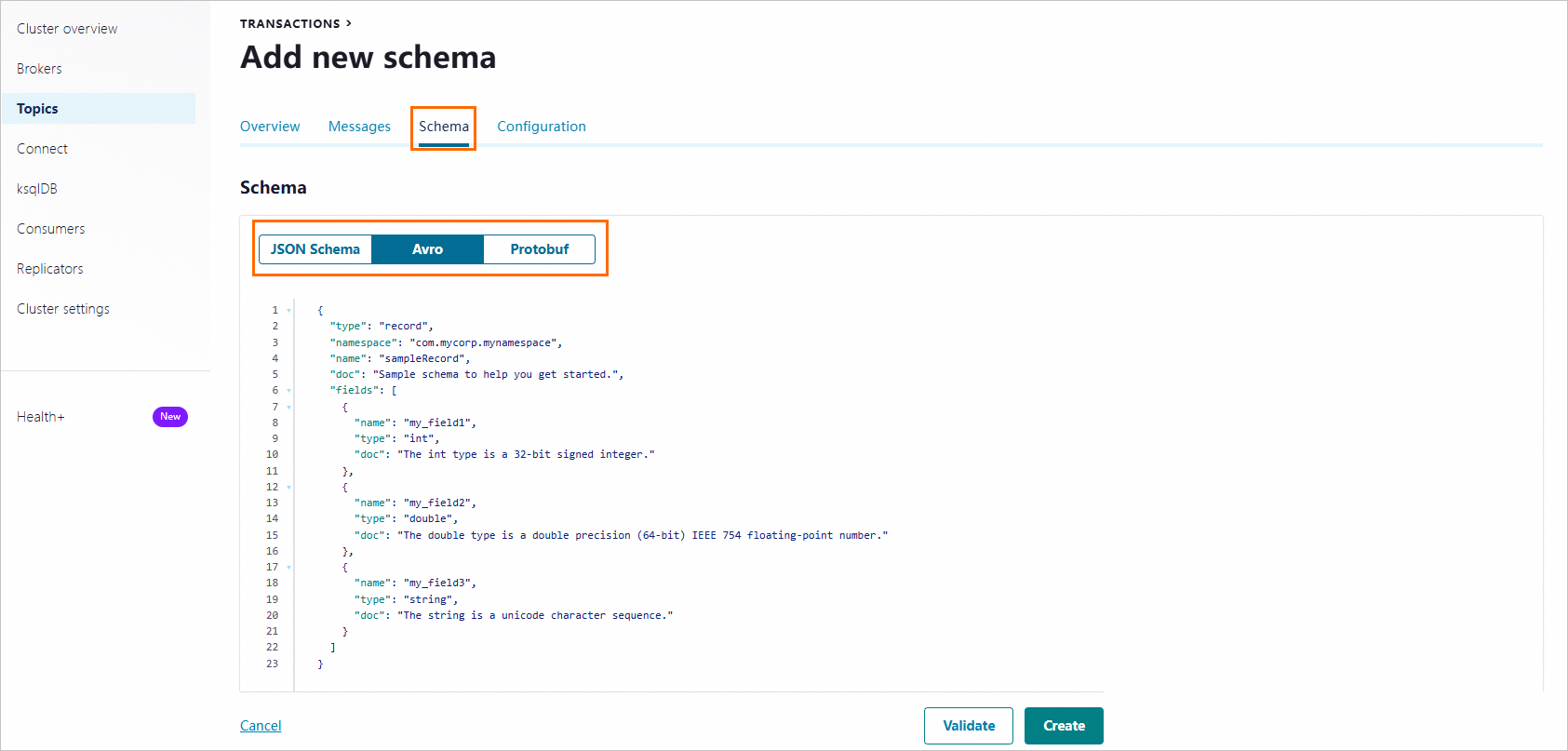

Topic详情页面,单击Schema,然后单击Set a schema。

在Schema页签,选择Schema校验格式,填写校验规则后,单击Create。

开启Schema格式校验

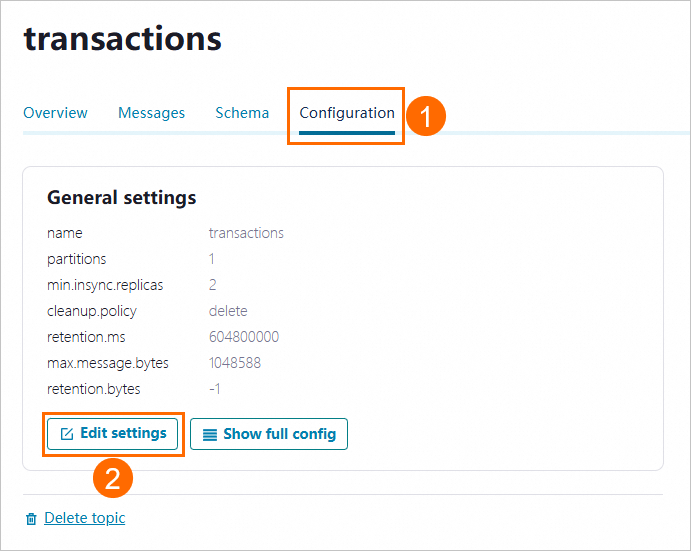

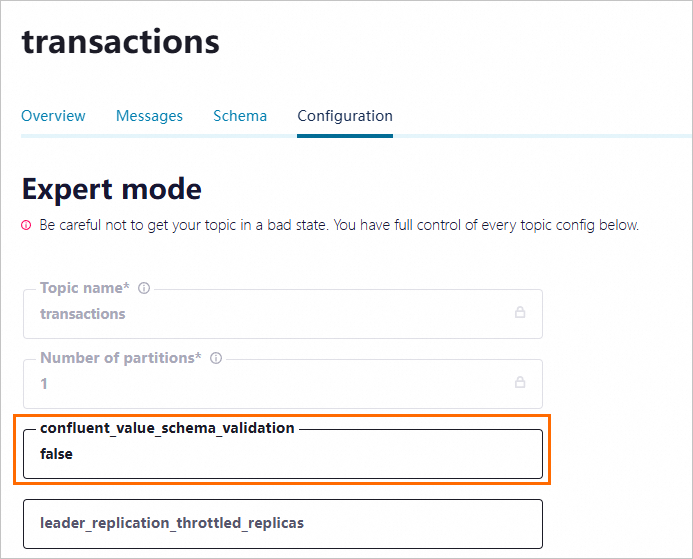

在Topic详情页面,单击Configuration页签,然后单击Edit settings。

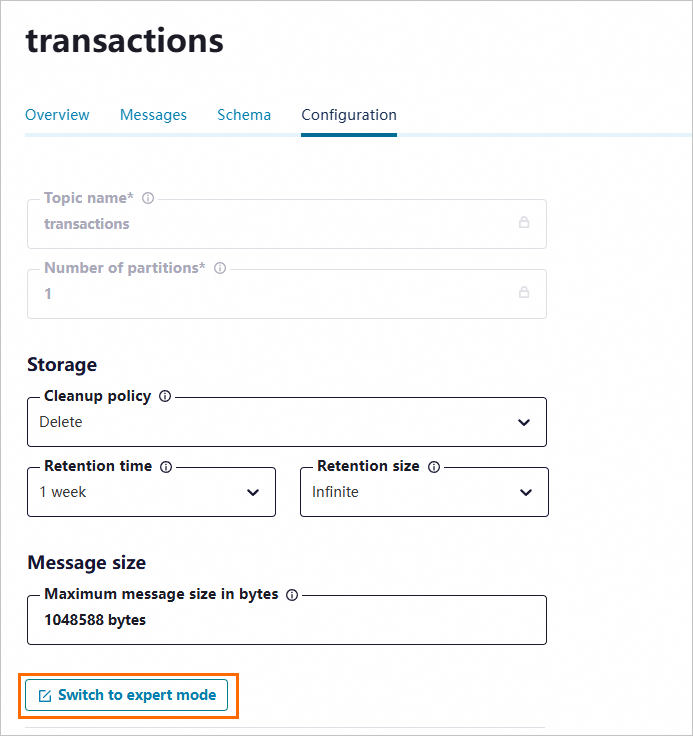

然后单击Switch to expert mode。

将confluent_value_schema_validation字段设置为true,然后单击Save changes,启用Schema验证消息内容格式。启用后发送和消费数据时将进行格式校验。

查看Broker详情

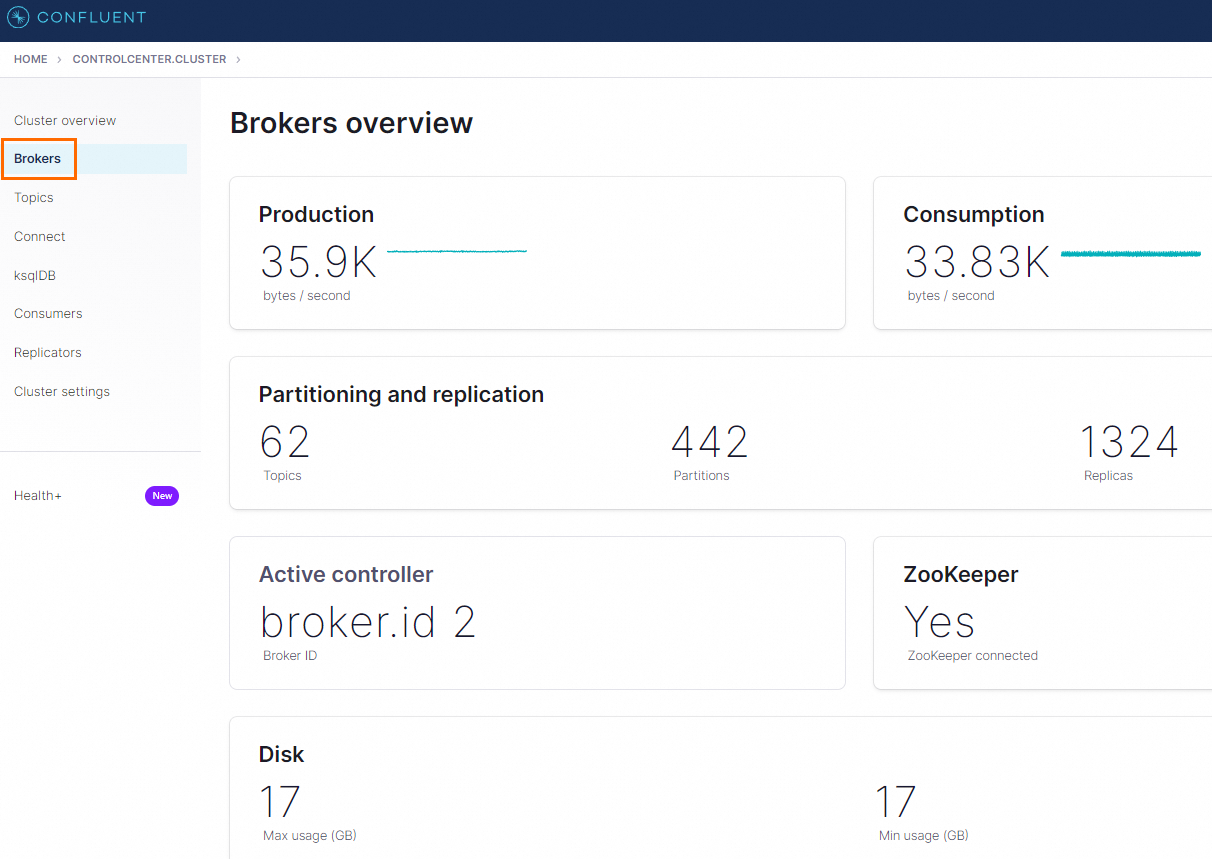

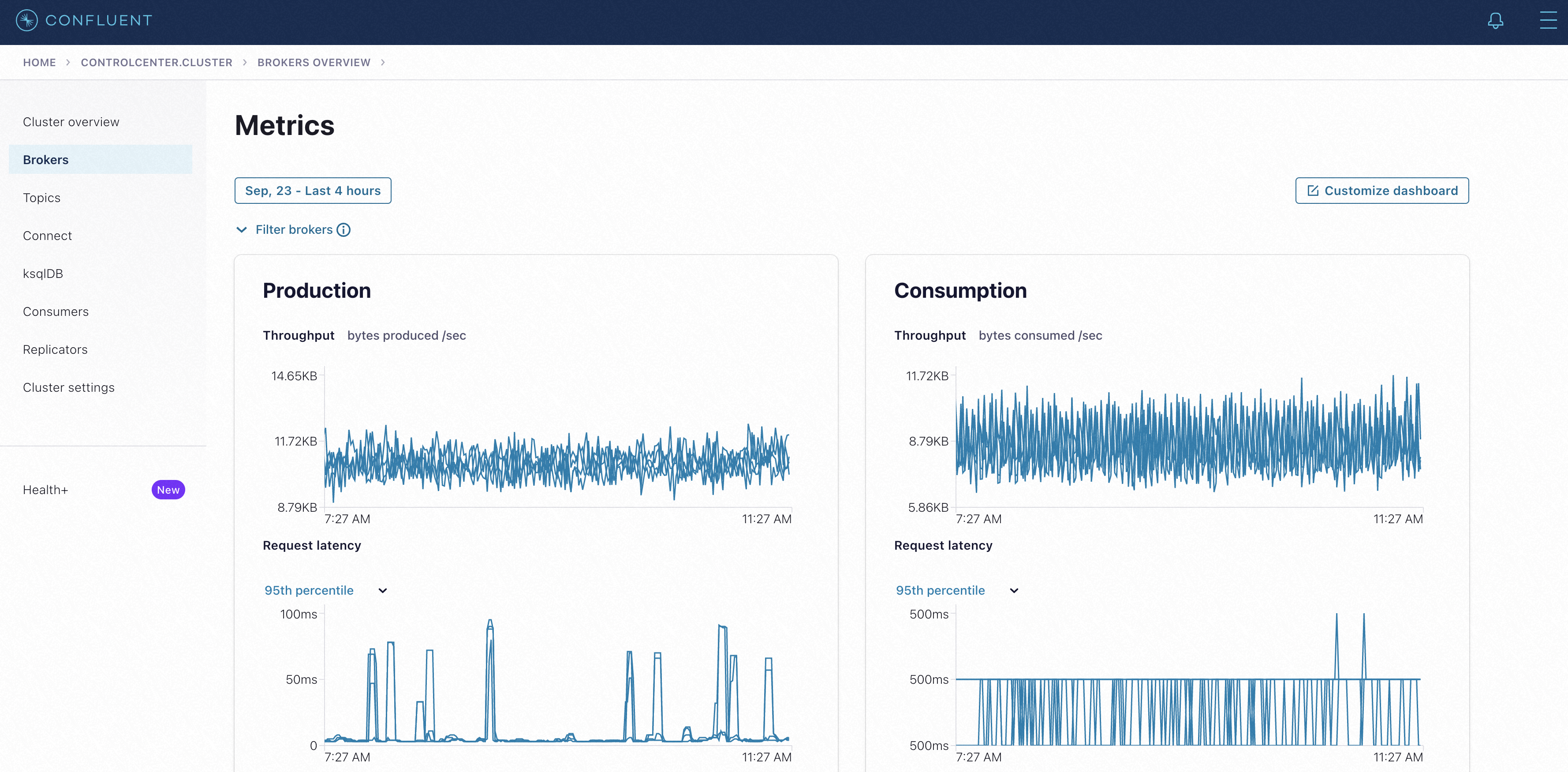

在Cluster overview页面的左侧导航栏,单击Brokers,查看Broker的基本信息。

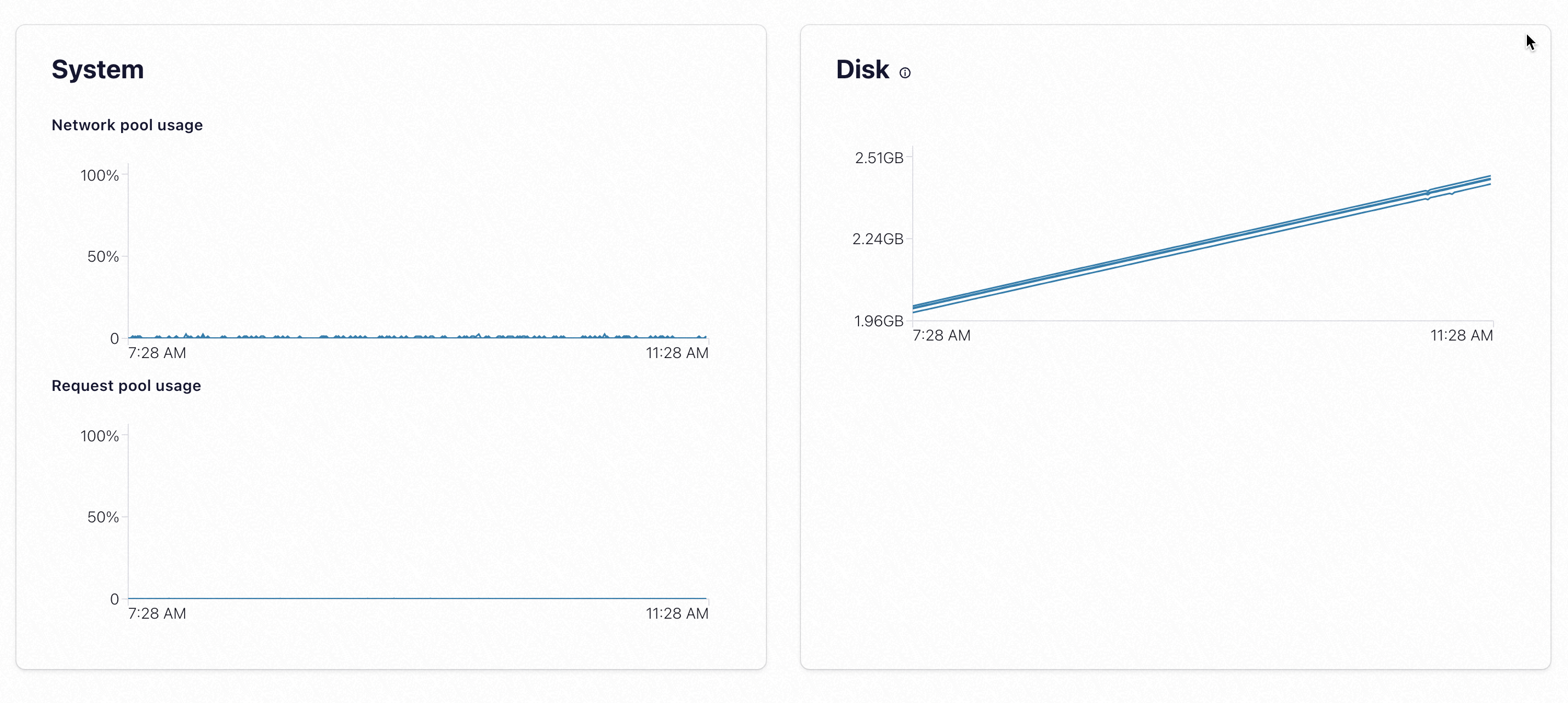

在Brokers overview页面,单击Production或Consumption,进入Metrics详情页,查看Producer和Consumer的Throughput,Request latency,Disk使用率等监控指标。

使用KsqlDB

KsqlDB是一款开源流式SQL引擎,能够借助类SQL语法实时处理与分析Kafka中的数据流,从而简化了Kafka流处理的复杂性。具体操作请参见KsqlDB。

查看集群配置

在主页的左侧导航栏,单击Cluster settings,查看集群的基本信息。

单击Cluster defaults页签,查看集群的详情信息,包括Controller、Genenal,Group Management等模块。

RBAC授权使用

RBAC即基于角色的访问控制(Role Based Access Control),是云消息队列 Confluent 版权限管理的核心功能之一,具体操作请参见RBAC授权。

告警设置

云消息队列 Confluent 版支持一些业务告警配置,具体操作,请参见Control Center设置告警。