在使用容器计算服务 ACS(Container Compute Service)算力时,您无需深入了解底层硬件,也无需涉及GPU节点管理和配置即可开箱即用。ACS部署简单、支持按量付费,非常适合用于LLM推理任务,可以有效降低推理成本。本文介绍如何使用ACS GPU算力通过deepgpu-comfyui插件加速Wan2.1视频生成。

背景信息

ComfyUI

ComfyUI是一个基于 节点(Node-based) 的图形用户界面(GUI),专为运行和定制 Stable Diffusion(一种主流的文本生成图像模型)而设计。它通过可视化的流程图(Workflow)方式,让用户以拖拽节点的方式构建复杂的图像生成流程,而无需直接编写代码。

Wanx模型

万相(Tongyi Wanxiang)是由阿里巴巴通义实验室研发的AI绘画与文生图(AIGC)大模型,属于“千问”大模型系列中的视觉生成分支。它是全球首个支持中文提示词的AI绘画模型,并具备多模态能力,能够根据文字描述、手绘草图、图像风格迁移等生成高质量的艺术作品。

前提条件

首次使用阿里云容器计算服务 ACS(Container Compute Service)时,需要为服务账号授予系统默认角色。当且仅当该角色被正确授予后,ACS才能正常地调用相关服务(ECS、OSS、NAS、CPFS、SLB等),创建集群以及保存日志等。具体操作,请参见首次使用容器计算服务。

支持的GPU卡型:L20(GN8IS)、G49E。

操作步骤

步骤一:准备模型数据

建议您创建NAS或OSS存储卷来持久化存储模型文件。本文以NAS存储卷为例,请在NAS挂载的目录中执行以下操作。

创建持久化存储卷的具体操作,请参见新建NAS文件系统作为存储卷或使用OSS静态存储卷。

执行以下命令下载ComfyUI。

请确认操作环境已安装git。

git clone https://github.com/comfyanonymous/ComfyUI.git执行以下命令,分别下载以下三个模型文件到ComfyUI对应的目录下。关于模型的详细信息,请参见Wan_2.1_ComfyUI_repackaged项目。

建议提升公网带宽峰值,预计下载总用时约30分钟。

wan2.1_t2v_14B_fp16.safetensors文件cd ComfyUI/models/diffusion_models wget https://modelscope.cn/models/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/master/split_files/diffusion_models/wan2.1_t2v_14B_fp16.safetensorswan_2.1_vae.safetensors文件cd ComfyUI/models/vae wget https://modelscope.cn/models/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/master/split_files/vae/wan_2.1_vae.safetensorsumt5_xxl_fp8_e4m3fn_scaled.safetensors文件cd ComfyUI/models/text_encoders wget https://modelscope.cn/models/Comfy-Org/Wan_2.1_ComfyUI_repackaged/resolve/master/split_files/text_encoders/umt5_xxl_fp8_e4m3fn_scaled.safetensors

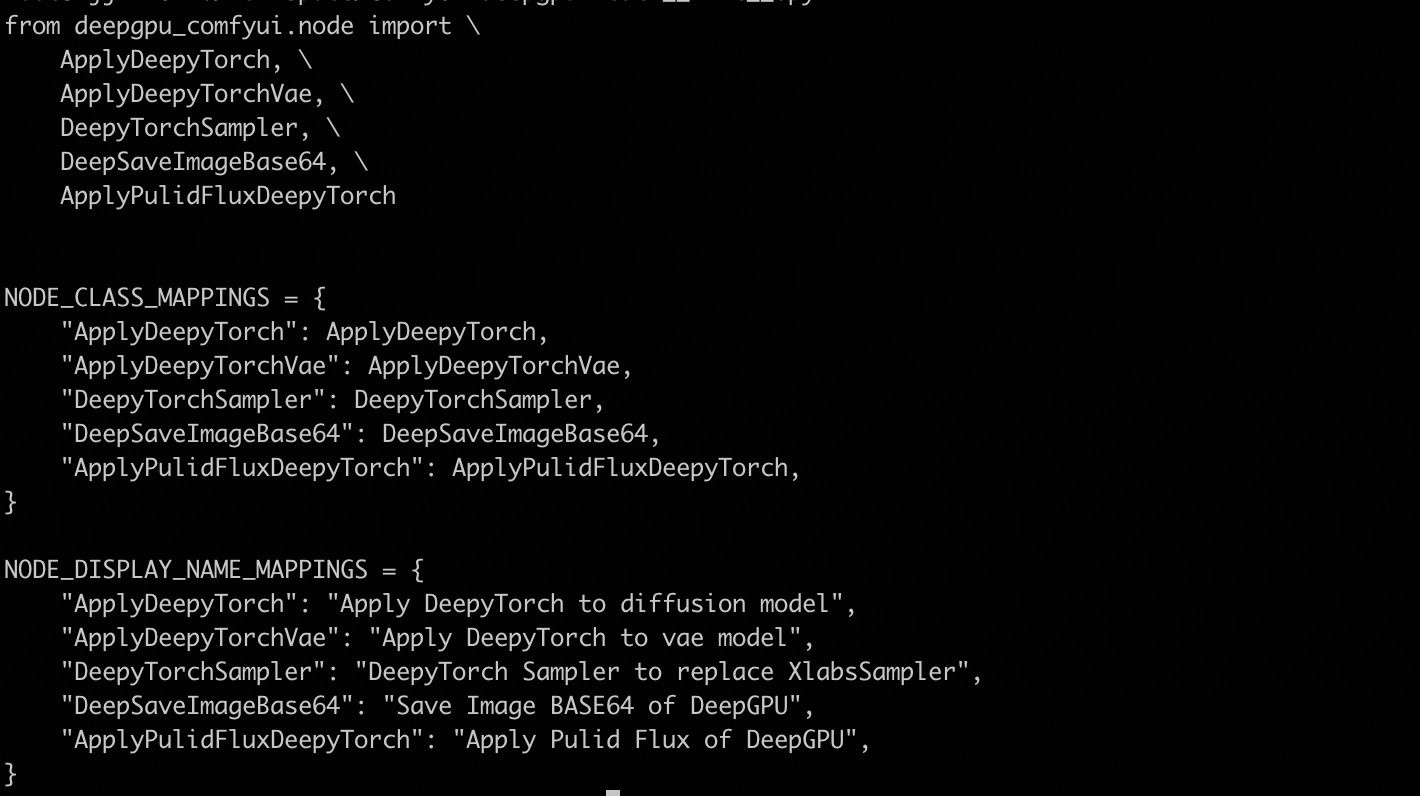

下载并解压ComfyUI-deepgpu。

cd ComfyUI/custom_nodes wget https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/deepgpu/comfyui/nodes/20250513/ComfyUI-deepgpu.tar.gz tar zxf ComfyUI-deepgpu.tar.gz

步骤二:部署ComfyUI服务

登录容器计算服务控制台,在左侧导航栏选择集群列表。然后单击目标集群名称,在左侧导航栏选择,然后单击右上角的使用YAML创建资源。

以挂载NAS存储卷为例,使用以下YAML作为模版,然后点击创建。

请按实际创建的PVC修改

persistentVolumeClaim.claimName配置。本示例使用的是

cn-beijing地域的inference-nv-pytorch 25.07,以减少镜像拉取的时间。若您希望使用其他地域的内网镜像,可以根据使用方式手动调整YAML中的镜像地址。本示例使用的测试容器镜像已内置deepgpu-torch、deepgpu-comfyui插件,如果您需要在其他容器环境内使用,请咨询PDSA获取插件安装包。

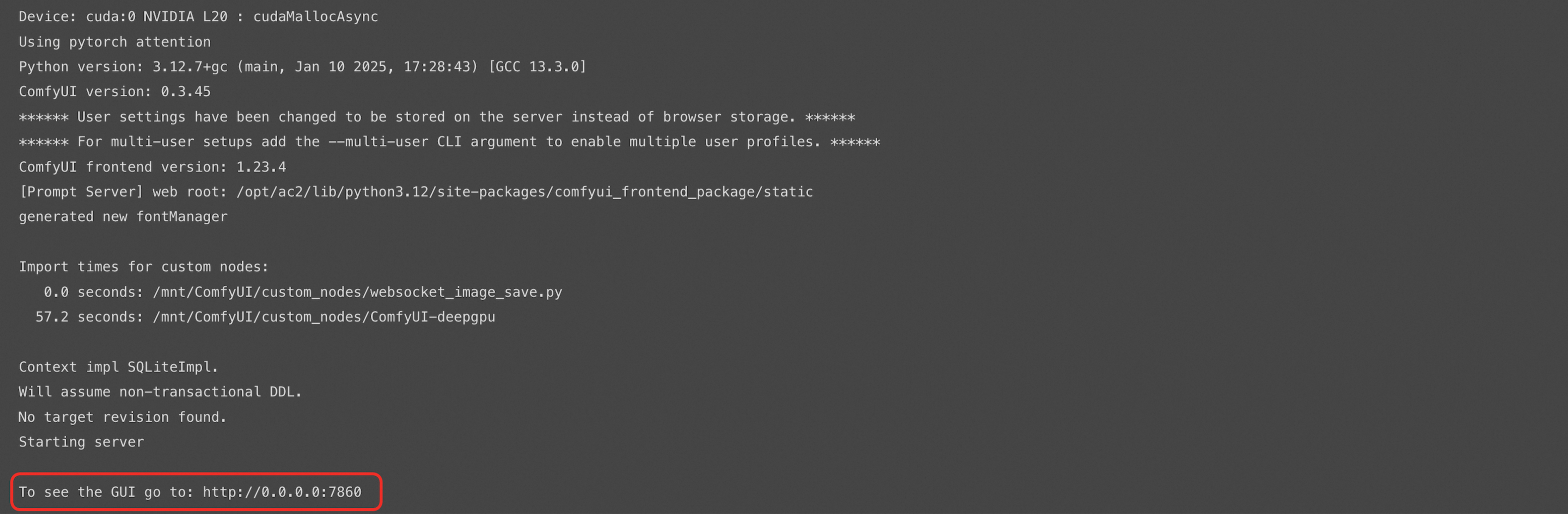

apiVersion: apps/v1 kind: Deployment metadata: labels: app: wanx-deployment name: wanx-deployment-test namespace: default spec: replicas: 1 selector: matchLabels: app: wanx-deployment template: metadata: labels: alibabacloud.com/compute-class: gpu alibabacloud.com/compute-qos: default alibabacloud.com/gpu-model-series: L20 #支持的GPU卡型:L20(GN8IS)、G49E app: wanx-deployment spec: containers: - command: - sh - -c - DEEPGPU_PUB_LS=true python3 /mnt/ComfyUI/main.py --listen 0.0.0.0 --port 7860 image: acs-registry-vpc.cn-beijing.cr.aliyuncs.com/egslingjun/inference-nv-pytorch:25.07-vllm0.9.2-pytorch2.7-cu128-20250714-serverless imagePullPolicy: Always name: main resources: limits: nvidia.com/gpu: "1" cpu: "16" memory: 64Gi requests: nvidia.com/gpu: "1" cpu: "16" memory: 64Gi terminationMessagePath: /dev/termination-log terminationMessagePolicy: File volumeMounts: - mountPath: /dev/shm name: cache-volume - mountPath: /mnt #/mnt为NAS存储声明影射到pod内的路径 name: data dnsPolicy: ClusterFirst restartPolicy: Always schedulerName: default-scheduler securityContext: {} terminationGracePeriodSeconds: 30 volumes: - emptyDir: medium: Memory sizeLimit: 500G name: cache-volume - name: data persistentVolumeClaim: claimName: wanx-nas #wanx-nas为通过NAS创建的存储声明 --- apiVersion: v1 kind: Service metadata: name: wanx-test spec: type: LoadBalancer ports: - port: 7860 protocol: TCP targetPort: 7860 selector: app: wanx-deployment在弹窗中点击查看,进入工作负载基本信息页面。点击下方日志页签,有如下输出,说明服务启动成功。

步骤三:插件用法介绍

点击访问方式页签,获取服务的外部端点(如8.xxx.xxx.114:7860)。

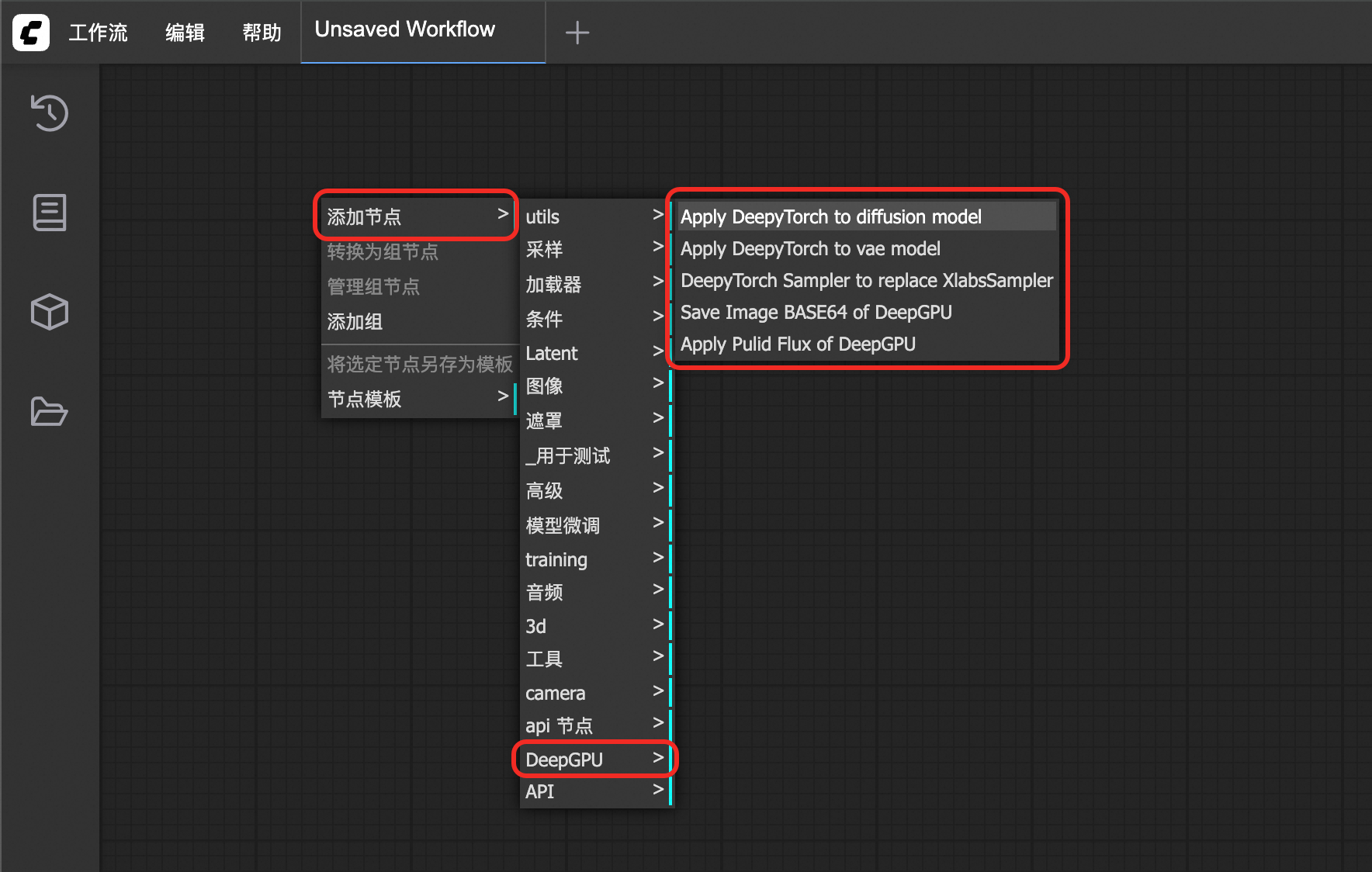

通过浏览器访问ComfyUI地址

http://8.xxx.xxx.114:7860/。在ComfyUI界面点击右键,然后点击添加节点,可以查看插件中包含DeepGPU类型的节点。首次访问加载用时约5分钟。

步骤四:测试示例工作流

通过浏览器下载wan2.1 DeepyTorch加速工作流到本地。

使用图片生成视频工作流。

https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/deepgpu/comfyui/wan/workflows/workflow_image_to_video_wan_1.3b_deepytorch.json使用文本生成视频工作流。

https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/deepgpu/comfyui/wan/workflows/workflow_text_to_video_wan_deepytorch.json

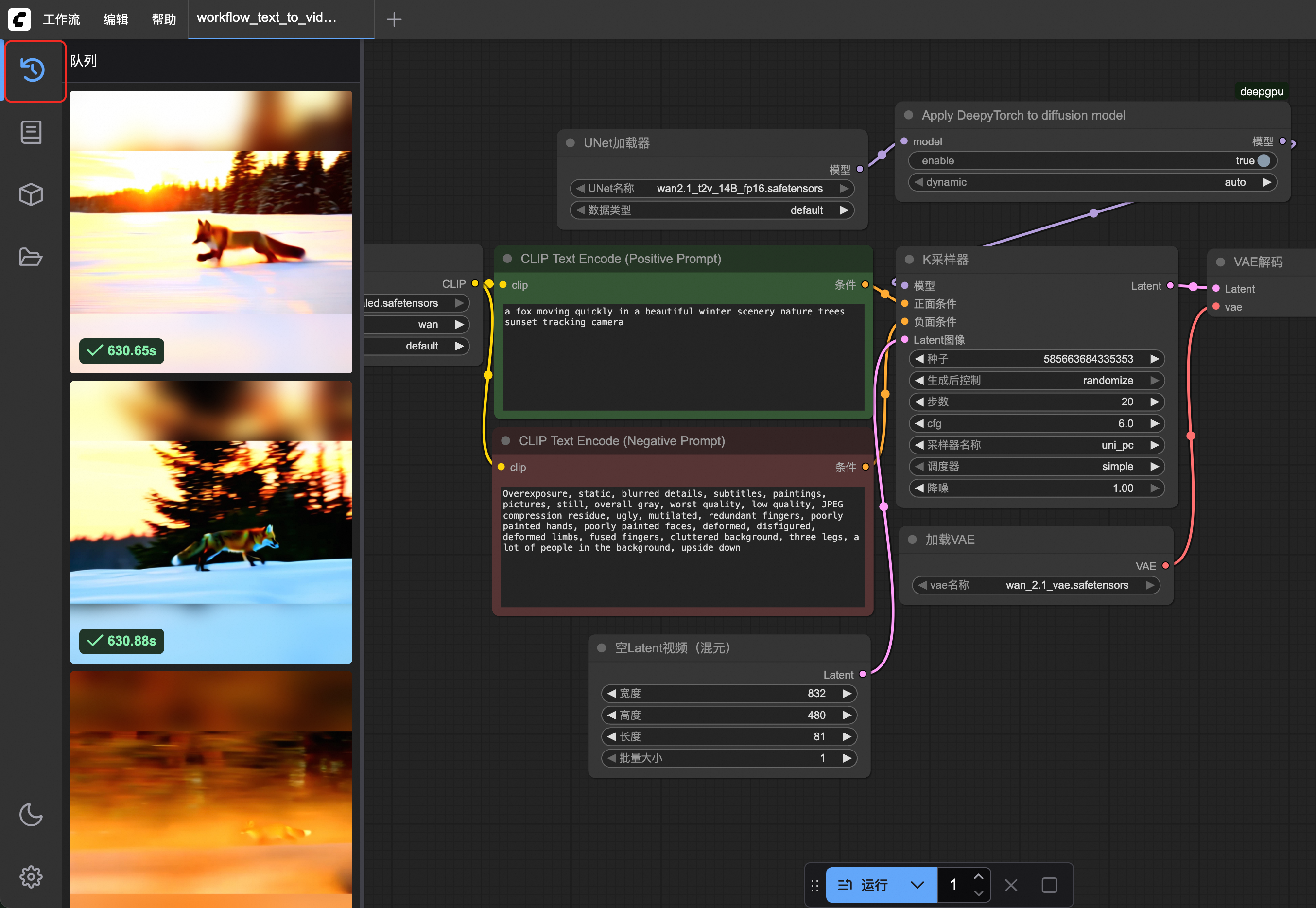

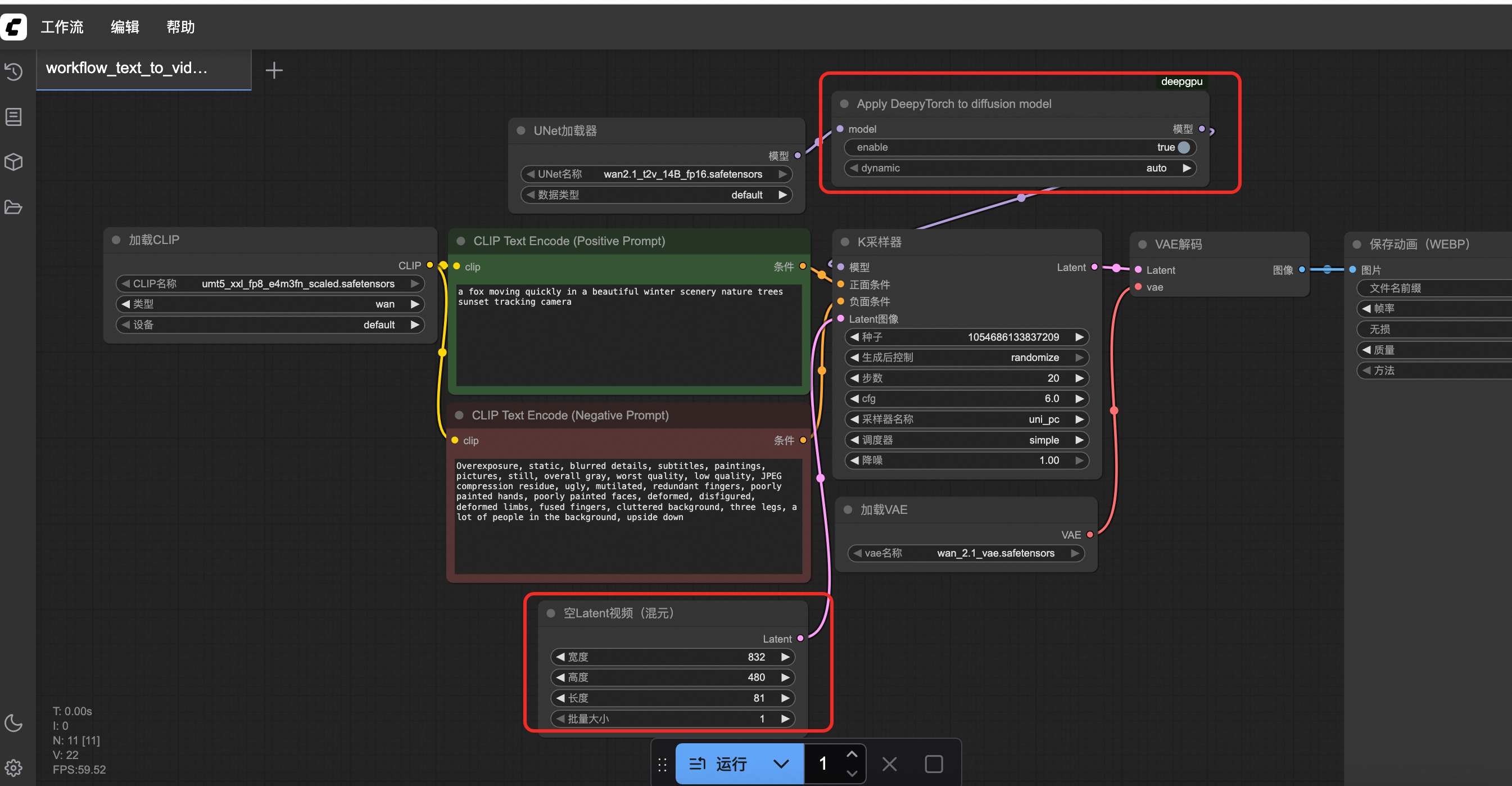

以下步骤以加速使用文本生成视频为例。在ComfyUI点击,然后选择已下载的

workflow_text_to_video_wan_deepytorch.json文件。打开工作流文件之后,需要将Apply DeepyTorch to diffusion model节点的enable设置为true来开启加速,然后点击运行,等待视频生成。

DeepyTorch加速工作流在Load Diffusion Model节点后插入ApplyDeepyTorch节点。

点击左侧队列按钮,可以查看视频生成时间并预览视频。

第一次测试生成时间会稍长,可以重复运行2~3次获取最佳性能。

(可选)如果要测试未加速场景,需要重启ComfyUI服务,并选择如下工作流生成视频。

https://aiacc-inference-public-v2.oss-cn-hangzhou.aliyuncs.com/deepgpu/comfyui/wan/workflows/workflow_text_to_video_wan.json