ACS集群的GPU-HPN容量预留是一种支持HPN高速网络的GPU算力资源的预留类型。通过将GPU-HPN容量预留与ACS集群中的虚拟节点相关联,您可以基于亲和性调度使用GPU容器算力,从而高效利用计算资源。本文介绍创建GPU-HPN容量预留,以及关联集群的详细步骤。

背景信息

使用ACS集群时,您无需再管理节点,但为了保持与原生Kubernetes的兼容性,您仍可以在集群中看到虚拟节点。虚拟节点拥有超大的计算资源容量,让ACS集群获得极大的弹性能力,而不必担心突发业务流量。默认的虚拟节点依据acs-profile ConfigMap中的vSwitchIds生成,本身不占用任何计算资源。

GPU-HPN容量预留介绍

GPU-HPN容量预留目前仅支持以预付费包年包月的方式,预留成功后周期内的资源始终可用,单次预留多个数量时,支持同时关联多个集群。预留的节点可以规划成不同数量和不同规格的Pod实例。例如在需要使用HPN高速网络进行GPU卡间分布式通信的大模型训练、微调等场景下,GPU-HPN容量预留可以以Pod规格的GPU数量整卡切分抵扣,不约束CPU和Memory大小。

计费及使用限制

容量预留以秒为计费单位,并遵循按量付费的标准。容量预留的计费周期如下:

计费开始:创建成功且状态转为已生效时,开始计费。

计费终止:预留容量到期自动释放后停止计费。

请提交工单开通GPU-HPN容量预留。

目前ACS集群仅支持相同GPU资源类型的容量预留抵扣。如果购买了不同的GPU卡型,则无法相互抵扣,ACS将按照实际购买的卡型价格进行计费。

GPU-HPN容量预留的节点仅支持计算类型为高性能网络GPU型(

gpu-hpn)的Pod使用。

创建GPU-HPN容量预留

登录容器计算服务控制台,在左侧导航栏,单击容量预留。

在容量预留页面,单击创建GPU-HPN资源预留,并输入以下内容。

配置项

说明

地域

选择资源预留所在的地域。

可用区

选择资源预留所在的可用区。

形态

目前仅支持实例。

分类

目前仅支持GPU。

HPN Zone

选择资源预留所在的HPN Zone。

节点型号

请以控制台实际显示内容为准。

购买时长

1个月、1年、3年。

首付比例(%)

0首付,购买后即可直接使用。

优惠信息

按照购买时长而有所不同。1个月期无优惠,1年期为12个月整购优惠,3年期为36个月整购优惠。

出账周期

每月。

分期次数

与购买时长相关。例如,购买1个月分期次数为1期,购买1年期分期次数为12期。

购买数量

购买实例个数。

配置完成后,单击立刻购买,在确认订单页面单击去支付。在支付页面单击订购,即可完成。

关联集群

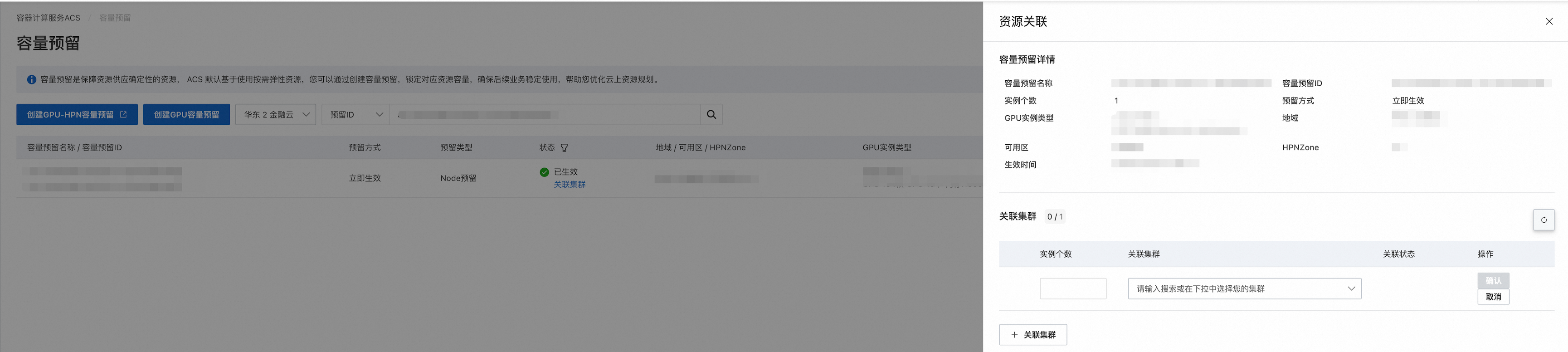

登录容器计算服务控制台,在左侧导航栏,单击容量预留。

在容量预留页面,单击需要关联集群的容量预留状态栏下方的关联集群。

重要仅支持关联到ACS集群、ACK托管集群、ACK One注册集群和ACK One分布式工作流Argo集群,不支持其他类型集群。

在弹出的资源关联页面,选择或填入待关联集群的ID和待关联的实例数,单击确认。

重要资源关联页面的关联集群下拉框中,只会显示ACS集群和ACK托管集群的ID。对于ACK One注册集群和ACK One分布式工作流Argo集群,请直接输入集群ID。

查询GPU-HPN容量预留已分配的资源

GPU-HPN容量预留以Kubernetes Node的形式在集群中体现,您可以通过kubectl工具查看Node已分配的资源。

执行以下命令,通过标签查看GPU-HPN节点。

kubectl get node -l alibabacloud.com/node-type=reserved预期输出:

NAME STATUS ROLES AGE VERSION cn-wulanchabu-c.cr-rkccqmu0xz8rea1***** Ready agent 20m v1.28.3-aliyun执行以下命令,查询GPU-HPN容量预留中已分配的资源。请将命令中的节点名称,替换为上一步获取的实际GPU-HPN节点名称。

kubectl describe node cn-wulanchabu-c.cr-rkccqmu0xz8rea1***** | grep Allocated -A 10预期输出:

Allocated resources: (Total limits may be over 100 percent, i.e., overcommitted.) Resource Requests Limits -------- -------- ------ cpu 16 (8%) 16 (8%) memory 128Gi (7%) 128Gi (7%) ephemeral-storage 30Gi (0%) 30Gi (0%) nvidia.com/gpu 1 1 Events: <none>其中第5~8行分别显示了CPU、内存、临时存储和GPU卡的分配量及分配率。