Dataphin支持使用ArgoDB作为Dataphin的离线计算引擎,为Dataphin项目提供处理离线计算任务的能力。本文为您介绍如何创建ArgoDB计算源。

前提条件

已完成TDH Inceptor元仓计算引擎的初始化并将计算引擎设置为TDH Inceptor,详情请参见使用星环TDH作为元仓计算引擎进行元仓初始化、设置Dataphin实例的计算引擎为TDH或ArgoDB。

仅TDH Inceptor元仓计算引擎支持创建ArgoDB计算源,其他元仓计算引擎不支持创建ArgoDB计算源。

背景信息

ArgoDB是星环自主研发的分布式分析型数据库,可替代Hadoop + MPP的混合架构。能够使用标准的SQL语法进行业务的建设,并且能够给用户提供多模型数据分析、实时数据处理、存储与计算模块解耦、异构服务器混合部署等先进技术能力。更多详情,请参见ArgoDB官网。

使用限制

当选择MySQL元数据库、ArgoDB System库或HMS方式获取元数据时,获取到的元数据信息可能存在部分信息无法获取或获取的信息不准确,具体如下。

元数据获取方式选择为MySQL元数据库或HMS时:

资产全景、数据板块、项目的数据量无法获取。

资产目录中表数据量、分区数据量、分区记录数无法获取。

资源治理的存储相关的指标信息不准确。

元仓共享模型中dim_dataphin_table和dim_dataphin_partition的数据量和记录数无法获取。

元数据获取方式选择为ArgoDB System库时:

资产目录的分区记录数信息无法获取。

资产目录中holodesk表数据量、分区数据量无法获取。

元仓共享模型中dim_dataphin_table和dim_dataphin_partition的记录数、holodesk格式的表数据量无法获取。

当HDFS连接信息的认证方式选择为非Kerberos认证、ArgoDB配置的认证方式选择为非LDAP认证时,可能会发生未知问题,开启前请联系Dataphin运维部署团队进行确认。

其他使用限制,具体如下。

当使用ArgoDB为计算引擎时,Dataphin不支持表管理。

脱敏算法不支持加盐哈希算法(包括加盐SHA256、加盐SHA384、加盐SHA512、加盐MD5)和高斯噪音脱敏算法(GaussianNoise)。

不支持Oracle、IBM DB2、Teradata等方言(Dialect),也不支持Oracle和DB2的存储过程。在SQL执行时可能会报错。

范围分区表仅支持DQL语句及少量DDL和DML语句。

操作步骤

在Dataphin首页,单击规划。

在左侧导航栏,选择项目 > 计算源。

在计算源页面单击+新增计算源,在下拉列表中单击ArgoDB计算源。

在新建计算源页面,配置相关参数。

a. 配置计算引擎源基本信息。

参数

描述

计算源类型

选择计算源类型为ArgoDB。

计算源名称

命名规则如下:

只能包含中文、数字、英文字母大小写、下划线(_)和短划线(-)。

长度不能超过64个字符。

计算源描述

对计算源的简单描述。

b. 配置集群基本信息。

参数

描述

namenode

默认为计算设置配置的NameNode参数值,不支持修改。

core-site.xml、hdfs-site.xml、hive-site.xml、其他配置文件

上传HDFS配置文件core-site.xml和hdfs-site.xml及hive的hive-site.xml文件。

若存在其他配置文件,您可在其他配置文件处进行上传。

认证方式

如果ARGODB集群有Kerberos认证,则此处认证方式需要选择为Kerberos。Kerberos是一种基于对称密钥技术的身份认证协议,可以为其他服务提供身份认证功能,且支持SSO(即客户端身份认证后,可以访问多个服务,例如HBase和HDFS)。

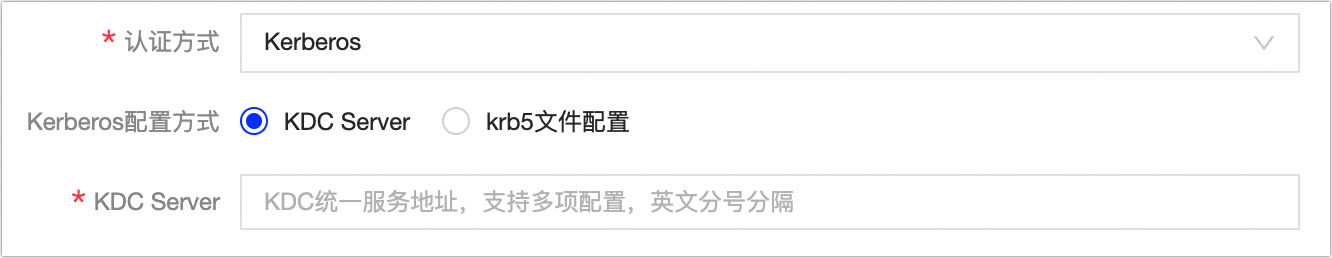

选择了Kerberos认证后,需要上传Krb5认证文件或配置KDC Server地址:

Krb5文件配置:需要上传Krb5文件进行Kerberos认证。

KDC Server地址:KDC服务器地址,辅助完成Kerberos认证。支持配置多个KDC Server服务地址,使用英文分号(,)分割。

c. 配置HDFS连接信息区域参数。

参数

描述

执行用户名、密码

登录计算执行机器用户名和密码,用于执行MapReduce任务、读取写入HDFS读存等。

重要请确保有提交MapReduce任务的权限。

认证方式

您如果HDFS有Kerberos认证,则此处认证方式需要选择为Kerberos。Kerberos是一种基于对称密钥技术的身份认证协议,可以为其他服务提供身份认证功能,且支持SSO(即客户端身份认证后,可以访问多个服务,例如HBase和HDFS)。

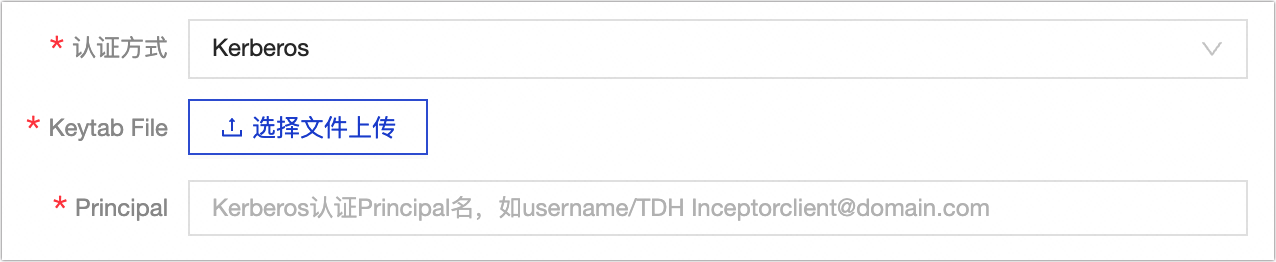

选择了Kerberos认证后,需要上传Keytab File认证文件及配置Principal地址:

Keytab File:需要上传Keytab File文件进行Kerberos认证。

Principal:对应的Kerberos认证用户名。

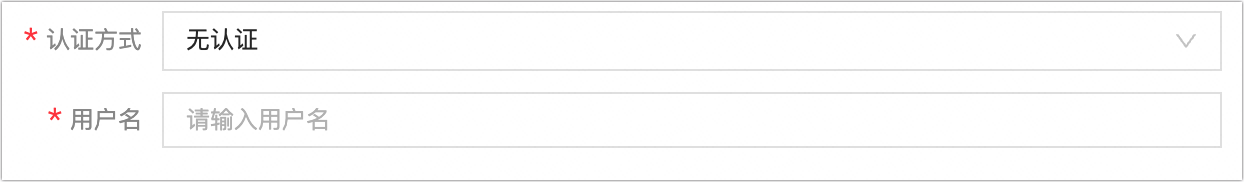

选择了无认证后,需要配置访问HDFS的用户名。

d. 配置ArgoDB配置区域的参数。

参数

描述

JDBC URL

配置Hive Server的JDBC连接地址,格式为

jdbc:hive2://InceptorServerIP:Port/Database。认证方式

选择ArgoDB的认证文件。您需要根据引擎情况进行选择,支持选择无认证、LDAP、Kerberos:

无认证:即没有认证。

LDAP:需要配置访问的用户名和密码。

Kerberos:您需要上传Kerberos认证的文件及配置Principal。

开发环境任务的执行用户

根据认证方式配置开发环境的任务的执行用户名、密码或上传Kerberos认证的文件及配置Principal。

周期性调度的任务的执行用户

根据认证方式周期性调度任务的执行用户名、密码或上传Kerberos认证的文件及配置Principal。

优先级任务队列

支持选择采用默认执行用户和自定义两种方式优先级执行的用户。

选择了自定义后,您需要配置不同优先级执行任务的用户名。

说明优先级队列是通过在Hadoop集群上创建不同的Yarn队列来分配资源。对应不同的任务的优先级,把相关的优先级的任务发送到对应的Yarn的队列来执行。

e. ArgoDB元数据连接信息。

参数

描述

元数据获取方式

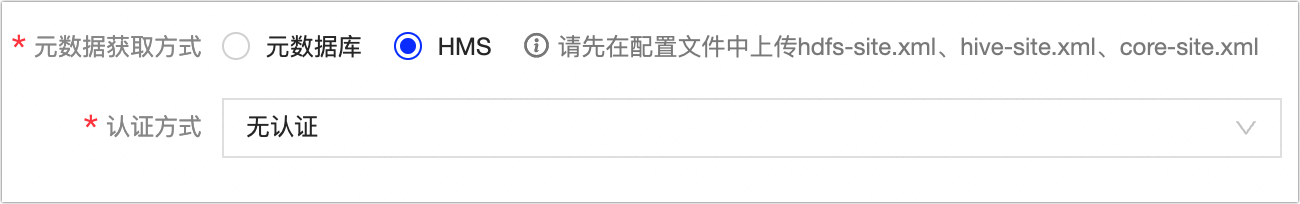

支持从元数据库获取和HMS获取方式。使用HMS请先在配置文件中上传hdfs-site.xml、hive-site.xml、core-site.xml文件及配置认证方式。

数据库类型

选择ArgoDB的元数据库类型。系统目前支持ArgoDB。

JDBC URL

填写对应元数据库的连接地址,格式为

jdbc:postgresql://<host>:<port>/<database name>。用户名、密码

填写登录元数据库的用户名和密码。

说明为保证任务正常执行,请确保填写的用户有所需数据权限。

单击测试连接。

连接测试通过后,单击提交。

后续步骤

完成创建ArgoDB计算源后,即可为项目绑定ArgoDB计算源。具体操作,请参见创建通用项目。