通过创建HDFS数据源能够实现Dataphin读取HDFS的业务数据或向HDFS写入数据。本文为您介绍如何创建HDFS数据源。

背景信息

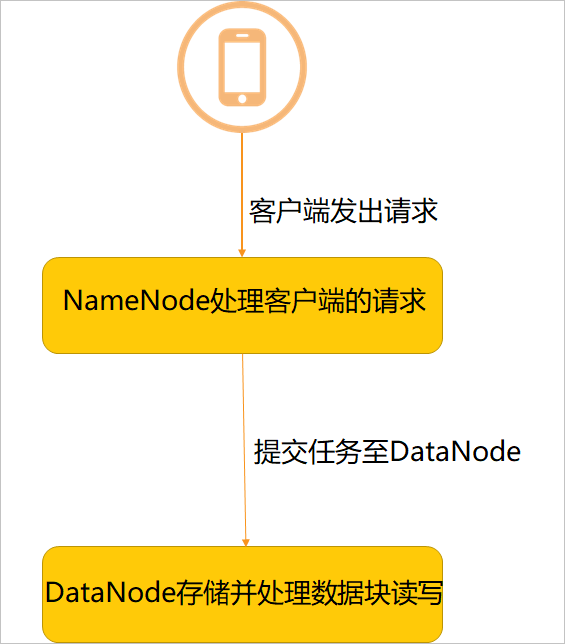

HDFS集群由NameNode和DataNode构成master-worker(主从)模式:

NameNode用于构建命名空间,管理文件的元数据等。

DataNode用于存储数据,及处理数据块的读写。

如果您使用的是HDFS,在引入HDFS的业务数据至Dataphin中或将Dataphin数据导出至HDFS的场景中,您需要先完成HDFS数据源的创建。更多HDFS信息,请参见HDFS官方介绍。

使用限制

Dataphin仅支持超级管理员、数据源管理员、板块架构师、项目管理员角色创建数据源。

超级管理员、数据源管理员角色添加与配置请参见添加、配置及管理Dataphin成员。

板块架构师配置请参见创建数据板块。

项目管理员配置请参见添加项目成员

创建HDFS数据源前,请确认Dataphin的IP地址已在HDFS的网络白名单中,以确保Dataphin能够访问HDFS中的数据。

操作步骤

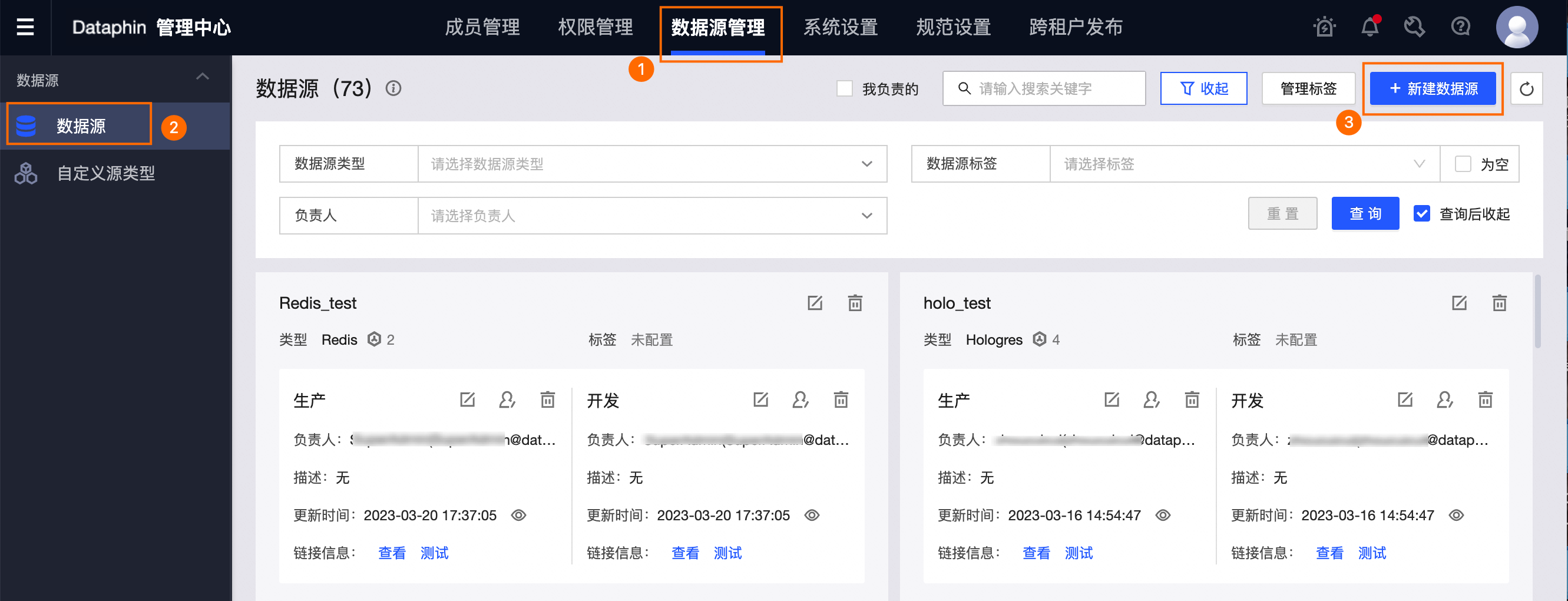

请参见数据源管理入口,进入数据源管理页面。

按照下图指引,进入新建数据源对话框。

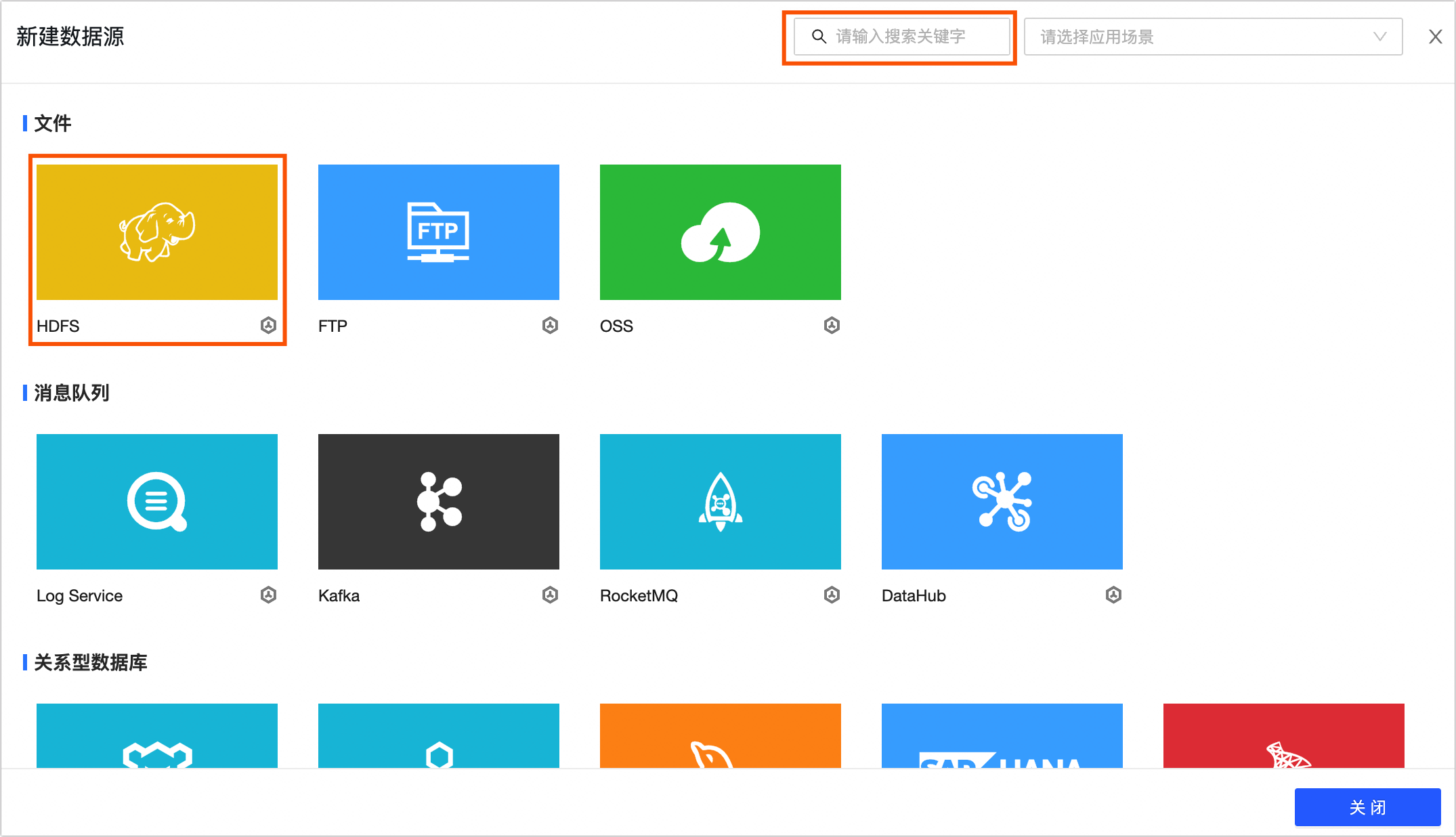

在新建数据源对话框的文件区域,选择HDFS。

如果您最近使用过HDFS,也可以在最近使用区域选择HDFS。同时,您也可以在搜索框中,输入HDFS的关键词,快速筛选。

在新建HDFS数据源对话框中,配置连接数据源参数。

配置数据源的基本信息。

参数

描述

数据源名称

命名规则如下:

只能包含中文、字母、数字、下划线(_)或中划线(-)。

长度不能超过64字符。

数据源编码

配置数据源编码后,您可以在Flink_SQL任务中通过

数据源编码.表名称或数据源编码.schema.表名称的格式引用数据源中的表;如果需要根据所处环境自动访问对应环境的数据源,请通过${数据源编码}.table或${数据源编码}.schema.table的变量格式访问。更多信息,请参见Dataphin数据源表开发方式。重要目前仅支持MySQL、Hologres、MaxCompute数据源。

数据源编码配置成功后不支持修改。

版本

选择数据源的版本,版本支持:

CDH5.x HDFS

EMR3.x HDFS

CDH6.x HDFS 2.1.1。

FusionInsight 8.x HDFS

CDP7.x HDFS

亚信DP5.x HDFS

EMR5.x HDFS

数据源描述

对数据源的简单描述。不得超过128个字符。

数据源配置

选择需要配置的数据源:

如果业务数据源区分生产数据源和开发数据源,则选择生产+开发数据源。

如果业务数据源不区分生产数据源和开发数据源,则选择生产数据源。

标签

您可根据标签给数据源进行分类打标,如何创建标签,请参见数据源管理标签。

配置数据源与Dataphin的连接参数。

若您的数据源配置选择生产+开发数据源,则需配置生产+开发数据源的连接信息。如果您的数据源配置为生产数据源,仅需配置生产数据源的连接信息。

说明通常情况下,生产数据源和开发数据源需配置非同一个数据源,以使开发数据源与生产数据源的环境隔离,降低开发数据源对生产数据源的影响。但Dataphin也支持配置成同一个数据源,即相同参数值。

参数

描述

NameNode

NameNode为HDFS集群中NameNode节点的HostName或者IP和端口。

配置样例:

host=192.168.*.1,webUiPort=,ipcPort=8020。其中,webUiPort和IPCport在CDH5环境下默认是50070和8020,您可根据实际情况填写对应的端口。说明webUiPort非必填项。未填写webUiPort对HDFS数据源使用无影响。

配置文件

用于上传Hadoop的配置文件,例如hdfs-site.xml、core-site.xml,配置文件可在Hadoop集群导出。

Kerberos

Kerberos是一种基于对称密钥技术的身份认证协议。

如果Hadoop集群有Kerberos认证,则需要开启Kerberos认证,并上传用户的Krb5认证文件或配置KDC Server地址、Keytab File和Principal:

Krb5文件:上传Krb5文件进行Kerberos认证。

KDC Server:KDC服务器地址,辅助完成Kerberos认证。

Keytab File:上传keytab文件,您可以在HDFS Server上获取keytab文件。

Principal:填写HDFS Keytab File文件对应的Kerberos认证用户名。

说明支持配置多个KDC Server服务地址,使用英文逗号

,分割。

单击测试连接,测试数据源是否可以和Dataphin进行正常的连通。

测试成功后,单击确定,完成HDFS数据源的创建。

- 本页导读 (0)