源端重复数据删除(Source deduplication)简称为源端重删,可在备份数据库时,在源端识别并去除已备份的重复数据,仅备份改动的数据。

背景信息

随着数据快速增长,传统备份上云的两个问题越来越突出:

带宽成本:为保证短时间内大量备份数据能快速上云,通常需要较大的带宽专线进行支撑,需要较昂贵的专线费用。

存储成本:需要支付大量冗余数据的存储费用。

DBS在物理备份场景中,引入源端重删功能,可在备份数据过程中节省数据传输的网络带宽和数据存储容量。

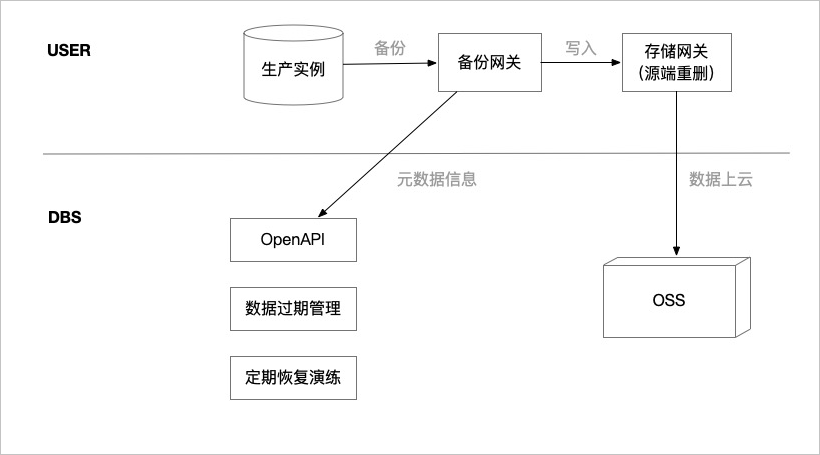

下图为源端重删在备份流程中的架构设计。

图 1. 源端重删架构设计

支持的备份计划

自建MySQL数据库的物理备份。

典型应用场景

备份数据较大

当备份数据较大时,您可以通过源端重删降低网络带宽和数据存储的压力。

数据改动频率低

当数据改动较少时,源端重删功能可以识别并过滤出没有改动的数据,仅备份改动的数据,极大地提高了数据传输效率,并降低了数据存储成本。

说明若数据没有改动时,源端重删可以在备份时实现零传输。

数据长期归档场景

源端重删不仅能过滤重复的数据,而且还能提供较普通备份场景更低的压缩率,在数据长期归档的场景中可以降低数据存储费用。

功能优势

基于源端重删技术的备份有如下功能优势:

优秀的压缩率(即文件压缩后的大小与压缩前的大小之比):针对实际的MySQL数据进行了测试,测试结果显示源端重删的压缩率在25%左右,明显优于压缩率在40%左右的GZip。

极速上传:将数据切片后并发上传,极大地提高了数据备份速度。

性能损耗低:在保证重删率的情况下,选择了比较平衡的切片大小,消耗更少的CPU和内存。

提供限流功能:您可以根据带宽情况,限制数据上传速度,保证线上服务稳定。

活动说明

该功能公测中,请使用钉钉搜索35585947群组,进群获取公测机会。公测阶段提供一对一技术服务,每个账号可获得一个免费的备份计划实例(三个月)。