您可以自行编写并构建包含业务逻辑的Python脚本,上传该脚本后,即可便捷地进行PySpark开发。本文通过一个示例,为您演示如何进行PySpark开发。

前提条件

操作步骤

步骤一:准备测试文件

在EMR Serverless Spark中,支持使用本地或独立的开发平台完成Python文件的开发,并将任务提交至EMR Serverless Spark中运行。本快速入门为了带您快速熟悉PySpark任务,为您提供了测试文件,您可以直接下载以供后续步骤使用。

单击DataFrame.py和employee.csv,直接下载测试文件。

DataFrame.py文件是一段使用Apache Spark框架进行OSS上数据处理的代码。

employee.csv文件中定义了一个包含员工姓名、部门和薪水的数据列表。

步骤二:上传测试文件

上传Python文件到EMR Serverless Spark。

进入资源上传页面。

在左侧导航栏,选择。

在Spark页面,单击目标工作空间名称。

在EMR Serverless Spark页面,单击左侧导航栏中的文件管理。

在文件管理页面,单击上传文件。

在上传文件对话框中,单击待上传文件区域选择Python文件,或直接拖拽Python文件到待上传文件区域。

本文示例是上传DataFrame.py。

上传数据文件(employee.csv)到阿里云对象存储OSS控制台,详情请参见文件上传。

步骤三:开发并运行任务

在EMR Serverless Spark页面,单击左侧的数据开发。

在开发目录页签下,单击

图标。

图标。在弹出的对话框中,输入名称,类型使用,单击确定。

在右上角选择队列。

添加队列的具体操作,请参见管理资源队列。

在新建的开发页签中,配置以下信息,其余参数无需配置,然后单击运行。

参数

说明

主Python资源

选择前一个步骤中在文件管理页面上传的Python文件。本文示例是DataFrame.py。

运行参数

填写数据文件(employee.csv)上传到OSS的路径。例如,oss://<yourBucketName>/employee.csv。

运行任务后,在下方的运行记录区域,单击任务操作列的日志探查。

在日志探查页签,您可以查看相关的日志信息。

步骤四:发布任务

已发布的任务可以作为工作流节点的任务。

任务运行完成后,单击右侧的发布。

在任务发布对话框中,您可以输入发布信息,然后单击确定。

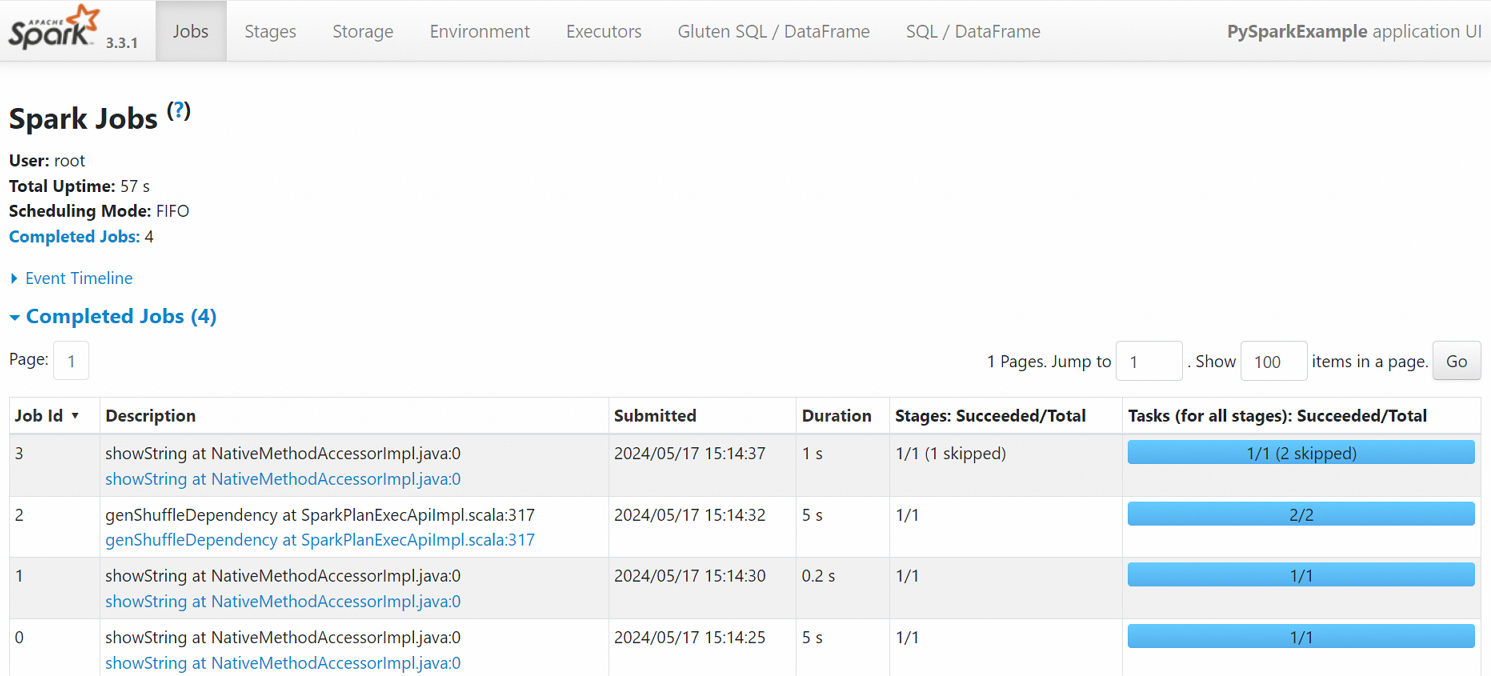

步骤五:查看Spark UI

任务正常运行后,您可以在Spark UI上查看任务的运行情况。

在左侧导航栏,单击任务历史。

在Application页面,单击目标任务操作列的Spark UI。

在Spark Jobs页面,您可以查看任务详情。

相关文档

任务发布完成后,您可以在工作流调度中使用,详情请参见管理工作流。任务编排完整的开发流程示例,请参见SparkSQL开发快速入门。

PySpark流任务的开发流程示例,请参见通过Serverless Spark提交PySpark流任务。