EMR Serverless Spark兼容spark-submit命令行参数,简化了任务执行流程。本文通过一个示例,为您演示如何进行Spark Submit任务的开发与部署,确保您能够快速上手。

前提条件

已创建工作空间,详情请参见管理工作空间。

已提前完成业务应用程序开发,并构建好JAR包。

操作步骤

步骤一:开发JAR包

在EMR Serverless Spark中,不直接提供集成的JAR包开发环境,因此需要您在本地或独立的开发平台上完成Spark应用的编码和打包成JAR文件。本快速入门为了带您快速熟悉JAR任务,为您提供了工程文件以及测试JAR包,您可以直接下载以备后续步骤使用。

单击spark-examples_2.12-3.3.1.jar,直接下载测试JAR包。

该JAR包是Spark自带的一个简单示例,用于计算圆周率π的值。

步骤二:上传JAR包至OSS

本文示例是上传spark-examples_2.12-3.3.1.jar,上传操作可以参见简单上传。

步骤三:开发并运行任务

在EMR Serverless Spark页面,单击左侧的任务开发。

单击新建。

输入任务名称,新建一个类型的任务,然后单击确定。

在右上角选择队列。

添加队列的具体操作,请参见管理资源队列。

在新建的任务开发中,配置以下信息,其余参数无需配置,然后单击运行。

参数

说明

脚本

填写您的Spark Submit脚本。

例如,脚本内容如下。

--class org.apache.spark.examples.SparkPi \ --conf spark.executor.memory=2g \ oss://<YourBucket>/spark-examples_2.12-3.3.1.jar在下方的运行记录区域,单击任务操作列的详情。

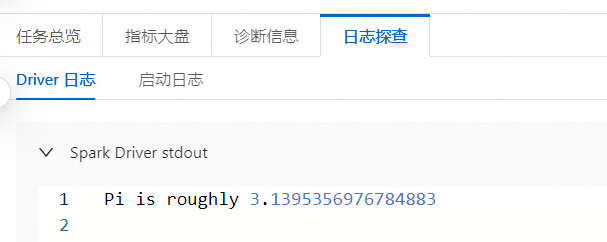

在日志探查页签,您可以查看相关的日志信息。

步骤四:发布任务

已发布的任务可以作为工作流节点的任务。

任务运行完成后,单击右侧的发布。

在任务发布对话框中,可以输入发布信息,然后单击确定。

(可选)步骤五:查看Spark UI

任务正常运行后,您可以在Spark UI上查看任务的运行情况。

在左侧导航栏,单击任务历史。

单击开发任务。

在开发任务页面,单击目标任务操作列的Spark UI。

将自动打开Spark UI页面,可查看任务详情。

相关文档

- 本页导读