本文为您介绍如何使用PAI-LangStudio和Qwen3构建基于MCP协议的Hologres ChatBI智能应用。该应用通过将Agent、MCP Server等技术与阿里最新的推理模型Qwen3整合在同一应用流中,为大模型提供了MCP+OLAP的智能数据分析能力。用户只需使用自然语言,即可实现OLAP数据分析的查询效果,从而有效减少了大模型幻觉的发生。开发者可基于该模板进行灵活扩展和二次开发,以满足特定场景的需求。

背景信息

PAI-LangStudio:大模型&Agent应用开发平台(PAI-LangStudio)是依托阿里云PAI产品核心能力构建的面向企业级用户的一站式大模型应用开发平台。LangStudio Agent智能体支持通过HTTP with SSE或Streamable HTTP传输方式调用MCP Server,利用MCP协议进行工具的发现与调用。

Qwen3:作为Qwen系列最新一代的大语言模型,提供了一系列密集(Dense)和混合专家 (MOE)模型。基于广泛的训练,Qwen3在推理、指令跟随、代理能力和多语言支持方面取得了突破性的进展。

Hologres实时数仓:阿里云自研一站式实时数仓产品,不仅支持海量数据多维分析(OLAP)、高并发低延迟的在线数据服务(Serving),还与达摩院自研高性能向量计算软件库Proxima深度整合,支持高性能、低延时、简单易用的向量计算能力。

MCP大模型协议:模型上下文协议(Model Context Protocol,MCP)是Anthropic于2024年推出的开源标准,旨在解决大模型与外部工具、数据源的集成难题。其核心作用是通过标准化接口架构,将AI模型的决策逻辑与外部资源解耦,形成智能大脑和外接四肢的协同模式。

Hologres MCP Server:Hologres MCP服务器作为AI代理与Hologres数据库之间的通用接口,支持AI代理与Hologres之间的无缝通信,帮助AI代理获取Hologres数据库元数据并执行SQL操作。

使用PAI-LangStudio和Qwen3构建基于MCP协议的Hologres ChatBI智能应用(支持VPC部署环境和SSE接入模式)主要分为以下步骤:

前提条件

已创建专有网络VPC、交换机和安全组。具体操作请参见专有网络和交换机。

已开通PAI。具体操作请参见开通PAI并创建默认工作空间。

已创建存储空间(Bucket)。具体操作请参见OSS快速入门。

Qwen3模型服务、Hologres实例、MCP Server服务和LanStudio Agent运行时所属的网络必须配置在同一VPC网络环境下。

Bucket必须与PAI控制台创建的Qwen3模型服务在同一地域下。

准备工作

Hologres数据来源于TPC-H数据集中的customer表。您可以直接下载customer数据。通过一键上传本地文件,将数据导入customer_holo_table表中,用于后续模型问答测试。

表结构创建SQL如下。

CREATE TABLE customer_holo_table

(

c_custkey BIGINT ,

c_name TEXT ,

c_address TEXT ,

c_nationkey INT ,

c_phone TEXT ,

c_acctbal DECIMAL(15,2) ,

c_mktsegment TEXT ,

c_comment TEXT

);步骤一:搭建Hologres MCP Server

登录Function AI控制台,进入探索页面。

重要首次使用需要您根据页面完成角色授权。

在筛选应用模板中,选择MCP Server。

在搜索框输入Hologres。

单击实时数仓 Hologres模板,进入模板详情页面。

单击立即部署,进入创建项目页面。配置相关参数,其他参数默认保持不变。

参数

配置说明

地域

选择与Qwen3模型所在地域一致。

服务名称

填写

hologres-mcp-server-studio。部署后服务名称不可修改。函数计算访问Hologres服务角色

AliyunFcDefaultRole默认不变。专有网络

选择您已创建的VPC,交换机和安全组。

交换机

安全组

Hologres实例Host

进入Hologres管理控制台,选择左侧导航栏实例列表,单击目标实例,在实例详情页网络信息中获取指定VPC网络地址和端口。

Host:

hgpostcn-cn-****-cn-hangzhou-vpc-st.hologres.aliyuncs.com。端口:80。

Hologres实例端口

Hologres数据库名称

已创建的数据库名。例如

holostudio。单击部署项目,等待部署完成。

进入项目中在访问地址中记录VPC访问地址信息,在配置下的MCP服务配置中记录Bearer Token信息。

为函数计算访问Hologres服务的角色

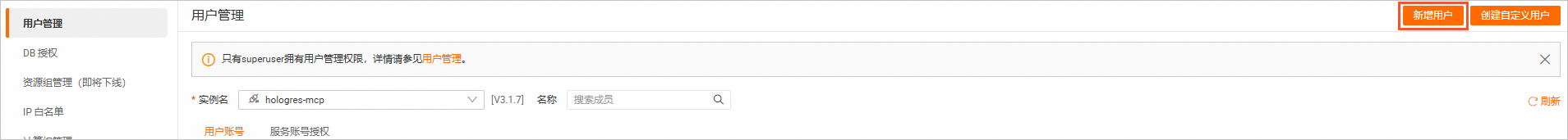

AliyunFcDefaultRole在Hologres数据库中授予查询(Viewer)权限。若您需要对数据库执行更高级别权限操作,可授予Developer及以上权限。步骤如下:登录Hologres 管理控制台,单击上面创建的实例名称,单击右上方的登录实例,进入 HoloWeb 页面。

单击顶部菜单中的安全中心,然后在左侧边栏,单击用户管理。

按照下图所示,单击新增用户。

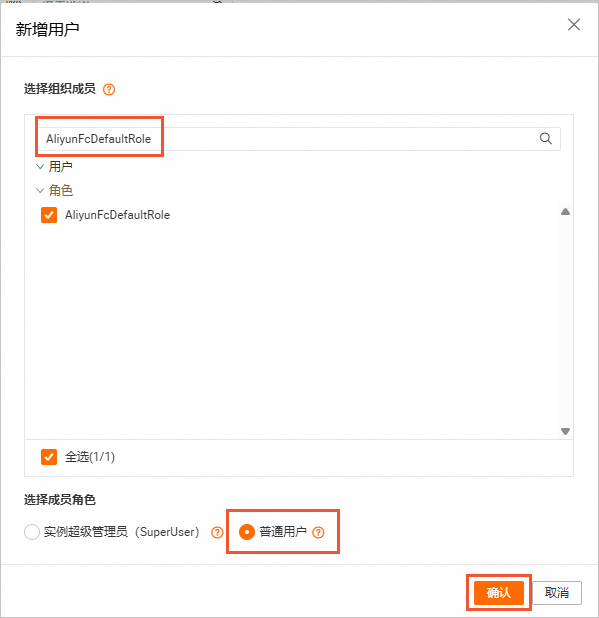

搜索框中输入

AliyunFcDefaultRole,勾选全部角色,然后单击确认。

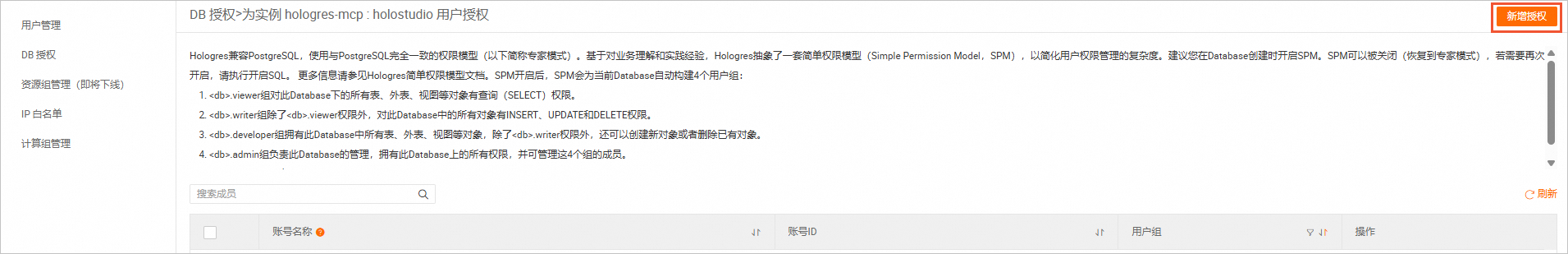

按照以下步骤完成 DB 授权。

在左侧边栏,单击DB 授权,在

holostudio数据库操作列,单击用户授权。

在数据库用户授权页面,单击新增授权。

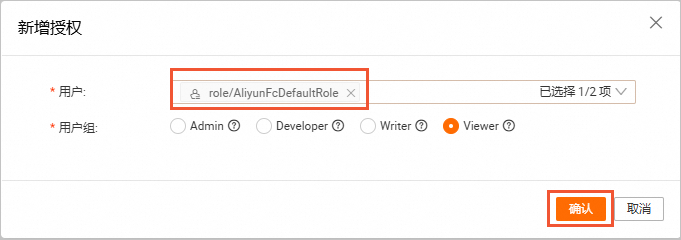

在弹框中,下拉选择用户

role/AliyunFcDefaultRole,用户组选择Viewer,然后单击确认。

步骤二:部署Qwen3模型

登录PAI控制台。

在左侧导航栏单击,进入Model Gallery页面。

单击模型Qwen3-8B,进入Qwen3-8B模型介绍页面。

单击右上角部署,选择已创建的工作空间,在部署页面完成参数配置,其他参数默认保持不变。

参数

配置说明

服务名称

使用默认,例如

quickstart_deploy_20250528_uwax。部署资源

使用默认,例如

ecs.gn7i-c8g1.2xlarge。您也可选择其他资源,较高的配置将会导致更高的计费。专有网络

选择您已创建的VPC,交换机和安全组。

单击部署,等待部署完成。

步骤三:搭建ChatBI Agent

登录PAI控制台。

在左侧导航栏单击。

选择已创建的工作空间,单击进入LangStudio。

新建运行时

选择运行时,单击新建运行时,进入运行时配置页面。配置相关参数,其他参数保持不变。

参数

配置说明

运行时名称

自定义配置,例如

holo_studio_runtime。运行时工作路径

选择已创建存储空间(Bucket)路径。例如

oss://holo_studio_bucket.oss-cn-hangzhou-internal.aliyuncs.com/。资源规格

默认不变,例如

ecs.c6.large(2 vCPU, 4 GiB)。您也可选择其他资源,较高的配置将会导致更高的计费。专有网络配置

选择您已创建的VPC,交换机和安全组。

安全组

交换机

单击确定,完成配置。

新建连接

选择连接,单击新建连接。进入到新建连接页面,配置相关参数。

参数

配置说明

名称

自定义配置,例如

holo_studio_link。连接类型

默认选择通用LLM模型服务连接。

服务提供方

默认选择PAI-EAS模型服务。

EAS服务

选择步骤一所创建的Qwen3模型服务。例如

quickstart_deploy_20250528_uwax。模型名称

自动映射Qwen3-8B。

Tool Call

选择支持。

base_url

Qwen3模型服务VPC访问地址。

api_key

Qwen3模型服务Token。

单击确定,完成配置。

新建应用流

选择应用流,单击新建应用流。进入到新建应用流页面,配置相关参数。

参数

配置说明

新建方式

选择从模板新建。

选择模板

选择智能数据Agent。

名称

自定义名称,例如

holo_studio_stream。选择运行时

选择已创建的运行时,例如

holo_studio_runtime。工作路径

选择已创建存储空间(Bucket)路径。例如

oss://holo_studio_bucket.oss-cn-hangzhou-internal.aliyuncs.com/。说明该路径必须与运行时的路径保持一致。

单击确定,完成配置。

Agent配置

选择应用流,单击创建的目标应用流ID,进入应用流详情页。

单击数据分析Agent节点。在数据分析Agent配置页面,进行参数相关配置,其他参数保持不变。

参数

配置说明

Agent策略

选择

FunctionCalling。模型设置

选择已新建的连接。

MCP服务配置

url:已创建MCP服务的VPC访问地址。

Authorization:已创建MCP服务的Bearer Token。格式

"Bearer <Bearer Token>"。

示例如下:

{ "mcpServers": { "hologres-mcp-server": { "type": "sse", "url": "https://aliyun-ng-****.cn-hangzhou-vpc.fcapp.run/sse", "headers": { "Authorization": "Bearer FB9A****-****-****-****-F5A8****" }, "timeout":30 } } }配置完成后,直接关闭即可。

步骤四:验证ChatBI Agent

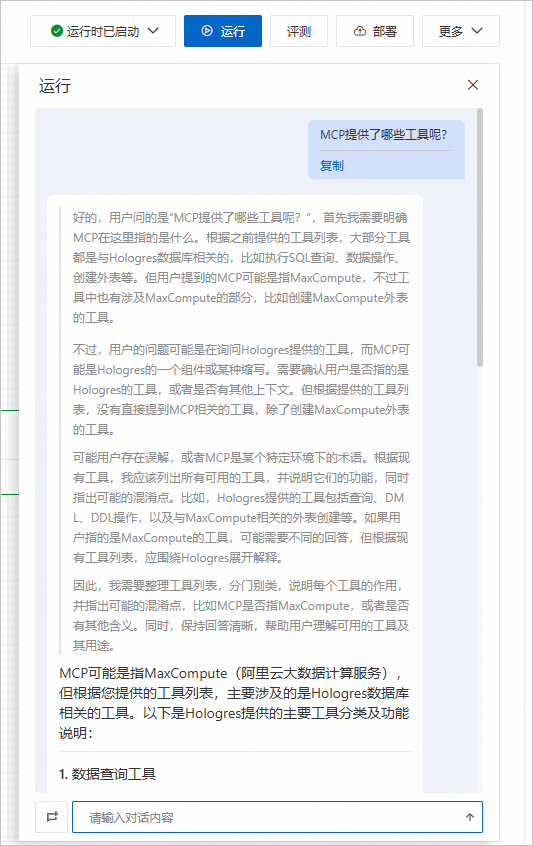

在应用流详情页,单击右上角运行,弹出对话框。在对话框中输入问题进行提问。

问题一:MCP提供了哪些工具呢?

问题二:查询public.customer_holo_table有多少条数据?

步骤五:部署EAS模型服务

在应用流详情页,单击右上角部署。进入部署配置页面,进行相关参数配置,其他参数保持默认不变。

参数

配置说明

服务创建方式

选择新建服务。

服务名称

默认

langstudio_20250528162801_lkpa。资源类型

选择公共资源。

部署资源

选择

ecs.c7.large(2 vCPU, 4GiB)。您也可选择其他资源,较高的配置将会导致更高的计费。专有网络(VPC)

选择您已创建的VPC,交换机和安全组。

交换机

安全组名称

选择路径

选择已创建存储空间(Bucket)路径。例如

oss://holo_studio_bucket.oss-cn-hangzhou-internal.aliyuncs.com/。说明该路径必须与运行时的路径保持一致。

单击确定,进行服务部署。

通过以上步骤,您可快速使用LangStudio构建基于Qwen3和Hologres MCP Server的智能数据分析ChatBI Agent应用,满足专业分析场景需求。

后续步骤

使用LangStudio完成应用部署后,可以调用服务,实现您的业务场景需求。

若您只是用于测试或学习,使用完成后,需要删除对应产品的实例,避免继续产生费用。

相关文档

Model Gallery模型开发更多信息,请参见Model Gallery。

大模型应用开发(LangStudio)更多信息,请参见大模型应用开发(LangStudio)。

MCP服务及开发更多信息,请参见MCP服务简介。