本文根据测试方案介绍中的场景,提供了相应的测试结果。

背景信息

本文的参考结果是针对Hologres公有云实例进行测试的结果。

测试所用的数据量及相关集群规格说明如下:

基于100GB数据集性能参考

测试所用的数据量及相关集群规格说明如下:

测试数据量说明:

表名称

表中包含的数据行数

LINEITEM

600,037,902

ORDERS

150,000,000

PARTSUPP

80,000,000

PART

15,000,000

CUSTOMER

20,000,000

SUPPLIER

1,000,000

NATION

25

REGION

5

集群规则说明如下:

计算资源

可用区

备注

64 CU(CPU:64 Core,内存:256 GB)

华东1(杭州)可用区J

使用集群默认配置,Shard数量为40。

128 CU(CPU:128 Core,内存:512 GB)

华东1(杭州)可用区J

使用集群默认配置,Shard数量为80。

测试结果

OLAP场景查询性能

查询执行时间以秒(s)为单位,结果均基于Hologres内部表,具体数值如下所示。随着实例规模的成本增长,查询时间也在成线性下降趋势。

TPCH

Query编号

TPCH 100G

TPCH 100G

64 CU(V3.1.3)

128 CU(V3.1.3)

64 CU(V2.2.19)

128 CU(V2.2.19)

1

0.48

0.36

0.55

0.34

2

0.19

0.18

0.17

0.15

3

0.43

0.28

0.38

0.29

4

0.26

0.15

0.32

0.19

5

0.53

0.41

0.68

0.48

6

0.1

0.12

0.10

0.08

7

0.48

0.34

0.55

0.36

8

0.48

0.37

0.51

0.38

9

1.52

0.91

1.62

1.00

10

0.81

0.43

0.69

0.47

11

0.19

0.17

0.37

0.32

12

0.19

0.14

0.22

0.15

13

0.53

0.36

0.67

0.37

14

0.19

0.13

0.19

0.13

15

0.34

0.19

0.36

0.23

16

0.35

0.29

0.41

0.33

17

0.21

0.18

0.22

0.16

18

1.57

0.89

2.02

0.94

19

0.26

0.19

0.25

0.17

20

0.24

0.22

0.24

0.27

21

0.79

0.56

1.03

0.63

22

0.26

0.18

0.28

0.22

Total

10.4

7.05

11.83

7.66

Key/Value点查场景性能

结果均基于Hologres内部表,软件版本为 r1.1.42,每类查询均连续运行5分钟,Hologres具体数值如下所示。随着实例规模的增长,QPS基本呈线性增长趋势。

具体场景

样例SQL

实例规格

并发客户端数量

QPS(包含连接时间)

QPS(不包含连接时间)

平均查询延迟

1

SELECT O_ORDERKEY ,O_CUSTKEY ,O_ORDERSTATUS ,O_TOTALPRICE ,O_ORDERDATE ,O_ORDERPRIORITY ,O_CLERK ,O_SHIPPRIORITY ,O_COMMENT FROM public.orders_row WHERE o_orderkey = {parameter} ;64CU

500

112,435

112,443

4.447 ms

128CU

1,000

242,755

242,772

4.119 ms

2

SELECT O_ORDERKEY ,O_CUSTKEY ,O_ORDERSTATUS ,O_TOTALPRICE ,O_ORDERDATE ,O_ORDERPRIORITY ,O_CLERK ,O_SHIPPRIORITY ,O_COMMENT FROM public.orders_row WHERE o_orderkey in ( {parameter1}, {parameter2}, {parameter3}, {parameter4}, {parameter5}, {parameter6}, {parameter7}, {parameter8}, {parameter9} );64CU

500

27,632

27,634

18.094 ms

128CU

1,000

90,086

90,092

11.100 ms

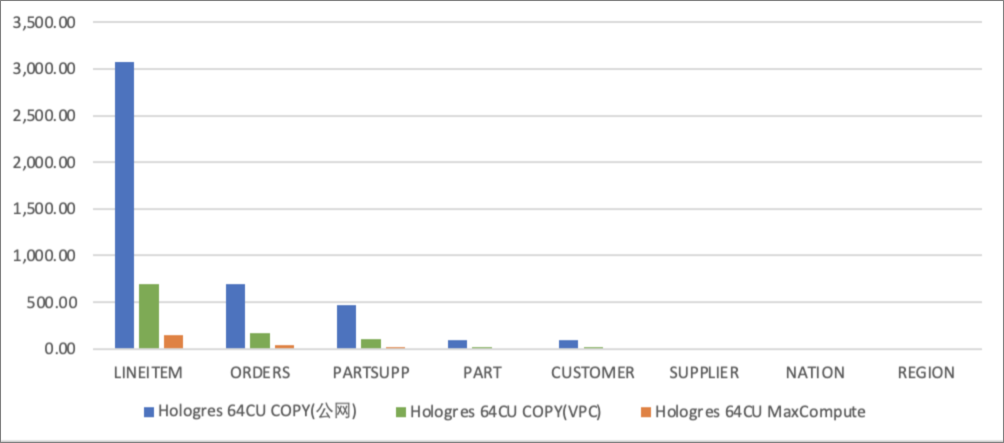

数据写入性能

导入时间指将数据导入Hologres内表的时间,数据导入时间以秒(s)为单位。下表以64 CU计算资源为例,为您展示各类导入时间的具体数值。

说明在使用COPY方法导入数据时,一张表对应一个数据文件,并未使用并发导入方式。

表名

数据行数

数据量

在公共网络下使用COPY方式导入

在VPC网络下使用COPY方式导入

使用MaxCompute外表导入

LINEITEM

600,037,902

73.6 GB

3,070.453

694.364

148.165

ORDERS

150,000,000

16.4 GB

691.060

172.529

37.741

PARTSUPP

80,000,000

2.3 GB

468.560

107.092

18.488

PART

20,000,000

11.3 GB

96.342

24.020

8.083

CUSTOMER

15,000,000

2.3 GB

95.190

22.937

10.363

SUPPLIER

1,000,000

132 MB

5.057

1.803

1.503

NATION

25

2 KB

0.580

0.584

0.747

REGION

5

0.375 KB

0.168

0.153

0.430

ORDERS_ROW

150,000,000

16.4 GB

717,653

143.800

25.676

Total

122.4 GB

722,080.410

1,167.282

251.196

导入时间图示如下图所示,图中蓝色为使用COPY方式在公网条件下导入数据的时间,绿色为使用COPY方式在VPC网络条件下导入数据的时间,灰色为使用MaxCompute外表方式导入的时间。其中纵坐标数值越低,表示导入速度越快。

说明横轴:表名。纵轴:数据导入时间(s)。

结合下图内容可以看出:

使用COPY方式导入本地文件数据时,由于网络带宽影响,使用VPC网络的导入数据时间明显短于使用公共网络的导入数据时间。

使用MaxCompute导入数据时间明显短于使用COPY方式导入本地文件数据时间。

数据更新性能

结果均基于Hologres内部表,软件版本 r1.1.42,每类查询均连续运行5分钟,Hologres具体数值如下所示。随着实例规模的增长,QPS基本呈线性增长趋势。

样例SQL

实例规格

并发客户端数量

QPS(包含连接时间)

QPS(不包含连接时间)

平均查询延迟

INSERT INTO public.orders_row( o_orderkey ,o_custkey ,o_orderstatus ,o_totalprice ,o_orderdate ,o_orderpriority ,o_clerk ,o_shippriority ,o_comment ) VALUES ( {parameter} ,1 ,'demo' ,1.1 ,'2021-01-01' ,'demo' ,'demo' ,1 ,'demo') on conflict(o_orderkey) do update set ( o_orderkey ,o_custkey ,o_orderstatus ,o_totalprice ,o_orderdate ,o_orderpriority ,o_clerk ,o_shippriority ,o_comment )= ROW(excluded.*);64CU

500

92,006

92,000

5.435 ms

128CU

1,000

191,761

191,771

5.215 ms

基于1TB数据集性能参考

测试所用的数据量及相关集群规格说明如下:

测试数据量说明:

表名称

表中包含的数据行数

数据量

LINEITEM

5,999,989,709

752.27 GB

ORDERS

1,500,000,000

167.11 GB

PARTSUPP

800,000,000

114.45 GB

PART

150,000,000

22.94 GB

CUSTOMER

200,000,000

22.85 GB

SUPPLIER

10,000,000

1.33 GB

NATION

25

2.15 KB

REGION

5

0.38 KB

集群规则说明如下:

计算资源

存储容量

备注

96 CU

(CPU:96 Core,内存:384 GB)

1000 GB

使用集群默认配置,Shard数量为60。

测试结果:OLAP场景查询性能

查询执行时间以秒(s)为单位,结果均基于Hologres内表,具体数值如下所示。

TPCH Query编号

查询耗时(V4.0.4)

查询耗时(V3.1.3)

查询耗时(V3.0.5)

1

3.07

3.00

8.47

2

0.34

0.39

0.36

3

3.98

3.60

5.77

4

1.53

1.78

1.71

5

4.55

4.68

7.65

6

0.27

0.32

0.34

7

3.48

3.25

3.56

8

1.97

2.34

5.61

9

13.28

13.94

16.83

10

4.33

5.89

5.61

11

1.79

2.42

2.23

12

0.69

0.93

0.84

13

4.56

4.58

5.78

14

0.78

0.83

0.79

15

1.87

1.96

2.27

16

2.02

1.85

1.64

17

0.93

1.05

4.64

18

11.51

13.08

13.74

19

0.86

1.45

3.00

20

0.76

1.22

0.95

21

4.73

5.15

7.20

22

2.72

2.57

2.17

Total

69.99

76.27

101.16

Flink实时数据写入场景性能参考

数据集基本信息

Hologres实例规格

计算资源

软件版本

备注

64 CU(CPU:64 Core,内存:256 GB)

r1.1.53

使用集群默认配置,Shard数量为40。

Flink全托管规格

引擎版本

vvr-4.0.12-flink-1.13

配置模式

基础模式

并发度

15

Job Manager CPU

1

Job Manager Memory

1 Gi

Task Manager CPU

1

Task Manager Memory

6 Gi

测试结果

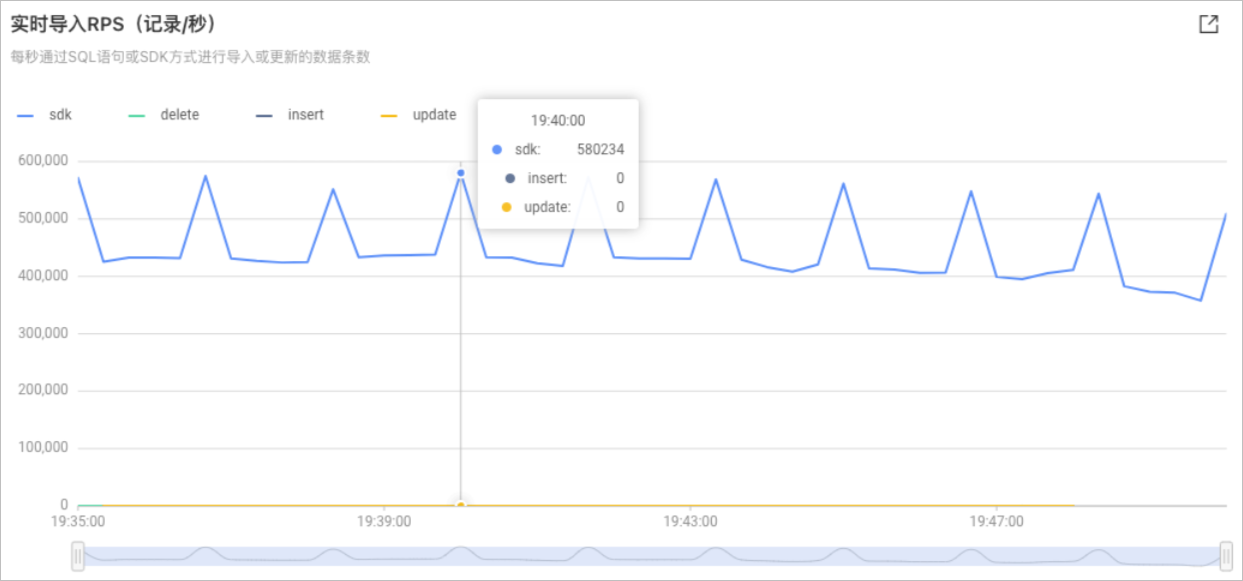

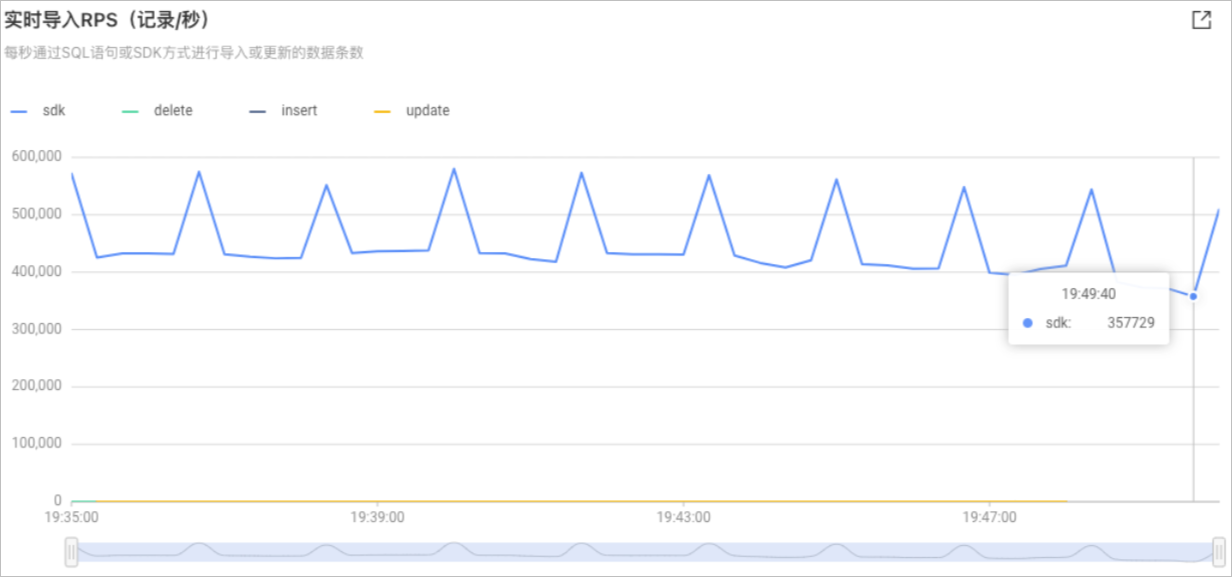

测试结果如下所示,可以看出从测试开始的2022年4月8日19:35至2022年4月8日19:50,RPS最大值为

580,234,最小值为357,729。