本文介绍如何使用阿里云智能语音服务提供的Java SDK,包括SDK的安装方法及SDK代码示例。

前提条件

下载安装

您可以下载现有的Maven示例项目,无需从零构建项目就可以体验语音合成的功能。您也可以从零构建项目或是将语音合成的代码集成到您现有的项目中。

Java SDK 从 2.1.7 版本开始(含2.1.7),waitForComplete 接口的超时时间单位从 秒 变更为 毫秒 。

SDK调用注意事项

NlsClient使用Netty框架,NlsClient对象的创建会消耗一定时间和资源,一经创建可以重复使用。建议调用程序将NlsClient的创建和关闭与程序本身的生命周期相结合。SpeechSynthesizer对象不可重复使用,一个语音合成任务对应一个SpeechSynthesizer对象。例如,N个文本要进行N次语音合成任务,创建N个SpeechSynthesizer对象。SpeechSynthesizerListener对象和SpeechSynthesizer对象是一一对应的,不能将一个SpeechSynthesizerListener对象设置到多个SpeechSynthesizer对象中,否则不能将各语音合成任务区分开。Java SDK依赖Netty网络库,如果您的应用依赖Netty,其版本需更新至4.1.17.Final及以上。

SDK使用步骤和关键接口说明

使用Java SDK编写语音合成代码的基本流程如下,您可以将代码示例中的代码复制到您的IDE中,并根据如下内容阅读代码,以便更好地理解(如您想了解更多接口细节,请参考Java API接口说明)。

1、创建实例

经过以下步骤,完成鉴权和连接服务代码的编写:

2、设置项目Appkey

调用SpeechSynthesizer实例的setAppKey方法设置项目Appkey。

接口/函数 | 参数 | 返回值 | 描述 |

|

| 无 | 设置项目Appkey。 |

示例:

synthesizer.setAppKey(appKey);3、设置语音合成相关参数

4、开始合成语音

调用SpeechSynthesizer实例的start方法。

接口/函数 | 参数 | 返回值 | 描述 |

| 无 | 无 | 开始语音合成。 |

示例:

synthesizer.start();5、等待语音合成结束

调用SpeechSynthesizer实例的waitForComplete方法。

接口/函数 | 参数 | 返回值 | 描述 |

| 无 | 无 | 等待语音合成结束。 |

|

| 无 | 等待语音合成结束。 |

示例:

//等待语音合成结束

synthesizer.waitForComplete();6、关闭连接并释放资源

调用

SpeechSynthesizer实例的close方法关闭连接。接口/函数

参数

返回值

描述

public void close()无

无

关闭连接。

调用

NlsClient实例的shutdown方法释放资源。接口/函数

参数

返回值

描述

public void shutdown()无

无

在应用的最后调用此方法,释放资源。

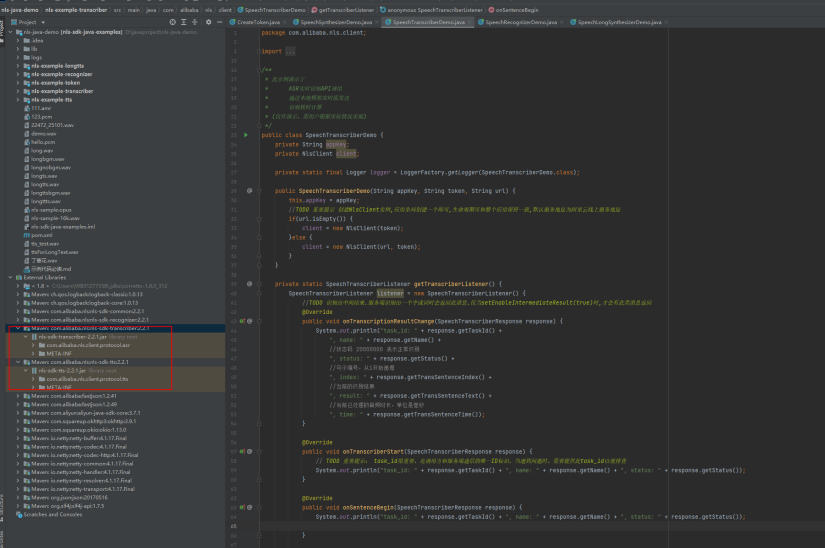

代码示例

示例中使用SDK内置的默认语音合成服务的外网访问服务URL,如果您使用位于阿里云上海地域的ECS,且需要通过内网访问服务URL,则在创建NlsClient对象时,设置内网访问的URL:

client = new NlsClient("wss://nls-gateway-cn-shanghai.aliyuncs.com/ws/v1", accessToken);示例中将合成的音频保存在文件中,如果您需要播放音频且对实时性要求较高,建议使用流式播放,即边接收语音数据边播放,减少延时。

调用接口前,需配置环境变量,通过环境变量读取访问凭证。智能语音交互的AccessKey ID、AccessKey Secret和AppKey的环境变量名:ALIYUN_AK_ID、ALIYUN_AK_SECRET、NLS_APP_KEY。

import java.io.File;

import java.io.FileOutputStream;

import java.io.IOException;

import java.nio.ByteBuffer;

import com.alibaba.nls.client.protocol.NlsClient;

import com.alibaba.nls.client.protocol.OutputFormatEnum;

import com.alibaba.nls.client.protocol.SampleRateEnum;

import com.alibaba.nls.client.protocol.tts.SpeechSynthesizer;

import com.alibaba.nls.client.protocol.tts.SpeechSynthesizerListener;

import com.alibaba.nls.client.protocol.tts.SpeechSynthesizerResponse;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

/**

* 此示例演示了:

* 语音合成API调用。

* 动态获取token。获取Token具体操作,请参见:https://help.aliyun.com/document_detail/450514.html

* 流式合成TTS。

* 首包延迟计算。

*/

public class SpeechSynthesizerDemo {

private static final Logger logger = LoggerFactory.getLogger(SpeechSynthesizerDemo.class);

private static long startTime;

private String appKey;

NlsClient client;

public SpeechSynthesizerDemo(String appKey, String accessKeyId, String accessKeySecret) {

this.appKey = appKey;

//应用全局创建一个NlsClient实例,默认服务地址为阿里云线上服务地址。

//获取token,使用时注意在accessToken.getExpireTime()过期前再次获取。

AccessToken accessToken = new AccessToken(accessKeyId, accessKeySecret);

try {

accessToken.apply();

System.out.println("get token: " + accessToken.getToken() + ", expire time: " + accessToken.getExpireTime());

client = new NlsClient(accessToken.getToken());

} catch (IOException e) {

e.printStackTrace();

}

}

public SpeechSynthesizerDemo(String appKey, String accessKeyId, String accessKeySecret, String url) {

this.appKey = appKey;

AccessToken accessToken = new AccessToken(accessKeyId, accessKeySecret);

try {

accessToken.apply();

System.out.println("get token: " + accessToken.getToken() + ", expire time: " + accessToken.getExpireTime());

if(url.isEmpty()) {

client = new NlsClient(accessToken.getToken());

}else {

client = new NlsClient(url, accessToken.getToken());

}

} catch (IOException e) {

e.printStackTrace();

}

}

private static SpeechSynthesizerListener getSynthesizerListener() {

SpeechSynthesizerListener listener = null;

try {

listener = new SpeechSynthesizerListener() {

File f=new File("tts_test.wav");

FileOutputStream fout = new FileOutputStream(f);

private boolean firstRecvBinary = true;

//语音合成结束

@Override

public void onComplete(SpeechSynthesizerResponse response) {

//调用onComplete时表示所有TTS数据已接收完成,因此为整个合成数据的延迟。该延迟可能较大,不一定满足实时场景。

System.out.println("name: " + response.getName() +

", status: " + response.getStatus()+

", output file :"+f.getAbsolutePath()

);

}

//语音合成的语音二进制数据

@Override

public void onMessage(ByteBuffer message) {

try {

if(firstRecvBinary) {

//计算首包语音流的延迟,收到第一包语音流时,即可以进行语音播放,以提升响应速度(特别是实时交互场景下)。

firstRecvBinary = false;

long now = System.currentTimeMillis();

logger.info("tts first latency : " + (now - SpeechSynthesizerDemo.startTime) + " ms");

}

byte[] bytesArray = new byte[message.remaining()];

message.get(bytesArray, 0, bytesArray.length);

fout.write(bytesArray);

} catch (IOException e) {

e.printStackTrace();

}

}

@Override

public void onFail(SpeechSynthesizerResponse response){

//task_id是调用方和服务端通信的唯一标识,当遇到问题时需要提供task_id以便排查。

System.out.println(

"task_id: " + response.getTaskId() +

//状态码 20000000 表示识别成功

", status: " + response.getStatus() +

//错误信息

", status_text: " + response.getStatusText());

}

};

} catch (Exception e) {

e.printStackTrace();

}

return listener;

}

public void process() {

SpeechSynthesizer synthesizer = null;

try {

//创建实例,建立连接。

synthesizer = new SpeechSynthesizer(client, getSynthesizerListener());

synthesizer.setAppKey(appKey);

//设置返回音频的编码格式

synthesizer.setFormat(OutputFormatEnum.WAV);

//设置返回音频的采样率

synthesizer.setSampleRate(SampleRateEnum.SAMPLE_RATE_16K);

//发音人

synthesizer.setVoice("siyue");

//语调,范围是-500~500,可选,默认是0。

synthesizer.setPitchRate(100);

//语速,范围是-500~500,默认是0。

synthesizer.setSpeechRate(100);

//设置用于语音合成的文本

synthesizer.setText("欢迎使用阿里巴巴智能语音合成服务,您可以说北京明天天气怎么样啊");

// 是否开启字幕功能(返回相应文本的时间戳),默认不开启,需要注意并非所有发音人都支持该参数。

synthesizer.addCustomedParam("enable_subtitle", false);

//此方法将以上参数设置序列化为JSON格式发送给服务端,并等待服务端确认。

long start = System.currentTimeMillis();

synthesizer.start();

logger.info("tts start latency " + (System.currentTimeMillis() - start) + " ms");

SpeechSynthesizerDemo.startTime = System.currentTimeMillis();

//等待语音合成结束

synthesizer.waitForComplete();

logger.info("tts stop latency " + (System.currentTimeMillis() - start) + " ms");

} catch (Exception e) {

e.printStackTrace();

} finally {

//关闭连接

if (null != synthesizer) {

synthesizer.close();

}

}

}

public void shutdown() {

client.shutdown();

}

public static void main(String[] args) throws Exception {

String appKey = System.getenv().get("NLS_APP_KEY");

String id = System.getenv().get("ALIYUN_AK_ID");

String secret = System.getenv().get("ALIYUN_AK_SECRET");

String url = System.getenv().getOrDefault("NLS_GATEWAY_URL", "wss://nls-gateway-cn-shanghai.aliyuncs.com/ws/v1");

SpeechSynthesizerDemo demo = new SpeechSynthesizerDemo(appKey, id, secret, url);

demo.process();

demo.shutdown();

}

}