本文旨在帮助您的团队通过一套可观测、可量化的评估体系,科学地衡量引入通义灵码后,对研发效率、代码质量和开发者体验带来的具体影响。

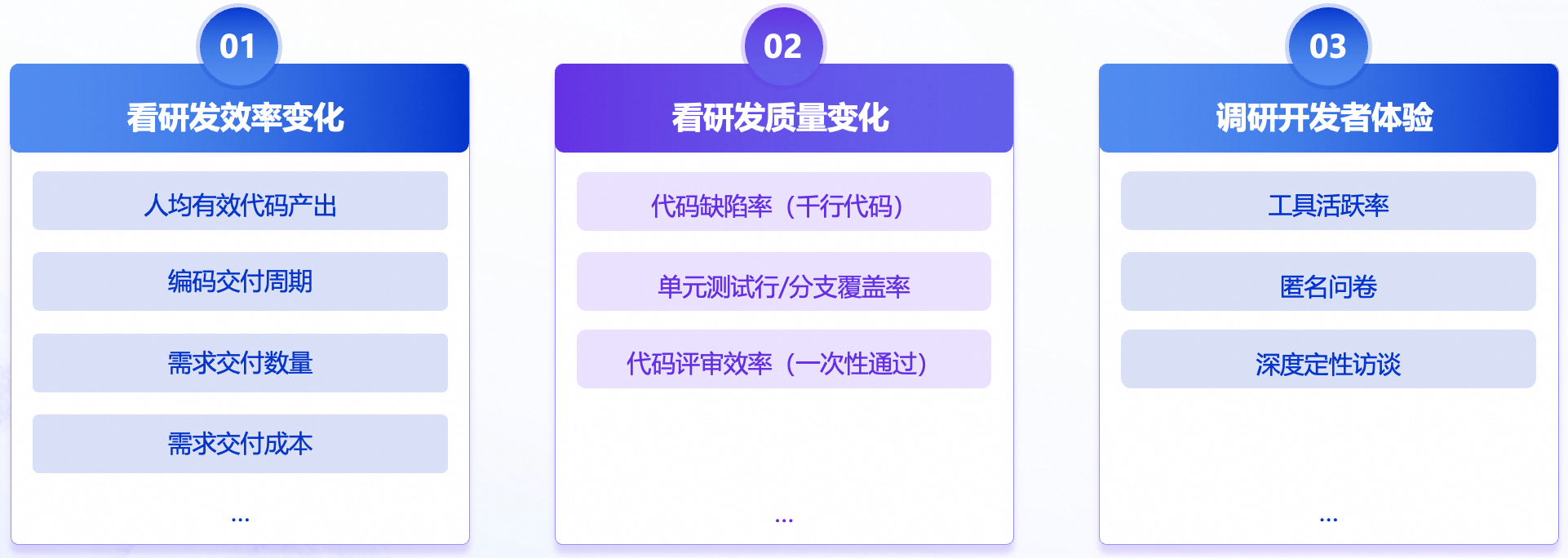

我们将遵循一个核心框架,从三个维度出发,全面、客观地评估 AI 编码工具的真实价值。

一、核心评估原则

在开始具体评估前,建议遵循以下三个核心原则,它们是确保评估结果客观、有效的基石。

原则一:告别单一指标,拥抱多维视角

建议结合研发效率、代码质量、开发者体验等多维度数据,单一指标极易造成片面理解和数据误导,从而忽视了AI工具的真实价值和潜在问题。综合考量才能绘制出AI工具对研发效能影响的全貌。

原则二:建立基线指标,动态衡量变化

在引入AI编码工具之前,建议采集并记录当前团队的各项关键指标数据(如编码交付周期、人均产出、缺陷率等)。这个“before”状态就是你的基线 (Baseline)。所有后续的评估都将与这个基线进行对比,从而科学地量化AI工具带来的变化。

原则三:以人为本,赋能开发者

关注人的因素是工具成功落地的关键,通过鼓励开发者积极深入使用工具,并提供最真实、最有价值的反馈,助力工具的优化和企业最佳实践的沉淀。

二、评估方法:三维量化评估模型

我们将从以下三个维度展开具体评估:

维度一:研发效率变化

衡量工具是否让团队“写得更多,交付更快”。

衡量指标 | 计算方法 | 解读与洞察 |

人均有效代码产出 | 人均非注释、非空白代码行数,与应用前同期对比。 | 核心指标,用于观察代码量的宏观变化趋势,但必须结合质量指标一起解读。 |

编码交付周期 | 从任务状态变为“开发中”到“待测试”的平均时长,与应用前同期对比。 | 辅助指标,衡量纯编码阶段的效率提升,排除需求评审和测试等环节干扰。 |

需求交付数量 | 周期内完成的需求总数,与应用前同期对比。 | 辅助指标,用于观察团队是否交付了更多的功能单元。 |

需求交付成本 | 周期内的总研发成本 / 周期内完成的需求总数,与应用前同期对比。 | 辅助指标,将技术产出与财务成本直接挂钩,可衡量投资回报率(ROI)。 |

维度二:研发质量变化

衡量工具生成的代码是否“质量更高,维护更容易”。

衡量指标 | 计算方法 | 解读与洞察 |

代码缺陷密度 | (周期内线上新增Bug数 / 同期新增或变更的千行代码数),与应用前同期对比。其中分母应为周期内实际产生变更的代码量,而非整个代码库的存量。 | 核心指标,千行代码缺陷率” (Defects per KLOC) 是一个全球公认的、用于衡量代码内在质量的黄金标准。 |

代码测试覆盖率与质量 | 1. 单元测试行/分支覆盖率的变化; 2. 抽样评估AI生成的测试用例的有效性。 | 辅助指标,通过Code Review抽查,评估其是否为有效测试,防止为追求覆盖率而生成大量无意义的测试。 |

代码评审效率 | 平均每个合并请求(MR/PR)的评论数、评审时长、一次性通过率,与应用前同期对比。 | 辅助指标,衡量AI生成的代码是否更易于理解和维护。 |

维度三:开发者体验

衡量工具是否“受欢迎,真好用”。

衡量指标 | 计算方法 | 解读与洞察 |

工具活跃率 | 日均活跃使用工具的开发者数/团队总开发者数。 | 核心指标,衡量工具的受欢迎程度和推广效果。 |

开发者满意度问卷 | 匿名问卷调查,问题示例:

| 系统性地收集开发者在效率、质量、心智负担等方面的主观感受。 |

深度定性访谈 | 选取不同经验水平的开发者进行1对1访谈,访谈提纲:

| 挖掘数据背后的故事和深层原因,收集具体的成功案例和失败案例,为工具的优化和内部最佳实践沉淀提供一手资料,把好的实践开发经验内部进行赋能推广。 |

三、实践案例

背景:哈啰成功将通义灵码融入研发流程,通过渐进式推广,实现了效率、质量和开发者体验的多重提升。

核心结论:其实践结果证明了AI应用规模与代码产量呈正相关,且在效率提升的同时,代码缺陷率逐步下降。赋能企业开发者,具备跨技术栈能力,促进了代码理解与文档完备度,提升了内部协作效率。

关键成果数据化:

效率提升

42% 代码产出效率同比增长

58% 需求交付效率同比增长

质量提升

0.54% 代码缺陷率,优于去年同期的 0.62%

综合能力提升

代码质量:命名更规范,低级失误减少。

文档完备度:AI 辅助让开发者更愿意写注释和文档。

员工能力:初级工程师能更快上手,跨技术栈开发门槛降低。

总结

科学地评估通义灵码的价值,需要您:

确立多维度、有基线的评估原则。

运用“效率-质量-体验”三维模型,以数据驱动管理运营。

将数据与开发者真实反馈相结合,建立正向激励,提升团队整体AI Coding实践水平。

希望这份指南能帮助您的团队更好地拥抱 AI,释放更大的研发潜能。