本文介绍如何使用阿里云GPU云服务器,基于ChatGLM-6B语言模型快速搭建AI对话机器人。

背景信息

ChatGLM是一个开源的预训练语言模型,由清华大学和智谱AI联合开发。它采用了GLM(General Language Model)架构,这是一种基于Transformer的语言模型架构,是一个支持中英双语问答的对话语言模型,专门针对中文进行了优化。

而ChatGLM-6B是ChatGLM系列中的一个版本,具有60亿参数。它使用了和ChatGPT相似的技术,经过约1 TB标识符的中英双语训练,辅以监督微调、反馈自助、人类反馈强化学习等技术的加持,能够生成符合人类偏好的回答。

阿里云不对第三方模型“ChatGLM-6B”的合法性、安全性、准确性进行任何保证,阿里云不对由此引发的任何损害承担责任。

您应自觉遵守第三方模型的用户协议、使用规范和相关法律法规,并就使用第三方模型的合法性、合规性自行承担相关责任。

操作步骤

您可以通过一键部署 快速完成以下操作。

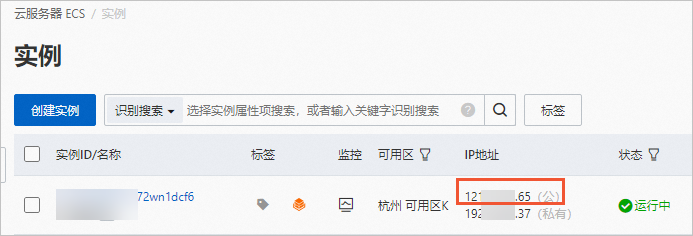

步骤一:创建ECS实例

步骤二:下载ChatGLM-6B模型

使用root用户远程连接ECS实例。

该市场镜像中,运行环境及模型都安装在

/root目录下,连接实例时需使用root用户。具体操作,请参见使用Workbench工具以SSH协议登录Linux实例。为了确保长时间运行的命令不会因会话中断而终止,可以使用

screen工具来保持会话在后台运行。安装

screen。如果您还没有安装

screen,可以通过以下命令进行安装。sudo apt-get update sudo apt-get install screen启动一个新的

screen会话。screen -S chatglm-session这将启动一个新的名为

chatglm-session的screen会话。

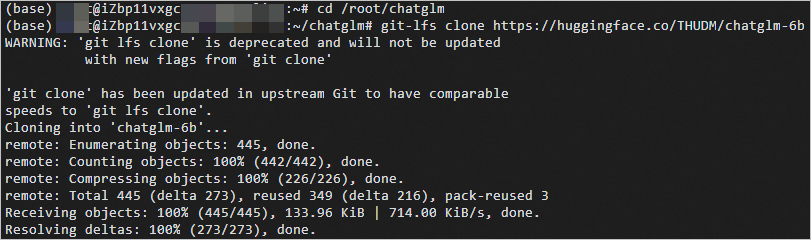

在

screen会话中,执行如下命令,下载ChatGLM-6B模型。cd /root/chatglm git clone https://www.modelscope.cn/ZhipuAI/ChatGLM-6B.git chatglm-6b git -C chatglm-6b checkout v1.0.16 sed -i '33c from .configuration_chatglm import ChatGLMConfig' chatglm-6b/modeling_chatglm.py您可以通过按下

Ctrl+A然后按D键来分离当前会话,这样即使关闭终端,任务也会继续在后台运行。如果您想查看任务的状态或继续工作,可以使用以下命令重新连接到

screen会话。screen -r chatglm-session模型下载大约需要35分钟,回显信息如下图所示时,表示模型已下载完成。

步骤三:启动对话服务

启动服务。

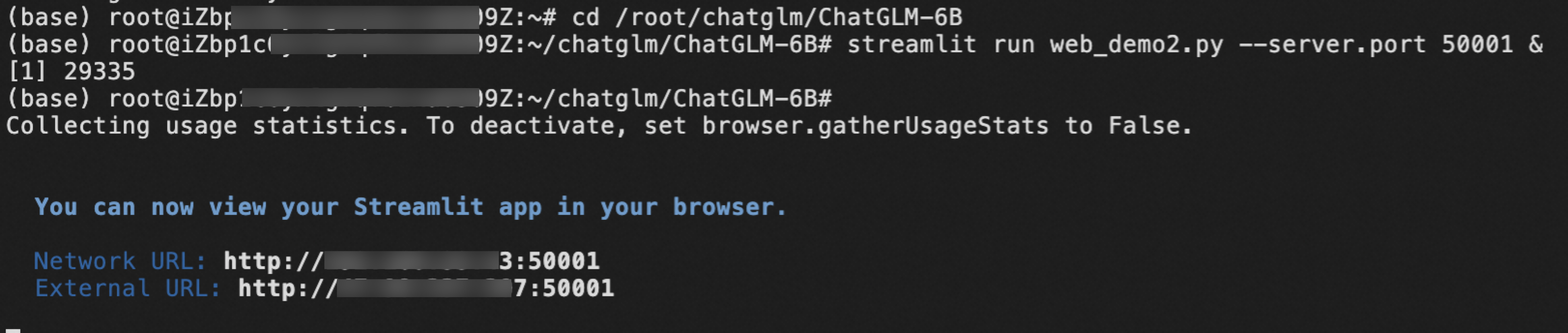

执行如下命令,开启WebUI服务。

cd /root/chatglm/ChatGLM-6B export STREAMLIT_SERVER_HEADLESS=1 streamlit run web_demo2.py --server.port 50001 &当出现如下回显的时候,表示启动成功。

访问对话页面。

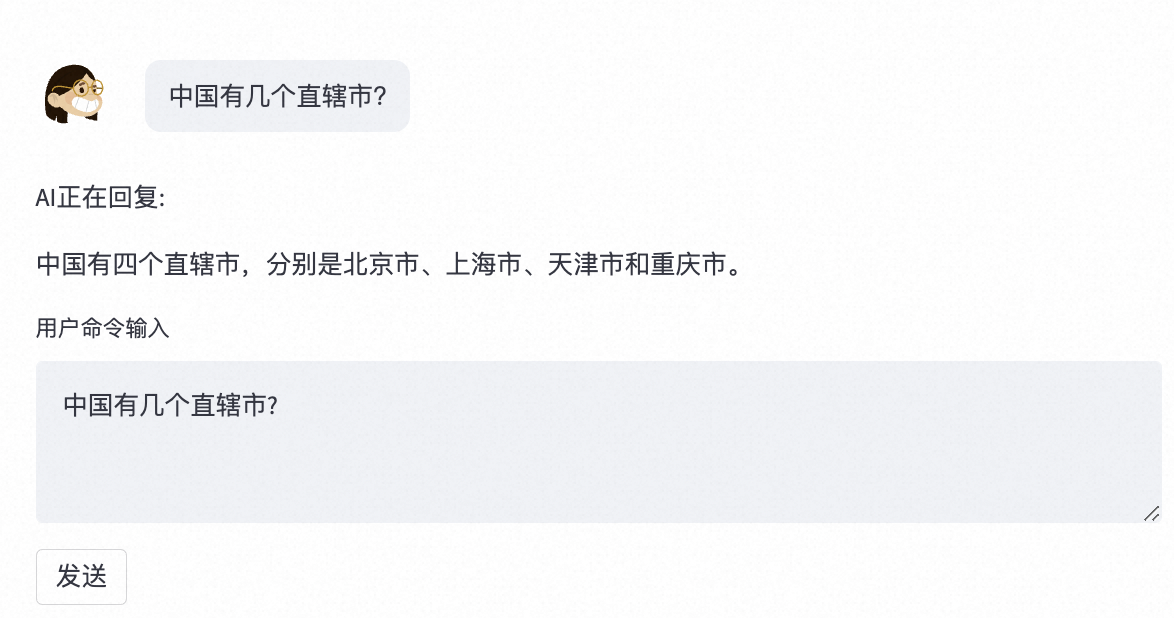

打开浏览器,输入

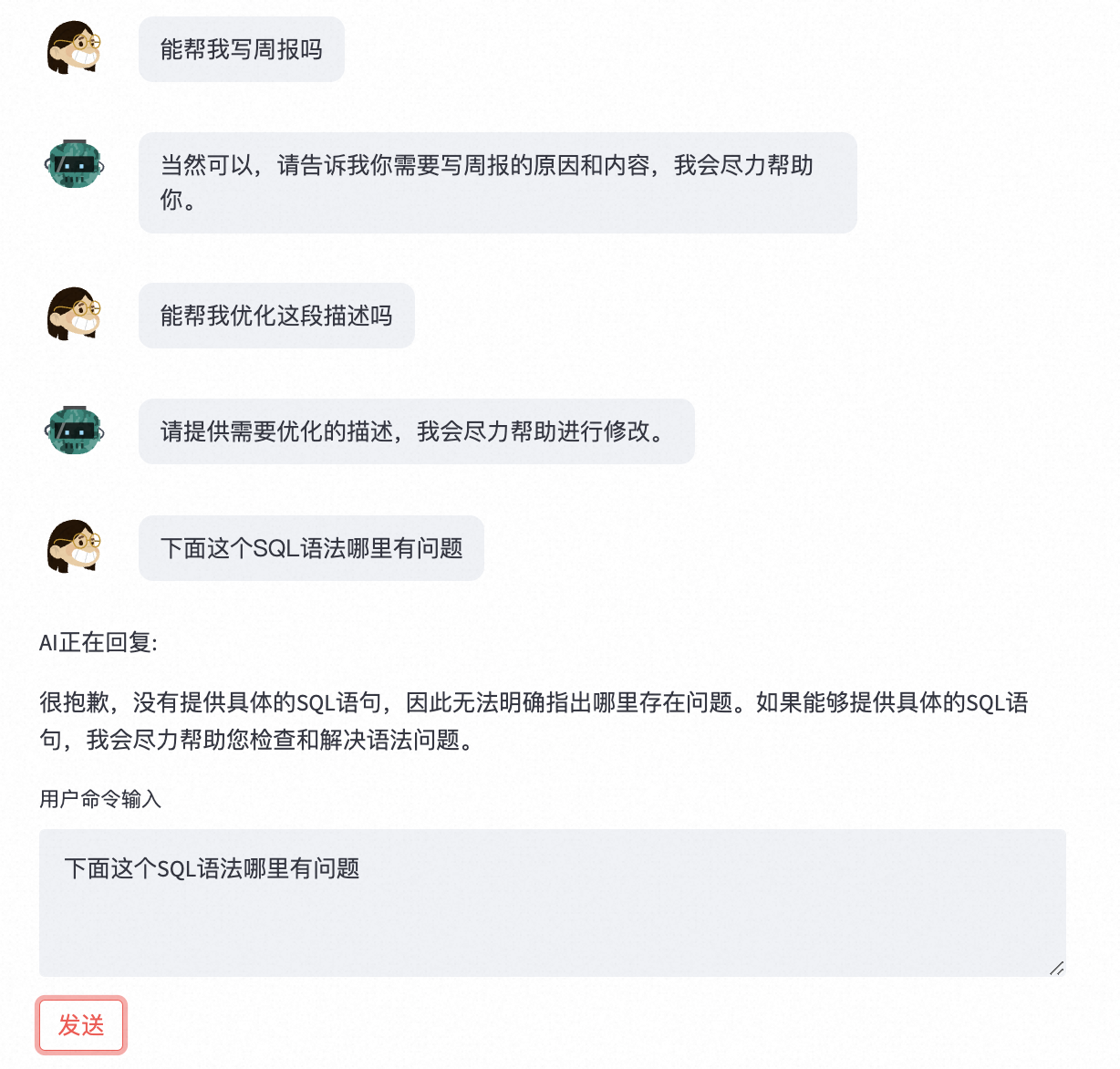

http://<ECS公网IP地址>:50001,进入对话Web页面。开始聊天。

在用户命令输入对话框中,输入对话内容,单击发送,即可开始AI对话。

了解更多AIGC实践和GPU优惠

活动入口:立即开启AIGC之旅