本文将详细介绍如何在控制台进行模型调优任务,并帮助您选择正确的调优方式与参数。模型调优包含模型微调(SFT)、继续预训练(CPT)、模型偏好训练(DPO)三种模型训练方式。

本文档仅适用于中国大陆版(北京地域)。

模型调优流程

步骤一:选择调优方式

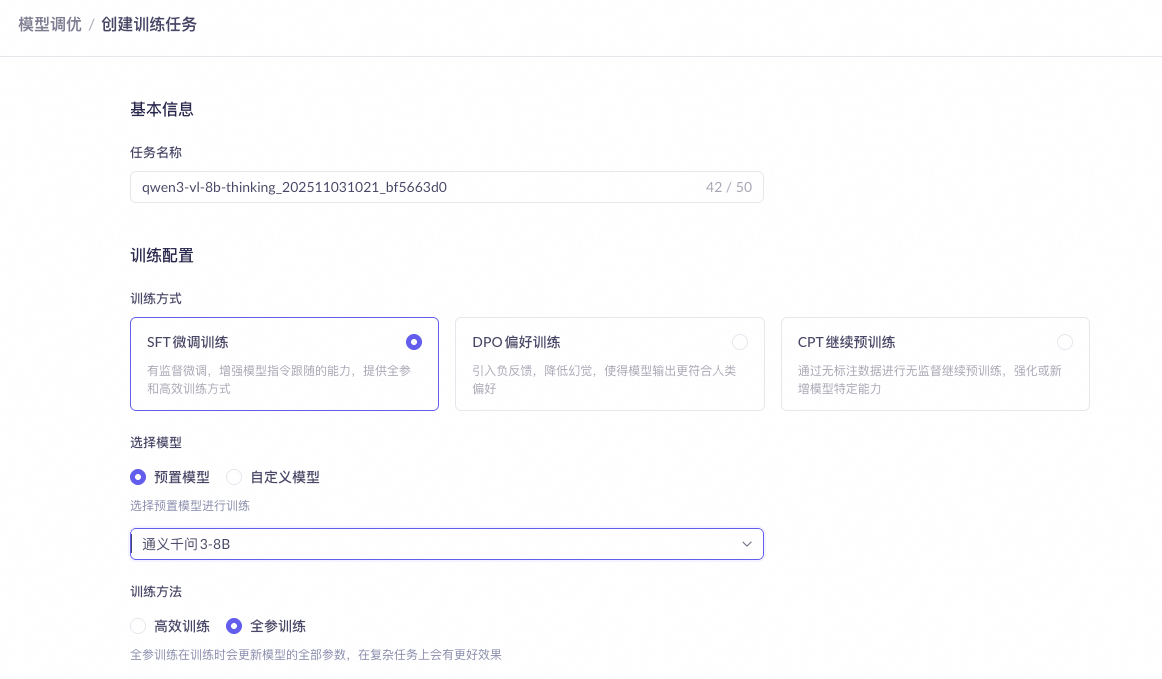

前往模型调优页面,点击“创建训练任务”按钮。

CPT、SFT 与 DPO 如何选择

CPT(继续预训练,Continual Pre-Training)目的是通过海量的无标记训练数据,提升模型在特定行业的表现。

SFT-有监督-模型微调(Supervised Fine-Tuning)目的是通过针对性的数据集和训练,提升模型在特定业务的表现。

DPO-有监督-直接偏好优化(Direct Preference Optimization)训练数据集数据同时提供正负样本,通过引入负反馈,降低幻觉,对bad case进行针对性优化。

百炼提供的三种调优方式并不互斥,而是递进的、相辅相成的。

CPT(可选)→ SFT → DPO(可选)

CPT (持续预训练)- 补知识 (通用模型知识的“广度”和“浅度”,无法满足专业领域的“深度”和“精度”要求)

金融模型:

学金融术语医疗模型:

记药品病理法律模型:

懂法条判例

SFT (监督微调)- 学做事

客服机器人:

学客服流程代码助手:

学编程范式工具调用 (Agent):

学使用 MCP

DPO (直接偏好优化)- 做得更好

安全与责任感:

拒有害建议简洁与有效性:

答干脆利落客观与中立:

评公正客观

SFT 训练集

SFT ChatML(Chat Markup Language)格式训练数据,支持多轮对话和多种角色设置,一行训练数据展开后结构如下:

不支持OpenAI 的name、weight参数,所有的 assistant 输出都会被训练。

{"messages": [

{"role": "system", "content": "系统输入1"},

{"role": "user", "content": "用户输入1"},

{"role": "assistant", "content": "期望的模型输出1"},

{"role": "user", "content": "用户输入2"},

{"role": "assistant", "content": "期望的模型输出2"}

...

]}system/user/assistant 区别请参见文本生成模型概述,训练数据集样例:SFT-ChatML格式示例.jsonl、SFT-ChatML格式示例.xlsx(xls、xlsx 格式只支持单轮对话)。

针对深度思考的内容,需要使用<think>标签包裹,训练数据集样例:SFT- 深度思考内容示例.jsonl。

思考标签前后的若干个\n必须要保留。{"role": "assistant", "content": "<think>\n期望的模型思考内容\n</think>\n\n期望的模型输出"} --正常输入深度思考内容

{"role": "assistant", "content": "<think>\n\n</think>\n\n期望的模型输出"} --设置空的深度思考内容,用于告诉模型不要思考SFT 图像理解(千问VL)训练集

SFT图像理解 ChatML 格式训练数据,一行训练数据展开后结构如下:

不支持OpenAI 的name、weight参数,所有的 assistant 输出都会被训练。

system/user/assistant 区别请参见文本生成模型概述。训练数据集样例:。

{"messages":[

{"role":"user",

"content":[

{"text":"用户输入1"},

{"image":"图像文件名1"}]},

{"role":"assistant",

"content":[

{"text":"模型期望输出1"}]},

{"role":"user",

"content":[

{"text":"用户输入2"}]},

{"role":"assistant",

"content":[

{"text":"模型期望输出2"}]},

...

...

...

]}针对深度思考的内容,需要使用<think>标签包裹:

{"role": "assistant", "content": "<think>期望的模型思考内容</think>期望的模型输出"}压缩包要求:

压缩包格式:ZIP。最大支持 2 GB, ZIP 包内文件夹、文件名仅支持 ASCII 字符集中的字母 (a-z, A-Z)、数字 (0-9)、下划线 (_)、连字符 (-)。

训练文本数据固定为 data.jsonl,并且位于压缩包的根目录下,应确保压缩后打开 zip 文件,直接就能看到

data.jsonl文件。图片单张尺寸的宽度和高度均不得超过 1024px,最大不超过10MB,支持

.bmp,.jpeg /.jpg,.png,.tif /.tiff,.webp格式。图片文件的名称不能重复,即使分布在不同的文件夹中。

压缩包目录结构:

单层目录(推荐)

图片文件与

data.jsonl文件均位于压缩包根目录下。Trainingdata_vl.zip |--- data.jsonl #注意:外层不能再包裹文件夹 |--- image1.png |--- image2.jpg多层目录

data.jsonl 必须在压缩包根目录下。

data.jsonl 内只需要声明图像文件名,不需要声明文件路径。例如:

正确示例:

image1.jpg;错误示例:jpg_folder/image1.jpg。图像文件名应在压缩包内全局唯一。

Trainingdata_vl.zip |--- data.jsonl #注意:外层不能再包裹文件夹 |--- jpg_folder | └── image1.jpg |--- png_folder └── image2.png

DPO 数据集

DPO ChatML 格式训练数据,一行训练数据展开后结构如下:

system/user/assistant 区别请参见文本生成模型概述,训练数据集样例:DPO ChatML格式样例.jsonl。

{"messages":[

{"role":"system","content":"系统输入"},

{"role":"user","content":"用户输入1"},

{"role":"assistant","content":"模型输出1"},

{"role":"user","content":"用户输入2"},

{"role":"assistant","content":"模型输出2"},

{"role":"user","content":"用户输入3"}

],

"chosen":

{"role":"assistant","content":"赞同的模型期望输出3"},

"rejected":

{"role":"assistant","content":"反对的模型期望输出3"}}模型将 messages 内的所有内容均作为输入,DPO 用于训练模型对用户输入3的正负反馈。

针对深度思考的内容,需要使用<think>标签包裹:

{"role": "assistant", "content": "<think>期望的模型思考内容</think>期望的模型输出"}CPT 训练集

CPT 纯文本格式训练数据,一行训练数据展开后结构如下:

{"text":"文本内容"}训练数据集样例:CPT-文本生成训练集示例.jsonl

两种训练方式的数据量要求请参见数据集的规模要求。

阿里云百炼推荐您以先 CPT(可选),后 SFT,最后 DPO 的顺序使用模型调优:

先收集海量(至少1000万Token)的特定领域的无标签样本,进行CPT训练,将模型训练成特定行业/领域的专家。

在应用上线前,使用足够多(1000+)的特定场景/业务的正样本,即收集场景/业务输入+模型期望输出,进行SFT 训练。

您的应用试运行/上线后,收集足够多(100+)的用户反馈(如:点赞、点踩、反馈)或者 bad case,将这些数据制作成 DPO 训练集,进行 DPO 训练。

模型选择

如果您是第一次进行模型调优,请选择您期望的预置模型。

如果您是因为模型训练效果不好需要再次训练某个模型,请选择自定义模型 > 您需要二次训练的模型。

支持的预置模型:

模型名称 | 模型代码 | CPT全参训练 (cpt) | SFT全参训练 (sft) | SFT高效训练 (efficient_sft) | DPO全参训练 (dpo_full) | DPO高效训练 (dpo_lora) |

通义千问3-32B | qwen3-32b |

|

|

|

| |

通义千问3-14B | qwen3-14b |

|

|

|

| |

通义千问3-8B | qwen3-8b |

|

|

|

| |

通义千问3-VL-8B-Instruct | qwen3-vl-8b-instruct |

|

| |||

通义千问3-VL-8B-Thinking | qwen3-vl-8b-thinking |

|

| |||

通义千问3-32B-Base | qwen3-32b-base |

|

| |||

通义千问3-14B-Base | qwen3-14b-base |

|

| |||

通义千问3-8B-Base | qwen3-8b-base |

|

| |||

通义千问2.5-72B | qwen2.5-72b-instruct |

|

|

|

|

|

通义千问2.5-32B | qwen2.5-32b-instruct |

|

|

|

| |

通义千问2.5-14B | qwen2.5-14b-instruct |

|

|

|

|

|

通义千问2.5-7B | qwen2.5-7b-instruct |

|

|

|

|

|

通义千问2.5-VL-72B | qwen2.5-vl-72b-instruct |

|

|

|

| |

通义千问2.5-VL-32B | qwen2.5-vl-32b-instruct |

|

| |||

通义千问2.5-VL-7B | qwen2.5-vl-7b-instruct |

|

| |||

通义千问2-开源版-72B | qwen2-72b-instruct |

|

| |||

通义千问2-开源版-7B | qwen2-7b-instruct |

|

|

|

| |

通义千问1.5-开源版-72B | qwen1.5-72b-chat |

| ||||

通义千问1.5-开源版-14B | qwen1.5-14b-chat |

|

| |||

通义千问1.5-开源版-7B | qwen1.5-7b-chat |

|

| |||

通义千问-Turbo-0624(通义商业版) | qwen-turbo-0624 |

|

|

|

| |

通义千问-Plus-0723(通义商业版) | qwen-plus-0723 |

|

| |||

通义千问VL-Max-0201 | qwen-vl-max-0201 |

| ||||

通义千问VL-Plus | qwen-vl-plus |

| ||||

百川2-7B(开源)下线中 | baichuan2-7b-chat-v1 |

| ||||

Llama2-13B下线中 | llama2-13b-chat-v2 |

| ||||

Llama2-7B下线中 | llama2-7b-chat-v2 |

| ||||

ChatGLM2-6B下线中 | chatglm-6b-v2 |

|

全参训练与高效训练

全参训练通过全量更新模型参数的方式进行学习。

高效训练采用低秩适应(Low-Rank Adaptation,LoRA)的方式,通过矩阵分解的方法,更新分解后的低秩部分参数。

由于两种训练方式的费用相同,阿里云百炼推荐您如果模型支持全参训练,请优先选择全参训练,因为全参训练效果比高效训练效果要好,性价比更高。

步骤二:参数配置

训练参数介绍:

并不是所有模型都支持所有参数的调节,请以控制台显示为准

参数名称 | 推荐设置 | 超参作用 | |

批次大小 (batch_size) | 使用默认值 | 批次大小,代表模型训练过程中,模型更新模型参数的数据步长,可理解为模型每看多少数据即更新一次模型参数,一般建议的批次大小为16/32,表示模型每看16或32条数据即更新一次参数 |

|

学习率 (learning_rate) | 高效训练:1e-4量级 全参训练:1e-5量级 CPT训练:1e-5量级 | 控制模型修正权重的强度。 如果学习率设置得太高,模型参数会剧烈变化,导致调优后的模型表现不一定更好,甚至变差; 如果学习率太低,调优后的模型表现不会有太大变化。 | |

循环次数 (n_epochs) | 数据量 < 10,000, 循环 3~5次 数据量 > 10,000, 循环 1~2次 具体需要结合实验效果进行判断 | 模型遍历训练的次数,请根据模型调优实际使用经验进行调整。 模型训练循环次数越多,训练时间越长,训练费用越高。 | |

验证步数 (eval_steps) | 使用默认值 | 训练阶段针对模型的验证间隔步长,用于阶段性评估模型训练准确率、训练损失。 该参数影响模型调优进行时的 Validation Loss 和 Validation Token Accuracy 的显示频率。 | |

学习率调整策略 (lv_scheduler_type) | 推荐选择“linear”或“Inverse_sqrt”。 | 在模型训练中动态调整学习率的策略。 各策略详情请参考学习率调整策略介绍。 | |

序列长度 (max_length) | 设置为模型支持的最大值 | 指的是单条训练数据 token 支持的最大长度。如果单条数据 token 长度超过设定值: SFT 会直接丢弃该条数据,不进行训练; DPO 则会自动截断超出配置长度的后续 token,截短后的数据仍会被训练。 字符与 token 之间的关系请参考 Token和字符串之间怎么换算 | |

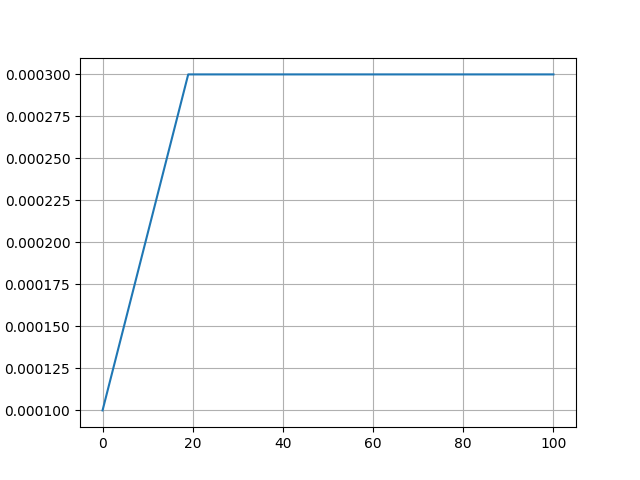

学习率预热比例 (warmup_ratio) | 使用默认值 | 学习率预热占用总的训练过程的比例。学习率预热是指学习率在训练开始后由一个较小值线性递增至学习率设定值。 该参数主要是限制模型参数在训练初始阶段的变化幅度,从而帮助模型更稳定地进行训练。 比例过大效果与过低的学习率相同,会导致调优后的模型表现不会有太大变化。 比例过小效果与过高的学习率相同,可能导致调优后的模型表现不一定更好,甚至变差。

| |

权重衰减 (weight_decay) | 使用默认值 | L2正则化强度。L2正则化能在一定程度上保持模型的通用能力。数值过大会导致模型调优效果不明显。 | |

LoRA阿尔法 (lora_alpha) | 使用默认值 | 用于控制原模型权重与LoRA的低秩修正项之间的结合缩放系数。 较大的Alpha值会给予LoRA修正项更多权重,使得模型更加依赖于调优任务的特定信息; 而较小的Alpha值则会让模型更倾向于保留原始预训练模型的知识。 | |

LoRA丢弃率 (lora_dropout) | 使用默认值 | LoRA训练中的低秩矩阵值的丢弃率。 使用推荐数值能增强模型通用化能力。 数值过大会导致模型调优效果不明显。 | |

LoRA秩值 (lora_rank) | 设置为模型支持的最大值 | LoRA训练中的低秩矩阵的秩大小。秩越大调优效果会更好一点,但训练会略慢。 |

学习率调整策略介绍

“学习率调整策略” 是在 超参配置 > 更多配置 下的第一个配置,配置包含8种不同的策略。

策略详情请参见:

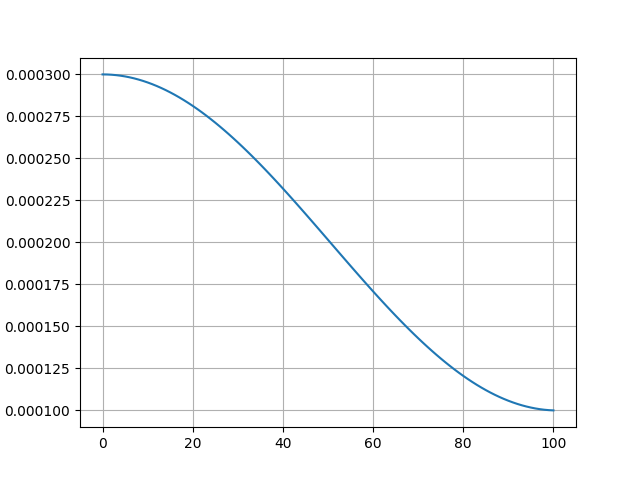

Linear:学习率线性递减。 使用场景:适合训练过程较短的任务。

| Polynomial:学习率按照一个预定义的多项式函数随训练迭代次数或周期数逐渐减少。 使用场景:Polynomial 可以更精细地控制学习率减少速度,适用于任务比较复杂的场景。 但内置多项式系数为1,效果同 Linear,不推荐使用。

|

Cosine:学习率变化符合余弦函数曲线。 使用场景:适合需要进行精细调整、训练过程较长的任务。 | Cosine_with_restarts:学习率按照余弦函数的形状周期性地减少至某个最小值,而且在每个周期结束时,学习率会“重启”成预设值,然后开启下一周期。 使用场景:适用于需要模型从局部最优解中跳出来,尝试寻找更好全局解的情况。 但经过实测,学习率并不会在函数曲线底部“重启”成预设值,不推荐使用。 |

Constant:学习率不变, “学习率预热比例”参数无效。 使用场景:适合初步探索模型性能。 | Constant_with_warmup:学习率不变,但“学习率预热比例”参数有效。 使用场景:适合初步探索模型性能。 |

Inverse_sqrt:学习率逐渐减小,减小量与迭代次数的平方根的倒数正相关。 使用场景:适合于 SFT 微调,能较好地平衡学习效率与模型收敛。

| reduce_lr_on_plateau:当监控的指标(验证损失或验证准确率)在连续多个epoch内没有显著改进时,自动降低学习率。 使用场景:当模型很难进一步提高性能时,reduce_lr_on_plateau 可以帮助模型继续优化和提升。

|

图中学习率下限梯度、最小值均为示意,实际学习率下限梯度、最小值以实际使用为准。

步骤三:选择训练数据

步骤四:配置模型导出

仅 SFT 微调训练支持设置该功能设置

在百炼平台上,模型调优完成后可以导出参数快照,导出后才能基于此版本的参数快照在百炼上进行模型部署。

导出的参数快照保存在云存储中,暂不支持访问或下载。

在模型导出的配置项下,可以设置:

Checkpoint 保存间隔:设置每隔多少轮(epoch)或多少步(step)保存一个模型参数快照。

快照保留数量上限(导出数量上限):设置最多保留的快照文件数量。

步骤五:训练模型

点击“开始训练” > 确认“模型调优计费提醒” > 模型开始训练。

如遇权限不足,请参考:模型调优时报权限不足怎么办?

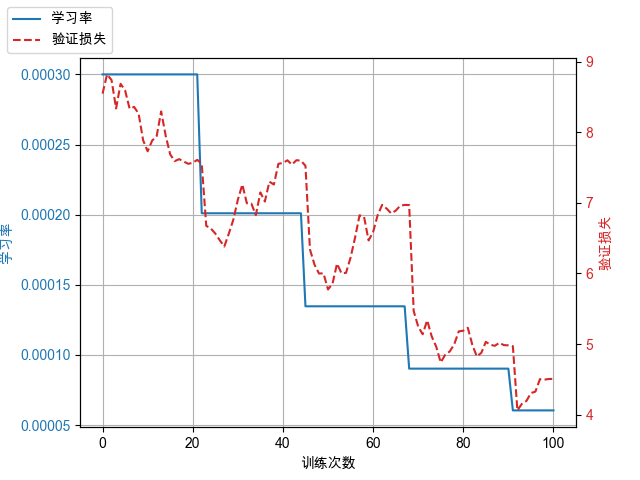

模型训练时点击“查看日志”按钮可以查询模型训练过程中实时产生的日志,也可以前往效果评估标签页查看训练损失(Training Loss)、验证损失(Validation Loss)、验证准确率(Validation Token Accuracy)。

训练完成后,请确认训练损失(Training Loss)与验证损失(Validation Loss)的差异变化趋势, 并选择。

如果训练损失逐渐减小而验证损失逐渐增大,说明模型已经过拟合训练数据,训练可能失败,训练效果可能不佳。建议按照以下推荐方法(推荐程度有先后顺序)进行优化,重新训练,提升训练效果:

使用数据增强,增加训练数据多样性和数据量。

收集更多训练数据,增加训练数据多样性和数据量。

调整超参,包括:减少“训练次数”、减小“学习率”、减小“批次大小”、增大“权重衰减”、提高“LoRA丢弃率”、提高“学习率预热比例”。

如果训练损失没有明显变化或逐渐增大(不常见),说明模型欠拟合训练数据,训练失败。建议按照以下推荐方法(推荐程度有先后顺序)进行优化,继续训练:

检查数据质量,确保数据清洗充分。

调整超参,包括:增大“训练次数”、增大“学习率”、增大“批次大小”、减小“权重衰减”、降低“LoRA丢弃率”、降低“学习率预热比例”。

如果没有上述情况请继续后续步骤。

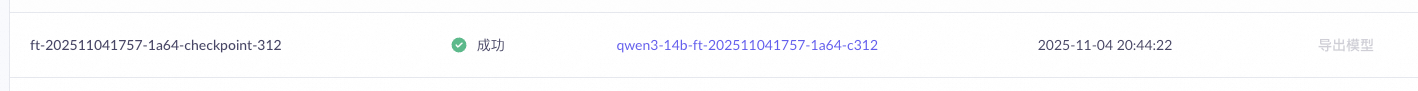

步骤六:导出模型用于部署

仅 SFT微调训练支持选择导出训练中间状态的模型快照

模型训练结束以后,点击导出模型,进入模型产出的标签页。

在列表中,包含根据步骤四:配置模型导出的配置所保存的若干模型参数快照。

根据验证集上的评估指标,选择不同阶段的模型参数快照进行导出。

导出完成后的模型名称可以在模型部署界面搜索到:

步骤七:部署模型

使用阿里云百炼的模型部署功能部署训练好的自定义模型,部署好后就可以对调优好的模型进行评测。模型部署相关信息请参见帮助中心:模型部署。

步骤八:评测模型

如果您有多个业务场景或者添加了混合训练数据,在模型评测时,建议您根据场景拆分评测集,分别评测各个场景在调优后的表现是否满足您的需求。

使用阿里云百炼模型评测功能评估自定义模型的训练效果,相关信息请参见帮助中心:模型评测简介。

评测方式

阿里云百炼支持以下三种评测方式:人工评测、自动评测和基线评测。

人工评测:由您本人或您邀请的业务专家参与,基于选定的评测维度和评测集,对待测模型的输出效果进行人工评价。这种方式的优势在于业务专家能够通过实际操作产品等方式,来验证输出内容中的每个细节及步骤的正确性。但局限性也很明显,即评测成本较高、效率低,并且多人评测时可能会受到主观因素的干扰。

自动评测:全过程无需人工参与,阿里云百炼将基于内置的深度学习指标(包括BLEU、ROUGE和F1)和AI评测器,自动对模型的输出效果进行评分。这种方式的优势在于高效率以及评测的公正性。局限性在于AI评测器的评测效果高度依赖于人为初始设定的评分维度、步骤和标准,并且它无法像人工评测那样验证输出内容中每个细节和步骤的正确性。

基线评测:基于预置基线评测集(包括C-Eval/CMMLU等主流榜单评测集)对待测模型的各项基础通用能力进行自动评测,适用于对已调优模型的基本效果进行回归评测(虽然调优有可能提升模型在特定任务上的效果,但有时也会降低模型的通用能力),避免模型通用能力的下降和丢失。

通常最佳实践是将上述三种评测方式结合起来。一个可能的场景是:先通过初始的人工评测确定一套评测维度,并形成配套可自动化执行的评分步骤和标准。再将这一整套评分体系应用于自动评测中,让阿里云百炼按照设定进行自动评测,快速从多个候选模型中选出最优者。最后通过人工评测仔细对比模型输出在结构组织、伦理合规等方面的细微差异。如果针对特定领域进行了模型调优,同时希望确保模型的通用能力没有明显下降,则可以进行基线评测。

常见问题

什么时候可以使用模型调优功能?

如果您并不是需要对文本生成模型进行调优,请直接前往Paraformer语音识别热词定制与管理页面。

文本生成模型调优虽然能在特定业务/场景取得非常好的效果,但有以下限制:

耗时较长,包括:拥有一个大规模(最少 0.5亿 token)CPT 数据集、构建一个有效(1000+)SFT 数据集、收集足够的(100+)Bad Case 构建有效 DPO 数据集、模型优化迭代速度慢等。

费用较高,调优后的模型部署后才能使用,部署费用较高。

阿里云百炼推荐您在考虑使用文本生成模型调优前先尝试使用的 Prompt 工程(Prompt Engineering)或插件调用(Function Calling)定制化您的应用,模型调优也通常作为改进模型表现“最后的手段”。因为:

在许多任务中,模型最初可能表现不佳,但通过应用正确的 Prompt 技巧可以改进结果,不一定需要使用模型调优。

迭代优化 Prompt、插件,比模型调优的迭代更敏捷、成本更低,因为模型调优的迭代可能需要重新收集数据、清洗优化数据、收集 bad case、发起客户调研等。

即使最后一定要进行模型调优,最初的 Prompt 工程、插件迭代优化相关工作也不会浪费。您的这些前期工作可以充分地在构建调优数据集时复用(用于构建数据集的输入)。

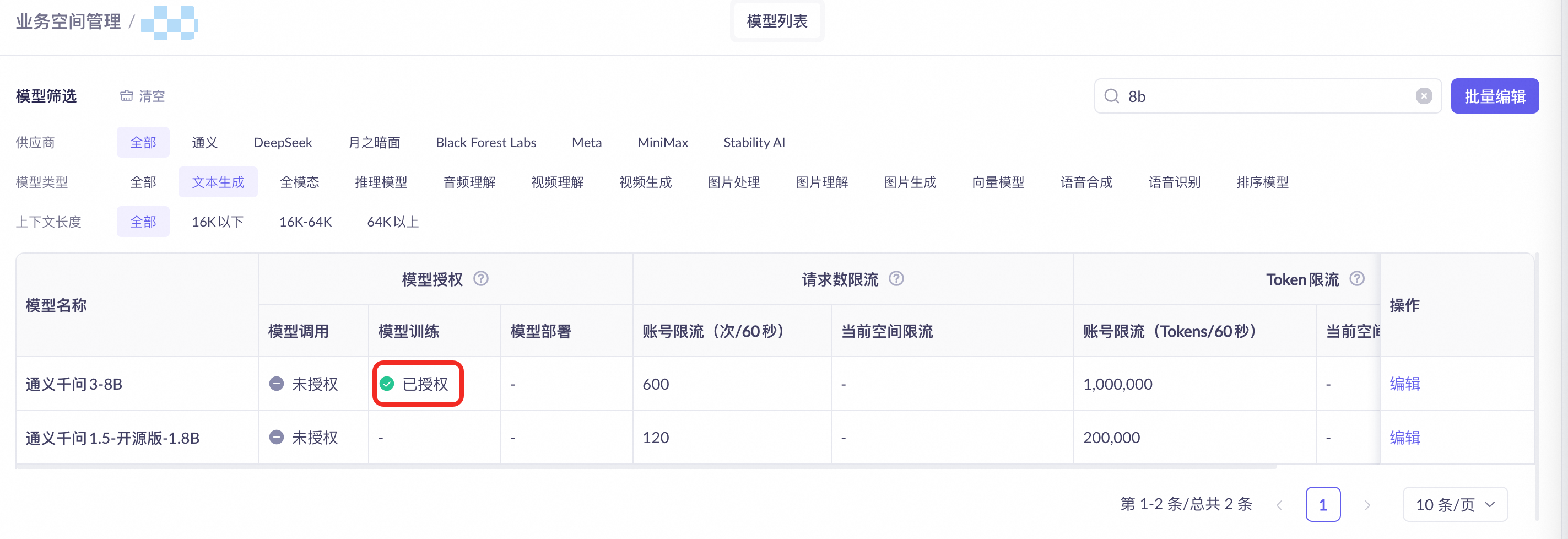

模型调优时报权限不足怎么办?

请联系您的平台或空间管理员,检查并开通以下权限:

账号拥有发起调优任务所在的业务空间下 模型调优-操作、模型部署-操作、模型评测-操作 的页面权限。

需要发起调优任务所在的业务空间拥有对特定模型进行模型训练(调优)的权限。

相关介绍请参考:授权子业务空间模型调用、训练和部署。控制台链接:百炼-业务空间管理。

如果模型调优后,评测的效果不好怎么办?

如果您使用的是人工评测,请检查评测维度是否符合业务或场景。

收集在模型评测时评测结果不佳的测试用例,统计分析评测结果不佳的原因,根据分析结果调整训练数据集,继续迭代调优模型。

根据评测结果不佳的用例生成 DPO 用例,对模型进行 DPO 训练。

模型调优、模型部署、模型评测怎么收费?

模型调优计费方式与模型调用计费方式相同,但费用会更高。模型评测按照模型调用计费。训练好的模型在部署后只收取部署费用,不收取模型的调用费用。详细数据请参考计费项。

还有什么方法能进行模型调优?

在百炼平台上还可以使用 API 进行模型调优。

如果需要上传和微调自己的模型,请前往阿里云人工智能平台 PAI ,进行模型微调与训练。

在阿里云百炼调优完成的模型可以下载到本地部署吗?

阿里云百炼平台进行调优的模型不支持导出,只支持在阿里云百炼上部署后测试、调用。