文件存储CPFS是阿里云推出的全托管、可扩展并行文件系统,满足高性能计算场景的需求。CPFS支持成百上千的机器同时访问,拥有数十GB的吞吐量、数百万的IOPS能力,同时还能保证亚毫秒级的延时。本文介绍如何在ACS中挂载CPFS存储卷,并验证CPFS的共享存储和持久化存储。

背景信息

CPFS包含智算版和通用版两种版本。更多信息,请参见CPFS产品概述。

CPFS智算版目前处于邀测中。更多信息,请参见CPFS智算版。

前提条件

ACS集群中已安装managed-csiprovisioner组件。

您可以在ACS集群管理页的左侧导航栏选择,在存储页签下查看managed-csiprovisioner组件的安装情况。

使用限制

CPFS智算版不支持挂载到GPU类型的ACS Pod。

CPFS对不同计算类型的ACS Pod的支持情况如下:

规格

CPU类型

GPU类型

CPFS通用版

CPFS智算版

(VPC挂载点)

(VPC挂载点)

仅部分地域和可用区支持创建CPFS智算版文件系统,具体请参见CPFS智算版。

注意事项

CPFS为共享存储。一个CPFS存储卷可以挂载到多个Pod上。

CPFS智算版采用按量计费,具体请参见CPFS智算版。

创建CPFS文件系统

CPFS通用版

CPFS智算版

创建CPFS智算版文件系统。具体操作,请参见创建CPFS智算版文件系统。

CPFS智算版目前处于邀测中,请先提交工单申请。

使用ACS集群对应的VPC和交换机创建VPC挂载点,生成挂载地址。具体操作,请参见管理VPC挂载点。

说明目前仅支持在CPU计算类型Pod中挂载CPFS智算版。

挂载CPFS存储卷

步骤一:创建PV和PVC

kubectl

连接集群。具体操作,请参见获取集群KubeConfig并通过kubectl工具连接集群或在CloudShell上通过kubectl管理Kubernetes集群。

将以下YAML内容保存为pv-pvc.yaml。

CPFS通用版

apiVersion: v1 kind: PersistentVolume metadata: name: cpfs-test labels: alicloud-pvname: cpfs-test spec: accessModes: - ReadWriteMany capacity: storage: 10Ti csi: driver: nasplugin.csi.alibabacloud.com volumeAttributes: mountProtocol: cpfs-nfs server: cpfs-***-***.cn-wulanchabu.cpfs.aliyuncs.com path: /share volumeHandle: cpfs-***** --- apiVersion: v1 kind: PersistentVolumeClaim metadata: name: cpfs-test spec: accessModes: - ReadWriteMany selector: matchLabels: alicloud-pvname: cpfs-test resources: requests: storage: 10Ti相关参数说明如下:

参数

说明

labels设置

alicloud-pvname: cpfs-testlabel用于PVC使用selector进行匹配绑定。accessModes访问模式。

capacity声明存储卷容量。

csi.driver驱动类型,设置为

nasplugin.csi.alibabacloud.com。csi.volumeAttributesmountProtocol设置为cpfs-nfs。server设置为CPFS通用版协议服务导出目录的挂载点域名,例如cpfs-***-***.cn-wulanchabu.cpfs.aliyuncs.com。path设置为CPFS通用版协议服务导出目录对应路径,例如/share。支持设置为子目录,例如/share/dir。

csi.volumeHandle设置为CPFS通用版文件系统ID。

selector使用PV上的label进行匹配绑定。

resources.requests容量不大于PV容量即可。

CPFS智算版(VPC挂载点)

仅支持CPU计算类型Pod挂载。

apiVersion: v1 kind: PersistentVolume metadata: name: cpfs-test labels: alicloud-pvname: cpfs-test spec: accessModes: - ReadWriteMany capacity: storage: 10Ti csi: driver: nasplugin.csi.alibabacloud.com volumeAttributes: mountProtocol: efc server: cpfs-***-vpc-***.cn-wulanchabu.cpfs.aliyuncs.com path: / volumeHandle: bmcpfs-***** --- apiVersion: v1 kind: PersistentVolumeClaim metadata: name: cpfs-test spec: accessModes: - ReadWriteMany selector: matchLabels: alicloud-pvname: cpfs-test resources: requests: storage: 10Ti相关参数说明如下:

参数

说明

labels设置

alicloud-pvname: cpfs-testlabel用于PVC使用selector进行匹配绑定。accessModes访问模式。

capacity声明存储卷容量。

csi.driver驱动类型,设置为

povplugin.csi.alibabacloud.com。csi.volumeAttributesmountProtocol设置为efc。serverCPFS智算版VPC挂载点域名,例如cpfs-***-vpc-***.cn-wulanchabu.cpfs.aliyuncs.com。path默认为/表示挂载CPFS文件系统的根目录,支持设置为子目录,如/dir。

csi.volumeHandle设置为CPFS智算版文件系统ID。

selector使用PV上的label进行匹配绑定。

resources.requests容量不大于PV容量即可。

创建PV和PVC。

kubectl create -f pv-pvc.yaml检查PVC完成绑定。

kubectl get pvc cpfs-test返回示例如下:

NAME STATUS VOLUME CAPACITY ACCESS MODES STORAGECLASS VOLUMEATTRIBUTESCLASS AGE cpfs-test Bound cpfs-test 10Ti RWX <unset> <unset> 10s

控制台

登录容器计算服务控制台。

在集群列表页面,单击目标集群名称,进入该集群的管理页面。

在集群管理页面的左侧导航栏,选择。

在存储声明页面,单击创建。

在弹出的对话框中,完成参数配置,然后单击创建。

以下为创建PVC的同时创建PV的参数说明,您也可以单独创建PV再创建PVC。

参数

说明

示例

存储声明类型

选择CPFS。

CPFS

名称

PVC名称,自定义输入。格式要求请参考界面提示。

cpfs-test

分配模式

根据需要选择已有存储卷和创建存储卷。

创建存储卷

CPFS类型

按需选择CPFS智算版或CPFS通用版。

CPFS通用版

总量

配置分配给Pod的存储容量,即要创建的CPFS存储卷容量。

说明CPFS静态卷总量仅起声明效果,实际容量不受限制,使用量以CPFS控制台为准。

20Gi

访问模式

支持ReadWriteMany和ReadWriteOnce。

ReadWriteMany

挂载点域名

配置要挂载的CPFS文件系统目录。

如果输入挂载点地址,例如

cpfs-***-***.cn-wulanchabu.cpfs.aliyuncs.com,则表示挂载的目录为CPFS文件系统的根目录(/)。如果输入挂载点地址和子目录,例如

cpfs-***-***.cn-wulanchabu.cpfs.aliyuncs.com:/dir,则表示挂载的目录为CPFS文件系统的/dir目录。如果/dir目录不存在,系统会自动新建。

cpfs-***-***.cn-wulanchabu.cpfs.aliyuncs.com文件系统ID

配置要挂载的CPFS智算版文件系统ID,仅当CPFS类型选择CPFS智算版时显示。

bmcpfs-0115******13q5

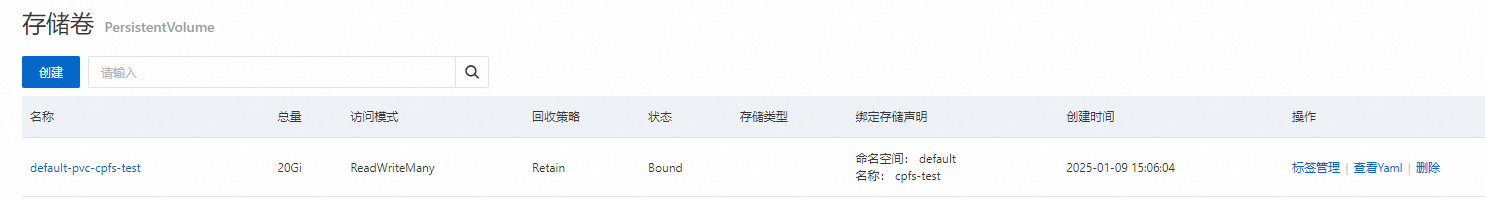

查看创建的PVC和PVC。

在存储声明页面可以看到新创建的PVC,且已绑定PV。

在存储卷页面可以看到新创建的PV,且已绑定PVC。

步骤二:创建应用并挂载CPFS

使用以下YAML内容,创建cpfs-test.yaml文件。

以下YAML示例可以创建包含2个Pod的Deployment,2个Pod均通过

alibabacloud.com/compute-class: gpu标签声明要使用GPU型算力,并且通过名为cpfs-pvc的PVC申请存储资源,挂载路径均为/data。说明关于以下示例中使用的GPU卡具体型号,请参见GPU型号说明。

apiVersion: apps/v1 kind: Deployment metadata: name: cpfs-test labels: app: cpfs-test spec: replicas: 2 selector: matchLabels: app: cpfs-test template: metadata: labels: app: cpfs-test alibabacloud.com/compute-class: gpu # 指定GPU型号为example-model,请按实际情况填写,如T4 alibabacloud.com/gpu-model-series: example-model alibabacloud.com/compute-qos: default spec: containers: - name: nginx image: registry.cn-hangzhou.aliyuncs.com/acs-sample/nginx:latest ports: - containerPort: 80 volumeMounts: - name: pvc-cpfs mountPath: /data volumes: - name: pvc-cpfs persistentVolumeClaim: claimName: cpfs-test创建Deployment并挂载CPFS。

kubectl create -f cpfs-test.yaml查看Deployment中Pod的部署情况。

kubectl get pod | grep cpfs-test返回示例如下,已创建2个Pod。

cpfs-test-****-***a 1/1 Running 0 45s cpfs-test-****-***b 1/1 Running 0 45s查看挂载路径。

命令示例如下,预期会返回CPFS智算版文件系统挂载目录下的数据。默认为空。

kubectl exec cpfs-test-****-***a -- ls /data

验证CPFS的共享存储和持久化存储

按照上文示例创建的Deployment中含有2个Pod,2个Pod同时挂载了同一CPFS智算版文件系统。您可以通过以下方式进行验证:

在一个Pod中创建文件,然后另一个Pod中查看文件,以此来验证共享存储。

重建Deployment,然后在新创建的Pod中查看文件系统中的数据是否存在,以此来验证持久化存储。

查看Pod信息。

kubectl get pod | grep cpfs-test返回示例如下:

cpfs-test-****-***a 1/1 Running 0 45s cpfs-test-****-***b 1/1 Running 0 45s验证共享存储。

在一个Pod中创建文件。

以名为

cpfs-test-****-***a的Pod作为示例:kubectl exec cpfs-test-****-***a -- touch /data/test.txt在另一个Pod中查看文件。

以名为

cpfs-test-****-***b的Pod作为示例:kubectl exec cpfs-test-****-***b -- ls /data预期返回如下,可以看到已共享新建的文件

test.txt。test.txt

验证持久化存储。

重建Deployment。

kubectl rollout restart deploy cpfs-test查看Pod,等待新Pod创建成功。

kubectl get pod | grep cpfs-test返回示例如下:

cpfs-test-****-***c 1/1 Running 0 78s cpfs-test-****-***d 1/1 Running 0 52s在新Pod中查看文件系统中的数据是否存在。

以名为

cpfs-test-c***的Pod作为示例:kubectl exec cpfs-test-****-***c -- ls /data预期返回如下,可以看到CPFS智算版文件系统中的数据依然存在,在新Pod的挂载目录下可以重新获取。

test.txt