DataHub是流式数据(Streaming Data)的处理平台,为您提供发布、订阅和分发流式数据的功能,让您可以轻松构建基于流式数据的分析和应用。

前提条件

配置DataHub输出节点前,您需要先配置好相应的输入或转换数据源,实时同步支持的数据源。

背景信息

DataHub Writer通过DataHub服务的Java SDK向DataHub写入数据,使用的日志服务Java SDK版本如下。

<dependency>

<groupId>com.aliyun.datahub</groupId>

<artifactId>aliyun-sdk-datahub</artifactId>

<version>2.5.1</version>

</dependency>操作步骤

进入数据开发页面。

登录DataWorks控制台,切换至目标地域后,单击左侧导航栏的,在下拉框中选择对应工作空间后单击进入数据开发。

鼠标悬停至

图标,单击。

图标,单击。 您也可以展开业务流程,右键单击目标业务流程,选择。

在新建节点对话框中,选择同步方式为单表(Topic)到单表(Topic)ETL,输入名称,并选择路径。

单击确认。

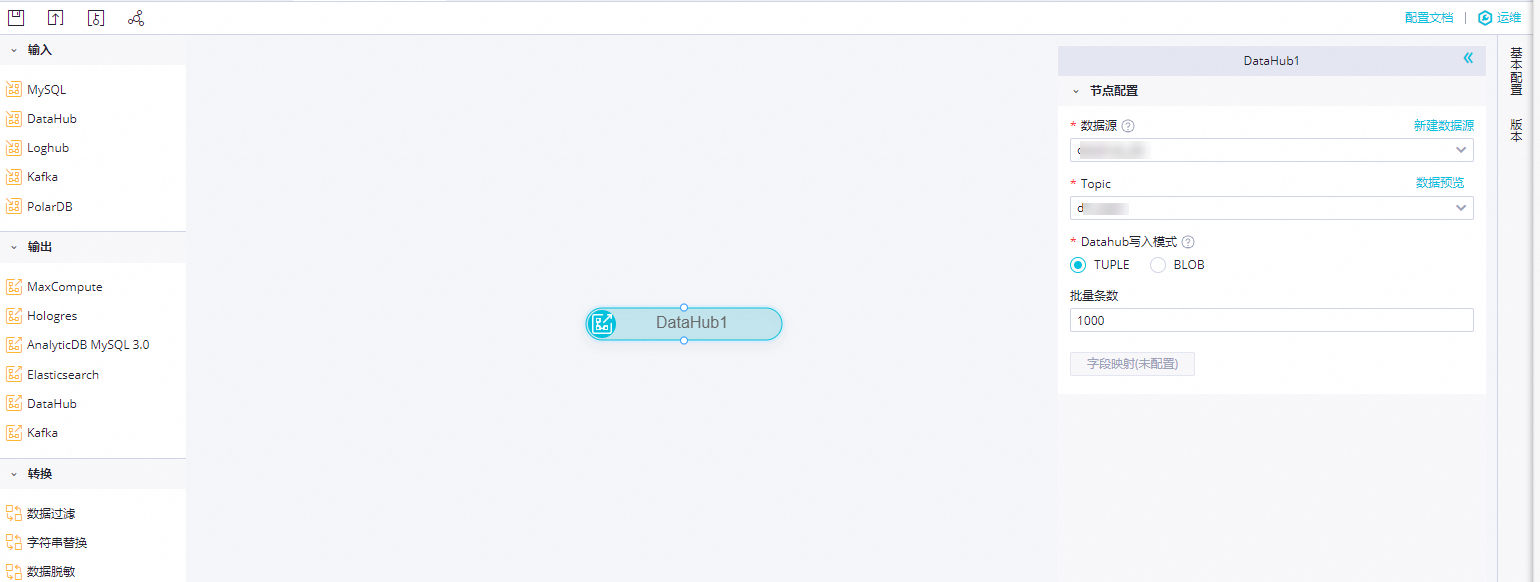

在实时同步节点的编辑页面,鼠标单击并拖拽至编辑面板,连线已配置好的输入或转换节点。

单击DataHub节点,填写节点配置对话框中的参数。

参数

描述

数据源

选择已经配置好的DataHub数据源,此处仅支持DataHub数据源。

如果未配置数据源,请单击右侧的新建数据源,跳转至页面进行新建。详情请参见配置DataHub数据源。

Topic

选择当前数据源下需要同步的Topic。您可以单击右侧的数据预览进行确认。

DataHub写入模式

DataHub写入方式分为两种:

TUPLE:结构化写入,需要对应的DataHub topic是schema结构建立的。

BLOB:非结构化写入,对应的DataHub topic是BLOB模式,按照二进制流块模式写入数据。

批量条数

支持批量同步的数量。

字段映射

映射源端和目标端的字段,进行同步任务时,会根据字段的映射关系同步数据。

单击工具栏中的

图标,保存配置。

图标,保存配置。

该文章对您有帮助吗?