该功能在DataWorks数据集成链路中,原生集成了AI大模型处理能力。它将传统的数据同步从简单的“搬运”升级为智能的“加工”,允许用户在数据从源到端的传输过程中,实时调用AI模型对流经的数据进行内容分析、处理与增强,在数据流转的过程中释放非结构化数据的隐藏价值。

功能介绍

适用客户:适用于需要在数据同步过程中对数据进行高级分析和处理的企业用户,特别是那些希望利用AI技术提升数据质量、挖掘数据价值的公司。

无缝嵌入同步链路:将AI处理作为数据集成中的一个内置处理环节,与源端读取、目标端写入无缝衔接。

支持丰富的NLP任务:可对同步中的文本数据进行多种自然语言处理(NLP),如:情感分析、摘要生成、关键词提取、文本翻译。

使用场景

行业领域 | 典型应用 |

客户服务 / 电子商务 | 实时分析用户评论、客服工单的情感倾向,自动提取核心问题与反馈要点。 |

合规 / 法律 / 科研 | 在同步过程中,对政策文件、法律合同、科研论文进行自动摘要和关键信息提取。 |

制造 / 供应链 / 医疗 | 智能分析设备日志、供应链反馈或医患沟通记录,实现风险预警和服务质量优化。 |

跨语言协作 | 将来自全球各地的社交媒体评论、新闻资讯或业务文档,在同步时自动翻译成统一语言,便于集中分析。 |

准备工作

已创建使用数据开发(Data Studio)(新版)的工作空间。

已准备AI辅助处理所需的大模型服务,根据选择的大模型服务商不同,需做如下准备:

阿里云DataWorks模型服务:已在大模型服务管理中完成模型部署,并启动模型服务。

阿里云百炼平台:已开通阿里云的大模型服务平台百炼并获取API Key。

阿里云PAI模型市场:已开通人工智能平台PAI并获取模型服务的Token。

离线同步任务支持手动配置数据源信息或使用已有数据源。

确保工作空间已绑定资源组,且资源组已与数据源连通。

计费说明

使用了AI辅助处理的数据集成任务,除数据集成任务本身涉及的费用外:数据集成场景费用,还涉及调用大模型产生的费用。其中:

阿里云DataWorks模型服务计费说明见:Serverless资源组计费-大模型服务。

阿里云百炼平台计费说明见:模型推理(调用)计费。

阿里云PAI模型市场计费说明见:模型在线服务(EAS)计费说明。

案例说明

本案例以Hologres为例,介绍Hologres单表离线同步至Hologres时,如何使用AI辅助处理功能,将数据来源表中feedback_info列的数据翻译为英文并同步至目标表。

一、创建离线同步任务

进入DataWorks工作空间列表页,在顶部切换至目标地域,找到已创建的工作空间,单击操作列的,进入Data Studio。

在左侧导航栏单击

,进入数据开发页面,在项目目录右侧单击

,进入数据开发页面,在项目目录右侧单击 ,选择,进入新建节点对话框。

,选择,进入新建节点对话框。设置节点路径、数据来源去向和节点名称后,单击确认,创建离线同步节点。

本文以Hologres同步至Hologres为例,介绍离线同步任务中的AI辅助处理功能。

二、配置同步任务

创建离线同步节点后,会自动进入任务编辑页面,您需要在此页面配置如下信息:

1、数据源

分别配置数据同步任务的数据来源和数据去向。

类型:创建离线同步任务步骤中已选择的数据来源和去向的数据源类型,不支持修改,如需修改请重新创建离线同步任务。

数据源:选择已绑定至工作空间的Hologres数据源,或者在下拉中选择新增数据源。

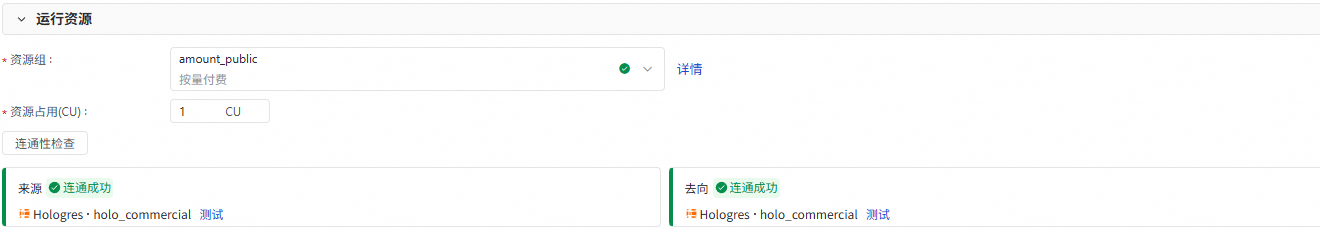

2、运行资源

选择同步任务所使用的资源组。如果使用Serverless资源组,您还可以为该任务分配资源占用(CU)。

选择资源组后,数据集成将自动检测资源组与数据来源、数据去向的连通性,您也可以手动单击连通性检查。

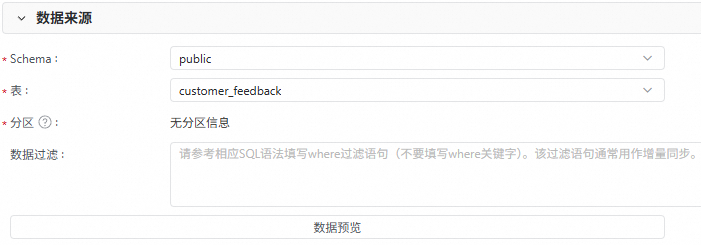

3、数据来源

配置数据来源具体待同步的表信息,如Schema、表、分区和数据过滤条件等。您可以单击数据预览,查看待同步的具体数据。

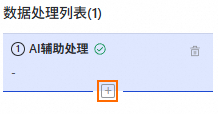

4、数据处理

在数据处理区域,您可以开启数据处理能力,数据处理能力需要更多的计算资源,会增加任务的资源占用开销。

单击添加节点,选择AI辅助处理。

配置AI辅助处理相关信息。

关键参数解释如下:

参数

描述

模型提供商

模型Endpoint

选择阿里云PAI模型市场,填写模型的调用Endpoint。获取地址,详见测试服务调用。

模型名称

负责智能数据处理的模型,按需选择。

API Key

访问模型的API KEY,请前往模型提供商获取。

阿里云百炼平台:获取百炼API Key。

阿里云PAI模型市场:前往部署的EAS任务,进入在线调试,获取Token,将其作为API KEY填写到此处。

处理工作描述

请使用自然语言描述对来源字段的处理,字段名以

#{column_name}格式书写。例如,本案例中,此处填写请将'#{feedback_info}'翻译成英文。写入字段

此处请输入存储结果字段的名称,如果对应字段不存在,将自动新增一个字段。

说明本案例的示例配置中,会将来源表的

feedback_info字段翻译成英文,并存储到feedback_processed字段中。您可以单击AI辅助处理区域右上角的数据输出预览,查看输出的最终数据效果。

(可选)您可以配置多个先后按顺序执行的数据处理流程。

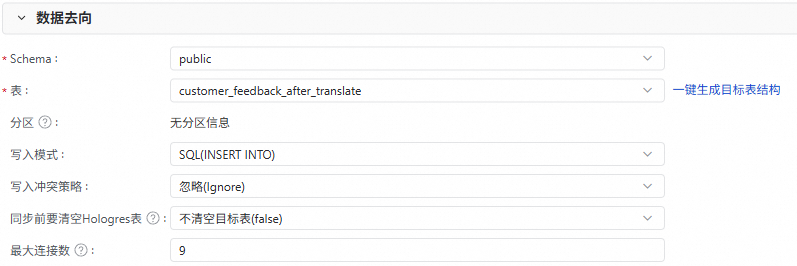

5、数据去向

配置数据同步的目标表信息,例如Schema、表名、分区等。

您可以单击一键生成目标表结构,快速生成目标表。

如果目标端中已存在表用于接收数据,则按需选择即可。

配置写入模式以及写入冲突策略。

配置同步前是否要清空Hologres表中的已有数据。

(可选)配置最大连接数。

最大连接数仅在写入模式为

SQL(INSERT INTO)下生效,在开启任务时请确保Hologres实例有充足的空闲连接。一个任务最多使用9个连接。

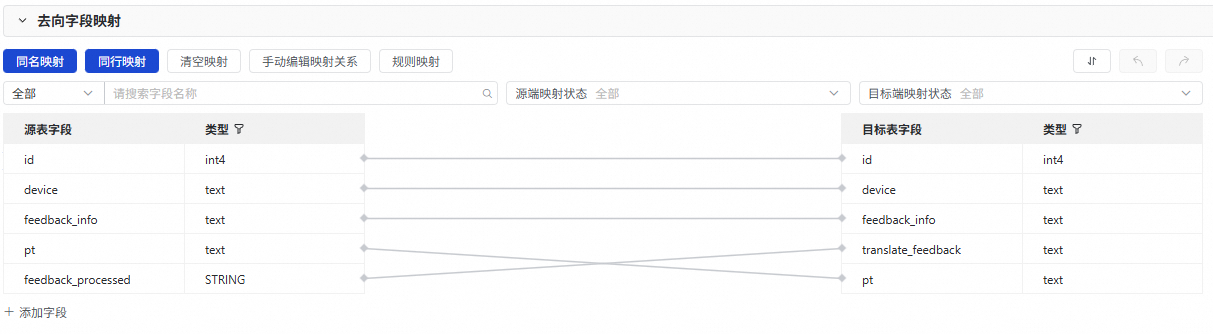

6、去向字段映射

配置完成数据来源、数据处理和数据去向后,会在此处展示来源与去向表间的字段映射关系,默认为同名映射和同行映射,你也可以按需进行调整。

本案例中除了将源表已有字段(id、device、feedback_info、pt)同名映射外,还需要手动将源表中存储翻译后结果的feedback_processed字段,映射至目标表的translate_feedback字段中。

三、调试任务

在离线同步任务的编辑窗口右侧,单击运行配置,配置调试本节点使用的资源组和相关脚本参数。

单击节点顶部工具栏的保存,然后单击运行,等待运行结束,查看运行结果是否成功,您可以前往目标端数据库查看表数据是否符合预期。

四、调度配置

若离线同步节点需要周期性调度执行,您需要在节点右侧的调度配置中设置调度策略,配置相关的节点调度属性。

五、节点发布

请单击节点工具栏的发布图标唤起发布流程,通过该流程将任务发布至生产环境。只有在发布至生产环境后,才会进行周期性调度。

后续操作:任务运维

节点发布后,您可以在发布流程中单击补数据或去运维。