通过MaxCompute与DLF和OSS的组合,可以实现数据仓库和数据湖的一体化,提供更加灵活和高效的数据处理能力。本文为您介绍如何通过MaxCompute、DLF和OSS构建湖仓一体,以及湖仓一体项目的管理。

前提条件

使用限制

仅华东1(杭州)、华东2(上海)、华北2(北京)、华北3(张家口)、华南1(深圳)、中国香港、新加坡和德国(法兰克福)地域支持构建湖仓一体能力。

MaxCompute、OSS和DLF必须部署在同一地域。

操作流程

MaxCompute湖仓一体构建流程如下:

步骤一:MaxCompute访问授权

步骤二:通过DataWorks构建湖仓一体

登录DataWorks控制台,选择支持构建湖仓一体的地域。

说明湖仓一体支持的地域,详情请参见使用限制。

在DataWorks控制台页面左侧导航栏,选择其他>数据湖集成(湖仓一体)。

在数据湖集成(湖仓一体)页面,单击现在开始创建。

在新建数据湖集成页面,按照界面指引进行操作。参数说明如下所示。

表 1. 创建数据仓库

参数

说明

外部项目名称

自定义外部项目名称。命名规则如下:

名称需以字母开头,且只能包含字母、下划线和数字。

名称不能超过128个字符。

说明外部项目基本概念,参考项目概念。

MaxCompute项目

选择对应的MaxCompute项目。如果没有MaxCompute项目,您可以单击新建项目(MC控制台)创建。详情请参见创建MaxCompute项目。

说明如果MaxCompute项目下拉列表中无法选择目标项目,则需要在DataWorks控制台中绑定目标项目,参考创建数据源或注册集群(未参加新版数据开发公测)。

表 2. 创建外部数据湖连接

参数

说明

异构数据平台类型

阿里云 E-MapReduce/Hadoop 集群:通过MaxCompute与Hadoop构建湖仓一体。

阿里云DLF + OSS 数据湖链接:通过MaxCompute和DLF和OSS构建湖仓一体。

阿里云DLF+OSS数据湖连接

External Project描述

可选。外部项目描述。

DLF所在区

连接DLF所在的可用区,请您根据地域进行选择。可选项如下:

杭州:cn-hangzhou

上海:cn-shanghai

北京:cn-beijing

深圳:cn-shenzhen

张家口:cn-zhangjiakou

新加坡:ap-southeast-1

法兰克福:eu-central-1

DLF Endpoint

DLF的对内服务Endpoint,请您根据地域进行选择。可选项如下:

华东1(杭州):dlf-share.cn-hangzhou.aliyuncs.com

华东2(上海):dlf-share.cn-shanghai.aliyuncs.com

华北2(北京):dlf-share.cn-beijing.aliyuncs.com

华北3(张家口):dlf-share.cn-zhangjiakou.aliyuncs.com

华南1(深圳):dlf-share.cn-shenzhen.aliyuncs.com

中国香港:dlf-share.cn-hongkong.aliyuncs.com

新加坡(东南亚1):dlf-share.ap-southeast-1.aliyuncs.com

德国(法兰克福):dlf-share.eu-central-1.aliyuncs.com

DLF数据库名称

连接DLF的目标数据库名称。您可以登录DLF控制台,在左侧导航栏元数据>元数据管理页面的数据库页签中获取。

重要目前仅支持选择DLF默认Catalog(数据目录)下的数据库。

DLF RoleARN

可选。RAM角色的ARN信息。采用自定义授权方式时,需要配置该参数。您可以登录RAM访问控制台,在左侧导航栏身份管理下拉列表下的角色页面获取。

步骤三:通过DataWorks管理湖仓一体

使用湖仓一体

在DataWorks控制台页面左侧导航栏,选择其他 > 数据湖集成(湖仓一体)。。

在数据湖集成(湖仓一体)页面,选择目标外部项目,开始使用湖仓一体。

使用湖仓一体。

单击目标外部项目操作列的使用湖仓一体。

更新湖仓一体外部项目。

单击目标外部项目操作列的项目配置,即可在项目配置对话框更新外部项目信息。

说明您可以更新MaxCompute外部项目映射的外部数据源的数据库名称,以及重新选择外部数据源。如果需要删除外部数据源,请到外部数据源页面进行删除(暂不支持外部数据源更新操作)。

删除湖仓一体外部项目。

单击目标外部项目操作列的删除,即可删除当前MaxCompute外部项目。

说明该删除操作为逻辑删除操作,外部项目会进入静默状态,并在15天后被正式删除。在此期间无法创建同名外部项目。

查看湖仓一体外部项目的元数据信息

在DataWorks控制台页面左侧导航栏,单击工作空间。

在工作空间列表中,选择与外部项目绑定的工作空间,单击操作列的。

在数据地图页面的搜索框或单击左侧导航栏

图标,在右侧项目列表页签下方,输入外部项目中的表名搜索。说明

图标,在右侧项目列表页签下方,输入外部项目中的表名搜索。说明表中的元数据信息为T+1更新,即在映射端(如Hive中)修改表结构,则T+1地体现在DataWorks数据地图中(MaxCompute引擎侧为实时元数据)。

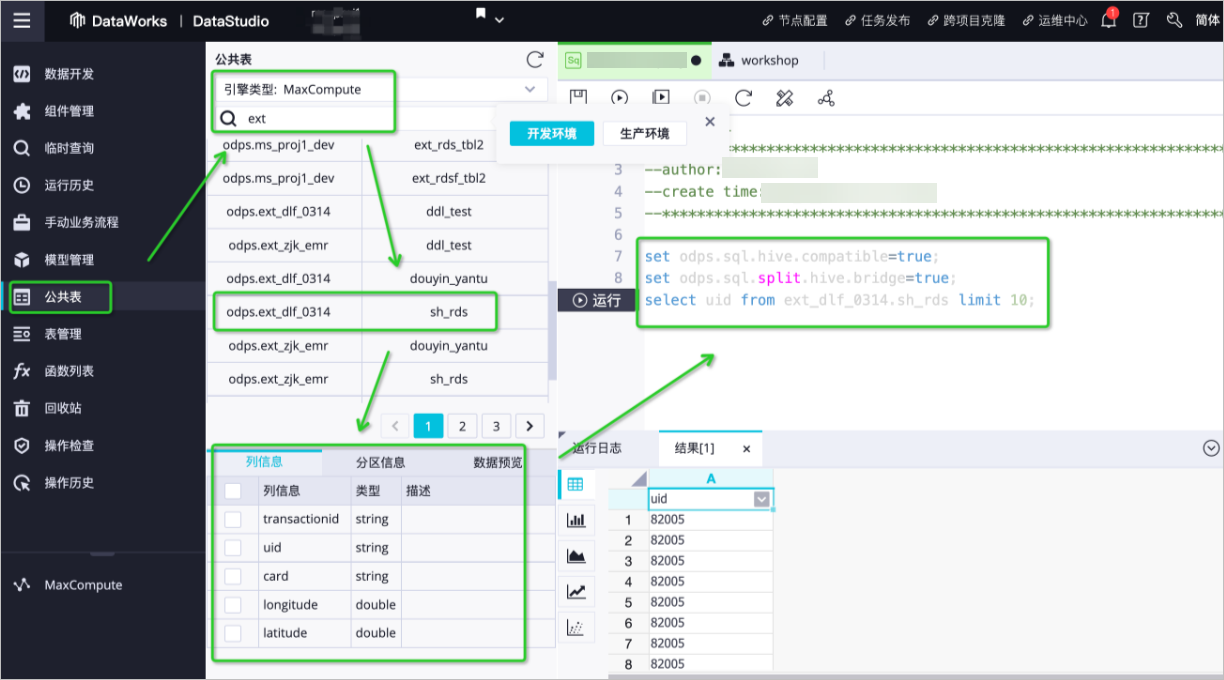

在DataWorks数据开发中查看外部项目元数据信息

在DataWorks控制台页面左侧导航栏,单击工作空间。

在工作空间列表中,选择与外部项目绑定的工作空间,单击操作列的。

在数据开发页面,单击左侧导航栏

图标,在数据目录中单击MaxCompute,在右侧MaxCompute - 项目页签,添加已有外部项目或新建项目。

图标,在数据目录中单击MaxCompute,在右侧MaxCompute - 项目页签,添加已有外部项目或新建项目。单击目标表名称即可在下方查看表结构信息。

说明表中的元数据信息为T+1更新,即在映射端(如Hive中)修改表结构,则T+1地体现在DataWorks数据地图中(MaxCompute引擎侧为实时元数据)。

相关文档

基于DLF、RDS或Flink、OSS支持Delta Lake或Hudi存储机制的湖仓一体方案,请参见基于DLF、RDS或Flink、OSS支持Delta Lake或Hudi存储机制。