无论是平台的预置模型还是您调优后的模型,通过部署可获得独立的、资源专享的推理服务,以满足您对高并发、低延迟等不同性能的业务需求。

本文档仅适用于中国大陆版(北京地域)。

支持的模型

模型类别 | 支持的模型 | 适用场景 |

预置模型 (阿里云百炼支持的标准模型) |

| 获取资源实例,保障推理性能与稳定性。 |

我的模型 (阿里云百炼平台调优后的模型) | 必须部署后才能推理或评测。 |

如果需要部署更多其他模型,请参考此解决方案并结合具体业务需求选择最适合的部署方案。

支持的计费方式

部署前可以在模型部署控制台(北京)查看不同模型的预估每小时费用。

计费方式在服务创建后无法更改。如需切换,必须下线已经部署的模型后再重新部署。

计费方式 | 部署方式 | 支持的模型 | 扩缩容方式 | 计费最小单位 | 优点 | 产品约束 |

按使用时长 (后付费) | 模型单元 | 所有可部署模型 | 自助扩缩容 | 分钟 |

| - |

包月 (预付费) | 部分可部署模型 | 自助扩缩容 | 天 |

|

| |

按模型使用量 (后付费) | Token 用量 | 部分可部署模型 | 在控制台提交申请, 等待人工审核。 | Token |

|

|

部署方法

您可以在控制台上部署模型,请参考以下操作步骤:

如果提示权限不足,请参考:部署时提示权限不足怎么办?

|

|

| |

重要 模型部署服务将产生费用。 |

部署配置设置

配置内容 | 配置详情 |

配置模型推理模式 | 少部分模型的模型单元部署模式可选。

|

最长上下文 | 部分模型的模型单元部署模式支持该设置。最长上下文长度基于模型类型。 |

服务限流 | 部分模型的模型单元部署模式支持该设置,可限制模型调用的 RPM、TPM。 |

模型部署详情

按使用时长计费(模型单元)

费用 = 使用时长(小时)× 模型单元数量 × 模型单元单价

通义千问

模型名称 | 模型类型 | 支持限流 | 模型单元规格 | 最长上下文 | 单价 (不满1分钟按1分钟计费) | 包月单价 (不满 1 天按 1 天计费) (如果在首月内提前退订,日单价将为 1.2 倍) |

通义千问3-14B | Instruct/Thinking | I 型模型单元(MU1) | 固定为: 详情请参考:qwen-3 | 96元/小时 | 46,000元/月 | |

通义千问3-8B | Instruct/Thinking | |||||

通义千问2.5-开源版-14B | Instruct | 固定为: 详情请参考:qwen-2.5 | ||||

通义千问2.5-开源版-7B | Instruct | |||||

通义千问2-开源版-7B | Instruct | 固定为: | ||||

通义千问-Turbo-0624(2024) | Instruct | 固定为: | ||||

通义千问-Plus-2025-12-01 | Instruct/Thinking | I 型模型单元(MU1) | 可设置: 详情请参考:qwen-plus | 192元/小时 | 92,000元/月 | |

通义千问-Plus-2025-07-28 | Instruct/Thinking | |||||

通义千问-Flash-2025-07-28 | Instruct/Thinking | 可设置: 详情请参考:qwen-flash | ||||

通义千问-Plus-0723(2024) | Instruct | 固定为: | ||||

通义千问2.5-开源版-72B | Instruct | 固定为: 详情请参考:qwen-2.5 | ||||

通义千问2.5-开源版-32B | Instruct | |||||

通义千问2-开源版-72B | Instruct | 固定为: | ||||

通义千问3-32B | Instruct | 固定为: 详情请参考:qwen-3 | ||||

通义千问3-Max-2025-09-23 | Instruct | II 型 / III 型模型单元 (MU2/MU3) | 可设置: 详情请参考:qwen-max | I 型模型单元:448元/小时 III 型模型单元:1048元/小时 | I 型模型单元:216,000元/月 III 型模型单元:504,000元/月 | |

模型类型:

Instruct - 模型部署后以非思考模式进行推理。

Thinking - 模型部署后以思考模式进行推理。

通义千问VL

模型服务 | 模型类型 | 支持限流 | 模型单元规格 | 最长上下文 | 单价 (不满1分钟按1分钟计费) | 包月单价 (不满 1 天按 1 天计费) (如果在首月内提前退订,日单价将为 1.2 倍) |

通义千问VL-Max-2025-08-13 | Instruct | VI 型模型单元(MU6) | 固定为: | 72元/小时 | 34,800元/月 | |

通义千问VL-Plus | Instruct | I 型模型单元(MU1) | 固定为: | 40元/小时 | 20,000元/月 | |

通义千问3-VL-8B-Instruct | Instruct | I 型模型单元(MU1) | 固定为: | 96元/小时 | 46,000元/月 | |

通义千问3-VL-8B-Thinking | Thinking | |||||

通义千问3-VL-4B-Instruct | Instruct | |||||

通义千问2.5-VL-7B | Instruct | |||||

通义千问VL-Max-0201(2024) | Instruct | 固定为: | 160元/小时 | 80,000元/月 | ||

通义千问3-VL-Flash-2025-10-15 | Instruct/Thinking | I 型模型单元(MU1) | 固定为: | 192元/小时 | 92,000元/月 | |

通义千问3-VL-Plus-2025-09-23 | Instruct/Thinking | |||||

通义千问3-VL-235B-A22B-Instruct | Instruct | 固定为: | ||||

通义千问3-VL-32B-Instruct | Instruct | |||||

通义千问2.5-VL-32B | Instruct | |||||

通义千问2.5-VL-72B | Instruct | |||||

模型类型:

Instruct - 模型部署后一定以非思考模式进行推理。

Thinking - 模型部署后一定以思考模式进行推理。

Instruct/Thinking - 可在模型部署时可选择是否开启思考模式。

按模型 Token 使用量

费用 = 模型输入 Token 数 × 模型输入单价 + 模型输出 Token 数 × 模型输出单价(最小计费单位:1 token)

只有在基于以下基础模型进行“SFT高效训练”后获得的自定义模型,才支持按模型 Token 使用量计费。

基础模型 | 模型类型 | 支持限流 | 最长上下文 | 输入单价 | 输出单价 |

通义千问3-32B | instruct | 固定为: 详情请参考:qwen-3 | 0.002元/千Token | 非思考模式:0.008元/千Token 思考模式:0.02元/千Token | |

通义千问3-14B | instruct | 0.001元/千Token | 非思考模式:0.004元/千Token 思考模式:0.01元/千Token | ||

通义千问3-8B | instruct | 0.0005元/千Token | 非思考模式:0.002元/千Token 思考模式:0.005元/千Token | ||

通义千问 2.5-72B | instruct | 固定为: 详情请参考:qwen-2.5 | 0.004元/千Token | 0.012元/千Token | |

通义千问 2.5-32B | instruct | 0.002元/千Token | 0.006元/千Token | ||

通义千问 2.5-14B | instruct | 0.001元/千Token | 0.003元/千Token | ||

通义千问 2.5-7B | instruct | 0.0005元/千Token | 0.001元/千Token | ||

通义千问2.5-VL-72B | instruct | 固定为: | 0.016元/千Tokens | 0.048元/千Tokens | |

通义千问2.5-VL-32B | instruct | 0.008元/千Tokens | 0.024元/千Tokens | ||

通义千问2.5-VL-7B | instruct | 0.002元/千Tokens | 0.005元/千Tokens | ||

通义千问 2-开源版-7B | instruct | 固定为: | 0.001元/千Token | 0.002元/千Token |

图片、视频生成模型(预置)-按实例(时间)计费

费用 = 资源占用时长(小时)× 实例数量 × 实例单价(不满1小时按1小时计费)

图片生成

模型服务 | 模型类型 | 独占实例资源规格 | 实例单价 | 实例单价 (预付费) |

通义万相-文本生成图像-0521 | 预置模型 | 轻量版 | 20元/实例/小时 | 10,000元/月 |

视频生成

模型服务 | 模型类型 | 独占实例资源规格 | 实例单价 | 实例单价 (预付费) |

悦动人像EMO-detect | 预置模型 | 轻量版 | 20元/实例/小时 | 10,000元/月 |

悦动人像EMO | ||||

舞动人像AnimateAnyone-detect | ||||

舞动人像AnimateAnyone |

部署后调用

模型部署成功后,支持通过 OpenAI 兼容、Dashscope及Assistant SDK进行调用。

在调用已部署成功的模型时,model的取值应为模型部署成功后的模型code。请您前往模型部署界面获取模型code。

示例代码以调用微调后的 qwen3-8b 模型为例:

模型特性(是否支持非流式输出、结构化输出等)与微调前的模型保持一致。

经过调优的深度思考模型在调用时是否开启深度思考,建议与调优数据格式一致:

调优数据含深度思考,调用时建议开启

enable_thinking参数。调优数据不含深度思考,调用时不建议开启

enable_thinking参数。

DashScope

import os

import dashscope

messages = [

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "你是谁?"},

]

response = dashscope.Generation.call(

# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv("DASHSCOPE_API_KEY"),

model="qwen3-14b-xxx-xxx", # 请替换为模型部署成功后的code

messages=messages,

result_format="message",

enable_thinking=False,

)

print(response)

OpenAI兼容接口

import os

from openai import OpenAI

client = OpenAI(

# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv('DASHSCOPE_API_KEY'),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(

model="qwen3-14b-xxx-xxx", # 请替换为模型部署成功后的code

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "你是谁?"},

],

extra_body={"enable_thinking": False},

)

print(completion)

部署服务扩缩容

按模型单元(时长)计费方式部署的模型可点击红框的扩缩容,自助、手动调节实例数量。

按 Token 调用量计费方式部署的模型点击黄框的扩容,填写并提交扩容申请表单,等待人工审核。

部署服务下线

前往模型部署,找到要下线的部署服务,点击下线并确认。下线后将不再产生计费。

常见问题

可以上传和部署自己的模型吗?

支持在我的模型控制台(北京)导入模型,详细支持列表请参考:模型导入。

此外,阿里云人工智能平台 PAI 提供了部署自有模型的功能,您可以参考PAI-LLM大语言模型部署了解部署方法。

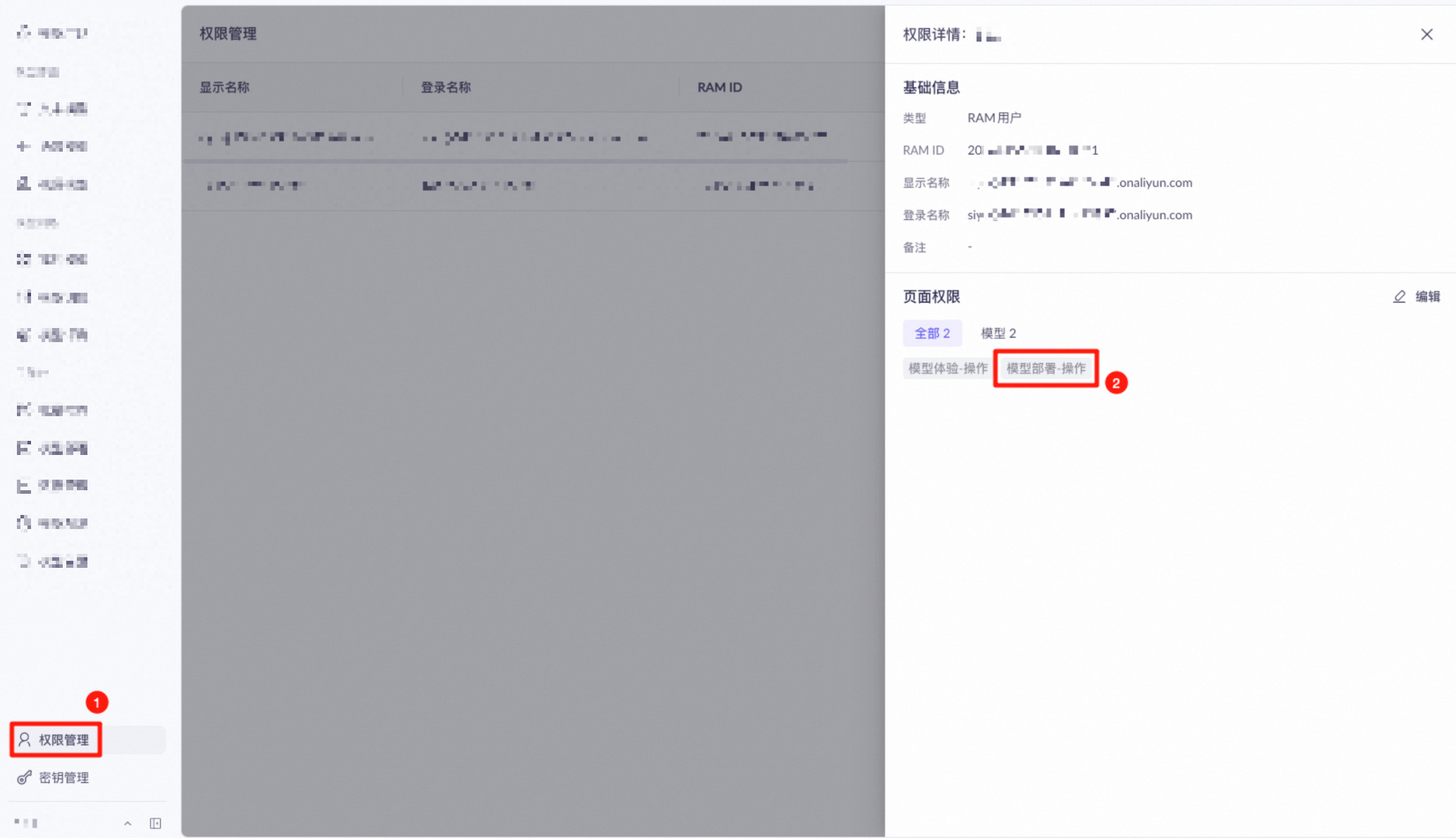

部署时提示权限不足怎么办?

如果显示“缺少该模块的权限”,请确保您的账号在该业务空间的权限管理页面中拥有模型部署-操作权限。

如果无法正常操作,请联系您的组织或 IT 管理员添加相关权限或代为检查权限问题。

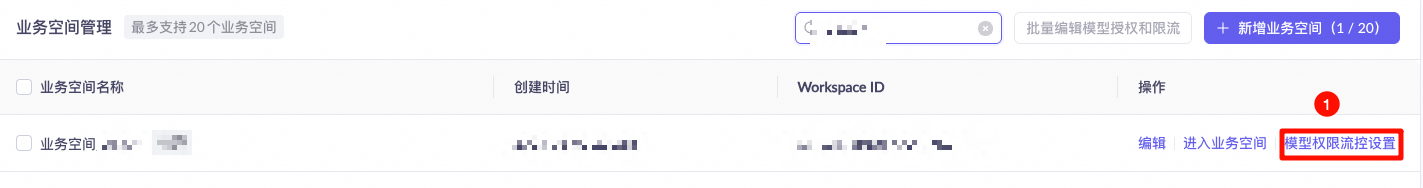

如果部署时报错“xx业务空间没有部署xx模型的权限”,请前往百炼的业务空间管理页面,为对应业务空间添加对应模型的部署权限。

API 调用报错:

Workspace xxx does not have deployment privilege for model xxxx。

如果提示权限不足,请联系您的组织或 IT 管理员添加相关权限或代为操作。

该如何切换到其他的计费方式?

只能释放原有资源,再重新使用需要的方式创建资源。

建议按照以下步骤进行切换:

使用需要的方式部署新的资源。

切换 API 并测试服务可用性。

下线释放原有资源。