本文介绍AI 能力概览。

AI场景下,经过网关的流量有以下三大特征,是区别于其他业务流量的,分别是:

长连接:由 AI 场景常见的 Websocket 和 SSE 协议决定,长连接的比例很高,要求网关更新配置操作对长连接无影响,不影响业务。

高延时:LLM 推理的响应延时比普通应用要高出很多,使得 AI 应用面向恶意攻击很脆弱,容易被构造慢请求进行并发攻击,攻击者的成本低,但服务端的开销很高。

大带宽:结合 LLM 上下文来回传输,以及高延时的特性,AI 场景对带宽的消耗远超普通应用。如果网关没有实现较好的流式处理能力和内存回收机制,容易导致内存快速上涨。

MSE 云原生网关应对网关流量有着天然的优势,特征分别是:

长连接无损的热更新:不同于 Nginx 变更配置需要 Reload,导致连接断开,MSE 云原生网关基于 Envoy 实现了连接无损的真正热更新。

安全网关能力:基于MSE 云原生网关的安全网关能力可以提供 IP/Cookie 等多维度的 CC 防护能力,面向 AI 场景,除了QPS,还支持面向 Token 吞吐的限流防护。

高效的流式传输:MSE 云原生网关支持完全流式转发,并且数据面是基于 C++ 编写的 Envoy,在大带宽场景下,所需的内存占用极低。内存虽然相比 GPU 很廉价,但内存控制不当导致 OOM,导致业务宕机,损失不可估量。

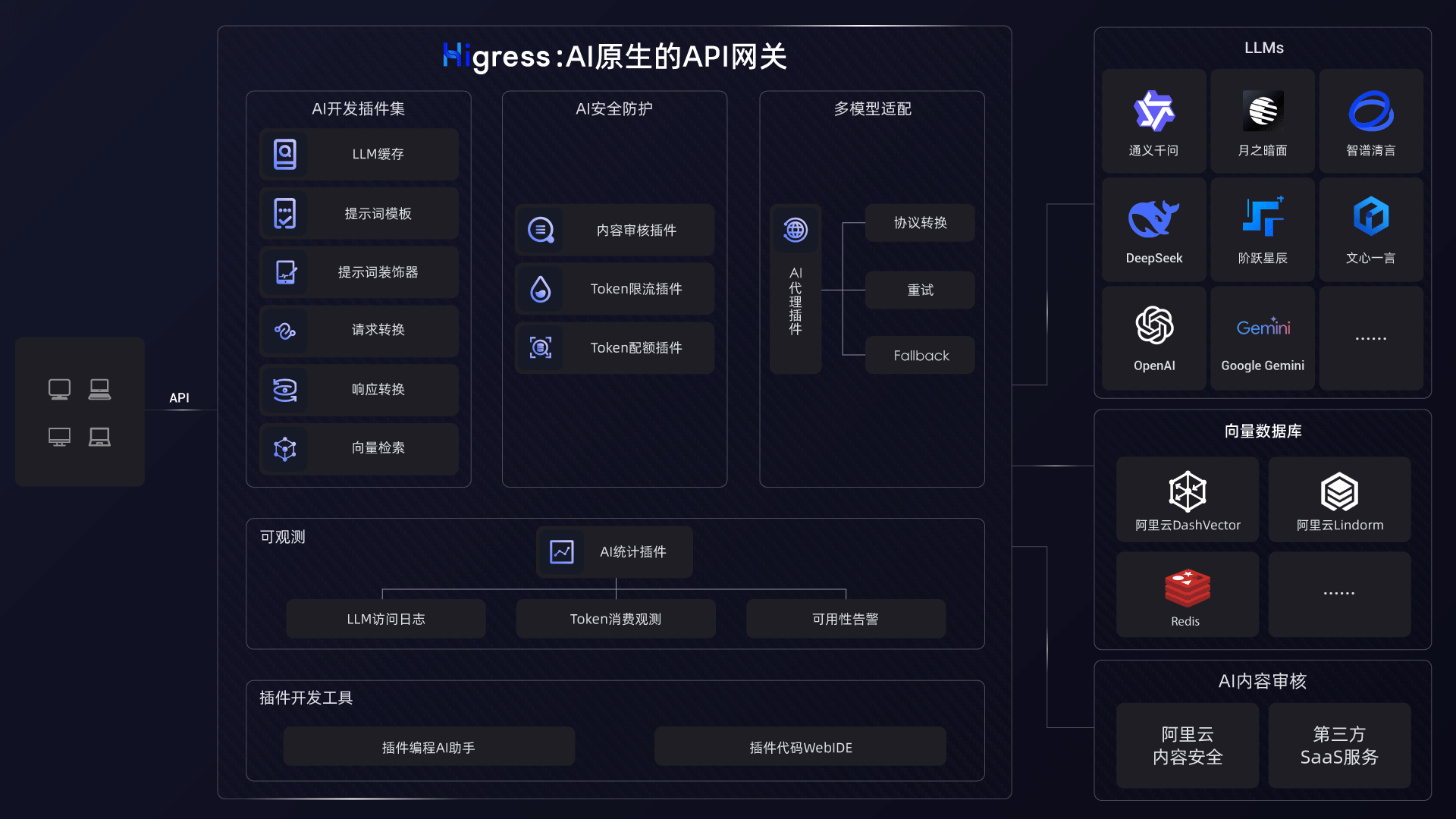

此外,我们提供了全面的AI插件集,提供包含安全防护、多模型适配、可观测、缓存、提示词工程等领域在内的多个开箱即用插件,核心能力如下:

AI 代理插件:支持对接多厂商协议,共支持15家 LLM 提供商,基本涵盖多数主流大型模型厂商。

AI 内容审核插件:支持对接阿里云内容安全云服务,可以拦截有害语言、误导信息、歧视性言论、违法违规等内容。

AI 统计插件:支持统计 Token 吞吐,支持实时生成 Promethus Metrics,在访问日志以及链路追踪的Span中打印相关信息。

AI 限流插件:支持基于 Token 吞吐进行后端保护式限流,也支持面向调用租户配置精确的调用额度限制。

AI 开发插件集:提供包含 LLM 结果缓存、提示词装饰等相关能力,可以助力AI应用的开发构建。