当Model API的模型服务因异常、故障或高负载而无法正常响应时,通过配置Fallback切换到备用模型,有效避免因模型服务中断导致的响应失败问题。本文将介绍如何为Model API开启和配置Fallback。

什么是AI Fallback

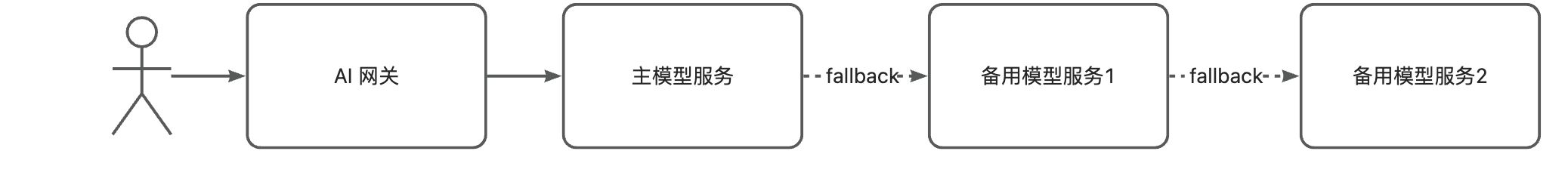

AI Fallback 是指Model API在主模型服务不可用时Fallback到备用模型,从而提升Model API的可用性,避免因为某个模型服务的异常或者高负载造成的请求不可用。

Model API 支持多级Fallback,启用并合理的配置Fallback, 可有效提升AI请求的成功率。典型场景示例如下:

AI 网关支持配置一到多个Fallback模型,当主模型服务不可用时,网关将会按顺序调用Fallback模型服务,如果调用成功,则会立即返回。

Fallback 模型包含如下配置项:

触发条件

当调用模型服务,返回任意 HTTP 4xx、5xx 错误状态码时,均会触发 AI Fallback。

前提条件

配置AI Fallback

打开AI网关控制台实例页面,在顶部菜单栏选择目标实例所在地域,并单击目标实例ID。

在左侧导航栏,单击Model API。可在创建或者编辑Model API时开启Fallback。

创建Model API:单击创建API,在Model API 的配置页面,开启Fallback。

编辑Model API:单击目标API操作列的编辑,在Model API 的配置页面,开启Fallback。

配置项

说明

Fallback

开启后可添加Fallback服务,按照降序执行。

说明Fallback服务支持重复使用同一个服务组建多条策略。

仅Fallback后端服务错误

开启后,仅当后端服务返回错误时才会触发Fallback机制。

如果不开启,则当请求被网关限流或者其它形式拦截时同样会触发Fallback。

Fallback列表

服务名称

选择Fallback服务名称。

模型名称

默认为透传。将请求中的模型名称直接传递给Fallback模型服务。

首包超时

流式传输中首个响应包的超时时间,单位为毫秒。首包超时仅对流式响应生效,设为0时代表不启用,当设置首包超时为非0时,对于首包响应过慢的请求网关将会fallback至兜底服务。