本文为您介绍DataWorks独享资源组的相关问题。

独享资源组使用场景

独享资源组网络配置

独享资源组商业化行为

独享资源组使用细则

独享调度资源组使用场景

如果非数据集成任务需要访问VPC环境下的数据库、有白名单访问控制的数据库时,需要使用独享调度资源组,独享调度资源组的使用详情请参见新增和使用独享调度资源组。

独享数据集成资源组使用场景

如果您需要同步VPC环境下的数据库,您需要使用独享数据集成资源组。独享数据集成资源组的使用详情请参见新增和使用独享数据集成资源组。

如何切换任务执行时使用的调度资源组?

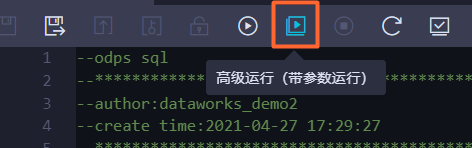

切换在数据开发测试运行时任务使用的资源组:

如果您需要切换测试运行时的调度资源组,请选择高级运行。

切换生产调度运行时任务使用的调度资源组:

在数据开发界面通过发布流程切换生产任务执行时使用的调度资源组。

在数据开发界面打开节点调度配置界面,在资源属性区域选择任务调度运行时需要使用的资源组。并提交发布。详情请参见配置资源属性。

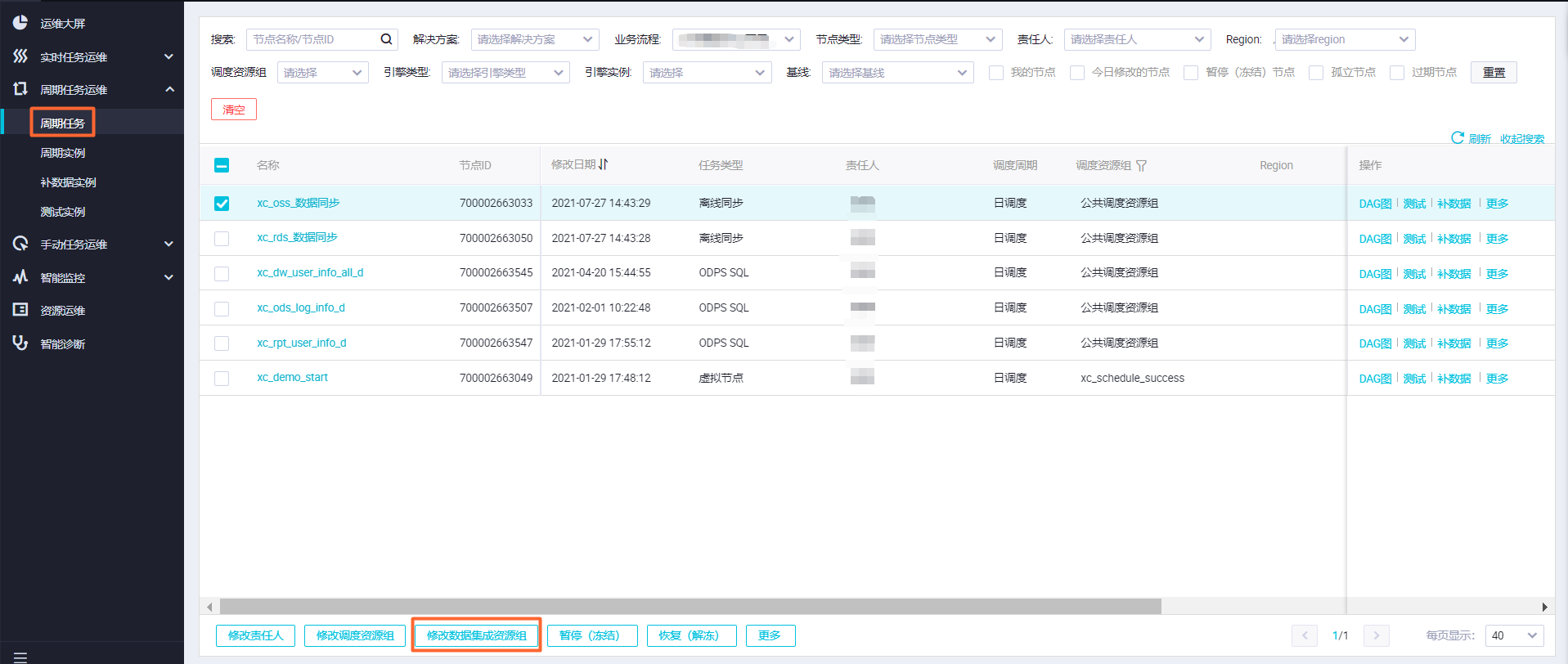

在生产运维中心修改任务执行时使用的调度资源组。

左上角的

图标,选择,进入生产运维中心页面,选择周期任务。

图标,选择,进入生产运维中心页面,选择周期任务。 说明

说明虚拟节点不占用资源,所以无需也不支持修改调度资源组。

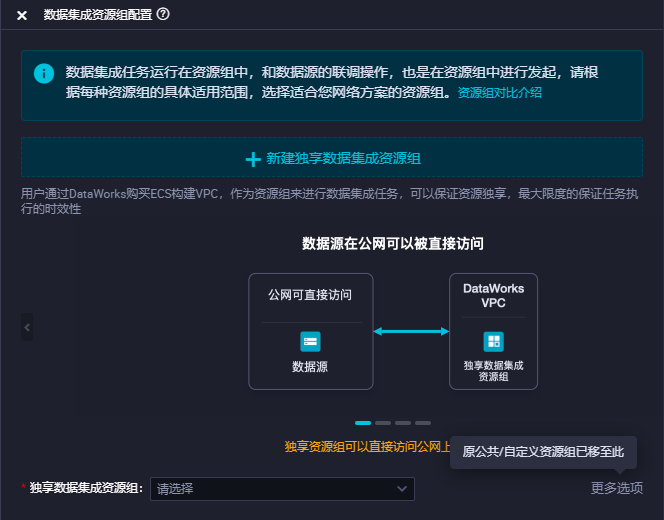

如何切换数据集成任务执行时使用的数据集成资源组?

切换数据集成任务开发环境测试运行时使用数据集成任务执行资源组:

在数据开发界面打开离线同步任务,选择右侧的数据集成资源组配置。

说明

说明如果生产环境执行也需要使用该资源组,请修改资源组后进行节点提交发布操作。

切换生产调度运行时使用数据集成任务执行资源组:

左上角的

图标,选择,进入生产运维中心页面,选择周期任务。

图标,选择,进入生产运维中心页面,选择周期任务。

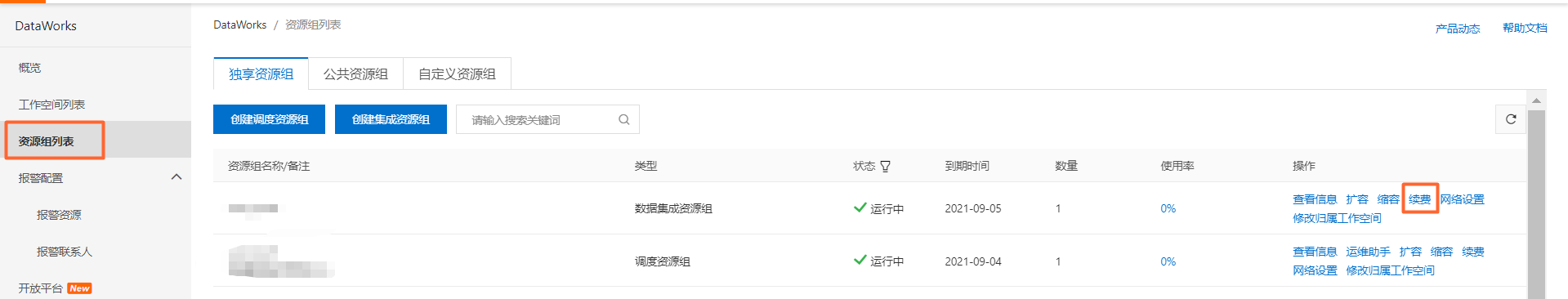

如何对资源组进行续费?

在DataWorks控制台组员组列表,选择具体资源组进行续费。

如果子账号需要进行相关操作,请参考文档如何为子账号授权购买相关服务的权限?

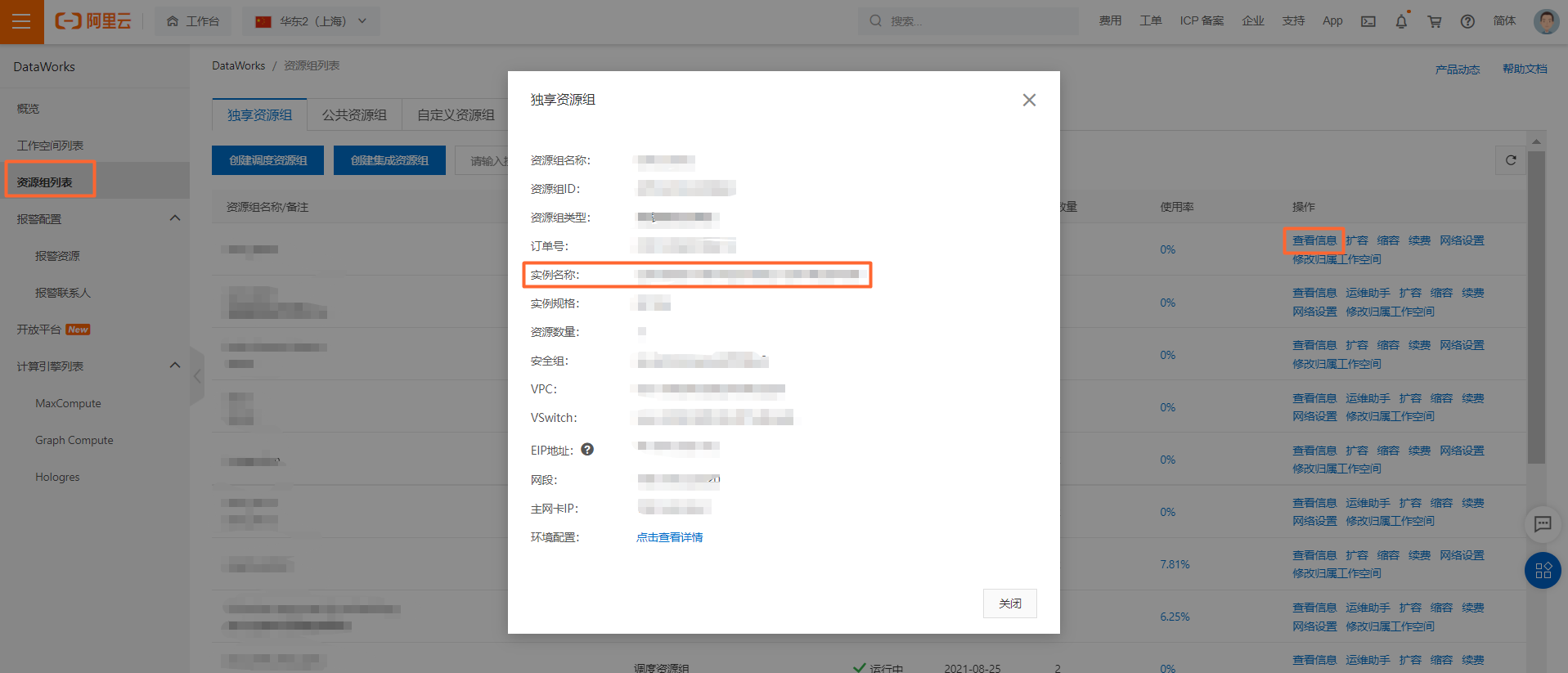

如果您需要修改资源组续费方式(手动续费,自动续费),您可以根据资源组的实例名称在阿里云续费管理页面进行处理。

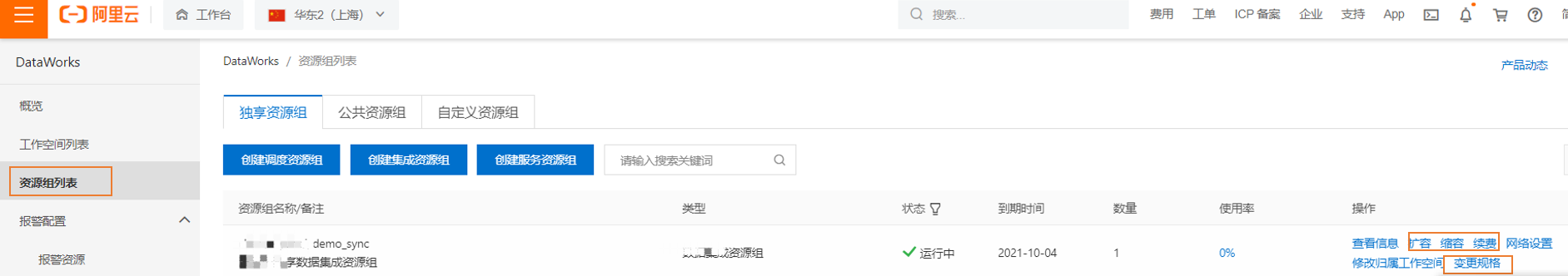

如何对资源组进行扩容、缩容和规格变更操作?

您可以在DataWorks控制台资源列表中对指定资源组进行扩容、缩容和规格变更操作。

如果子账号需要进行相关操作,请参考文档如何为子账号授权购买相关服务的权限?

扩容、缩容操作为增加或减少资源组下同规格的资源组数量。

独享资源组访问VPC环境下数据的前提条件是什么?

您在DataWorks使用独享资源组访问数据库,需要确保以下内容:

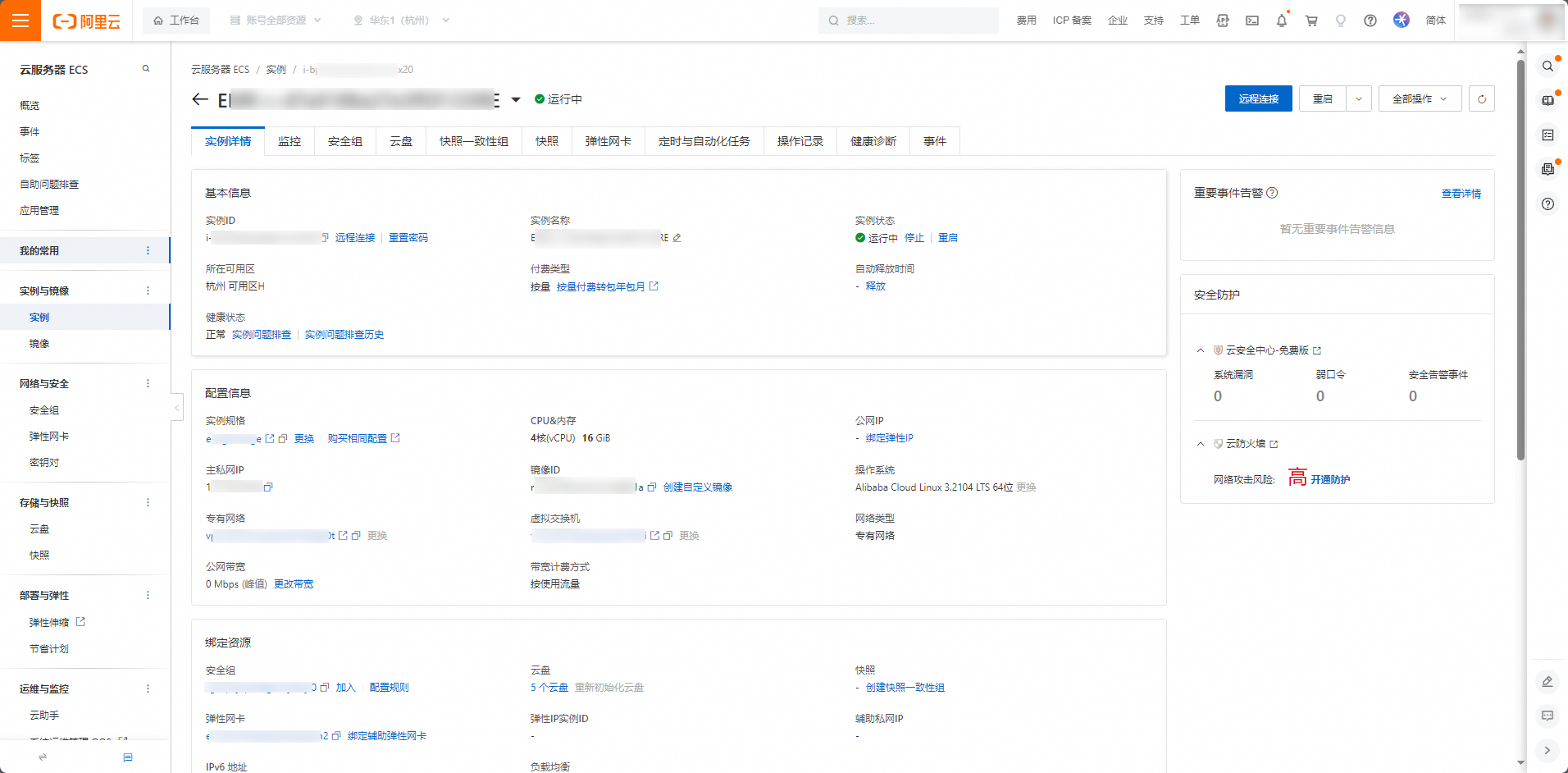

购买独享资源时,需要选择数据源所在的可用区,并为独享资源组绑定专有网络。

独享资源绑定的专有网络和交换机,需要和数据源保持一致。

如果数据库有白名单限制,您需要添加独享资源组EIP地址、独享资源组绑定的专有网络(或交换机)网段至数据库的白名单和安全组访问许可内。详情请参见添加白名单和附录:ECS自建数据库的安全组配置。

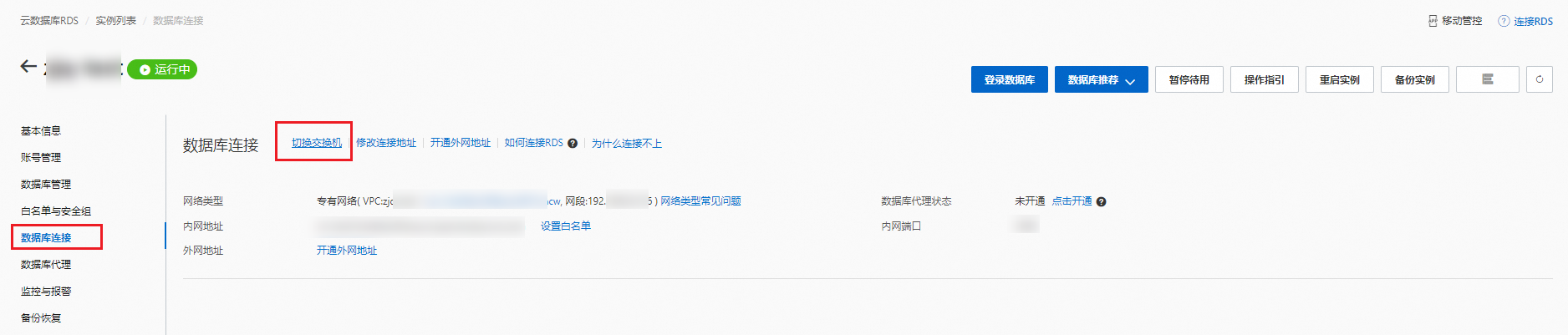

如何查看数据源的网络环境?

添加独享资源组白名单

通过内网访问,请将资源组绑定的交换机网段IP添加到数据源的白名单列表。

在DataWorks控制台的资源组页面独享资源组页签下,单击目标资源组后的网络设置,查看交换机网段并将其添加至数据源的白名单列表中。

通过公网访问:

Serverless资源组:请将Serverless资源组绑定VPC配置的EIP添加至数据源的白名单列表中。

在公网NAT网关控制台,找到配置好的SNAT条目,获取对应交换机绑定的公网IP地址。

旧版资源组:请添加资源组本身的EIP至数据源的白名单列表中。

在DataWorks控制台的资源组页面的独享资源组页签下,单击目标资源组后的查看信息,获取对话框中的EIP地址。

说明如果您之后对资源组进行了扩容操作,请检查此处待添加的EIP是否有变动,为了避免任务执行出错,请在扩容后第一时间更新数据源添加的白名单。

如何将资源组与工作空间进行绑定和解绑?

请在DataWorks控制台资源列表进行操作。

需要有工作空间管理员权限才可以进行此操作。

同步任务运行时如果资源组资源不足,是扩充调度资源组还是数据集成资源组?

只需要扩充独享数据集成资源组,无需扩充调度资源组。