阿里云Elasticsearch(简称ES)可与阿里云百炼模型服务平台、AI搜索开放平台提供的AI模型能力集成,为不同业务场景提供高效灵活的AI搜索产品方案,常见的应用场景包括语义搜索、多模态检索、RAG知识库、搜推问答助手等。

背景信息

无论是企业内部知识管理,还是面向C端的电商、内容、娱乐等领域,搜索技术的效能都直接影响点击率、转化率等业务指标。搜索的核心在于从海量信息中快速定位用户需求,而AI搜索则在此基础上更进一步,追求信息的精准度与用户满意度。大模型搜索潜力无限,但面临场景效果要求高、模型使用成本高,隐私安全可控性低等问题。

阿里云ES AI搜索功能依托于强大的ES基础,整合多样化模型与混合检索技术,实现了从传统搜索到AI语义搜索的跨越。该功能通过精细的数据预处理、智能向量化、多维度检索召回、以及大模型辅助生成,形成了一个完整且高效的智能语义搜索及RAG场景应用框架。

阿里云AI搜索方案介绍

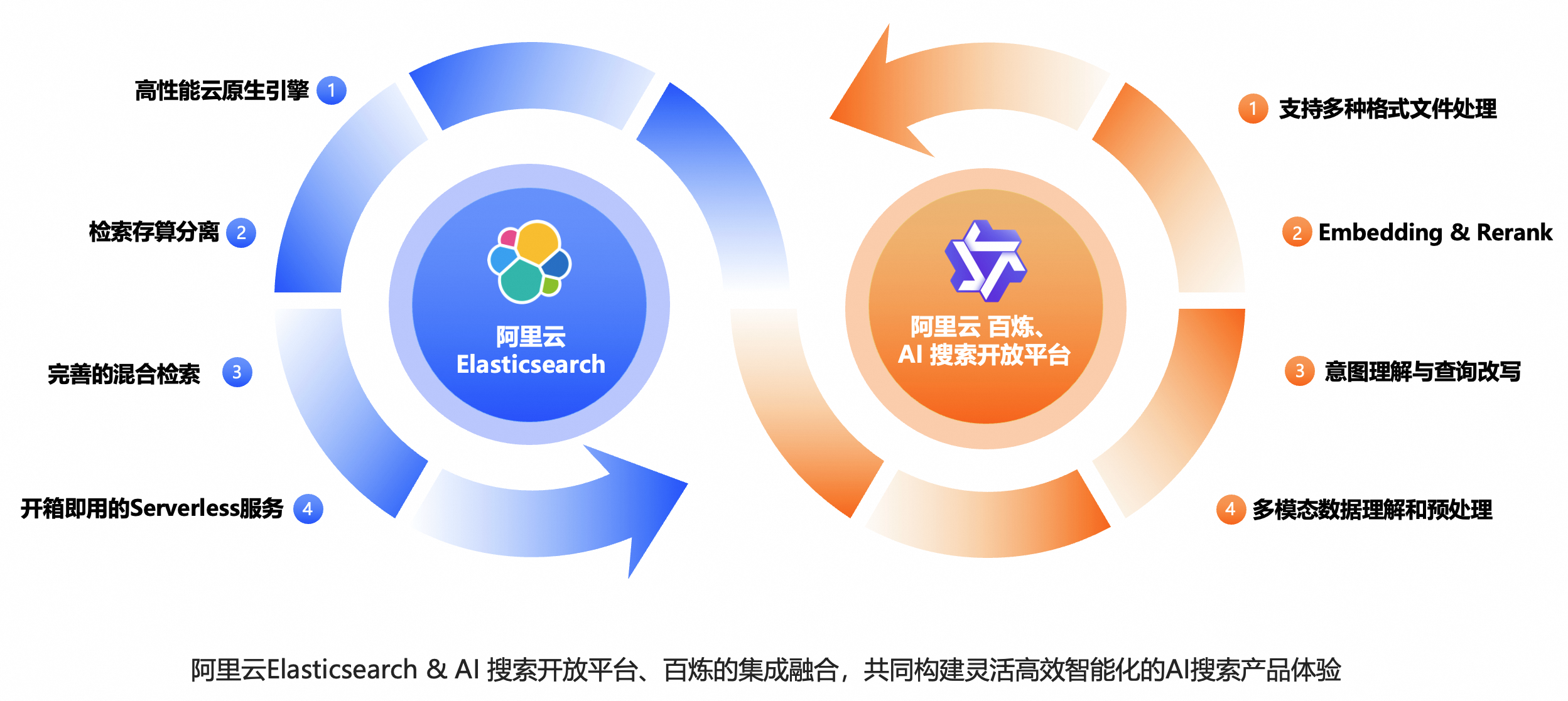

阿里云 AI 搜索方案是一套面向企业级应用的智能搜索解决方案,旨在将传统搜索引擎的能力与大模型(LLM)的语义理解、生成能力深度融合,实现“搜得准、答得对、体验好”的新一代搜索体验。该方案主要由两个核心构建模块组成:高性能搜索引擎与先进的 AI 模型能力。

高性能搜索引擎(Elasticsearch)

阿里云基于企业版 Elasticsearch 和自研优化的功能特性,提供高性能、高可用、可扩展的底层搜索引擎,具备以下关键能力:

毫秒级响应:高性能引擎增强能力支持海量数据的实时索引与低延迟查询。

多模态检索:支持文本、向量、结构化数据等多类型内容的混合检索,大幅提升检索精度与效率。

语义增强:通过向量检索(ANN)、倒排索引与语义匹配结合,提升相关性排序。

企业级特性:包括权限控制、审计日志、高可用部署、快速扩缩容等。

说明阿里云 ES 是 Elasticsearch 的托管服务,在兼容开源生态的同时,深度优化了性能、稳定性与成本效率。

先进的 AI 模型能力

AI搜索通过两大平台提供模型能力支撑:

百炼:阿里云推出的大模型开发及应用构建平台,提供最全最先进的通用模型能力,包括多模态模型、文本向量模型、重排序模型等。

AI搜索开放平台介绍:专为搜索场景打造的模型服务平台,提供智能检索链路所需的原子化能力。

说明阿里云AI搜索开放平台是专为搜索场景打造的模型服务平台,针对文本搜索、电商图片、人脸识别等场景有特定优化,兼顾成本与效果。

通过“引擎 + 模型”双轮驱动,阿里云 AI 搜索方案帮助企业从“关键词匹配”迈向“语义理解+智能生成”的下一代搜索范式,显著提升用户体验与业务效率。

阿里云ES AI搜索方案介绍

本文提供了两种场景化方案的原理介绍。

AI语义搜索

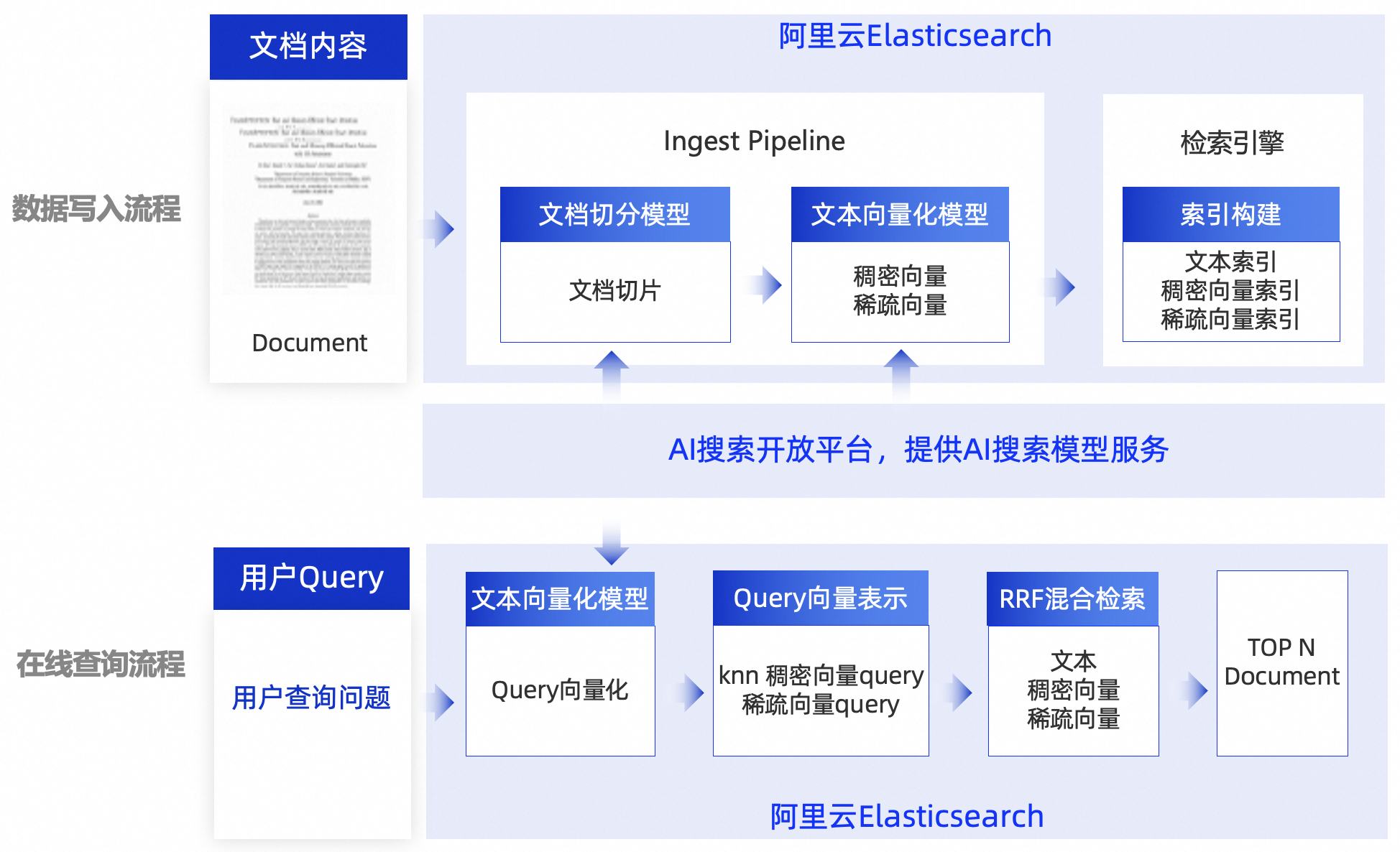

阿里云ES提供的高性能混合检索方案,结合AI搜索开放平台在智能搜索场景提供的优质组件化服务,形成完整的AI语义搜索方案。

该过程包含两个核心流程:

数据写入流程:

运用先进的文档切片模型实施语义层面的精细分割,转化成若干语义切片单元。

借助自主研发的向量化模型,将这些切片转换成稠密与稀疏向量极大地增强了信息的表达能力及检索效率。

向量在ES搜索引擎中被用来构建高效索引,为后续的信息检索任务奠定坚实基础,体现了从复杂数据到结构化知识的有效转化与利用。

数据查询流程:

处理搜索任务时,首先将需要查询的Query信息,通过向量化模型转换为稠密向量和稀疏向量,然后在ES索引中进行混合检索,召回TOP N文档内容。

基于RAG的知识库问答

检索增强生成(Retrieval-Augmented Generation),简称RAG,是一种结合了信息检索技术和生成式大语言模型的人工智能技术,旨在提升模型生成内容的相关性、准确性和多样性。下图展示了RAG全链路搭建方案。

该过程包含两个核心流程:

数据写入流程:

运用文档解析模型,将多种非结构化文档内容转化为结构化数据。

运用先进的文档切片模型,实施语义层面的精细分割,将文档转化成若干语义切片单元。

借助自主研发的向量化模型,将这些切片单元转换成稠密向量与稀疏向量,并写入ES索引中,作为在线问答知识库,为后续的大模型信息检索任务提供额外的信息输入。

数据查询流程:

处理搜索任务时,首先对Query(搜索内容)进行分析,然后在知识库中检索与Query最相关的片段,最后将检索到的信息与Query一起输入到大语言模型(LLM)中,Query作为提示或者上下文引导大模型生成更精确和丰富的回答。

相关文档

场景化方案:

AI语义搜索场景:

RAG场景: