在Elasticsearch(简称ES)实例中使用AI推理模型时,需要首先在引擎中创建AI模型。根据模型的来源,可以分为两种操作方式,即内置模型、自部署模型对应的操作方式。您可以参考本文进行操作。

计费说明

按量计费,仅对实际调用量计费,无调用不产生费用。

创建模型

内置模型

在左侧导航栏,单击Elasticsearch实例。

进入目标实例。

在顶部菜单栏处,选择资源组和地域。

在Elasticsearch实例中单击目标实例ID。

在左侧导航栏,选择。

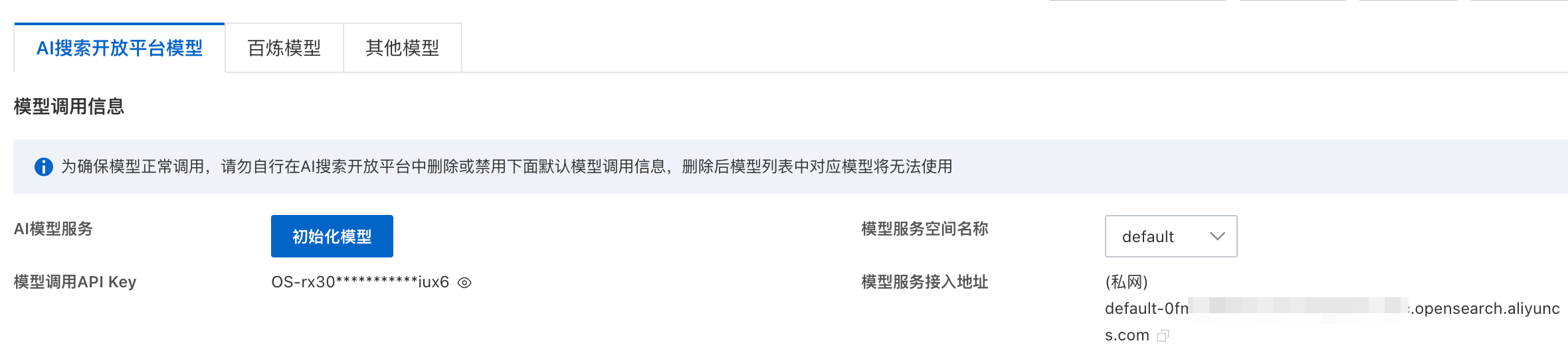

单击初始化模型后,系统将自动检测当前账号是否已开通 AI 搜索开放平台服务:

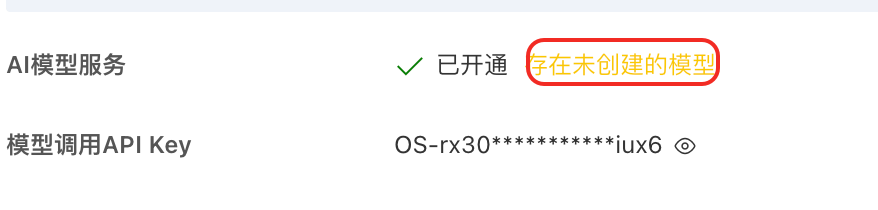

已开通:自动完成模型初始化。

未开通:跳转至 AI 搜索开放平台开通页面 → 开通成功后,自动返回 ES 控制台并完成初始化。

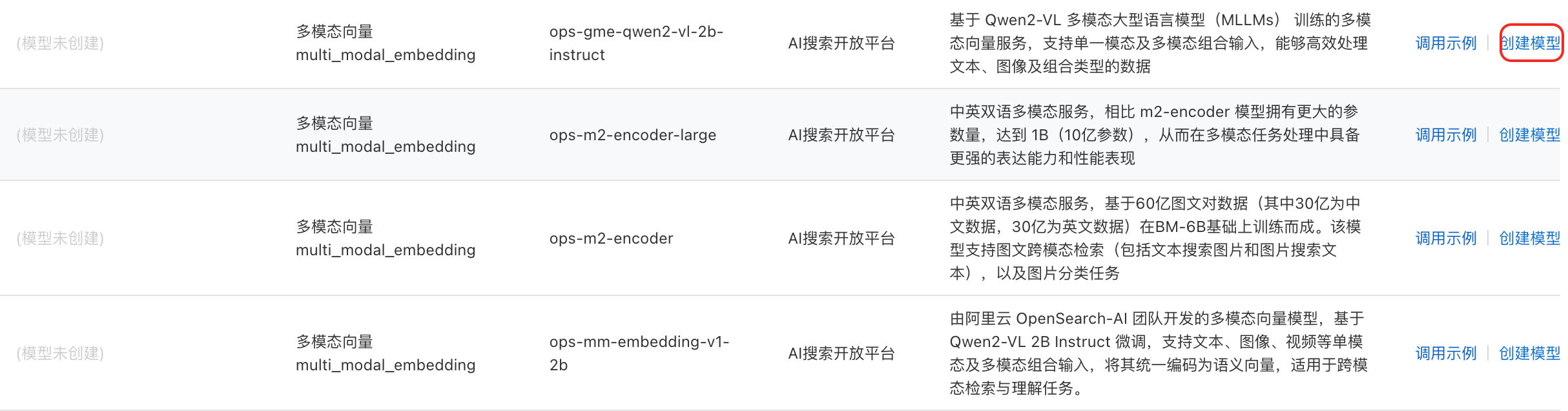

如果初始化后提示您存在未创建的模型,单击任一模型右侧的创建模型系统自动创建所有AI模型服务。

如果初始化后提示您存在未创建的模型,单击任一模型右侧的创建模型系统自动创建所有AI模型服务。

参数

说明

模型服务空间

数据隔离单元。首次开通AI搜索开放平台自动创建默认空间default,支持创建自定义空间,请参见创建空间。

API Key

调用身份认证凭证,如何获取请参见管理API Key。

接入地址

ES实例优先提供私有网络下的AI模型接入地址。位于杭州、深圳、北京、张家口和青岛地区的ES实例,可以通过私有网络进行跨地域调用AI搜索开放平台的服务。如需使用公共网络调用AI搜索开放平台的服务,请参见获取公网服务接入地址。

自部署模型

在左侧导航栏,单击Elasticsearch实例。

进入目标实例。

在顶部菜单栏处,选择资源组和地域。

在Elasticsearch实例中单击目标实例ID。

在左侧导航栏,选择。

开通AI搜索开放平台,并在AI搜索开放平台中进行服务部署,以及创建

API Key。

在模型管理页面,选择 AI搜索开放平台模型 > 自部署模型 ,点击创建模型。

查看调用AI模型需要的参数信息。

说明获取Token:获取对应区域的私网访问token。

在ES实例中调用AI搜索开放平台自部署模型的具体方案,请参见通过Inference API创建自定义模型推理服务。

调用示例

注意事项

调用前提:请勿在AI搜索开放平台中删除或禁用模型调用信息,否则ES控制台中对应模型将失效。

跨境数据规范

数据流向:调用时业务数据将传输至中国上海区域处理。

您的责任:

确保传输符合所在地法律法规。

落实数据保护措施、提供隐私声明、获取必要授权。

保证数据内容合法合规。

责任声明:如因您违反前述声明与保证,导致阿里云和/或其关联公司遭受任何损失,您应承担相应的赔偿责任。

数据解析模型

文档内容解析

POST _inference/doc_analyze/<inference_id>

{

"input": ["http://opensearch-shanghai.oss-cn-shanghai.aliyuncs.com/chatos/rag/file-parser/samples/GB10767.pdf"], # 可以是url, content or task_id

"task_settings": {

"document": {

"input_type": "url", # optional, url, content or task_id, default url. 为task_id时查询异步task结果

"file_name": "<file_name>", # optional, url无法推断时上传

"file_type": "<file_type>", # optional, file_name无法推断时上传

},

"output": {

"image_storage" : "<image_storage>" # optional, default base64

},

"is_async" : "<true or false>", # 默认false

}

}图片内容提取

POST _inference/img_analyze/<inference_id>

{

"input": ["https://img.alicdn.com/imgextra/i1/O1CN01WksnF41hlhBFsXDNB_!!6000000004318-0-tps-1000-1400.jpg"], # 可以是url, content or task_id

"task_settings": {

"document": {

"input_type": "url", # optional, url, content or task_id, default url

"file_name": "<file_name>", # optional, url无法推断时上传

"file_type": "<file_type>", # optional, file_name无法推断时上传

},

"is_async" : "<true or false>" # 默认false

}

}文档切片

POST _inference/doc_split/<inference_id>

{

"input":"<input>"

}向量化模型

文本向量

POST _inference/text_embedding/<inference_id>

{

"input":[<input>]

}文本稀疏向量

POST _inference/sparse_embedding/<inference_id>

{

"input":[<input>]

}排序

排序

POST _inference/rerank/<inference_id>

{

"input": [<input_list>],

"query": "<query>"

}大语言模型

查询分析

POST _inference/query_analyze/<inference_id>

{

"input":"<input>",

"task_settings": {

"history": [

{

"content": "<history.content>",

"role": "<history.role>"

},

{

"content": "<history.content>",

"role": "<history.role>"

}

]

}

}内容生成

POST _inference/completion/<inference_id>

{

"input":["<input>"]

}更多Inference API调用示例请参见AI搜索开放平台内置模型服务。