您可以将AI搜索开放平台、ModelScope与定制模型中的模型进行独立部署,提供更高并发、更低延迟的推理服务。

模型列表

模型类别 | 模型名称 | 模型来源 |

文本向量化 |

模型调用请参见:文本向量。 | AI搜索开放平台 |

GTE多语言通用文本向量模型:上下文最大token长度8192,支持70多种语言。 | ModelScope | |

在模型定制中自主训练的文本向量化模型。 | 模型定制 | |

排序服务 |

模型调用请参见:排序服务。 | AI搜索开放平台 |

多模态向量化 |

| ModelScope |

计费规则

计费公式为:CU单价*机型消耗的CU数量*购买机器台数

具体计费规则如下表所示:

机型 | CU单价(元/小时) | 单台机器消耗CU数量 | 单台机器单价(元/小时) |

gpu.v100.16g.x1 | 1.07 | 30.14 | 32.25 |

gpu.t4.16g.x1 | 16.07 | 17.195 | |

gpu.a10.24g.x1 | 11.01 | 11.781 |

例如某用户购买2台gpu.a10.24g.x1部署模型服务,计费为:1.07*11.01*2=23.56元/小时。

部署服务

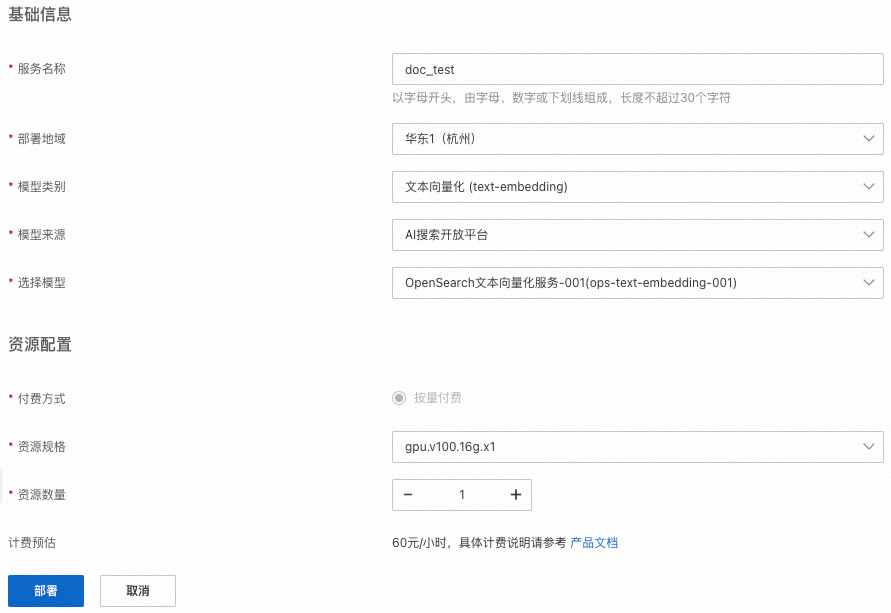

在AI搜索开放平台选择模型服务>服务部署,然后单击部署服务。

如通过RAM账号进行服务创建、变更、查看服务详情等操作时,需要提前授予RAM账号模型服务-服务部署相关的操作权限。

在部署服务页面,配置服务名称、部署地域等信息。

目前支持的部署地域为:华东1(杭州)、华东2(上海)、华南1(深圳)、华北2(北京)、华北3(张家口)。

资源规格:模型部署使用的机型。

计费预估:模型部署消耗的费用。

单击部署,系统开始部署服务。服务状态说明:

部署中:系统正在部署服务,服务暂不可用。在服务列表单击管理查看服务详情、单击删除删除部署任务。

正常:表示部署成功。在服务列表单击管理查看服务详情,在服务详情页通过更改配置更改服务的资源配置;在服务列表单击删除删除服务。

部署失败:可以查看部署详情、重新部署、删除部署任务。

查看服务调用信息

登录AI搜索开放平台,选择模型服务>服务部署,在服务列表中单击管理:

服务ID:通过SDK调用服务时,需要此参数。

公网和私网API域名:可选择通过公网或者私网地址调用模型服务。

Token:服务调用时的凭证。分为公网Token和私网Token,通过公网或者私网地址调用服务时,需填入对应的Token。

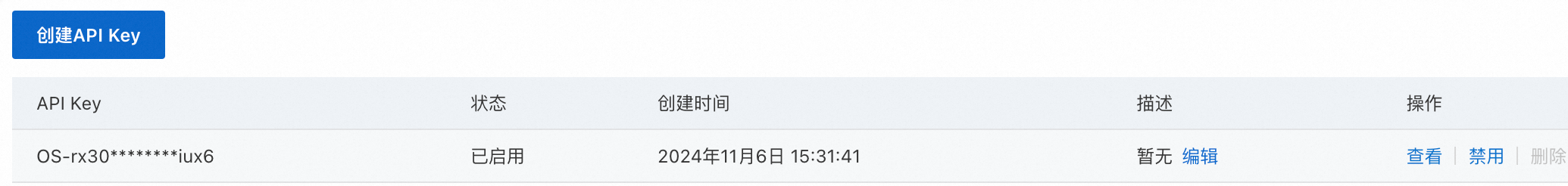

API-KEY:通过API-KEY实现服务调用时的身份认证。

测试服务

通过curl命令测试模型服务时,需要传入API-KEY、Token信息。

执行以下代码调用文本向量化模型对输入内容“科学技术是第一生产力”和“opensearch产品文档”进行向量化:

curl -X POST \

-H "Content-Type: application/json" \

-H "Authorization: Bearer 您的API-KEY" \

-H "Token: NjU0ZDkzYjUwZTQ1NDI1OGRiN2ExMmFmNjQxMDYyN2M5*******==" \

"http://default-0fm.platform-cn-hangzhou.opensearch.aliyuncs.com/v3/openapi/deployments/******_1zj19x_1yc/predict" \

-d '{

"input": [

"科学技术是第一生产力",

"opensearch产品文档"

],

"input_type": "query",

"dimension" : 567 # 部署的为定制模型并开启向量降维时,才会生效,且维度不能大于基础模型的维度

}'

正确返回结果:

{

"embeddings": [

{

"index": 0,

"embedding": [

-0.028656005859375,

0.0218963623046875,

-0.04168701171875,

-0.0440673828125,

0.02142333984375,

0.012345678901234568,

...

0.0009876543210987654

]

}

]

}通过SDK调用服务

测试通过后,接下来您可以参照以下Python SDK调用示例,在业务系统中集成SDK实现服务调用。

import json

from alibabacloud_tea_openapi.models import Config

from alibabacloud_searchplat20240529.client import Client

from alibabacloud_searchplat20240529.models import GetPredictionRequest

from alibabacloud_searchplat20240529.models import GetPredictionHeaders

from alibabacloud_tea_util import models as util_models

if __name__ == '__main__':

config = Config(bearer_token="API-KEY",

# endpoint配置统一的请求入口,去掉http://或者https://

endpoint="default-xxx.platform-cn-shanghai.opensearch.aliyuncs.com",

# protocol支持HTTPS和HTTP

protocol="http")

client = Client(config=config)

# --------------- 请求体参数 ---------------

request = GetPredictionRequest().from_map({"body":{"input_type": "document", "input": ["搜索", "测试"]}})

headers = GetPredictionHeaders(token="xxxxxxxxYjIyNjNjMjc2MTU1MTQ3MmI0ZmQ3OGQ0ZjJlMjxxxxxxxx==")

runtime = util_models.RuntimeOptions()

# deploymentId:部署id

response = client.get_prediction_with_options("已部署服务的服务ID" ,request, headers, runtime)

print(response)