基于LangStudio的“IQS联网搜索聊天助手”模板,开发者可快速构建集成阿里云实时搜索功能的AI应用,通过联网数据增强回答准确性,开发者可以基于该模板进行灵活扩展和二次开发,以满足特定场景的需求。

准备工作

1. 部署LLM模型服务

IQS联网搜索聊天助手应用流需要用到LLM模型服务,若您已有支持OpenAI API的LLM模型服务,可跳过此步骤,直接使用现有服务。

本文以使用EAS部署的DeepSeek-R1大模型服务为例。您可以前往快速开始 > Model Gallery进行部署。更多部署详情,请参见一键部署DeepSeek-V3、DeepSeek-R1模型、模型部署及训练。

2. 开通阿里云信息查询服务

IQS联网搜索聊天助手应用流需要使用阿里云信息查询服务中的通用搜索功能,对指定的查询语句进行检索。

请确认已开通阿里云信息查询服务,详情请参见快速入门。

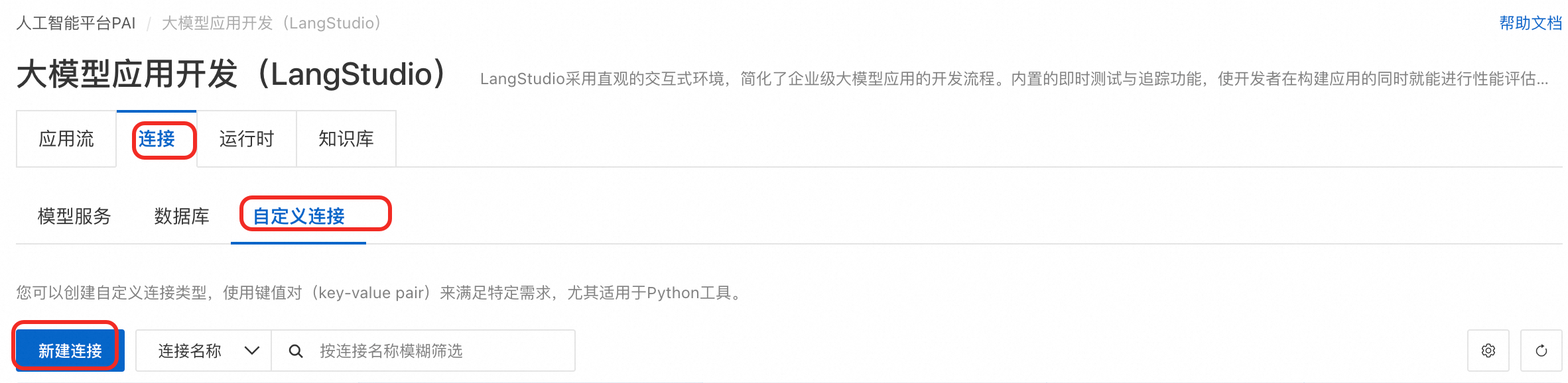

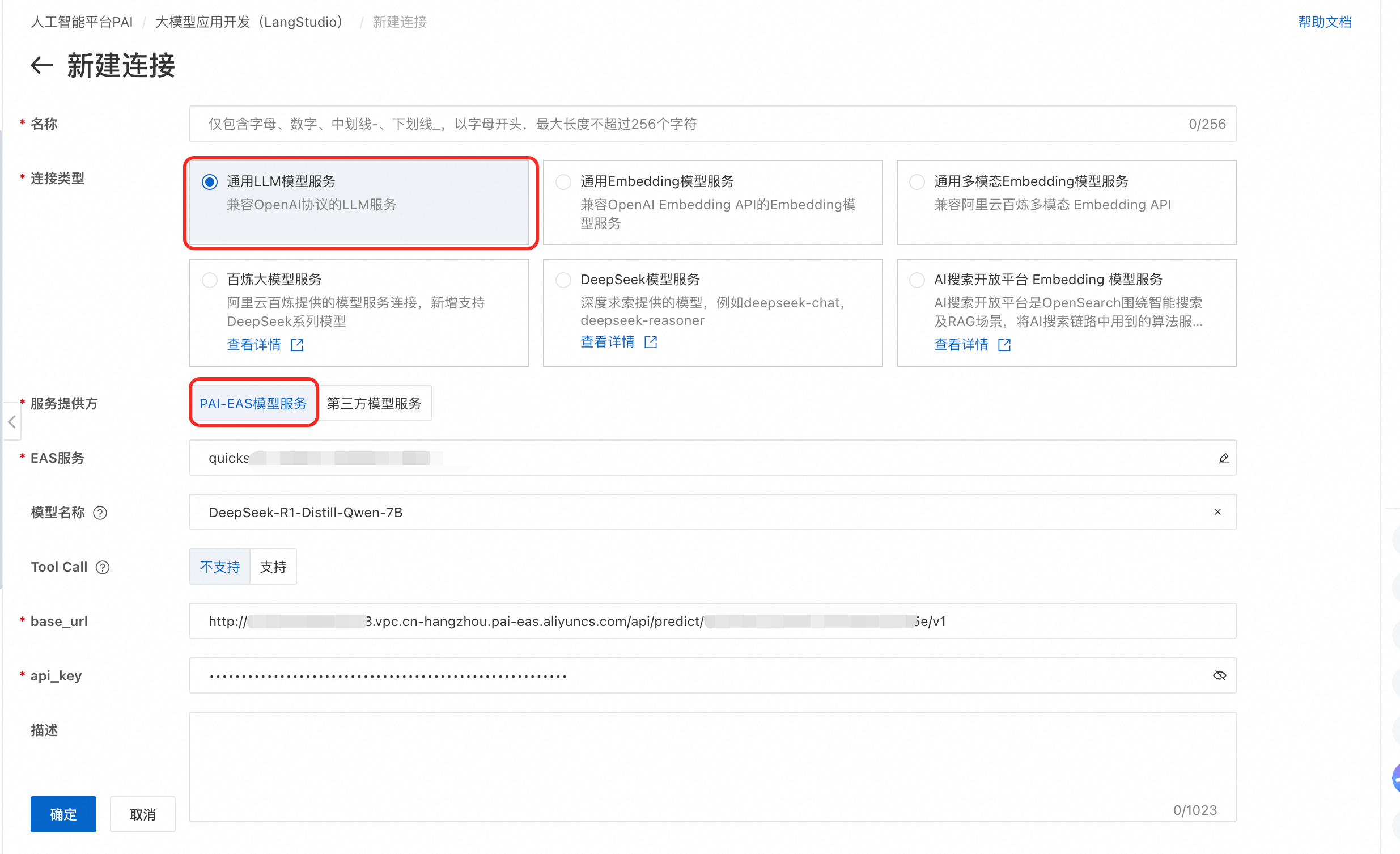

一、创建LLM服务连接

本文创建的LLM模型服务连接基于快速开始 > Model Gallery中部署的模型服务(EAS服务)。更多其他类型的连接及详细说明,请参见连接配置。

进入LangStudio,选择工作空间后,在连接 > 模型服务页签下单击新建连接,创建通用LLM模型服务连接。

关键参数说明:

参数 | 说明 |

服务提供方 |

|

模型名称 | 当通过Model Gallery进行模型部署时,可通过模型详情页(在Model Gallery页单击模型卡片)查看模型名称的获取方法,详情请参见创建连接-模型服务。 |

二、创建运行时(运行环境)

运行时(Runtime)使用的是PAI-DSW实例,为LangStudio应用流的开发与调试提供运行环境。

如您没有任何运行时,请参见下文新建。如您想使用已有的运行时,请根据下文确认配置符合条件。

在运行时页签下单击新建运行时。

关键参数说明:

运行时工作路径:路径需要与应用流的工作路径一致才能被绑定使用。建议您选择工作空间的默认存储路径作为运行时和应用流的工作路径。

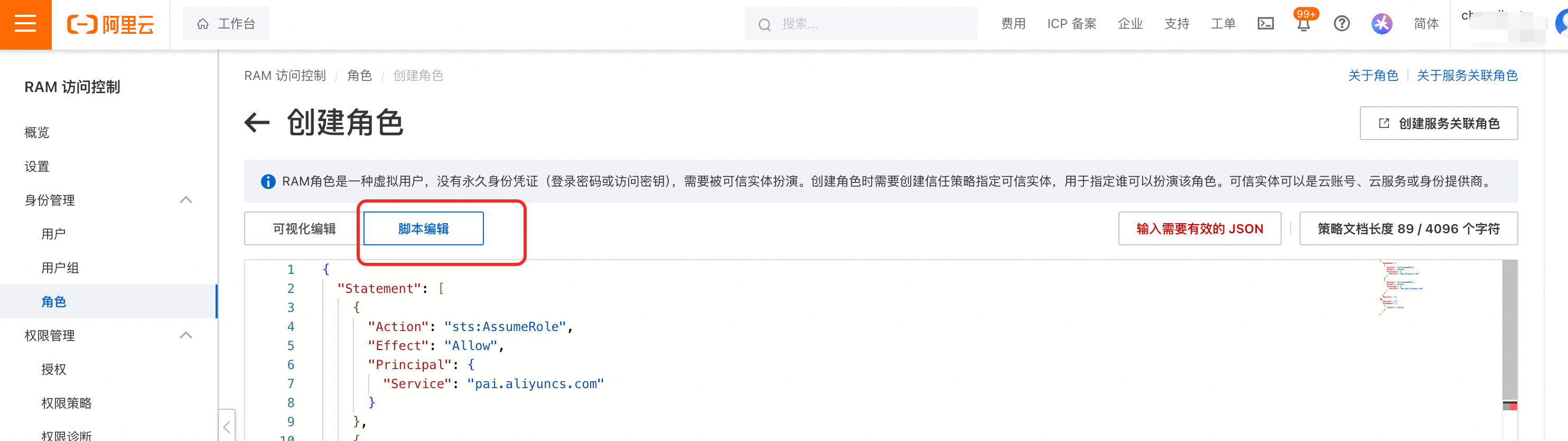

实例RAM角色:推荐选择自定义角色。

PAI默认角色(不推荐):使用PAI默认角色需通过

api_key使用IQS联网搜索功能(经公网,数据安全性低)。自定义角色(推荐):选择按照下文步骤创建的RAM角色,可以在VPC环境下通过RAM鉴权的方式使用IQS联网搜索(不经公网,数据更加安全)。

三、应用流开发

进入LangStudio,选择工作空间后,在应用流页签下单击新建应用流。

新建方式:从模板新建。

选择模版:IQS联网搜索聊天助手。

选择运行时:选择步骤二中创建的运行时。

工作路径:当选择运行时之后,默认填充工作路径。

在应用流页签,单击目标应用流,进入应用流详情页面。

关键节点配置如下(其余配置保持默认,更多节点组件详情,请参见附录:预置组件说明):

阿里云IQS-标准搜索:

时间范围:选择搜索数据的时间范围。

IQS连接:

如果按照步骤二要求给运行时使用RAM角色,此处无需配置。

如果运行时使用PAI默认角色,请配置IQS连接。在连接页签下,选择,自定义键填写

api_key,自定义值可通过信息查询服务-凭证管理查看。

大模型节点:调用大语言模型回答问题或对自然语言进行处理。

模型设置:选择一、创建LLM服务连接中创建的连接。

对话历史:是否启用对话历史,将历史对话信息作为输入变量。

调试/运行。单击右上角运行,开始执行应用流。关于应用流运行时的常见问题,请参见常见问题。

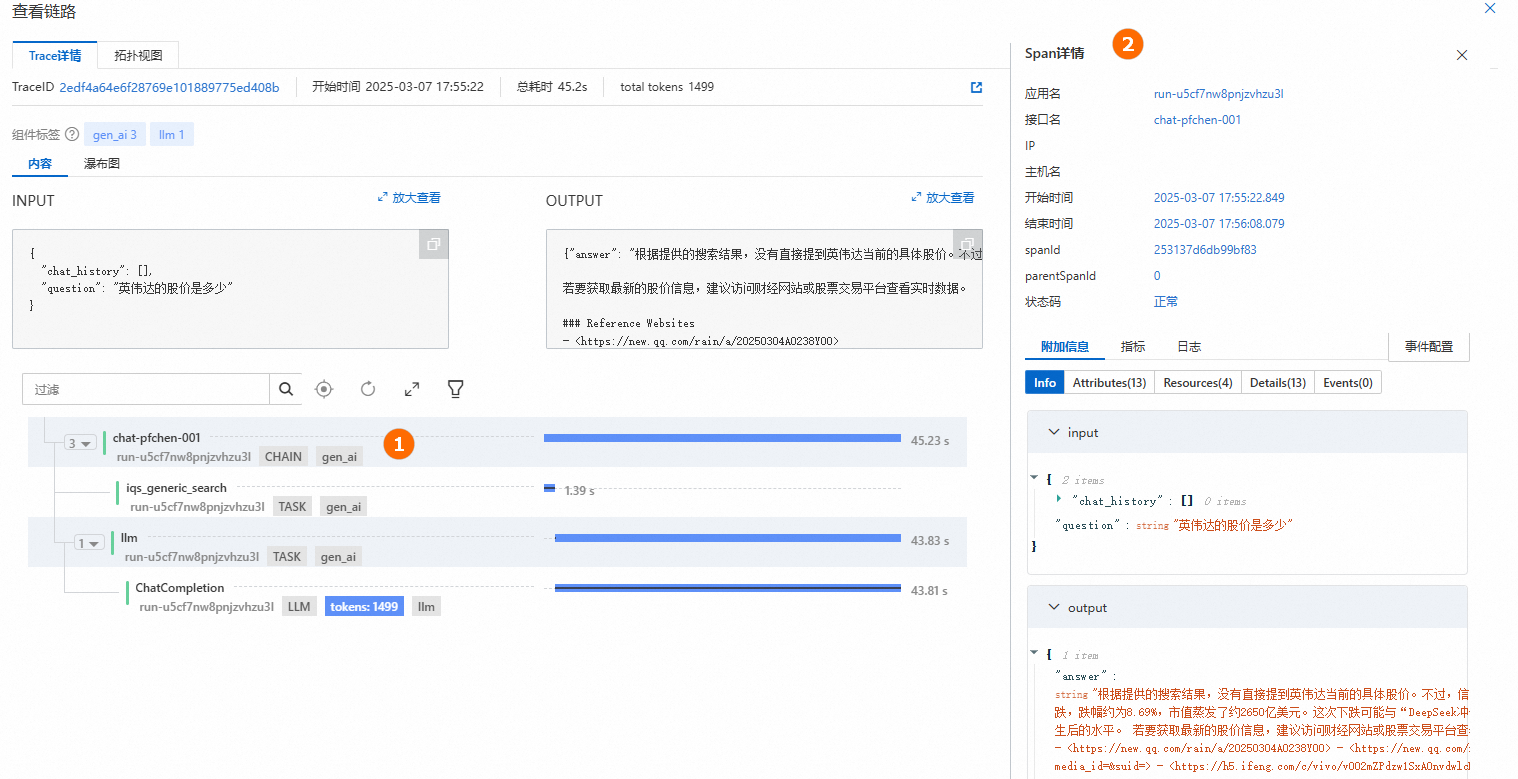

查看链路:单击生成答案下的查看链路,查看Trace详情或拓扑视图。

四、部署应用流

在应用流开发页面,单击右上角部署,将应用流部署为EAS服务。部署参数其余配置保持默认或根据实际需求进行配置,关键参数配置如下:

资源信息 > 实例数:配置服务实例数。本文部署仅供测试使用,因此实例数配置为1。在生产阶段,建议配置多个服务实例,以降低单点故障的风险。

专有网络 > 专有网络 (VPC):由于搜索功能依赖于阿里云信息查询服务,其支持VPC访问的地域可参见服务接入点,对于不支持 VPC 访问的地域,会自动使用张家口公网地址。因此如果您的应用流不在这些地域,则需要配置具备公网访问能力的VPC(EAS服务默认不可访问公网),详情请参见配置公网连接。

角色与权限 > 实例RAM角色:与运行时实例RAM角色配置保持一致。

更多部署详情,请参见应用流部署。

五、调用服务

部署成功后,跳转到PAI-EAS,在在线调试页签下配置并发送请求。请求Body中的Key与应用流中“开始节点”中的参数"对话输入"字段需一致,本文使用默认字段question。

更多调用方式(如API调用)及详细说明,请参见应用流部署-调用服务。

六、资源清理

开发结束,请注意停止或删除运行时,以免不必要的计费。详情请参见运行时管理。

如您部署了EAS模型服务,后续不再使用,请注意清理:

使用公共资源部署,停止/删除服务,防止持续计费。

使用后付费机器部署,需删除机器后付费机器资源才可停止计费。

相关文档

应用流正式部署到生产环境前,您还可以进行应用流评测。

如果需要对模板进行二次开发,可参见应用流开发。

使用LangStudio的计费详情,请参见大模型应用开发(LangStudio)计费说明。