为集中接入Azure日志并实现统一标准化解析与威胁检测,需将数据导入云安全中心(Agentic SOC),提升多云安全运营效率。通过Azure Event Hub的Kafka兼容能力,以接入点、Topic和主连接字符串认证消费日志,并在云安全中心配置导入任务、目标Logstore及解析检测规则。

工作原理

本方案利用Azure事件中心对Apache Kafka协议的兼容性,将事件中心模拟为一个Kafka服务。云安全中心作为Kafka客户端,通过指定的接入点、Topic和认证信息,从事件中心获取日志数据,进行统一的标准化解析和威胁检测。配置流程如下:

在Azure准备事件中心(Event Hub)

详细指引请参考Azure官方文档:使用 Azure 门户创建事件中心。

步骤一:创建资源组

登录Azure控制台。

在左侧导航栏中,选择资源组,然后选择创建。

创建资源组页面填写配置信息后,单击查看 + 创建。

订阅:请选择要在其中创建资源组的 Azure 订阅的名称。

资源组名称: 自定义资源组唯一名称。

区域:选择资源组所在的区域。

确认信息后,单击创建。

步骤二:创建Event Hub命名空间

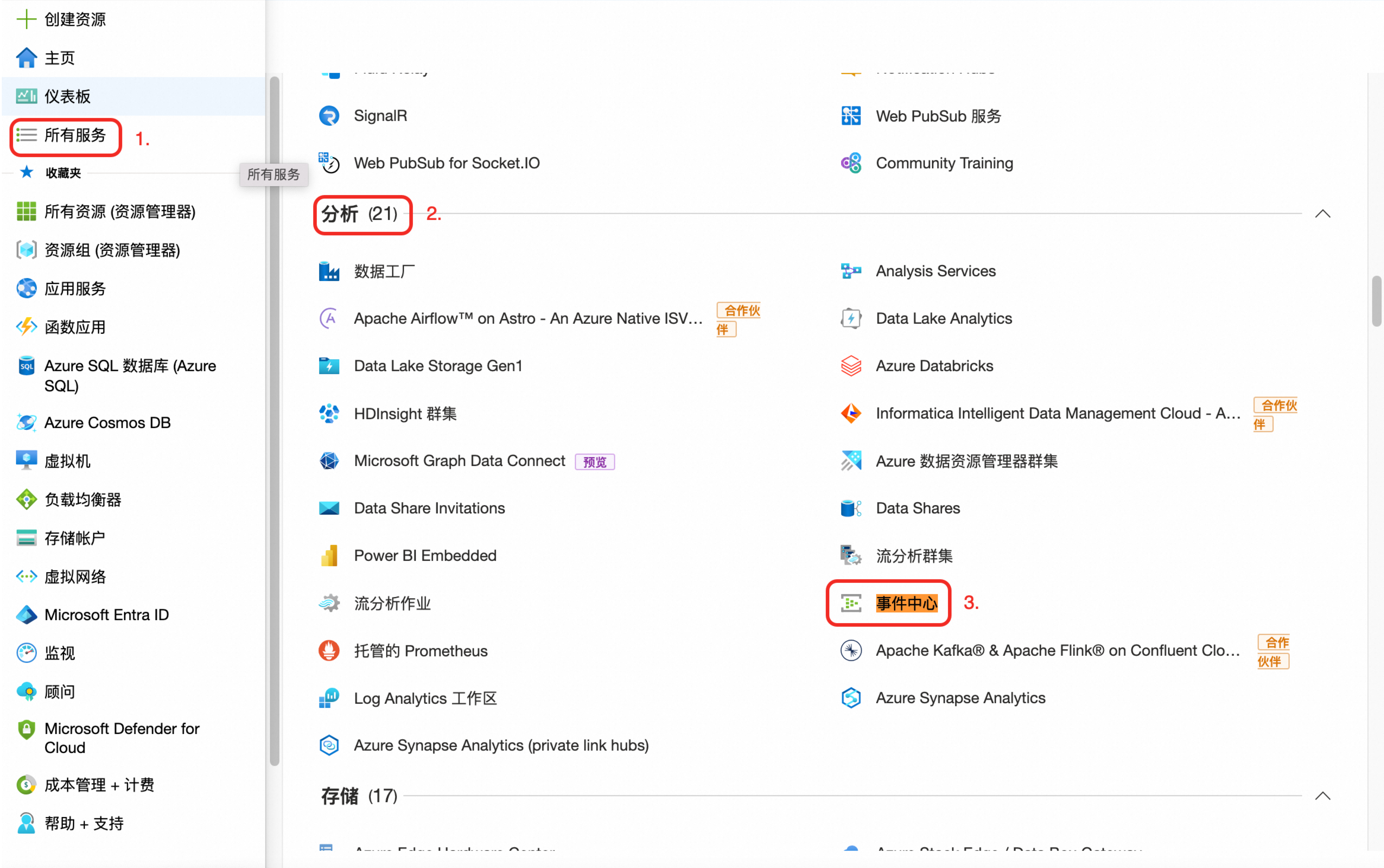

在左侧导航栏中,选择所有服务。在分析服务区域,单击事件中心。

在事件中心页面,单击创建并参照如下说明,填写配置信息。

订阅:选择步骤一中填写的订阅名称

资源组:选择在步骤一中创建的资源组。

命名空间名称:自定义命名空间的名称,输入框右下角即为空间访问地址(Kafka 接入点的服务地址)。

区域:选择在步骤一中创建的资源组所在区域。

定价层:根据业务需求配置,默认选择基本 。若需将 Azure 事件中心命名空间的访问权限限制为仅 Agentic SOC 可访问,请选择标准层、高级层或专用层,更多操作,请参见配置事件中心白名单(可选)。

吞吐量单位/处理单元(高级层):保持默认配置即可。

说明更多吞吐量单位或处理单位说明,请参见事件中心的可伸缩性。

自动扩充:根据业务需求,决定是否启用此功能。

在网络页签,选择网络连接方式为公共访问,然后单击页面底部审阅 + 创建。

重要在Azure中配置网络白名单,可实现Agentic SOC对Event Hub命名空间的专属访问。具体操作,请参见配置事件中心白名单(可选)。

确认配置信息无误后,单击创建并等待部署完成。

在部署完成页,单击转到资源,可跳转至命名空间详情页。

说明在事件中心首页列表中,单击空间名称,查看并进入命名空间详情页。

步骤三:创建事件中心

在步骤二创建的命名空间详情页,单击+ 事件中心。

在创建页填写下拉信息后,单击审阅 + 创建。

名称:自定义Event Hub的名称。

重要Event Hub名称即为后续配置Kafka时对应的Topic,请设置具有代表性且易于查找理解的名称。

其余配置:保持默认即可。

在信息确认页,单击创建后,等待创建任务完成。

返回命名空间首页,可在事件中心区域查看新建的数据。

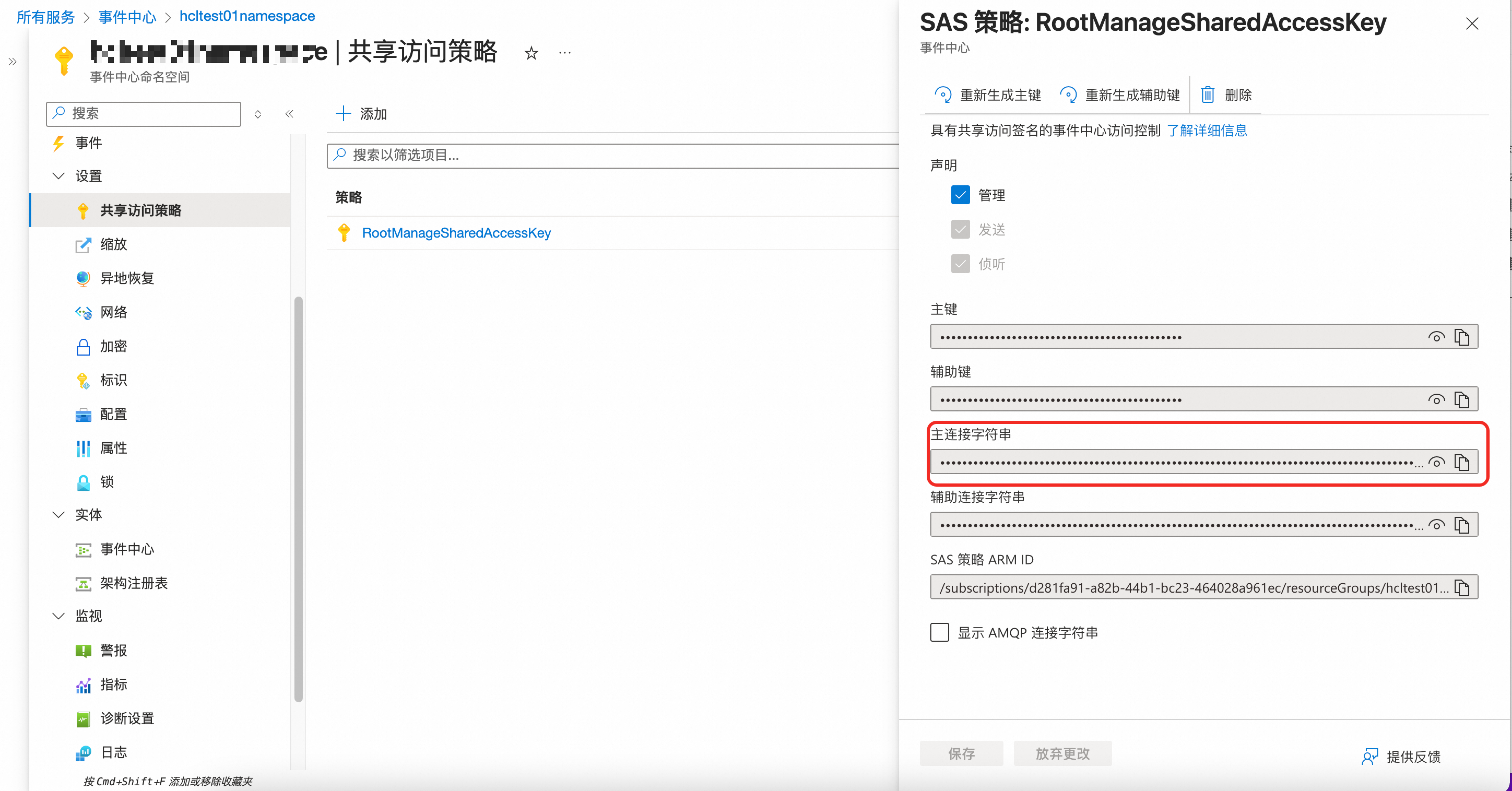

步骤四:获取主连接字符串

在命名空间页面,单击左侧设置下的共享访问策略。

单击主策略

RootManageSharedAccessKey名称,在策略详情面板,复制主连接字符串。重要主连接字符串将在后续导入配置 Kafka时,作为身份验证凭据(即密码)使用。

步骤五:向事件中心写入数据

请参考Azure官方文档说明,将需要分析的数据写入步骤三创建的事件中心。参考文档如下:

在云安全中心配置数据导入

步骤一:授权云安全中心访问Event Hub

访问云安全中心控制台-Agentic SOC-接入中心,在页面左侧顶部,选择需防护资产所在的区域:中国内地或非中国内地。

在多云配置管理页签,选择多云资产后,单击新增授权,下拉选择IDC。在弹出的面板中进行如下配置:

配置同步策略

AK服务状态检查:不涉及,跳过即可。

步骤二:创建数据导入任务

创建数据源

为Azure日志数据创建一个数据源,若已创建请跳过此步骤。

访问云安全中心控制台-Agentic SOC-接入中心,在页面左侧顶部,选择需防护资产所在的区域:中国内地或非中国内地。

在数据源页签,创建接收日志的数据源。具体操作请参见创建数据源:日志未接入日志服务(SLS)。

源数据源类型:可选择Agentic SOC专属数据采集通道(推荐)或用户侧日志服务。

接入实例:建议新建日志库(Logstore),进行数据隔离。

在数据导入页签,单击新增数据导入。在弹出的面板中进行如下配置:

数据源类型:Kafka。

终端节点:

<YOUR-NAMESPACE>.servicebus.windows.net:9093,其中<YOUR-NAMESPACE>为事件中心的命名间名称。Topics:即为创建事件中心时设置的Event Hub的名称。

值类型:json。

配置目标数据源

数据源名称:选择在本节创建数据源步骤中创建的数据源。

目标Logstore:选择在本节创建数据源步骤中设置的日志库(Logstore)。

单击确定保存配置:导入配置完成后,云安全中心将自动从Azure Event Hub获取日志。

配置事件中心白名单(可选)

基础层不支持配置网络白名单。

详细指引请参考Azure官方文档:为现有命名空间配置 IP 防火墙。

在Event Hub命名空间的左侧菜单中,单击设置菜单下的网络。

在网络页的公共访问页签,单击Public network access区域的Manage按钮。

在公用网络访问配置页面的Default action区域,勾选Enable from selected networks。

在IP Addresses区域,填写需要加白的IP地址,单击保存(Save)。操作示例和白名单地址如下:

日志存储Project地域IP:

地域

VPC IP地址白名单

公网IP地址白名单

华东1(杭州)

100.104.0.0/16

114.55.8.190

47.99.57.53

114.55.85.98

47.99.212.49

120.26.169.131

118.178.236.24

47.98.173.126

华东2(上海)

100.104.0.0/16

101.133.151.144

47.102.141.56

106.15.248.175

47.102.99.12

华东5(南京-本地地域-关停中)

100.104.0.0/16

47.122.0.130

华北1(青岛)

100.104.0.0/16

47.104.146.34

120.27.20.55

华北2(北京)

100.104.0.0/16

59.110.6.146

39.105.19.110

47.93.61.189

182.92.187.76

华北3(张家口)

100.104.0.0/16

8.142.80.93

47.92.90.166

8.142.152.234

39.100.37.56

华北5(呼和浩特)

100.104.0.0/16

39.104.61.213

华北6(乌兰察布)

100.104.0.0/16

8.130.10.99

39.101.66.131

华南1(深圳)

100.104.0.0/16

120.76.47.88

119.23.150.175

华南2(河源)

100.104.0.0/16

47.113.195.162

47.113.192.163

华南3(广州)

100.104.0.0/16

8.134.56.134

西南1(成都)

100.104.0.0/16

47.108.26.166

中国(香港)

100.104.0.0/16

8.210.69.249

47.52.240.106

新加坡

100.104.0.0/16

47.241.44.82

47.88.153.120

韩国(首尔)

100.104.0.0/16

8.213.130.255

日本(东京)

100.104.0.0/16

47.74.56.187

马来西亚(吉隆坡)

100.104.0.0/16

47.254.195.145

印度尼西亚(雅加达)

100.104.0.0/16

149.129.233.70

菲律宾(马尼拉)

100.104.0.0/16

8.212.131.139

泰国(曼谷)

100.104.0.0/16

8.213.194.187

德国(法兰克福)

100.104.0.0/16

47.91.76.65

47.91.89.173

英国(伦敦)

100.104.0.0/16

8.208.86.103

8.208.3.16

美国(弗吉尼亚)

100.104.0.0/16

47.253.208.218

47.90.252.237

美国(硅谷)

100.104.0.0/16

47.88.8.7

47.88.7.168

Agentic SOC地域IP:

地域

公网IP地址白名单

中国内地

106.14.241.32

非中国内地

8.222.217.173

分析导入数据

数据成功接入后,需配置相应的解析和检测规则,才能让云安全中心对这些日志进行分析。

创建新的接入策略

参考产品接入,创建新的接入策略,配置如下:

数据源:选择数据导入任务中配置的目标数据源。

标准化规则:Agentic SOC提供了适配部分云产品的内置标准化规则,可直接选用。

标准化方式:当接入日志标准化为告警日志时,仅支持“实时消费”方式标准化。

配置威胁检测规则

根据安全需求,在规则管理中启用或创建日志检测规则,才能对日志进行分析、产出告警并生成安全事件。具体操作,请参见规则管理。

费用与成本

本方案会涉及以下服务的费用,实施前请仔细阅读各产品的计费文档,做好成本预估。

Azure侧:事件中心定价。

阿里云侧:费用组成取决于选择的数据存储方式。

说明Agentic SOC计费说明,请参见Agentic SOC包年包月、Agentic SOC按量付费。

日志服务(SLS)计费说明,请参见计费概述。

数据源类型

Agentic SOC 计费项

SLS 计费项

特别说明

Agentic SOC专属数据采集通道

日志接入费用。

日志存储、写入费用。

说明以上均消耗日志接入流量。

除日志存储和写入外的其他费用(如公网流量等)。

由Agentic SOC 创建并管理 SLS 资源,因此日志库存储和写入费用由Agentic SOC出账。

用户侧日志服务

日志接入费用,消耗日志接入流量。

日志相关所有费用(包含日志存储和写入、公网流量费用等)。

日志资源全部由日志服务(SLS)管理,因此日志相关费用,均由SLS出账。