本文基于三种AI 模型接入场景,介绍如何通过AI 网关快速实现第三方 DeepSeek 模型的统一接入。

场景概览

场景 | 描述 |

支持通过选择已集成的部分大模型供应商及配置 API-KEY 的方式直接接入使用。 | |

支持通过配置自定义AI 服务地址且满足 OpenAI 接入标准的AI 服务。 | |

支持通过网关已集成的部分大模型供应商和配置自定义AI 服务地址接入使用。 |

前提条件

创建专有网络VPC并绑定公网NAT网关,具体操作请参见创建和管理专有网络和使用公网NAT网关SNAT功能访问互联网。

基于上述VPC创建AI 网关实例,具体操作请参见创建网关实例。

场景一:集成模型接入AI 网关

当前AI 网关中已经集成部分大模型供应商,该类模型可通过选择供应商及配置 API-KEY 直接接入。

1. 创建AI 服务

登录AI网关控制台。

在左侧导航栏,选择实例,并在顶部菜单栏选择地域。

在实例页面,单击目标实例ID。

在左侧导航栏,单击服务,并单击服务页签。

单击创建服务,在创建服务面板,参考如下信息配置AI 服务,以阿里云百炼配置示例。

服务来源:AI服务。

服务名称:填写创建网关服务的名称,如aliyun-deepseek。

大模型供应商:选择对应的模型供应商,如阿里云百炼。

服务地址(base_url):使用阿里云百炼默认配置,如https://dashscope.aliyuncs.com/compatible-model/v1。

API-KEY:填写模型供应商获取的请求凭证 API-KEY 。

说明如果使用阿里云百炼,请在阿里云百炼API-KEY 获取。其他大模型供应商,请咨询对应的服务供应商。

2. 创建Model API

登录AI网关控制台。

在左侧导航栏,选择实例,并在顶部菜单栏选择地域。

在实例页面,单击目标实例ID。

在左侧导航栏,单击Model API,然后单击创建Model API。

在创建Model API面板中,配置基本信息如下:

域名:建议配置域名(使用默认环境域名下存在限流)。

Base Path:API的基本路径。

AI请求观测:开启。

服务模型:单模型服务。

服务列表:配置如下:

服务名称:选择上一步中配置的阿里云百炼 DeepSeek 服务。

模型名称:选择透传。

3. 调试Model API

登录AI网关控制台。

在左侧导航栏,选择实例,并在顶部菜单栏选择地域。

在实例页面,单击目标实例ID。

在左侧导航栏,选择Model API,单击目标 Model API 操作列下的调试。在调试面板中,配置相关参数进行调试。

模型选择为deepseek-r1,在右侧模型返回页签下与阿里云百炼的 DeepSeek 进行对话。

重要在模型返回页签下,使用的是

/v1/chat/completions对话接口,如需使用其他接口,您可选择CURL命令或原始输出的方式通过 curl 、SDK 调试。

场景二:通用模型方式接入AI 网关

您可通过自定义服务地址方式,将通用模型接入AI 网关且支持如下情况。

对于AI 网关中未集成大模型供应商,且该模型支持 OpenAI 协议。

对于通过在阿里云人工智能平台PAI 或者函数计算FC等方式部署的 DeepSeek 服务。

本场景,可直接参考通过AI 网关接入PAI部署模型进行接入。

场景三:AI 网关多模型代理

1. 创建AI 服务

当前AI 网关支持同时基于已集成模型和通用模型的方式接入,提供多模型代理服务,并支持调用异常情况下 Fallback 。在该场景下,用户使用统一调用方式,同时调用不同的三方模型服务。

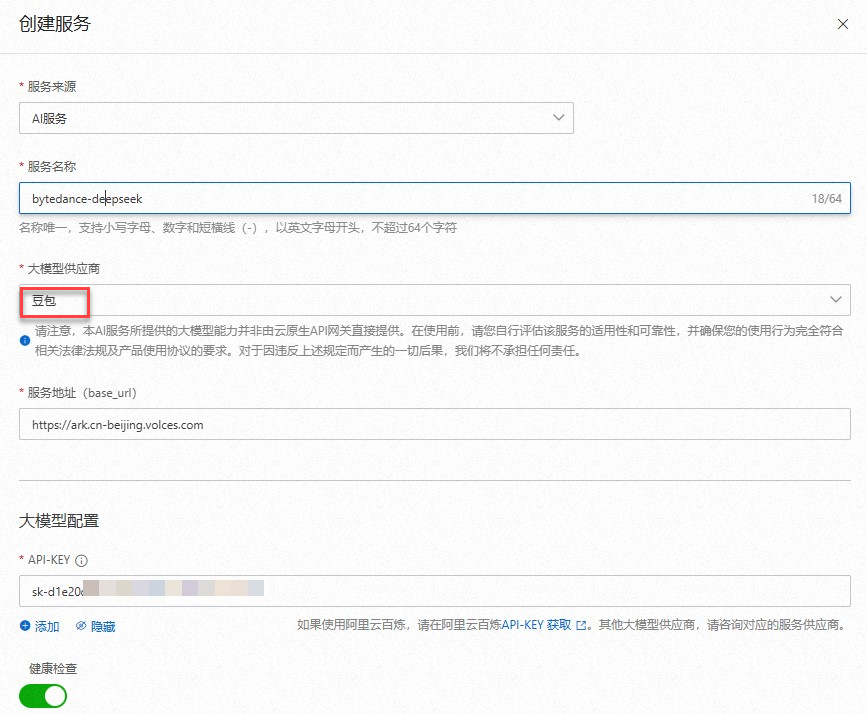

基于场景一、场景二分别完成三个网关AI 服务配置(阿里云百炼、火山引擎、PAI),火山引擎的服务配置可参考图示配置。

2. 创建Model API

登录AI网关控制台。

在左侧导航栏,选择实例,并在顶部菜单栏选择地域。

在实例页面,单击目标实例ID。

在左侧导航栏,单击Model API,然后单击创建Model API。

在创建Model API面板中,配置基本信息如下:

服务模型:多模型服务(按模型名称)。

服务列表:添加下列多个服务。

选择上一步中配置的阿里云 DeepSeek 服务,模型名称匹配规则配置为

deepseek-*。选择上一步中配置的火山引擎 DeepSeek 服务,模型名称匹配规则配置为

ep-*。

Fallback:开启。

Fallback列表: 选择上一步中配置的 PAI DeepSeek 服务,模型名称配置为

DeepSeek-R1-Distill-Qwen-1.5B。

说明

说明如上图所示的配置会按照下列规则执行:

模型为deepseek-*时调用阿里云 DeepSeek 。

模型为ep-*时调用火山引擎 DeepSeek 。

在其他模型出错或限流场景下调用 PAI DeepSeek-R1-Distill-Qwen-1.5B(如配置多个Fallback,则按顺序调用)。

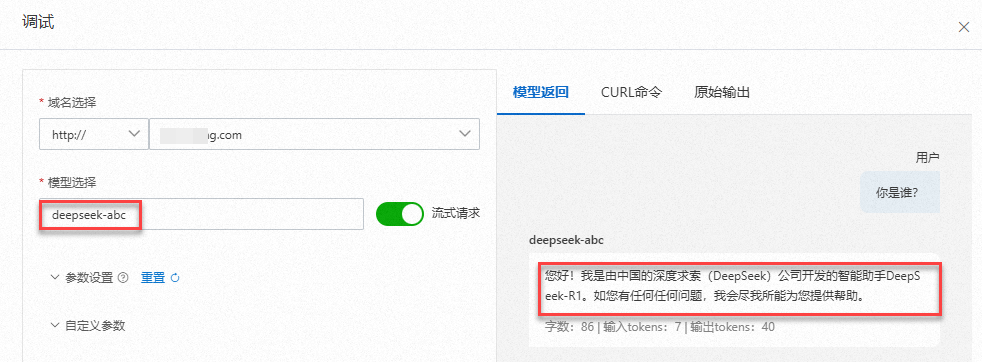

3. 调试Model API

单击目标 Model API 操作列下的调试。在调试面板中,配置相关参数进行调试。

模型选择为

deepseek-v3、ep-20250219155230-28l6f(以火山引擎侧实际获取的模型为准)时,会按照规则响应阿里云百炼、火山引擎。重要在模型返回页签下,使用的是

/v1/chat/completions对话接口,如需使用其他接口,您可选择CURL命令或原始输出的方式通过 curl 、SDK 调试。

当配置一个匹配上述模型前缀但错误的名称,如

deepseek-abc,此时阿里云百炼不存在该模型。因此会触发 Fallback ,调用到PAI DeepSeek。