本文主要介绍如何通过AI 网关访问部署在人工智能平台PAI 的模型。

前提条件

当使用私网地址访问模型时,请确保AI 网关实例与人工智能平台PAI 部署的模型处于同一VPC。

操作步骤

步骤一:创建AI 服务

登录AI网关控制台。

在左侧导航栏,选择实例,并在顶部菜单栏选择地域。

在实例页面,单击目标实例ID。

在左侧导航栏,单击服务,并单击服务页签。

单击创建服务,在创建服务面板,参考如下信息配置AI 服务:

配置项

说明

服务来源

选择AI服务。

服务名称

填写创建网关服务的名称,如pai。

大模型供应商

选择AI 服务所提供的大模型供应商。本示例选择PAI-EAS。若无EAS通过PAI 部署模型,具体操作请参见一键部署模型。

工作空间

人工智能平台PAI工作空间,例如

pai_xqrj0u0t******。EAS服务

选择通过PAI 部署模型的名称,例如

Qwen3-32B。连接类型

选择与PAI 部署模型的连接类型,包含公网和私网两种。本示例选择私网。

API-KEY

已自动获取通过PAI 部署模型的API-KEY。

说明该API-KEY用于在AI 网关与PAI-EAS服务之间进行身份验证,AI 网关将自动获取API-KEY并与PAI-EAS服务建立通信。

健康检查

是否开启服务健康状态检查。

步骤二:创建Model API

步骤三:调试Model API

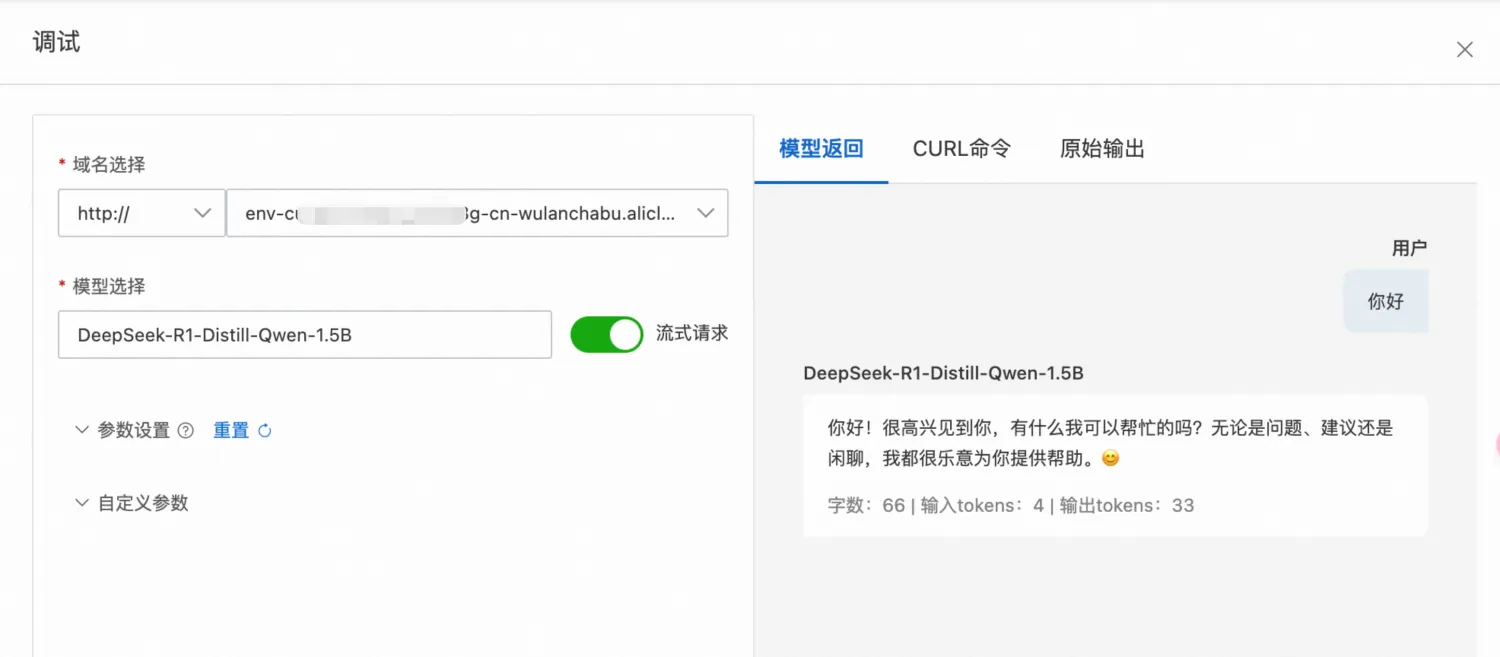

单击目标 Model API 操作列下的调试按钮进行测试。

在调试控制面板中,模型选择在PAI 中部署的模型,在右侧模型返回页签下与大模型进行对话。

重要在模型返回页签下,使用的是

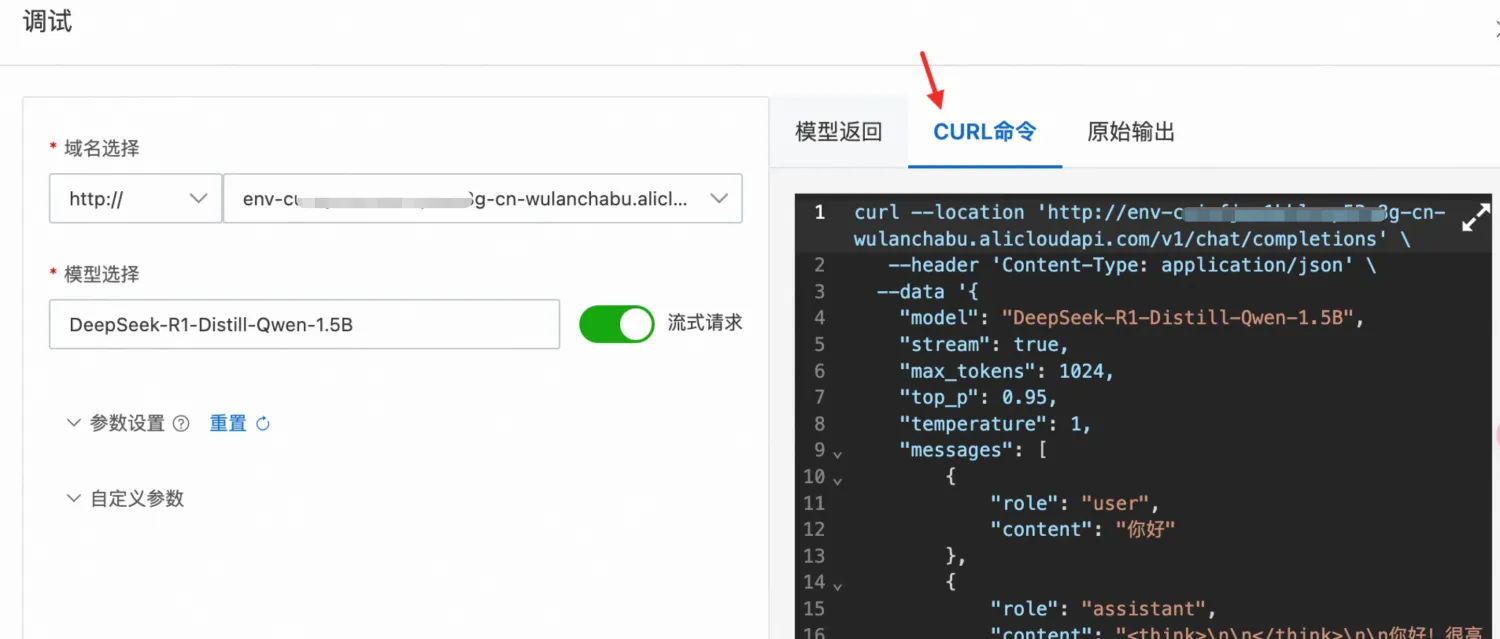

/v1/chat/completions对话接口,如需使用其他接口,您可选择CURL命令或原始输出的方式通过 curl 、SDK 调试。

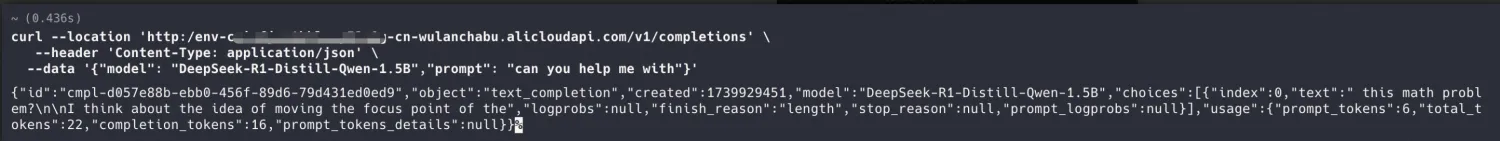

【示例】您可以使用CURL命令调用

completions,具体操作步骤如下:

在CURL命令页签下,复制AI 网关提供的代码示例。

将代码示例中提供的

url接口替换为/v1/completions。将代码示例中提供的

data(body)部分修改为/v1/completions需要的格式: