Data Studio是阿里巴巴基于十几年大数据经验打造的智能湖仓一体数据开发平台,支持阿里云多种计算服务,提供智能化ETL、数据目录管理及跨引擎工作流编排的产品能力。通过个人开发环境实例支持Python开发、Notebook分析与Git集成,Data Studio还支持丰富多样的插件生态,实现实时离线一体化、湖仓一体化、大数据AI一体化,助力“Data+AI”全生命周期的数据管理。

Data Studio 介绍

Data Studio是智能湖仓一体数据开发平台,内置阿里巴巴大数据建设方法论,深度适配阿里云MaxCompute、E-MapReduce、Hologres、Flink、PAI等数十种大数据和AI计算服务,为数据仓库、数据湖、OpenLake湖仓一体数据架构提供智能化ETL开发服务,它支持:

湖仓一体与多引擎支持

通过统一的数据目录和丰富的引擎节点,实现对湖(例如,OSS)仓(例如,MaxCompute)数据的无差别访问与多引擎混合开发。灵活的工作流与调度

提供丰富的流程控制节点,支持在工作流中对跨引擎任务进行可视化编排,并提供时间驱动的周期调度和事件驱动的触发式调度。开放的Data+AI开发环境

提供可自定义依赖的个人开发环境、支持SQL与Python混编的Notebook,并通过数据集、Git集成等功能,构建开放、灵活的AI研发工作站。智能辅助与AI工程化

内置强大的Copilot智能助手赋能代码开发全过程,并通过专业的PAI算法节点和大模型节点,为端到端的AI工程化提供原生支持。

Data Studio 基本概念

概念 | 专业术语 | 核心价值 | 关键词 |

工作流 | 任务的组织与编排单元 | 实现复杂任务的依赖管理与自动化调度,是开发和调度的“容器”。 | 可视化、DAG、周期/触发、编排 |

节点 | 工作流中的最小执行单元 | 编写代码、实现具体业务逻辑的地方,是数据处理的原子操作。 | SQL、Python、Shell、数据集成 |

自定义镜像 | 环境的标准化快照 | 保证环境的可拓展性、一致性与可复现性。 | 环境固化、标准化、可复制、一致性 |

调度 | 任务自动触发的规则 | 实现数据生产的自动化,将手动任务转化为可自动运行的生产力。 | 周期调度、触发式调度、依赖、自动化 |

数据目录 | 统一的元数据工作台 | 结构化组织和管理数据资产(如表)及计算资源(如函数、资源)。 | 元数据、表管理、数据探查 |

数据集 | 外部存储的逻辑映射 | 打通与外部非结构化数据(图片/文档)的连接,是 AI 开发的关键数据桥梁。 | OSS/NAS 接入、数据挂载、非结构化 |

Notebook | 交互式的 Data+AI 开发画布 | 实现 SQL 与 Python 代码的融合,加速数据探索与算法验证。 | 交互式、多语言、可视化、探索分析 |

Data Studio 流程指引

Data Studio提供面向数仓开发和AI开发的流程,以下展示常见两种路径。更多路径请按实际情况探索。

通用路径:数仓开发流程(周期性ETL任务)

此流程适用于构建企业级数据仓库,实现稳定、自动化的批量数据处理。

面向人群:数据工程师、ETL 开发者。

核心目标:构建稳定、规范、可自动调度的企业级数据仓库,进行批量数据处理和报表生成。

关键技术:数据目录、周期工作流、SQL 节点、调度配置。

步骤 | 阶段名称 | 核心操作与目的 | 关键路径和参考文档 |

1 | 绑定计算引擎 | 为工作空间关联一个或多个核心的计算引擎(如MaxCompute),作为所有SQL任务的执行环境。 支持多引擎OpenLake开发,详情请参见OpenLake解决方案快速体验。

| 控制台 > 工作空间配置 相关文档,请参见绑定计算资源。 |

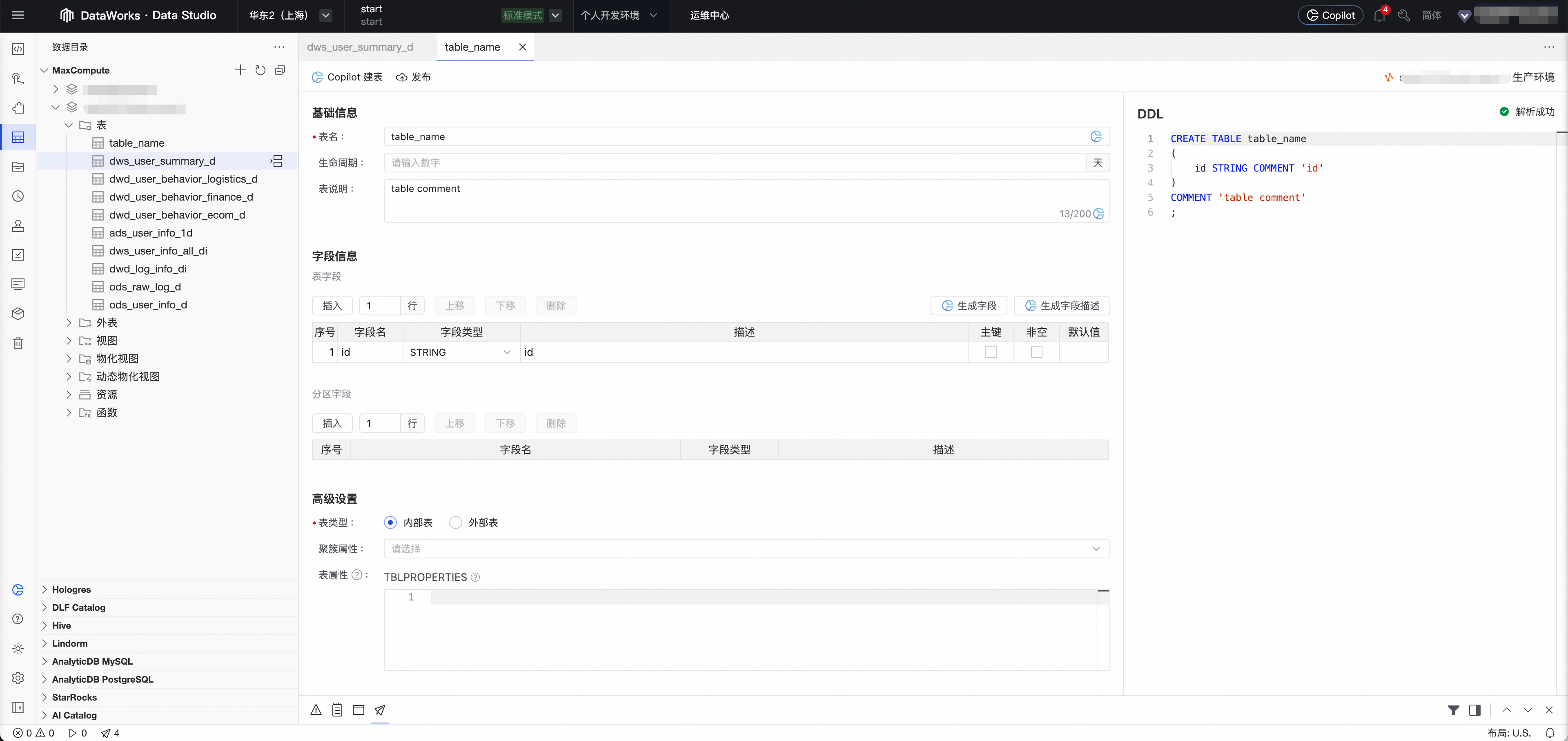

2 | 数据目录管理 | 在数据目录中创建或探查数仓各层所需的表结构(ODS, DWD, ADS等),为数据处理定义好输入和输出。 推荐使用数据建模模块构建数仓体系。

| Data Studio > 数据目录 相关文档,请参见数据目录。 |

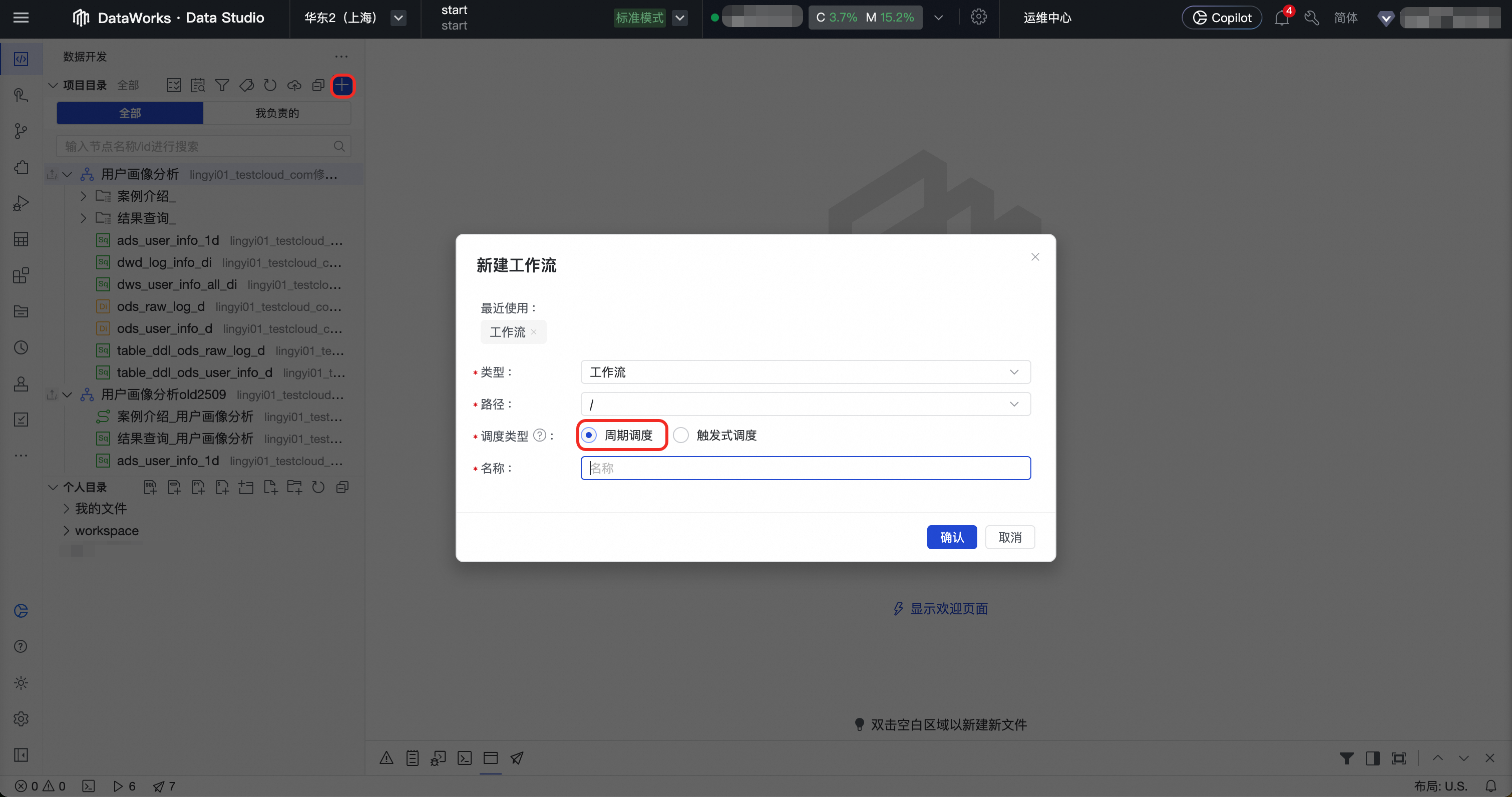

3 | 创建周期工作流 | 在项目目录中创建一个周期工作流,作为组织和管理相关ETL任务的容器。

| Data Studio > 项目目录 > 周期工作流 相关文档,请参见周期工作流。 |

4 | 节点开发和调试 | 创建ODPS SQL等节点,在编辑器中编写核心的ETL(数据清洗、转换、聚合)逻辑,并进行节点调试。

|

相关文档,请参见节点开发。 |

5 | Copilot辅助开发 | 通过DataWorks Copilot能力,实现SQL、Python的代码生成、代码纠错、代码改写、代码转换。

|

|

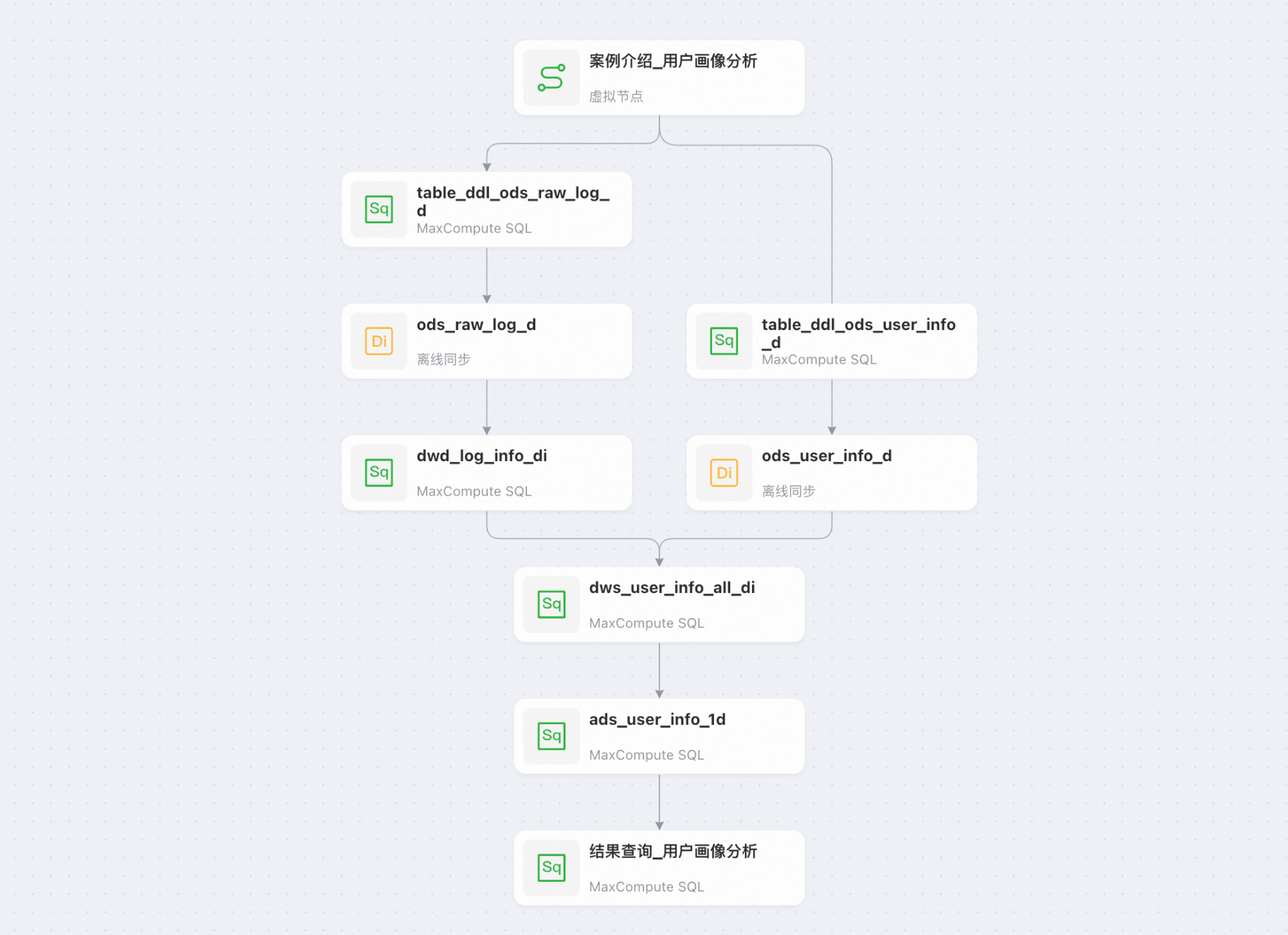

6 | 节点编排和调度 | 在工作流的DAG画布中,通过拖拽和连线的方式,定义各节点之间的上下游依赖关系。支持各种流程控制节点,可实现复杂的流程编排。

为工作流或节点配置生产环境的调度属性,如周期、时间和依赖。支持日均千万级超大规模调度。

|

相关文档,请参见通用流程控制节点、节点调度配置。 |

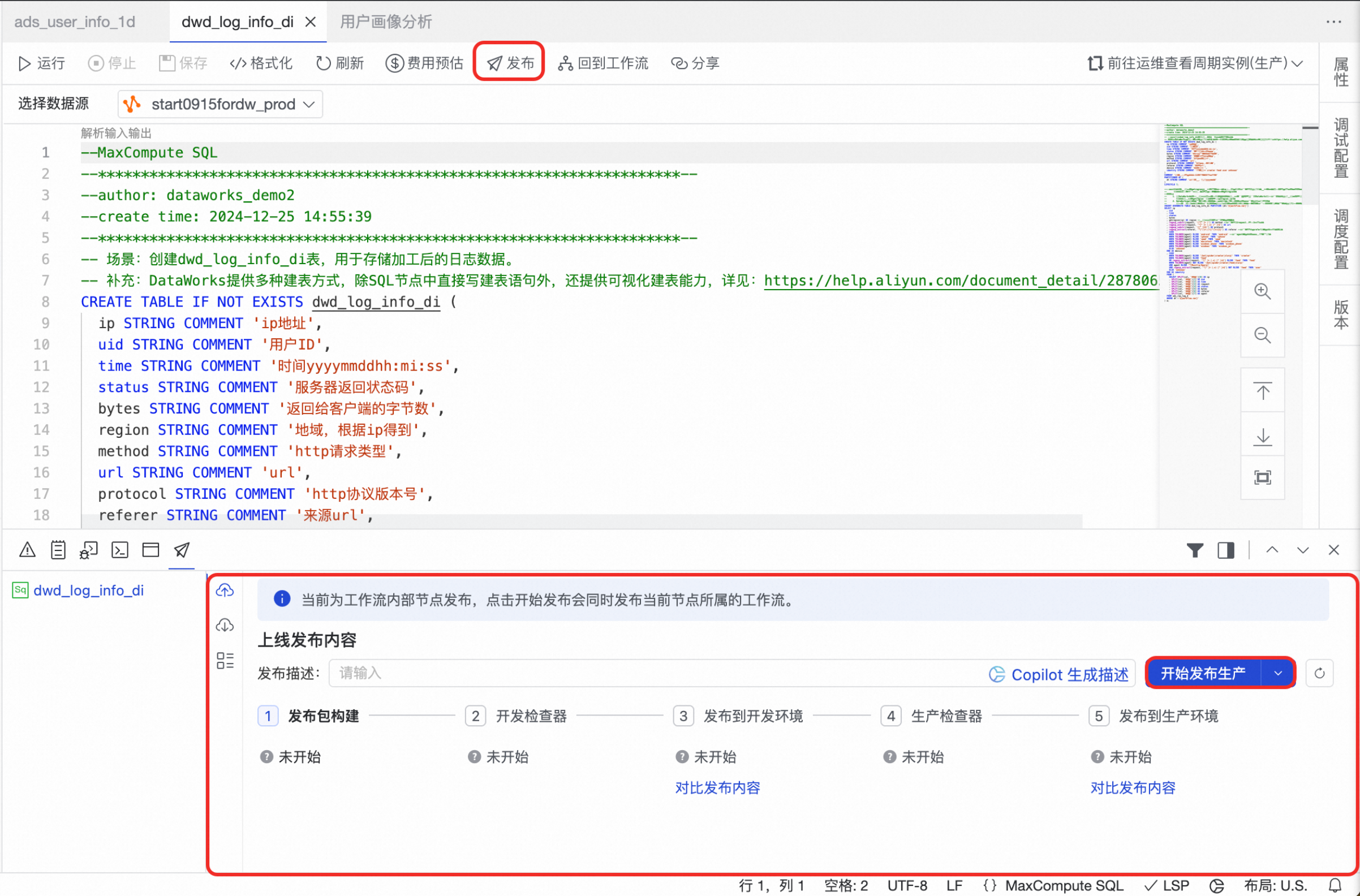

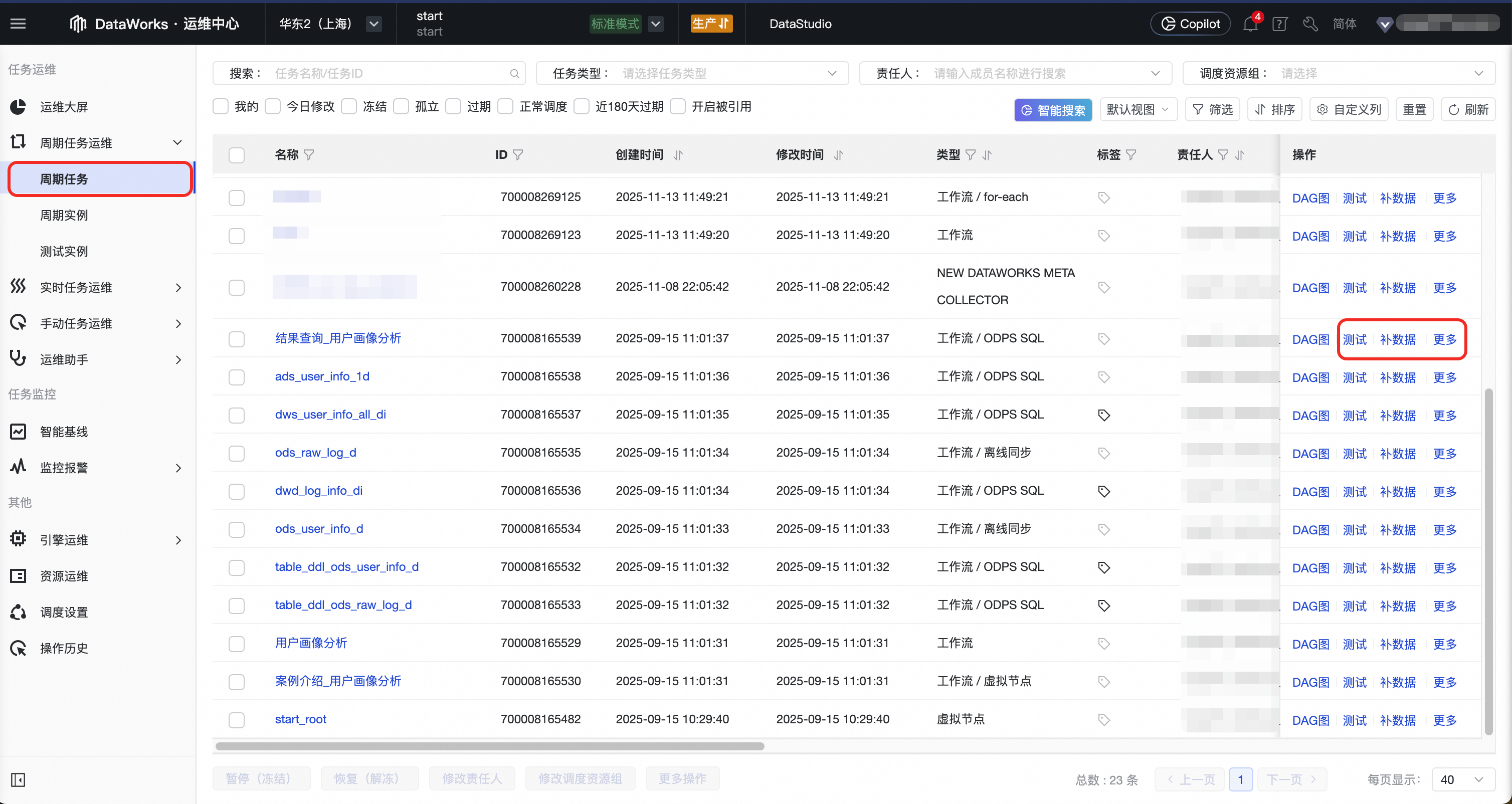

7 | 工作流/节点发布与运维 |

|

|

相关入门案例可参见:进阶:商品订单畅销类目分析。

进阶路径:大数据AI开发流程

此流程适用于AI模型开发、数据科学探索和构建实时响应的AI应用,强调环境的灵活性与交互性。具体流程可因实际而定。

面向人群:AI 工程师、数据科学家、算法工程师。

核心目标:进行数据探索、模型训练、算法验证,或构建实时响应的 AI 应用(如 RAG、实时推理服务)。

关键技术:个人开发环境、Notebook、触发式工作流、数据集、自定义镜像。

步骤 | 阶段名称 | 核心操作与目的 | 关键路径和参考文档 |

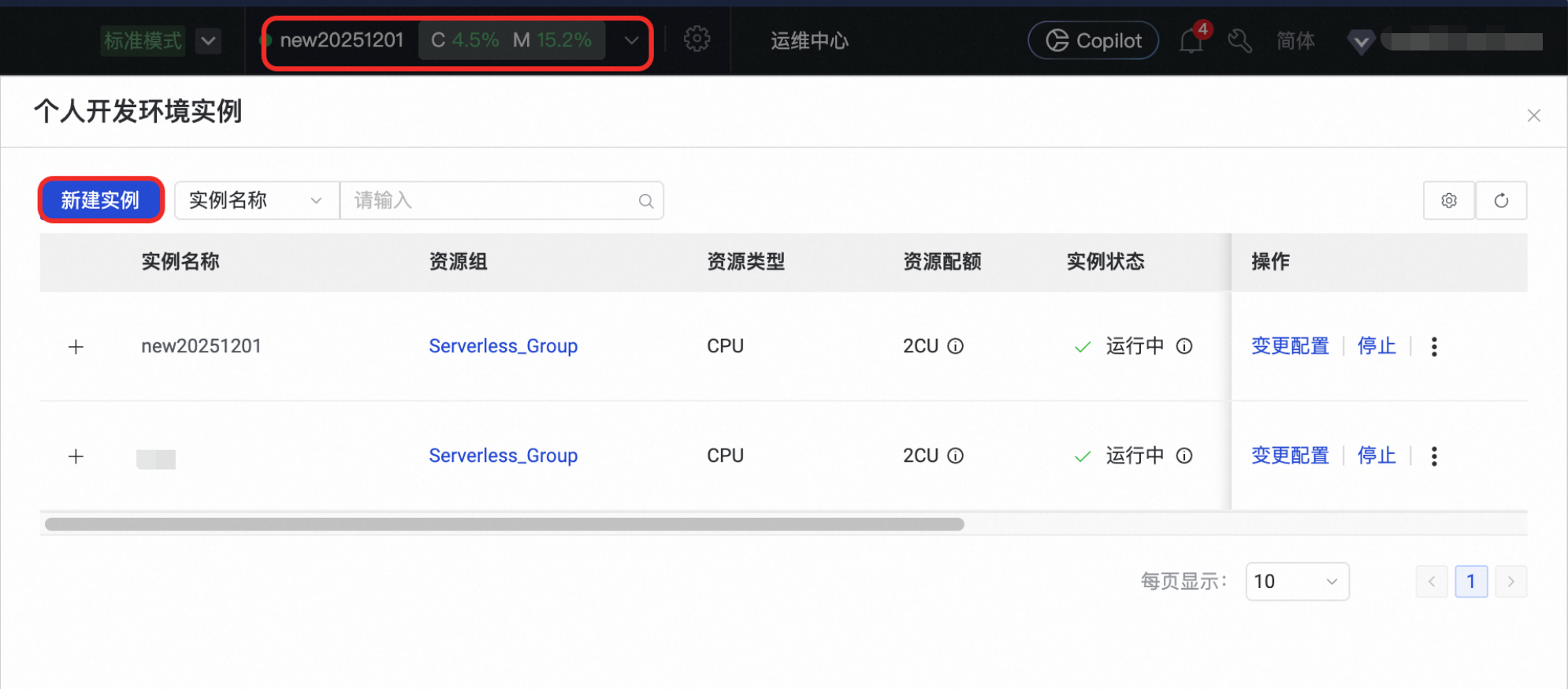

1 | 创建个人开发环境 | 创建一个隔离的、可自定义的云端容器实例,作为安装复杂Python依赖和进行专业AI开发的环境。

| Data Studio > 个人开发环境 相关文档,请参见个人开发环境。 |

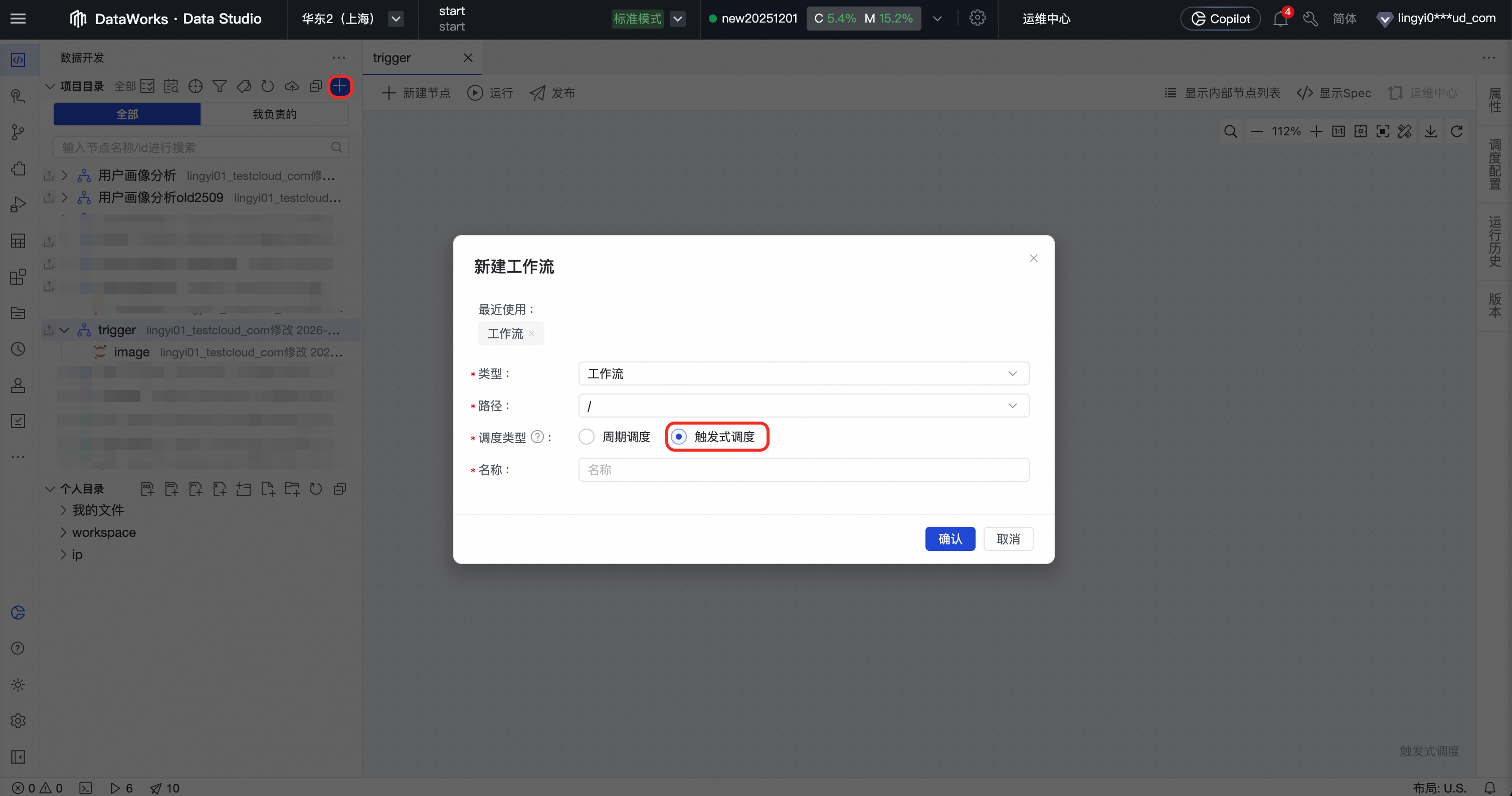

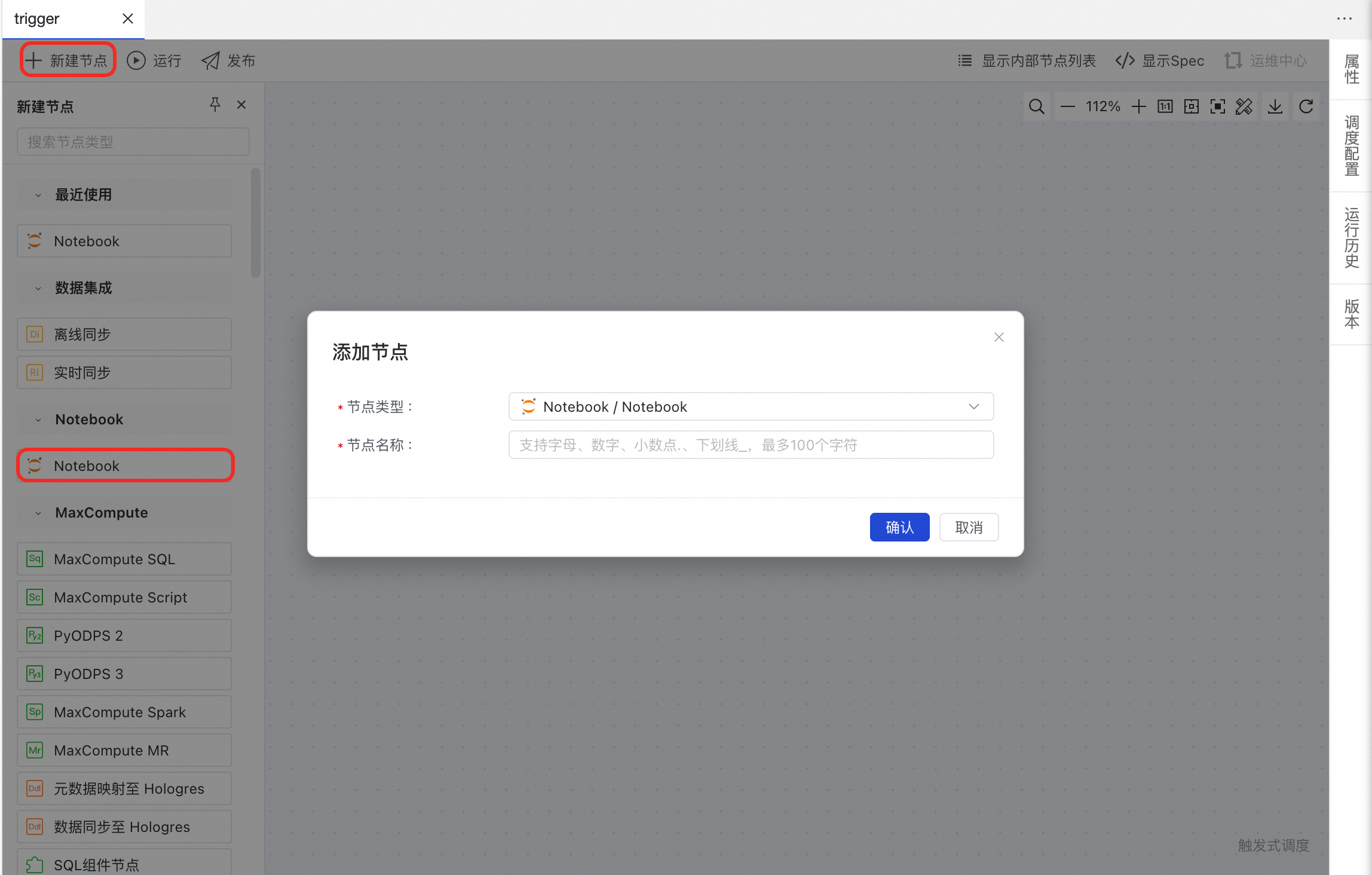

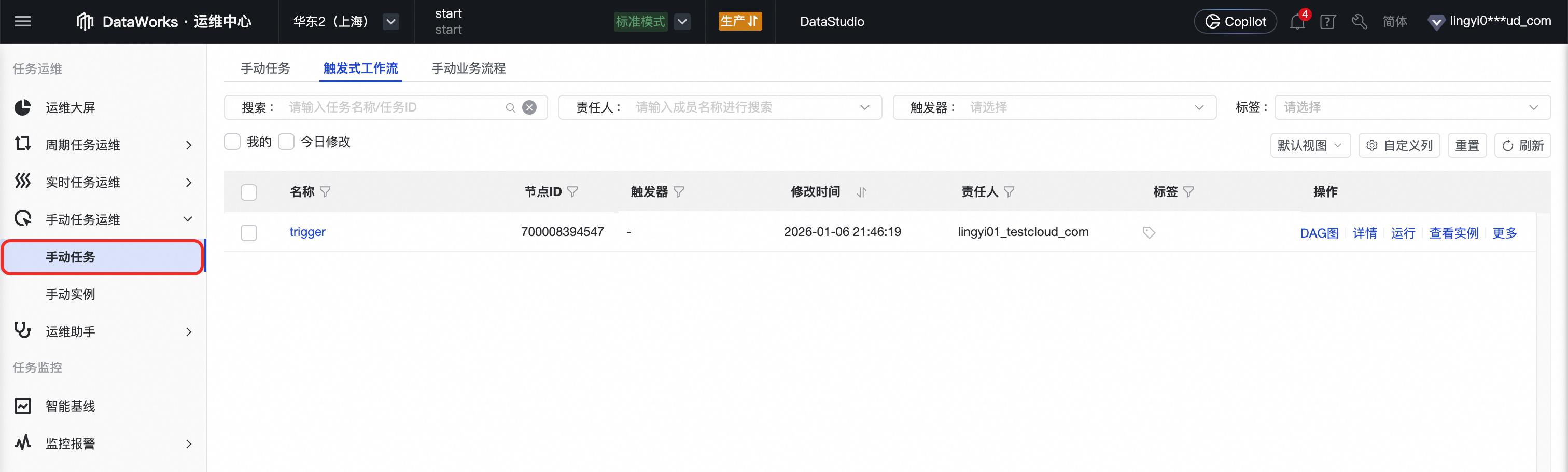

2 | 创建触发式工作流 | 在项目目录中创建一个由外部事件驱动的工作流,为实时AI应用提供编排容器。

| Data Studio > 项目目录 > 触发式工作流 相关文档,请参见触发式工作流。 |

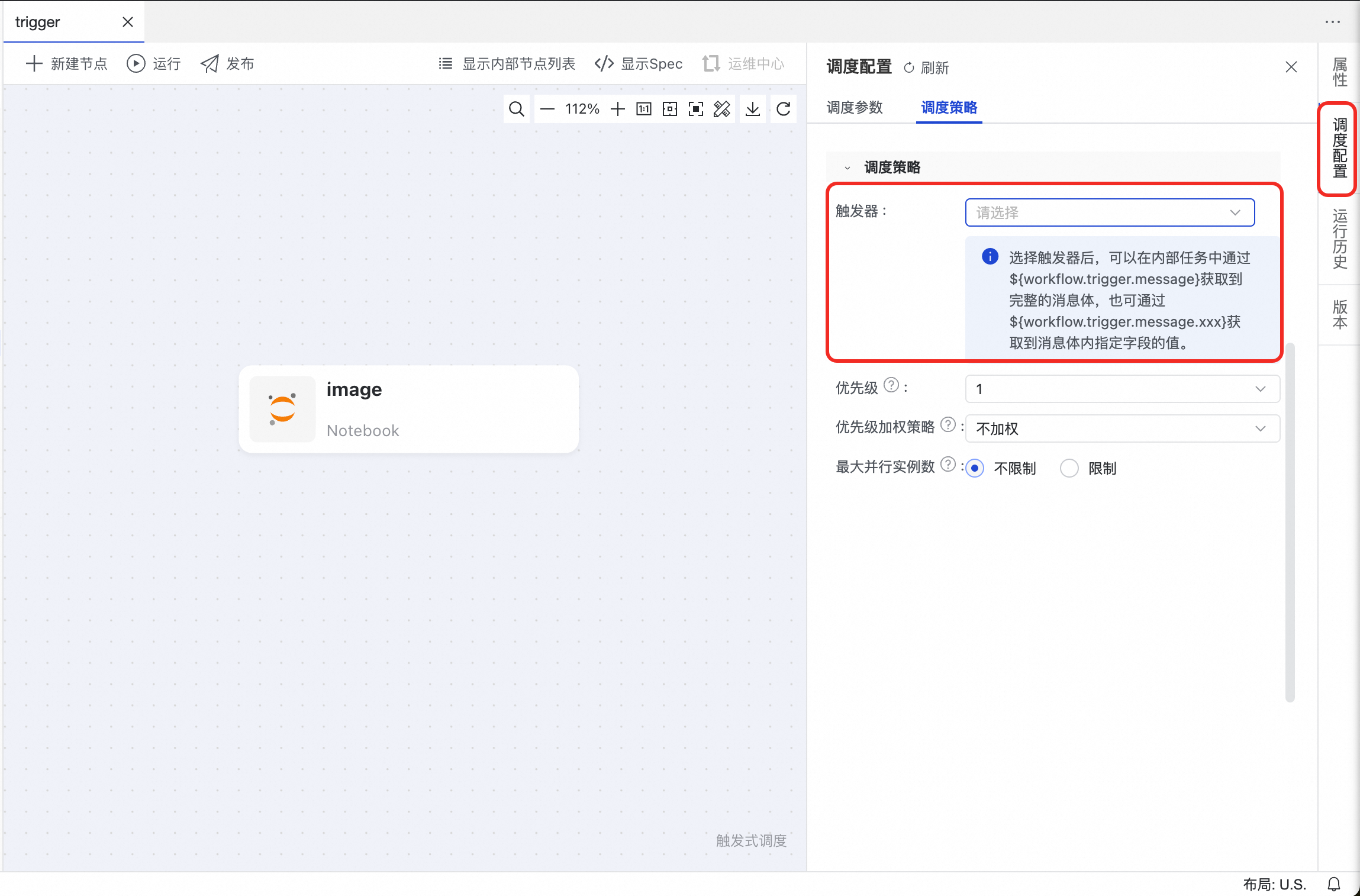

3 | 创建和设置触发器 | 在运维中心配置一个触发器,定义何种外部事件(如OSS事件、Kafka消息事件)会启动工作流。

|

相关文档,请参见管理触发器、设计触发式工作流。 |

4 | 创建Notebook节点 | 创建用于编写AI/Python代码的核心开发单元。通常先在个人目录的Notebook中进行探索。

| 项目目录 > 触发式工作流 > Notebook节点 相关文档,请参见创建节点。 |

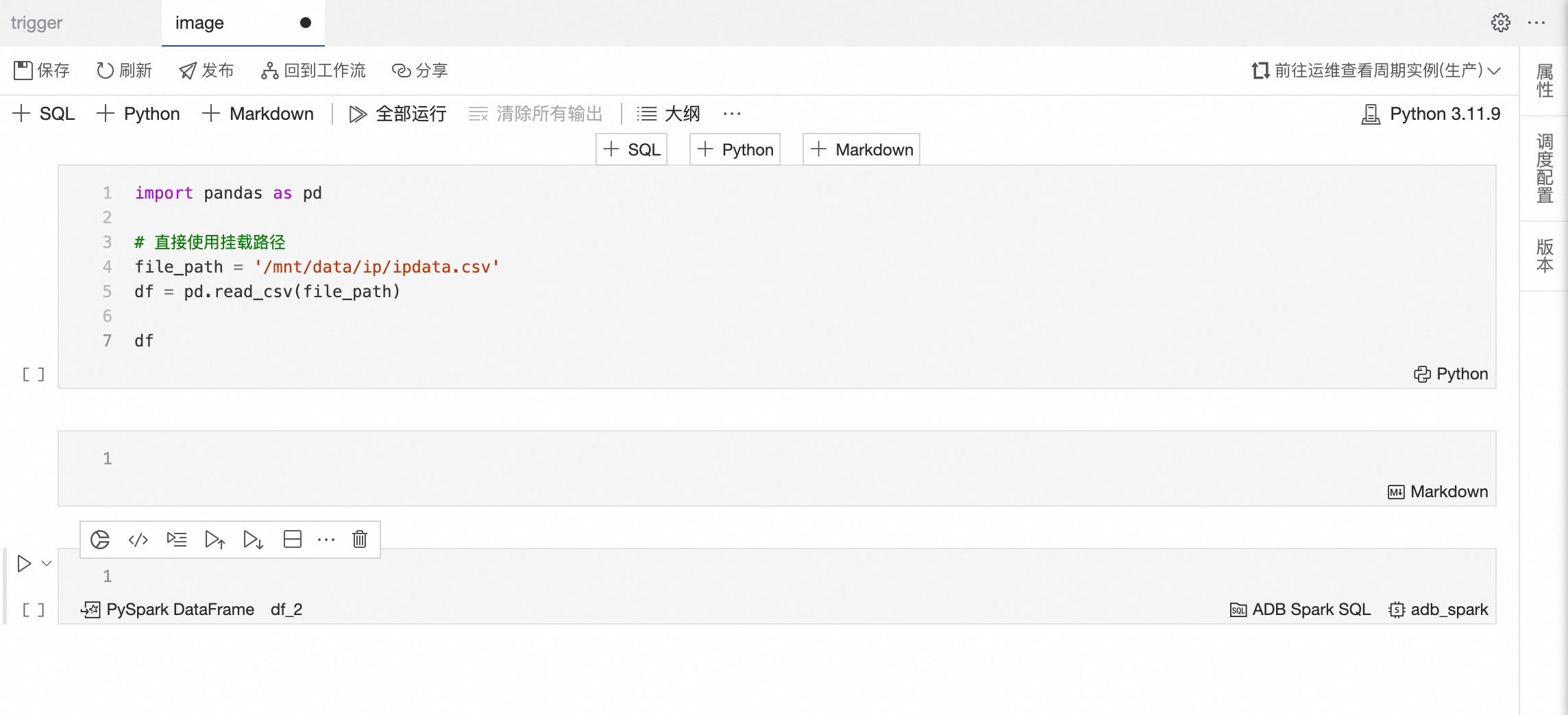

5 | 创建和使用数据集 | 将存储在OSS/NAS上的非结构化数据(图片、文档等)注册为数据集,并挂载到开发环境或任务中,供代码访问。

|

相关文档,请参见管理数据集、使用数据集。 |

6 | 开发&调试Notebook/节点 | 在个人开发环境提供的交互式环境中编写算法逻辑,进行数据探索、模型验证和快速迭代。

| Data Studio > Notebook编辑器 相关文档,请参见Notebook 基础开发。 |

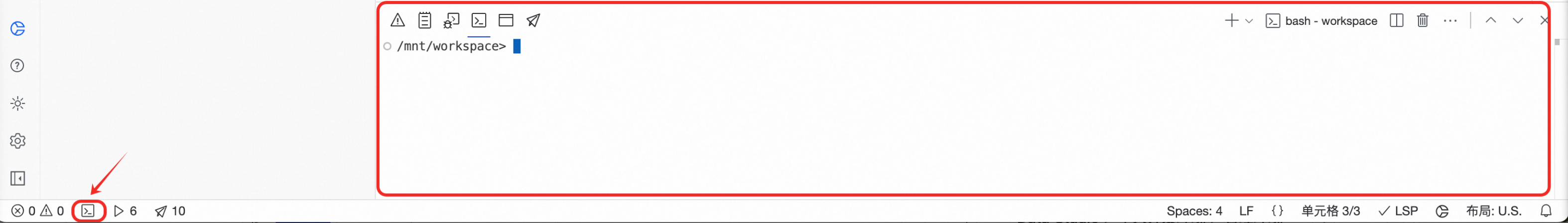

7 | 安装自定义依赖包 | 在个人开发环境的终端或Notebook的单元格中,使用

| Data Studio > 个人开发环境 > 终端 相关文档,请参见附录:完善个人开发环境。 |

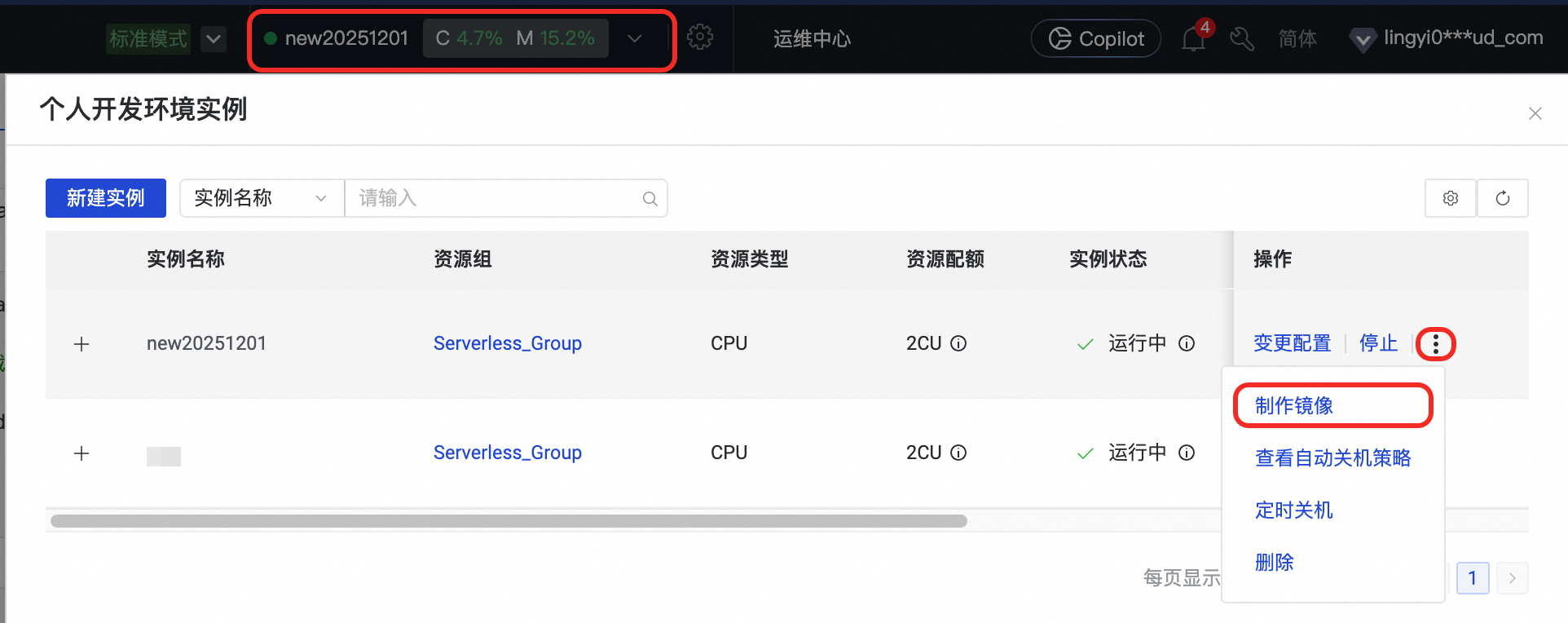

8 | 制作自定义镜像 | 将配置好所有依赖的个人开发环境固化成一个标准化的镜像,以保证生产环境与开发环境完全一致。 若没有安装自定义依赖包,则跳过此步骤。

|

相关文档,请参见个人开发环境制作DataWorks镜像。 |

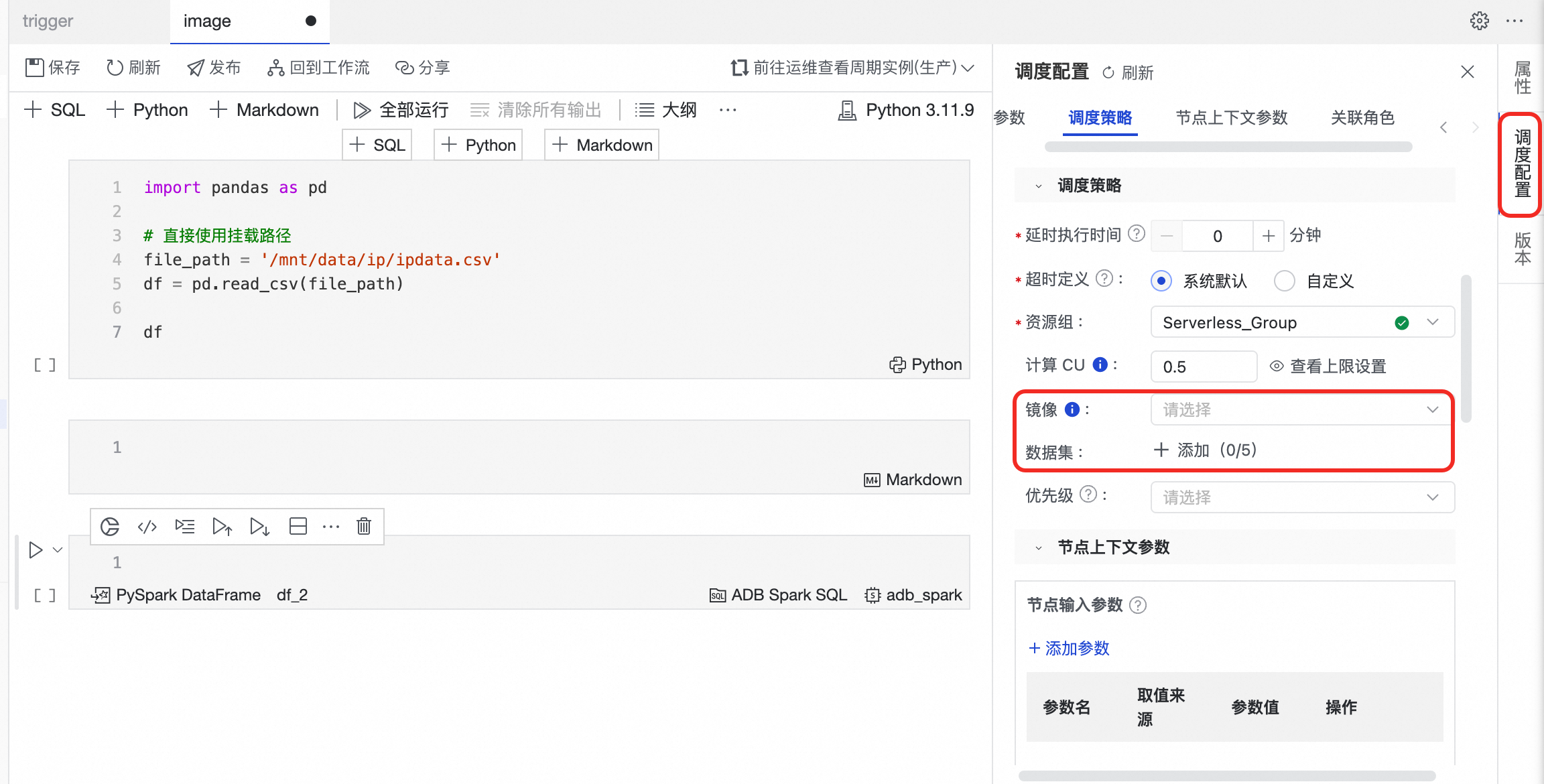

9 | 节点调度配置 | 在生产节点的调度配置中,必须指定使用上一步制作的自定义镜像作为运行环境,并挂载所需的数据集。

| Data Studio > Notebook节点 > 调度配置 相关文档,请参见节点调度配置。 |

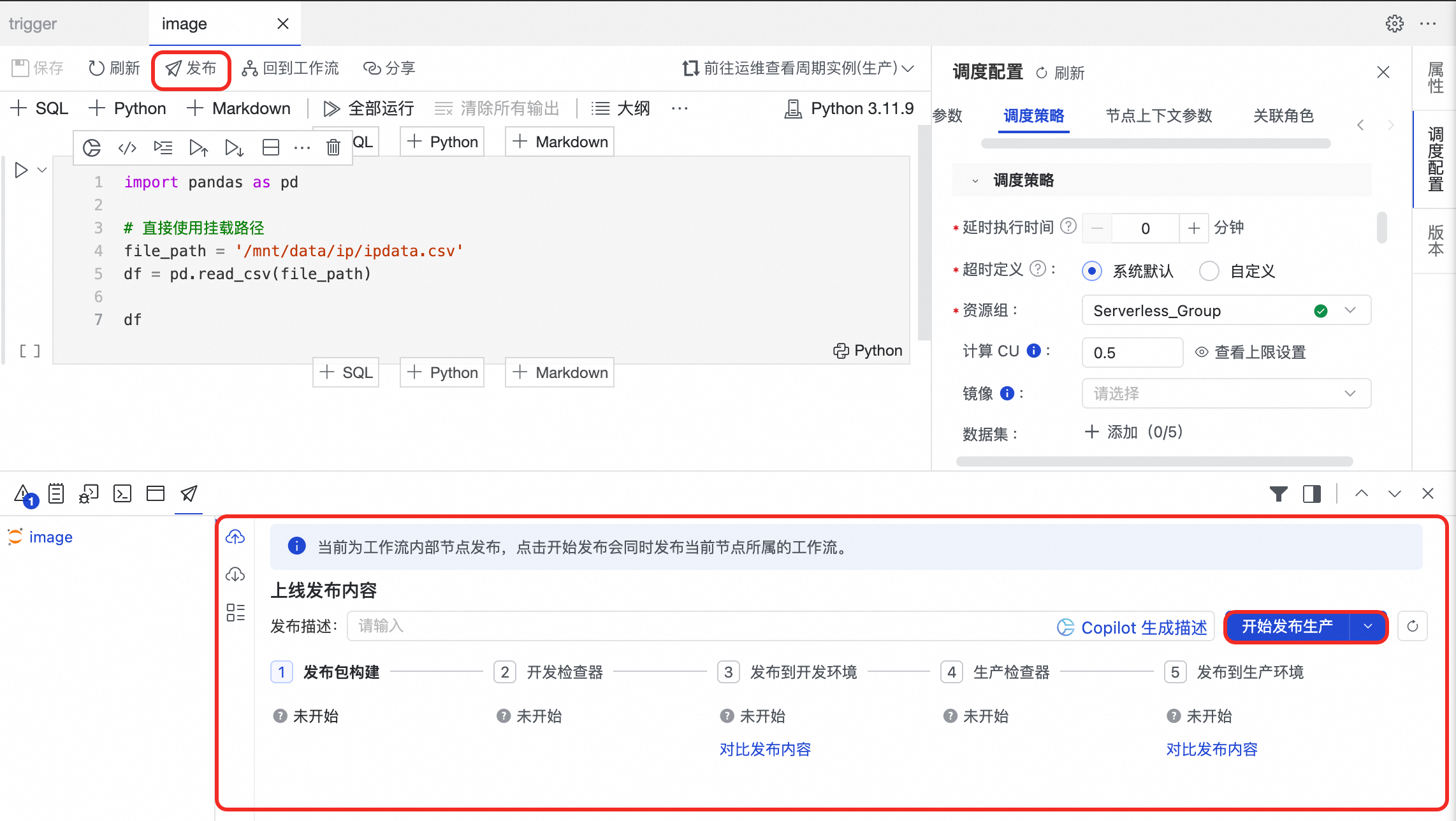

10 | 节点/工作流发布与运维 |

|

Data Studio 核心模块

核心模块 | 主要能力 |

工作流编排 | 提供可视化的 DAG 画布,支持通过拖拽方式轻松构建和管理复杂的任务工程。支持周期工作流、触发式工作流、手动业务流程,满足不同场景的自动化需求。 |

执行环境与模式 | 提供灵活、开放的开发环境,提升开发效率与协同能力。 |

节点开发 | 支持丰富的节点类型和计算引擎,实现灵活的数据处理与分析。

更多详情,请参见计算资源管理和节点开发。 |

节点调度 | 提供强大、灵活的自动化调度能力,确保任务按时、有序执行。

|

开发资源管理 | 实现对数据开发过程中涉及的各类资产的统一管理。 |

质量管控 | 内置多重管控机制,保障数据生产流程的规范性和产出数据的准确性。 |

开放与拓展 | 提供丰富的开放接口和扩展点,方便与外部系统集成和二次开发。

|

Data Studio 产品计费

DataWorks侧收费(费用在DataWorks相关账单中)

资源组费用:节点开发和个人开发环境使用依赖资源组进行。根据资源组不同,将产生Serverless资源组费用或独享调度资源组费用。

若使用大模型服务,也将产生Serverless资源组费用。

任务调度费用:若任务发布至生产环境调度运行,将产生任务调度费用(使用Serverless资源组时)或独享调度资源组费用(使用独享资源组时)。

数据质量费用:若为周期性任务配置质量监控并成功触发实例,将产生数据质量实例费用。

智能基线费用:若为周期性任务配置智能基线,开启状态的智能基线将产生智能基线实例费用。

报警短信和电话费用:若为周期性任务配置监控报警并成功触发短信和电话,将产生报警短信和电话费用。

说明费用涉及模块:数据开发、数据质量、运维中心模块。

非DataWorks侧收费(费用不在DataWorks相关账单中)

运行数据开发节点任务时,可能产生的计算引擎计存储费用(例如,OSS存储费)不在DataWorks收取。

Data Studio 快速开始

创建或启用新版数据开发

创建工作空间时,选择使用新版数据开发(Data Studio)。具体操作请参见创建工作空间。

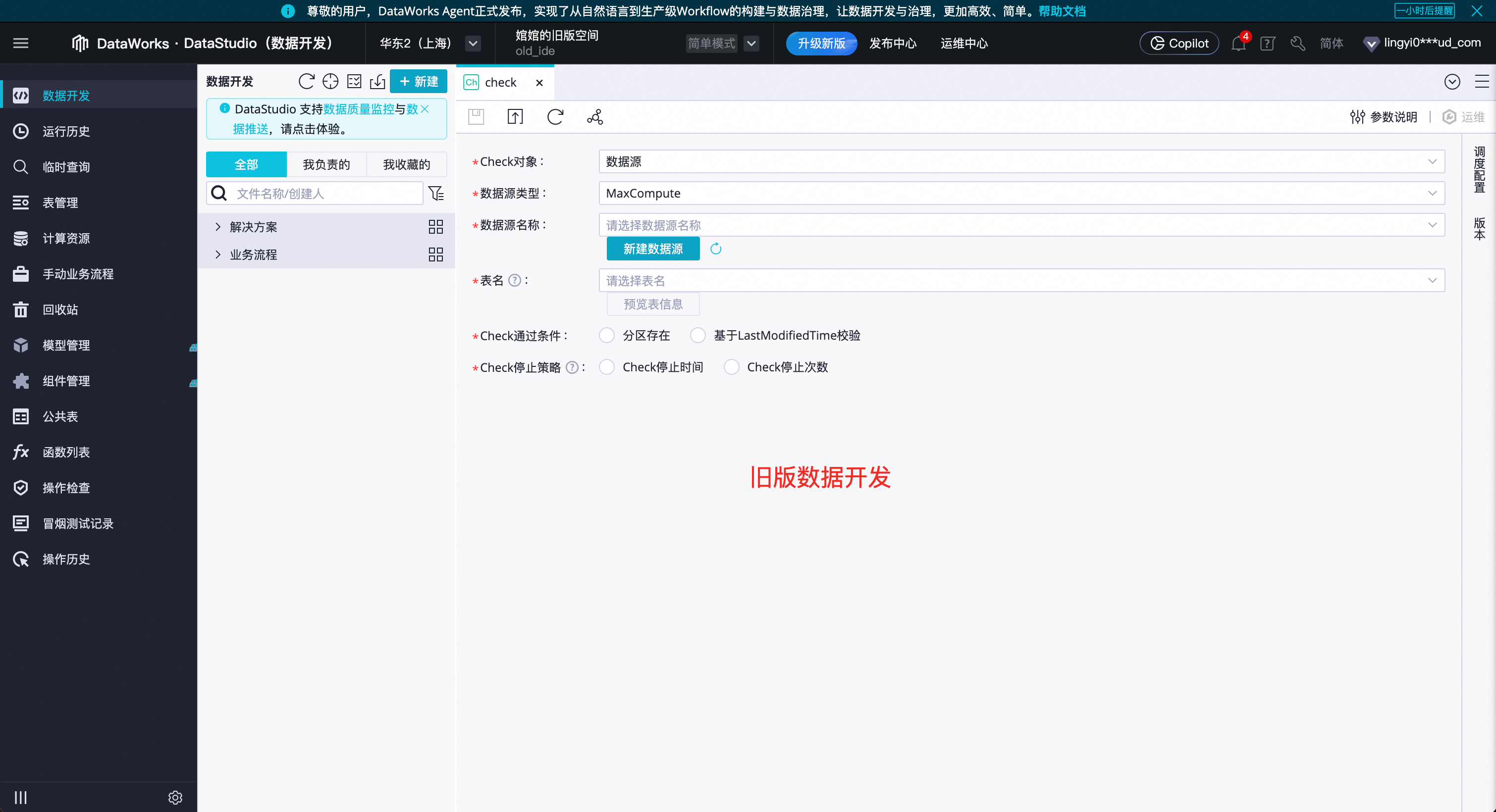

旧版数据开发(DataStudio)支持通过单击数据开发页面顶部的升级新版按钮,按界面提示,将数据迁移至新版数据开发(Data Studio)。详情请参见Data Studio 升级指南。

进入新版数据开发

进入DataWorks工作空间列表页,在顶部切换至目标地域,找到已创建的工作空间,单击操作列的,进入Data Studio。

常见问题与答疑

Q:如何区分新版数据开发还是旧版数据开发?

A:两者页面风格完全不同,新版为正文截图样式,旧版如下图。

Q:升级成新版数据开发之后,能退回旧版数据开发么?

A:旧版数据开发升级新版为不可逆操作,成功升级后将无法回退至旧版。切换前建议先创建开启新版数据开发的工作空间进行测试,确保新版数据开发满足业务需求后再升级。另外,新版数据开发与旧版数据开发中的数据相互独立。

Q:为什么我创建工作空间时,没看到使用新版数据开发(Data Studio)配置项?

A:若您在界面上未看到此选项,代表您的工作空间已默认启用新版数据开发。

重要

重要如您在使用新版数据开发过程中遇到问题,可添加DataWorks数据开发升级到新版专属答疑群进行咨询。