预置吞吐单元(Provisioned Throughput Unit, PTU)是阿里云百炼的一种模型部署计费方式,支持按需配置TPM(Tokens per Minute),能够使模型满足预期的吞吐需求,适用于需要持续稳定吞吐能力的业务场景。

目前预置吞吐单元计费模式属于邀测阶段,请您先联系销售经理进行申请。

预置吞吐单元概述

PTU定义

PTU是用于描述模型部署中模型吞吐容量的单位,它具有以下特性:

稳定吞吐:针对特定版本的模型,能够使模型达到预期且稳定的吞吐量。

低延时:相比按 Tokens 调用量计费,在首包时延和生成速率上更优,且有稳定保障。

高并发:针对特定版本的模型,提供比默认限额更大的并发数。

每个PTU可以换算成模型每分钟需要输入和输出的Token总数(TPM),您仅需评估模型所需的TPM,再根据换算比例来决定PTU的购买数量。

购买逻辑:可以使用模型部署页面的计算器进行估算

统计模型每分钟的TPM:每分钟输入Token数 + 每分钟输出Token数

计算PTU的推荐数量 : TPM / 该模型每PTU对应的TPM

处理计算结果:结果PTU的最小购买单位向上取整

吞吐单元推荐数量仅供参考,建议部署后使用真实流量负载进行压测获取更准确的结果。

计费方式:按PTU的数量和使用时长收费

计费公式:费用 = 使用时长(分钟)× PTU数量 × PTU单价;最小计费单位:分钟

支付方式:

按小时后付费:以 PTU 计费方式完成模型部署后,无论是否进行模型推理,都将按小时出账(不满一分钟按一分钟计算),按月扣费。如需关闭计费,请下线部署服务。

按月预付费:您可以购买预置吞吐单元容量包,通过承诺月度使用时长来降低费用。预置吞吐单元容量包购买成功后立即生效,且不支持退订。建议您先创建PTU部署服务后再购买容量包,以免先买容量包后创建PTU失败而产生成本浪费。

创建购买时有可能会受资源容量限制,如购买不成功建议重试或联系销售经理。

支持的模型

PTU计费模式目前仅支持部署以下5种预置模型,每个模型 PTU 的最小购买单位、每PTU所对应的 TPM 或 QPM 都不同。

支持的模型 | 每PTU对应的TPM (每分钟消耗Token数) | 每 PTU对应的QPM (每分钟调用次数) | PTU的最小购买单位 |

qwen-turbo-2025-04-28 | 60,000 | 60 | 4 |

qwen-plus-2025-04-28 | 25,000 | 25 | 8 |

qwen-max-2025-01-25 | 10,000 | 10 | 16 |

qwen-vl-plus-2025-05-07 | 16,000 | 8 | 4 |

qwen-vl-max-2025-04-08 | 4,000 | 4 | 8 |

如模型实际的TPM超过了部署时购买的PTU所能承载的TPM值时会报限流错误(错误代码:429),建议您等待重试或进行PTU的扩容。

计费模式对比

按PTU 和按 Tokens 调用量计费都属于模型部署时的计费方式,但适用场景不同。

按PTU | 按Token调用量 | |

适用场景 | 高并发,低延迟,稳定吞吐,流量可预估的业务场景 | 付费灵活,用于快速验证调优效果、性能有保障的业务场景 |

计费方式 | 按PTU的使用时长收费 | 按不同类型的Token用量收费 |

计费公式 | 费用 = 使用时长(小时)× PTU数量 × PTU单价 最小计费单位:1分钟 | 费用 = 模型输入 Token 数 × 输入单价 + 模型输出 Token 数 × 输出单价 最小计费单位:1 token |

支付方式 |

| 按量后付费 |

支持模型 |

部署流程

以下是通过阿里云百炼控制台以PTU模式进行部署的流程。目前,PTU 模式不支持通过 API 部署。

前往模型部署,点击部署新模型。

选择预置模型、选择预置吞吐单元计费方式,设置模型名称并开始部署。

部署状态为运行中时,代表该模型可以进行推理并开始计费。

部署后调用

模型部署成功后,支持通过 DashScope、 OpenAI 兼容、使用大模型、LangChain及 Assistant SDK 进行调用。

调用部署成功后的模型,model的取值应为模型部署成功后的模型 code 。请您前往模型部署界面获取模型 code 。

OpenAI 兼容

import os

from openai import OpenAI

client = OpenAI(

# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1",

)

completion = client.chat.completions.create(

model="qwen-plus-d824b8ad<请替换为模型部署成功后的code作为模型名称>",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "你是谁?"},

],

# Qwen3模型通过enable_thinking参数控制思考过程(开源版默认True,商业版默认False)

# 使用Qwen3开源版模型时,若未启用流式输出,请将下行取消注释,否则会报错

# extra_body={"enable_thinking": False}

)

print(completion.choices[0].message.content)

DashScope

import os

import dashscope

messages = [

{'role': 'system', 'content': 'You are a helpful assistant.'},

{'role': 'user', 'content': '你是谁?'}

]

response = dashscope.Generation.call(

# 若没有配置环境变量,请用百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv('DASHSCOPE_API_KEY'),

model="qwen-plus-d824b8ad<请替换为模型部署成功后的code作为模型名称>",

messages=messages,

result_format='message'

)

print(response)

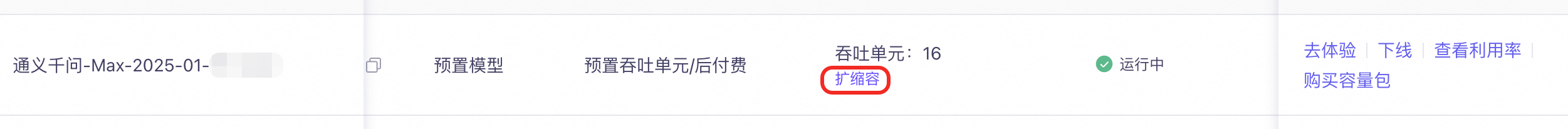

模型扩缩容

按 PTU 方式部署的模型支持进行扩缩容,您可以根据您的模型所需的吞吐量调整 PTU 的数量。

部署服务下线

如果不再需要模型部署服务,需要停止服务计费,请您按照此操作下线部署服务,下线后将不再产生计费:

前往模型部署,找到要下线的部署服务,点击下线并确认。

部署状态显示“下线中”时,请耐心等待。直到该服务消失后,下线操作全部完成。

调用统计

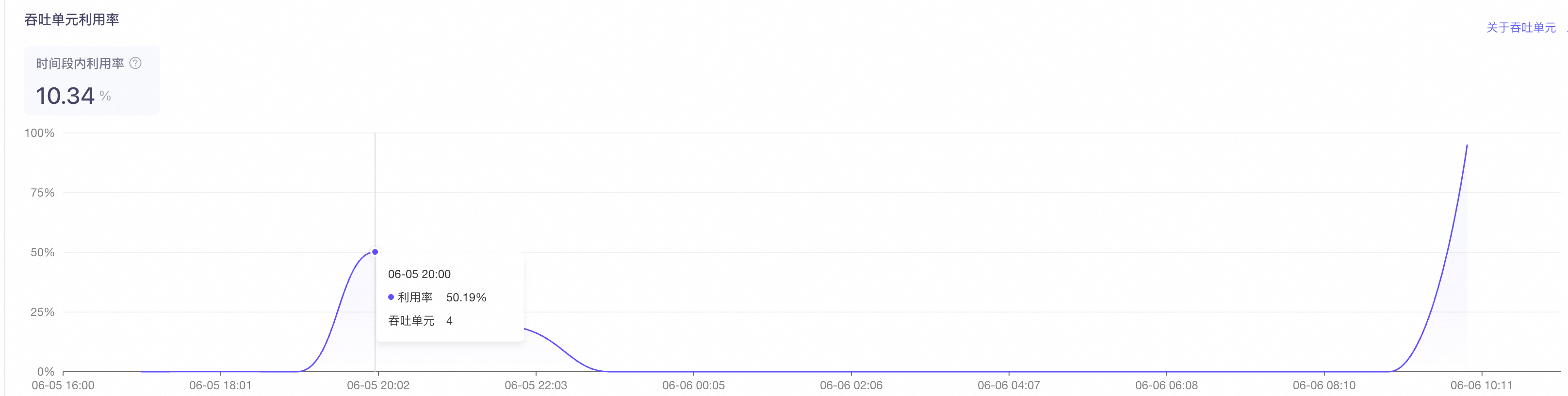

PTU创建成功后,您可在模型观测页面查看 PTU 利用率的变化。

PTU 部署利用率 = 时间段内消耗的吞吐单元数量 / 时间段内部署的吞吐单元数量