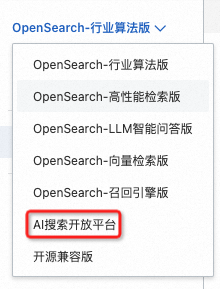

AI搜索开放平台专注智能搜索场景,提供文档切片、向量化、排序及大模型等核心算法组件化服务。行业算法版支持一键接入AI搜索开放平台的算法服务,支持根据业务需求定制训练向量化模型,开发者可按需调用模块化能力,快速构建智能搜索系统。

使用流程

计费规则

模型调用费用

AI搜索开放平台提供的算法服务采用按量付费模式,按照服务调用量计费。每小时生成一个计费账单,所有的分时账单归属于一个订单,并按照生成订单时的账单从阿里云账号扣费,您可以在费用与成本中心查看消费明细。

由于在业务数据导入阶段和业务调用搜索功能阶段,行业算法版将依据配置的索引字段方式进行业务数据文本向量化和搜索内容向量化,因此在这两个阶段均会产生向量化费用。

|

服务ID |

简介 |

计费单位 |

0-500个单位定价 |

超出500个单位定价 |

|

ops-text-embedding-001 |

多语言(40+)文本向量化服务,输入文本最大长度300,输出向量维度1536维 |

元/千tokens |

0.005 |

0.0001 |

|

ops-text-embedding-002 |

语言(100+)文本向量化服务,输入文本最大长度8192,输出向量维度1024维 |

0.005 |

0.0005 |

|

|

ops-text-embedding-zh-001 |

中文文本向量化服务,输入文本最大长度1024,输出向量维度768维 |

0.005 |

0.00005 |

|

|

ops-text-embedding-en-001 |

英文文本向量化服务,输入文本最大长度512,输出向量维度768维 |

0.005 |

0.00005 |

|

|

ops-document-split-001 |

提供通用的文本切片服务,可基于文档段落格式、文本语义、指定规则,对html、markdown、txt格式的结构化数据进行拆分,同时支持富文本形式提取code、image、table。 |

0.005 |

0.00002 |

|

|

ops-qwen-turbo |

以qwen-turbo大规模语言模型为模型底座,进行有监督的模型微调,强化搜索增强,减少有害性。 |

输入:0.0004 输出:0.0007 |

||

|

qwen-turbo |

千问系列速度最快、成本极低的模型,适合简单任务,详情请参见模型列表。 |

输入:0.0003 输出:0.0006 |

||

|

qwen-plus |

能力均衡,推理效果、成本和速度介于千问-Max和千问-Turbo之间,适合中等复杂任务,详情请参见模型列表。 |

输入:0.0008 输出:0.002 |

||

|

qwen-max |

千问系列效果最好的模型,适合复杂、多步骤的任务,详情请参见模型列表。 |

输入:0.0024 输出:0.0096 |

||

|

deepseek-r1 |

专注于复杂推理任务的大语言模型,在复杂指令理解、结果准确性等方面表现较突出。 |

输入:0.004 输出:0.016 |

||

|

deepseek-v3 |

MoE模型,在长文本、代码、数学、百科、中文能力上表现优秀。 |

输入:0.002 输出:0.008 |

||

|

deepseek-r1-distill-qwen-7b |

基于知识蒸馏技术,通过使用DeepSeek-R1生成的训练样本对Qwen-7B微调训练的模型。 |

输入:0.0005 输出:0.001 |

||

|

deepseek-r1-distill-qwen-14b |

基于知识蒸馏技术,通过使用DeepSeek-R1生成的训练样本对Qwen-14B微调训练的模型。 |

输入:0.001 输出:0.003 |

||

|

ops-bge-reranker-larger |

提供基于BGE模型的文档打分服务,可根据query与文档内容的相关性,按分数由高到低对doc进行排序,并输出对应的打分结果。支持中英双语,最大输入token长度512(Query+doc长度)。 |

元/个docs |

0.001 |

0.00003 |

|

ops-text-reranker-001 |

OpenSearch自研重排模型,融合多行业数据集训练,提供高水准的重排服务,可根据Query及doc的语义相关性从高到低对doc进行排序。支持中英双语,最大输入token长度512(Query+doc长度)。 |

0.001 |

0.00015 |

|

模型训练费用

计费公式为:CU单价*机型消耗的CU数量*购买机器台数

具体计费规则如下表所示:

|

机型 |

CU单价(元/小时) |

单台机器消耗CU数量 |

单台机器单价(元/小时) |

|

gpu.v100.16g.x1 |

1.07 |

30.14 |

32.25 |

|

gpu.t4.16g.x1 |

16.07 |

17.195 |

|

|

gpu.a10.24g.x1 |

11.01 |

11.781 |

使用示例

-

购买行业算法版实例。

-

单击一键接入开通AI搜索开放平台服务。

重要您使用该功能将使得您的业务数据传输至产品部署(中国上海)的区域进行处理,因您的配置而异,可能会涉及跨境数据传输,以下信息需要您知晓并遵守:

-

如涉及跨境数据传输,使用本功能,即表示您确保您业务数据的跨境传输符合所有适用法律,包括提供充分的数据保护、提供充分的隐私声明、获得有关个人的必要同意等,且您的业务数据不含任何适用法律限制或禁止传输或披露的内容。

-

您在此声明并保证,您将遵守以上合规要求。如因您违反前述声明与保证,导致阿里云和/或其关联公司遭受任何损失,您应承担赔偿责任。

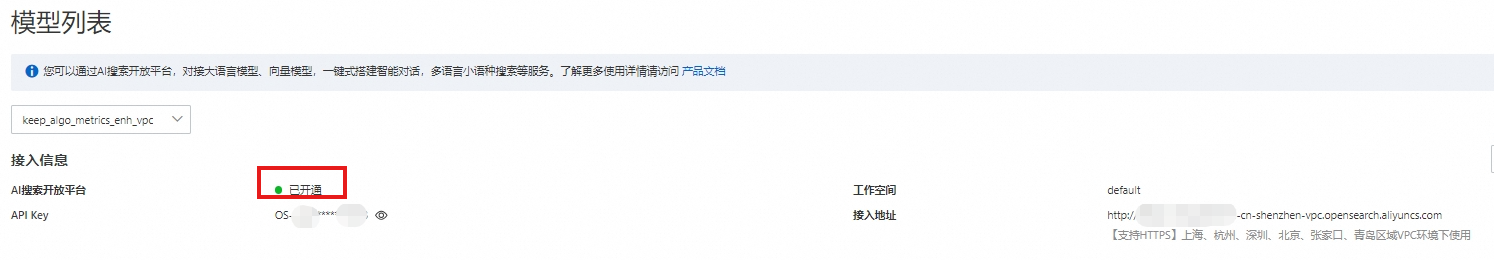

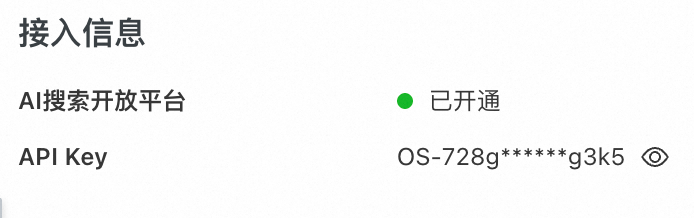

接入AI搜索开放平台服务后,您可以看到服务调用相关信息:

界面

说明

工作空间:用于隔离和管理不同的业务数据,首次开通AI搜索开放平台服务后,系统自动创建Default空间,您也可以创建更多空间隔离不同业务。

AI搜索开放平台支持通过空间+RAM用户授权方式,让RAM用户最小化权限使用AI服务,增加数据安全,详情参见空间管理和RAM用户授权。

当前RAM账号有多个工作空间的使用权限时,单击编辑切换空间。

接入地址:AI搜索开放平台支持通过公网访问服务,也支持杭州、深圳、北京、张家口、青岛地域的用户通过VPC地址跨地域调用AI搜索开放平台的服务。

单击编辑配置行业算法版实例通过公网或者VPC地址调用服务,默认为VPC。

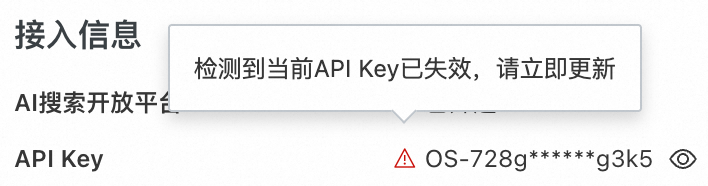

API Key:调用服务时的身份认证信息。如果您需要将指定工作空间下的API Key授权给RAM用户使用,需要给RAM用户授予相关的权限。

存在多个API Key或者API Key失效时,单击编辑切换API Key。API Key失效时,页面会提示您更新,同时,业务系统使用搜索业务时也会返回报错信息。

开通AI搜索开放平台服务后,您也可以将地域切换为上海,体验AI搜索开放平台提供的更多服务。

-

-

配置应用结构,具体步骤包含添加搜索业务数据源信息、定义主表、配置多表之间的关联关系、表主键、字段映射类型等信息。

-

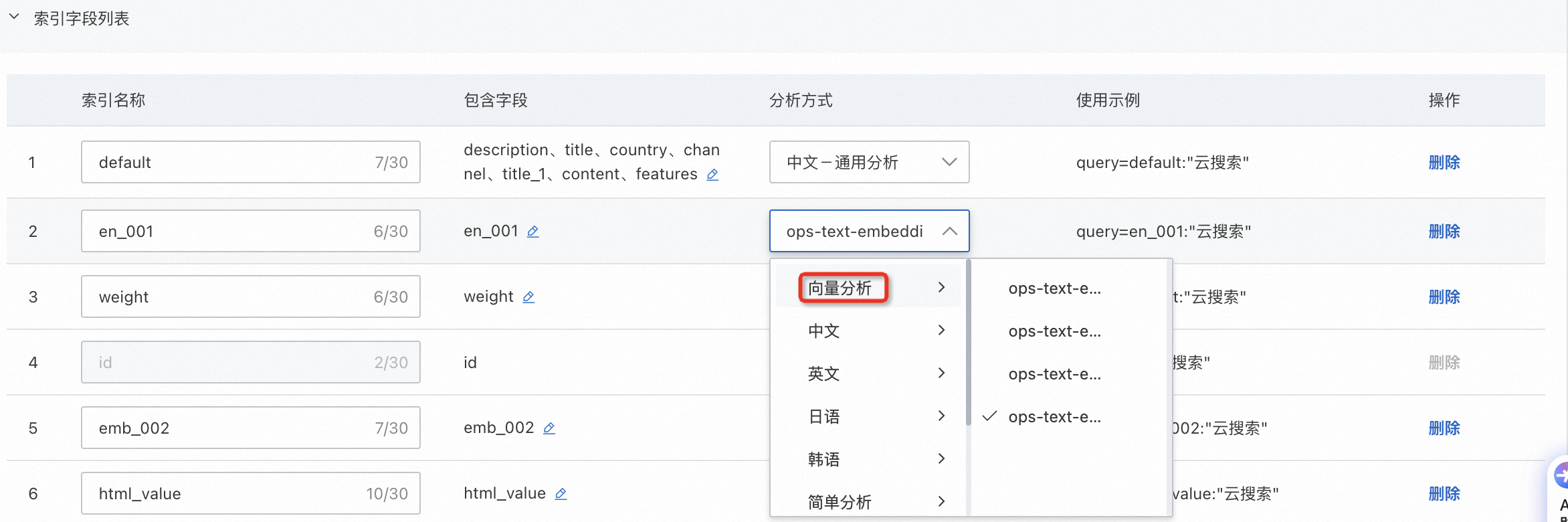

配置索引结构,字段类型为TEXT、SHORT_TEXT时,分析方式可选择使用向量分析(包含在AI搜索开放平台中内置的多维度文本向量化模型、用户自定义部署的模型以及行业算法版独享型实例的内置向量化模型)服务,后续导入业务数据时,可以直接导入原始文本数据,通过此处的文本向量化服务完成数据向量化,如何计费请参见计费规则。

-

配置数据源,本实例中的业务数据存储在MaxCompute中,根据MaxCompute数据特性,行业算法版允许用户指定数据导入的分区,支持通过正则表达式导入前一天的数据构建索引,可参见配置MaxCompute 数据源掌握更多数据分区条件写法。

-

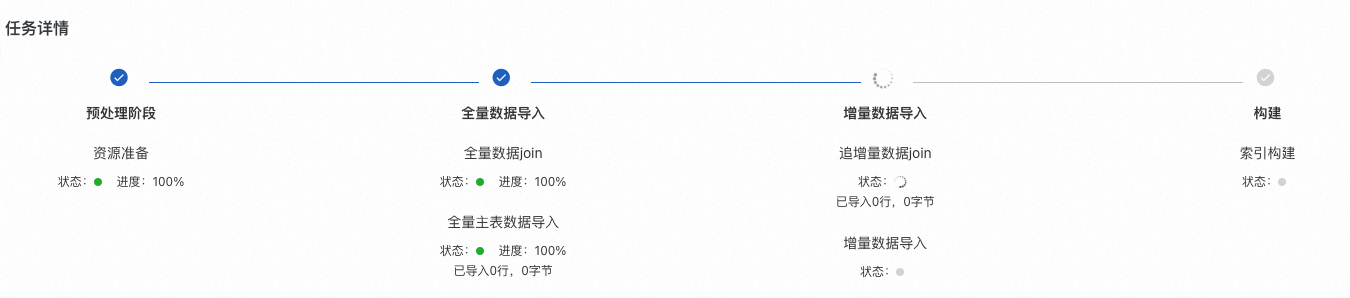

完成上述配置后,系统开始导入数据并构建索引,通过实例详情页查看任务进度。

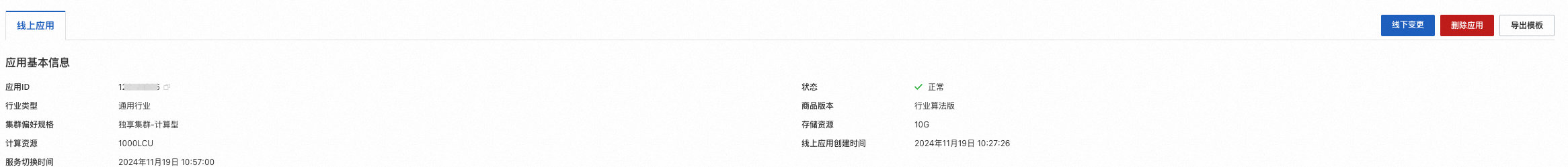

应用状态为正常时,表示索引构建完成。

-

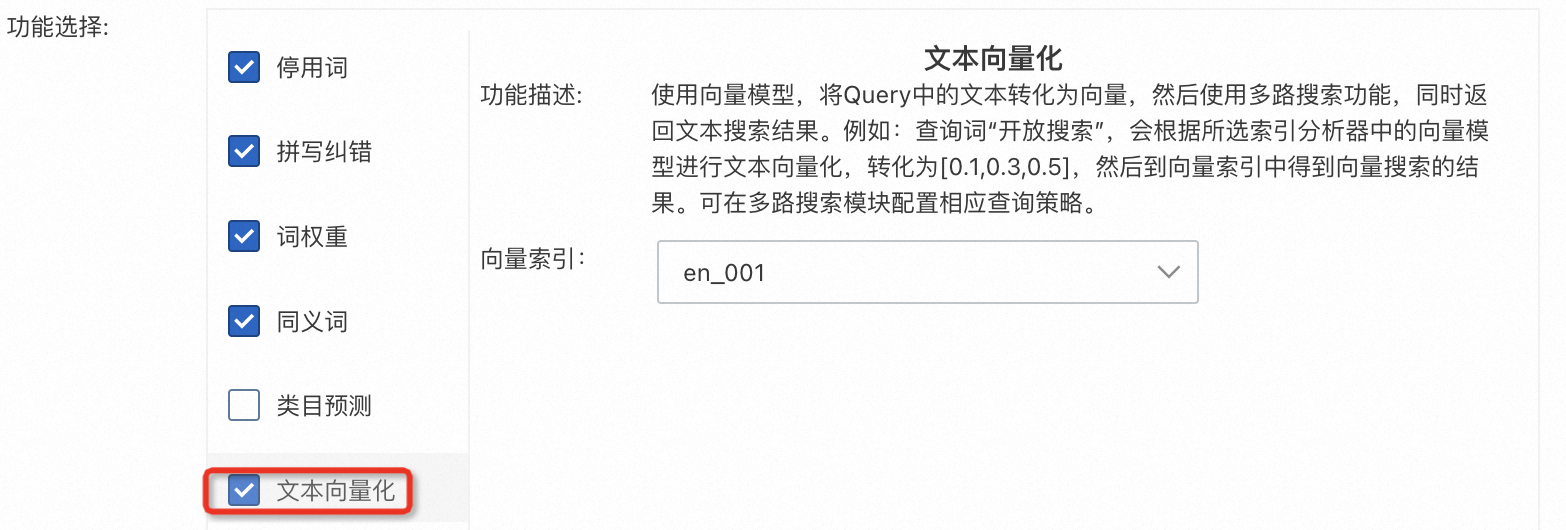

配置搜索召回时使用的向量模型,单击搜索算法中心>召回配置>查询分析器配置,在功能选择模块选择文本向量化,向量索引值为步骤4中配置的索引名称。一个应用中可以添加多条查询分析器,详情参见查询分析配置。

-

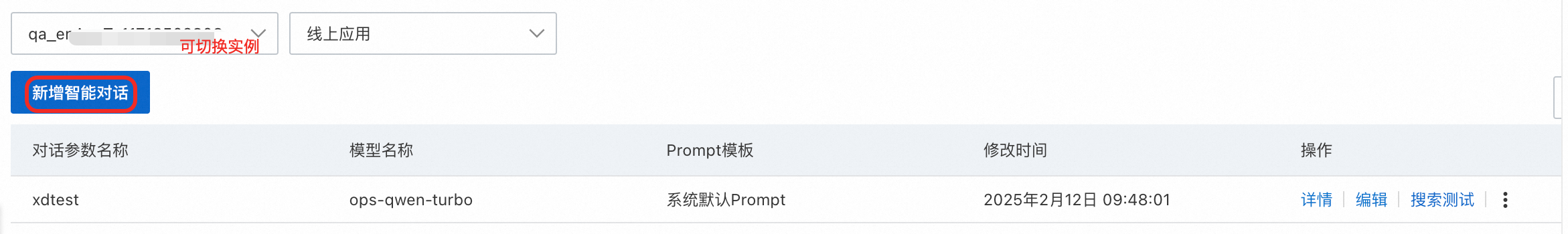

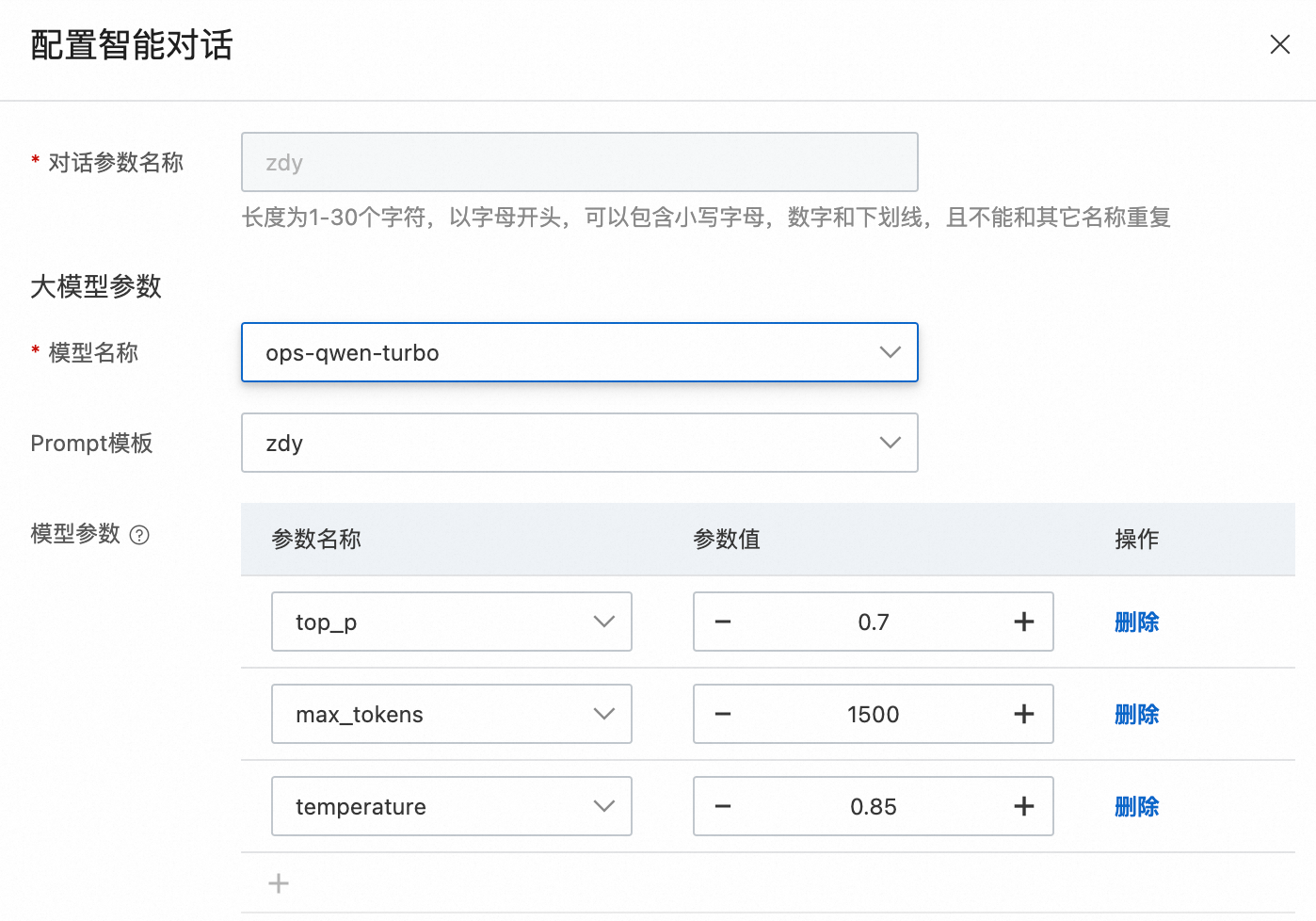

通过检索增强生成>智能对话对大模型及其相关参数进行配置,通过大模型对搜索结果进行摘要总结。

关键参数说明如下:

参数

说明

大模型参数

模型名称

支持选择千问系列和DeepSeek系列模型对搜索结果进行摘要总结。

Prompt模板

Prompt(提示词)是您输入大模型的指令,用于明确需求并引导其生成精准、相关的回答或内容,详情请参见Prompt管理。

模型参数

-

temperature: 用于控制模型生成内容的随机性和多样性程度,取值范围:[0, 2)。temperature值越大,生成内容更加多样化;temperature值越小,生成结果越单一。

-

top_p:控制候选Token集合的采样范围,取值范围为(0,1.0)。top_p值越大,候选Token的范围越广,生成的内容更加多样化;top_p值越小,候选Token的范围越小,输出更符合既定模式。

-

max_tokens:用于控制模型生成token的最大数量。

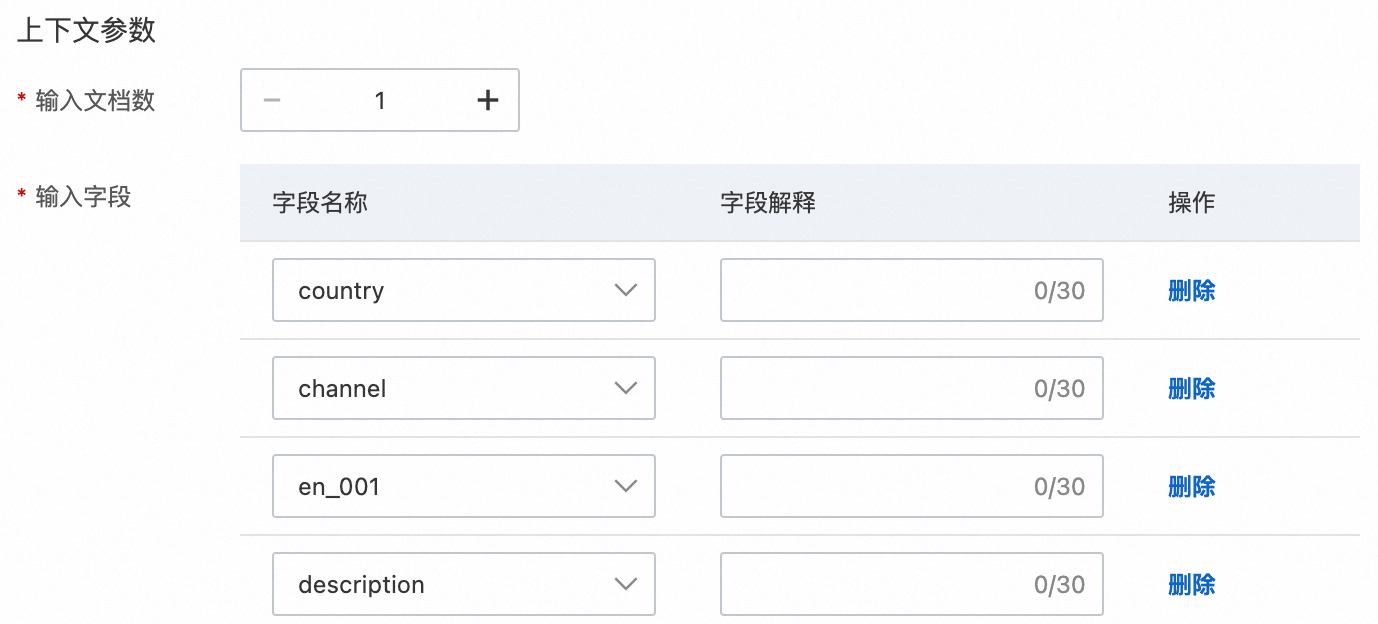

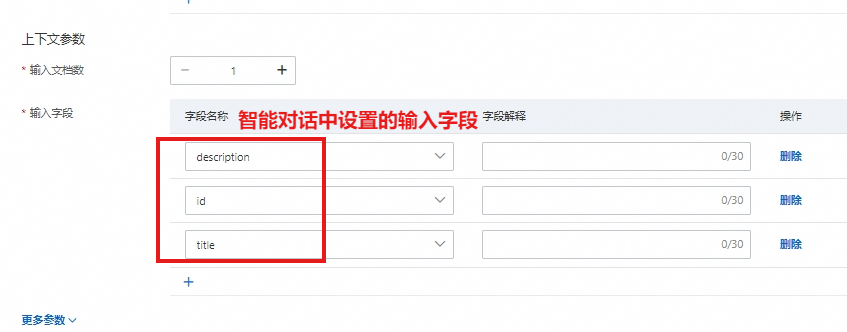

上下文参数

输入文档数

单次输入给大模型的文档个数。

输入字段

配置文档中哪些字段输入给大模型。

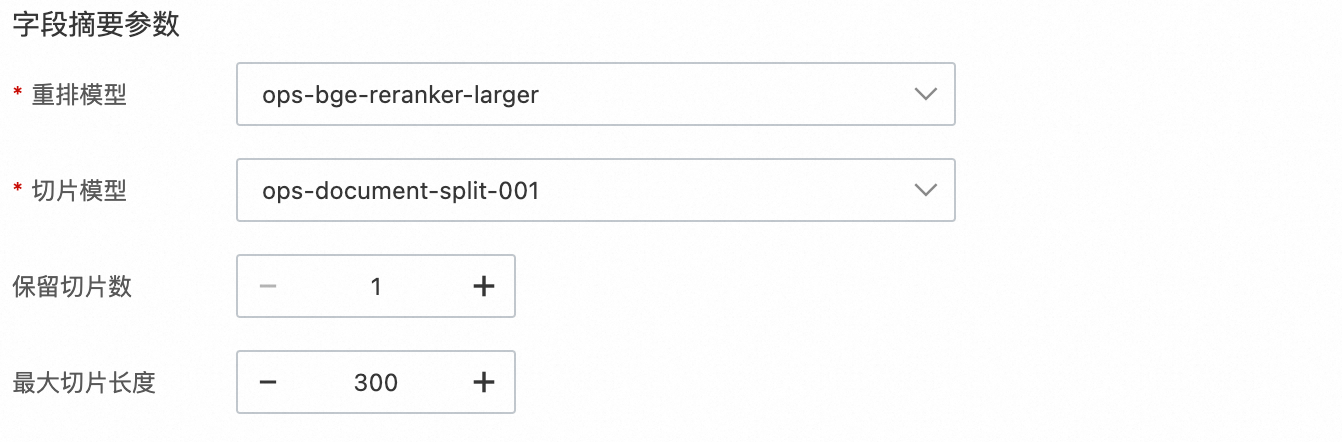

字段摘要

重排模型

选择重排模型对切片进行排序:

-

ops-bge-reranker-larger:基于BGE模型的文档打分服务,支持中英双语,最大输入token长度512。

-

ops-text-reranker-001:OpenSearch基于行业数据集微调训练的重排模型,支持中英双语,最大输入token长度512。

切片模型

当搜索结果中出现较长文档时,可以对其进行切片处理。可基于文档的段落格式、文本语义或指定规则,对HTML、Markdown和TXT格式的结构化数据进行拆分。

保留切片数

配置召回的文档切片数量,取值范围:[1, 30]。

最大切片长度

切片长度单位为token,取值范围[100, 3000]。

-

-

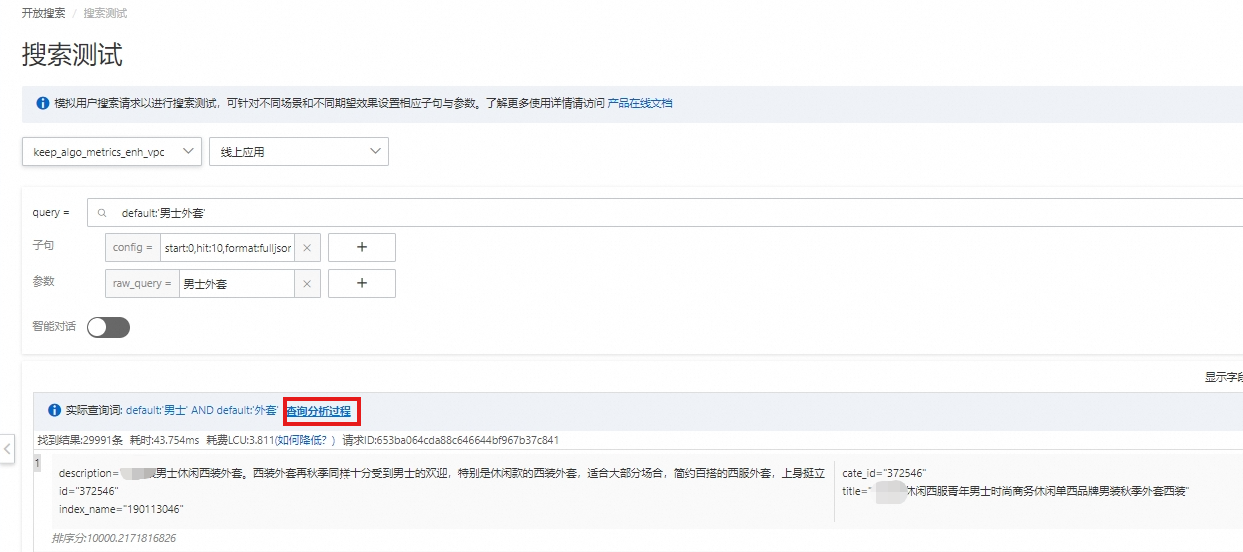

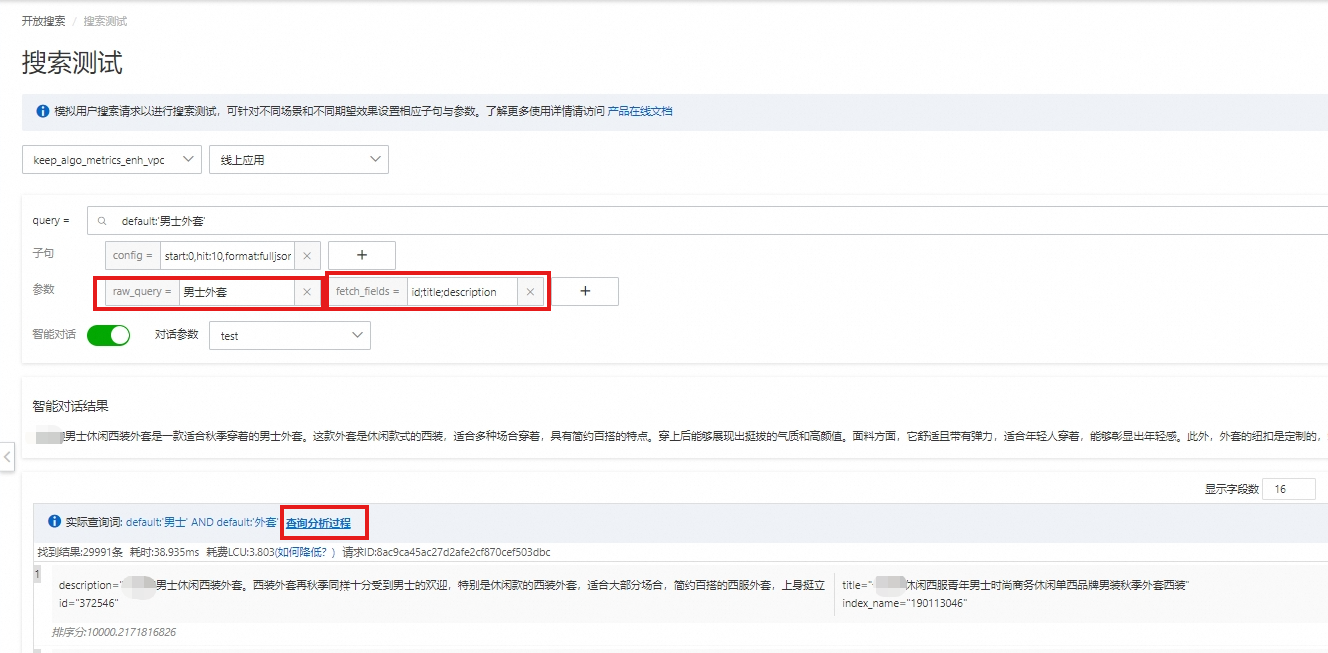

通过功能扩展>搜索测试对向量检索和大模型摘要总结效果进行测试。

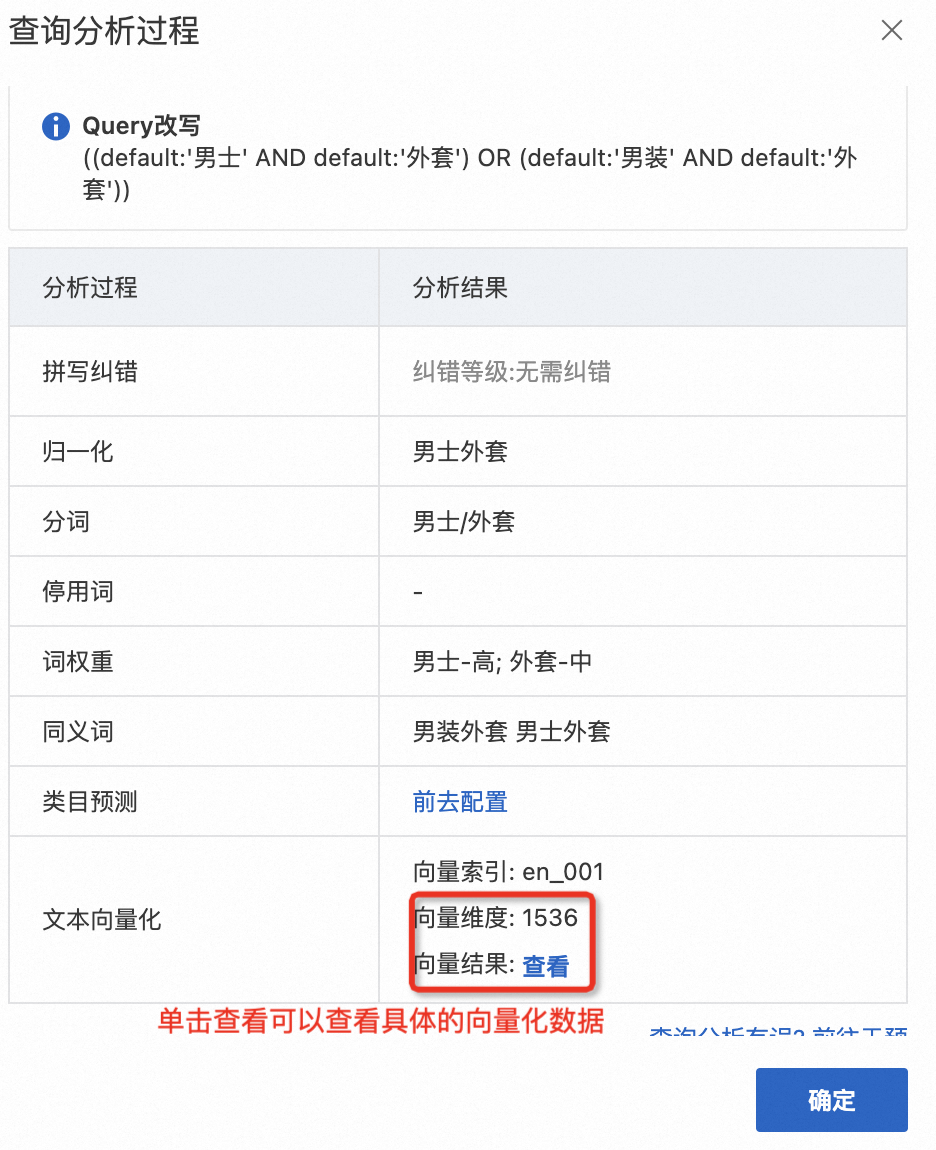

通过查询分析过程确认搜索内容是否使用了AI搜索开放平台提供的向量化服务:

开启智能对话,设置查询参数并选择步骤8配置的智能对话进行效果测试:

-

fetch_fields:展示的字段;开启智能对话后,填写字段为智能对话中配置的字段,多个字段之间使用英文符号;连接。

-

raw_query:原始query,一般建议设置为终端用户输入的原始查询词。

-

测试效果达到业务要求时,您可以参照开发指南在业务应用中通过SDK调用搜索功能。

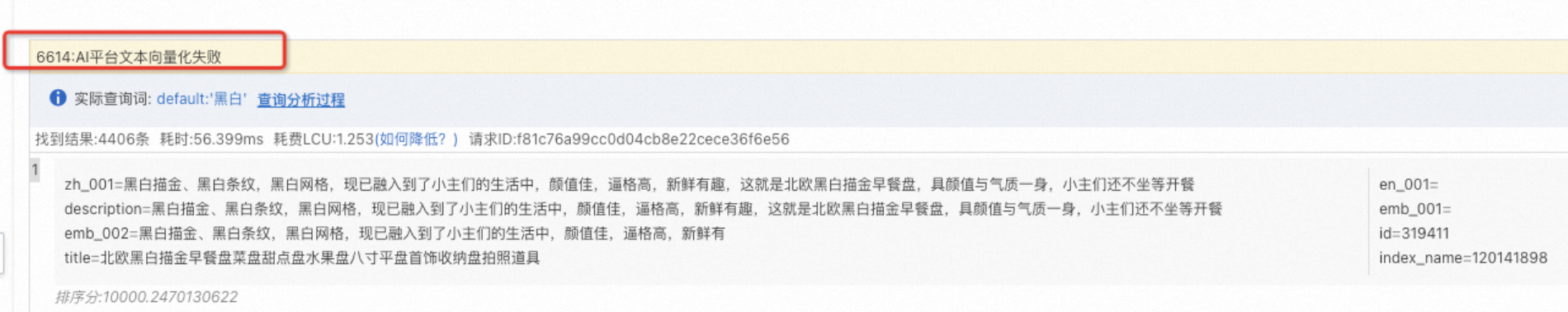

常见问题

调用搜索功能时,系统报错提示“6614:AI平台文本向量化失败”。

6614错误提示表示AI搜索开放平台配置发生错误导致调用服务时出错,可以按照以下步骤检查和解决: