阿里云人工智能平台PAI(Platform For AI)的模型在线服务EAS(Elastic Algorithm Service)提供了场景化部署方式,通过简单配置几个参数,您便可以一键部署集成了大语言模型(LLM)和检索增强生成(RAG)技术的对话系统服务,显著缩短服务部署时间。在使用该服务进行推理验证时,它能够有效地从知识库中检索相关信息,并与大语言模型的回答相结合,以产生准确且信息丰富的答案,从而大幅提高问答的质量和整体性能。该服务适用于问答、摘要生成和依赖外部知识的自然语言处理任务。本文将介绍如何通过RDS PostgreSQL构建向量检索库,部署RAG对话系统服务,以及进行模型推理验证的具体方法。

本方案依赖于RDS PostgreSQL实现。您可以加入RDS PostgreSQL插件交流钉钉群(103525002795),进行咨询、交流和反馈,获取更多关于插件的信息。

背景信息

大语言模型(LLM)在生成准确性和实时性回复方面存在局限,因此并不适合直接用于需要精确信息的客服或问答等场景。为了解决这一问题,当前业界广泛采用的方法是利用检索增强生成(Retrieval-Augmented Generation, RAG)技术来增强LLM的性能,这一技术可以显著提升问答、摘要生成以及其他需要引用外部知识的自然语言处理(NLP)任务的质量。

RAG通过将大语言模型(如通义千问)和信息检索组件结合在一起,增强了模型生成答案的准确性和信息量。在处理用户查询时,RAG通过信息检索组件在知识库中寻找与查询相关的文档或信息片段,将这些检索到的内容与原始查询一同输入大语言模型之后,模型能够利用现有的归纳生成能力产生基于最新信息的、符合事实的回复,而无需对模型进行重新训练。

EAS部署的对话系统服务,通过集成大语言模型(LLM)和检索增强生成(RAG)技术,克服了LLM在准确性和实时性方面的局限,为多种问答场景提供了准确且信息丰富的响应,从而提升了自然语言处理任务的整体效能和用户体验。

前提条件

注意事项

本实践受制于LLM服务的最大Token数量限制,旨在帮助您体验RAG对话系统的基本检索功能:

该对话系统受制于LLM服务的服务器资源大小以及默认Token数量限制,能支持的对话长度有限。

如果无需进行多轮对话,建议您关闭RAG服务的with chat history功能,这样能有效减少达到限制的可能性。详情请参见如何关闭RAG服务的with chat history功能。

步骤一:准备RDS PostgreSQL向量检索库

RAG支持通过RDS PostgreSQL构建向量检索库。您需要获取相关配置参数,以便后续连接向量检索库。

建议RDS PostgreSQL实例与RAG服务在同一地域,以便利用VPC内网进行通信。

为RDS实例创建账号和数据库,详情请参见创建账号和数据库。

其中:

创建账号时,账号类型选择高权限账号。

创建数据库时,授权账号选择已创建的高权限账号。

配置数据库连接。

访问RDS实例列表,在上方选择地域,然后单击目标实例ID。

在左侧导航栏单击数据库连接。

在数据库连接页面,查看数据库连接地址和相应端口号。

在shared_preload_libraries的运行参数值中添加pg_jieba。例如,将运行参数值改为

'pg_stat_statements,auto_explain,pg_cron'。详细操作请参见设置实例参数。说明RDS PostgreSQL使用pg_jieba插件进行中文分词,用于关键词检索与召回。

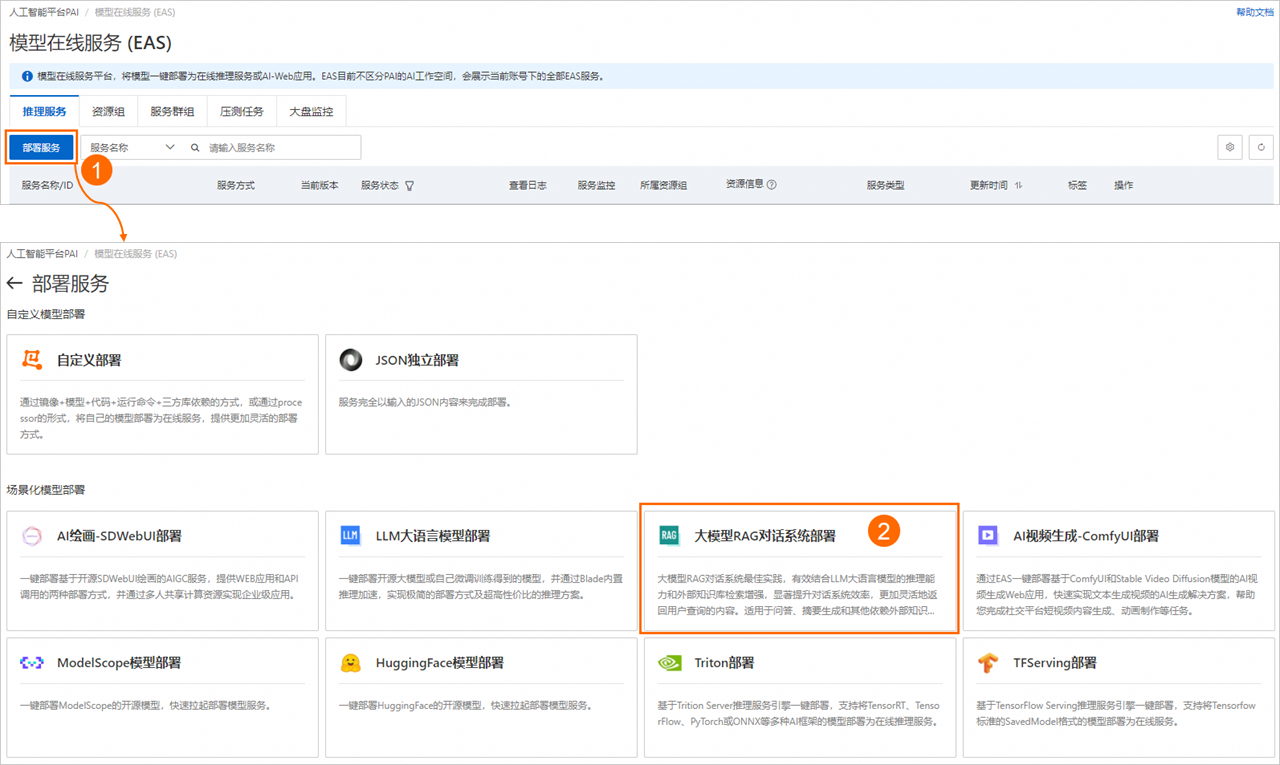

步骤二:部署RAG服务

进入模型在线服务页面。

在模型在线服务页面,单击部署服务,在场景化模型部署区域,单击大模型RAG对话系统部署。

在部署大模型RAG对话系统页面,配置以下关键参数。

基本信息

参数

描述

服务名称

自定义服务名称。

模型来源

支持使用开源公共模型或自持微调模型。

模型类别

根据您的使用场景,选择模型类型。

使用自持微调模型时,您需配置相应模型的参数量和精度。

模型配置

使用自持微调模型时,您需配置微调模型的文件路径。支持以下两种配置方法:

说明确保使用的模型文件格式与HuggingFace Transformers兼容。

按对象存储(OSS):请选择微调模型文件所在的OSS路径。

按文件存储(NAS):请选择微调模型文件所在的NAS文件系统和NAS源路径。

资源配置

参数

描述

资源配置选择

当使用开源公共模型时,系统会根据选定的模型类别自动推荐适合的实例规格,默认选中。

当使用自持微调模型时,请选择与目标模型相匹配的实例规格,详情请参见如何切换其他的开源大模型。

推理加速

目前,部署在A10或GU30系列机型上的Qwen、Llama2、ChatGLM或Baichuan2等系列模型服务,支持启用推理加速功能。支持以下两种加速类型:

PAI-BladeLLM自动推理加速:BladeLLM提供超高性价比的大模型推理加速能力,可帮助您一键享受高并发和低延时的技术优势。

开源框架vllm推理加速

向量检索库设置

参数

描述

版本类型

选择RDS PostgreSQL。

主机地址

配置为RDS PostgreSQL内网地址或外网地址。

使用内网地址:当RAG应用网络和数据库在同一地域时,您可以使用内网地址连接实例。

使用外网地址:当RAG应用网络和数据库在不同地域时,您需要为RDS PostgreSQL开通外网地址。具体操作,请参见开通或关闭外网地址。

端口

默认为5432,请根据实际情况填写。

数据库

配置为RDS PostgreSQL数据库名称。

表名称

请输入新的表名称或已存在的表名称。对于已存在的表,表结构应符合PAI-RAG要求,例如您可以填写之前通过EAS部署RAG服务时自动创建的表名称。

账号

配置为RDS PostgreSQL高权限账号。

密码

配置为RDS PostgreSQL高权限账号的密码。

专有网络配置

参数

描述

VPC

当主机地址使用内网地址时,RAG服务需要配置与RDS PostgreSQL实例一致的专有网络。

当主机地址使用外网地址时,您需要为RAG服务配置VPC和交换机,并为该VPC配置NAT网关和弹性公网IP(EIP),以便为RAG应用提供公网访问能力。具体操作,请参见使用公网NAT网关SNAT功能访问互联网。同时您需要将绑定的弹性公网IP添加到RDS PostgreSQL实例的公网访问白名单中,详情请参见设置白名单。

交换机

安全组名称

配置安全组。

重要请勿使用名称为created_by_rds的安全组,该安全组仅供系统管控使用。

单击部署。

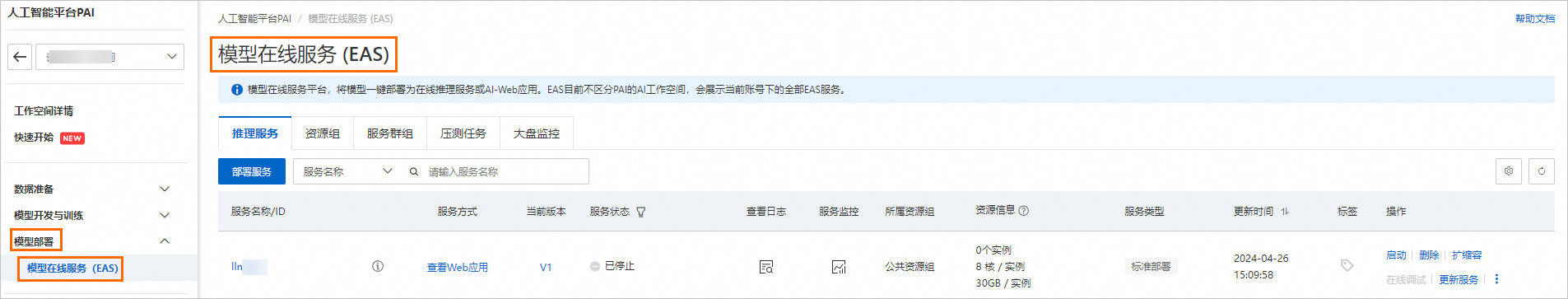

当服务状态变为运行中时,表示服务部署成功。

步骤三:通过WebUI页面进行模型推理验证

您可以先在WebUI页面,参考以下操作步骤对服务进行调试。当您在WebUI页面调试好问答效果后,可以基于PAI提供的API将其应用到您自己的业务系统中,详情请参见步骤三:通过API调用进行模型推理。

1、配置RAG对话系统

RAG服务部署成功后,单击服务方式列下的查看Web应用,启动WebUI页面。

配置机器学习模型。

Embedding Model Name:系统内置四种模型供您选择,将自动为您配置最合适的模型。

Embedding Dimension:选择Embedding Model Name后,系统会自动进行配置,无需手动操作。

测试向量检索库连接是否正常。

系统已自动识别并应用了部署服务时配置的向量检索库设置,并且该设置不支持修改。单击Connect PostgreSQL,验证RDS PostgreSQL连接是否正常。

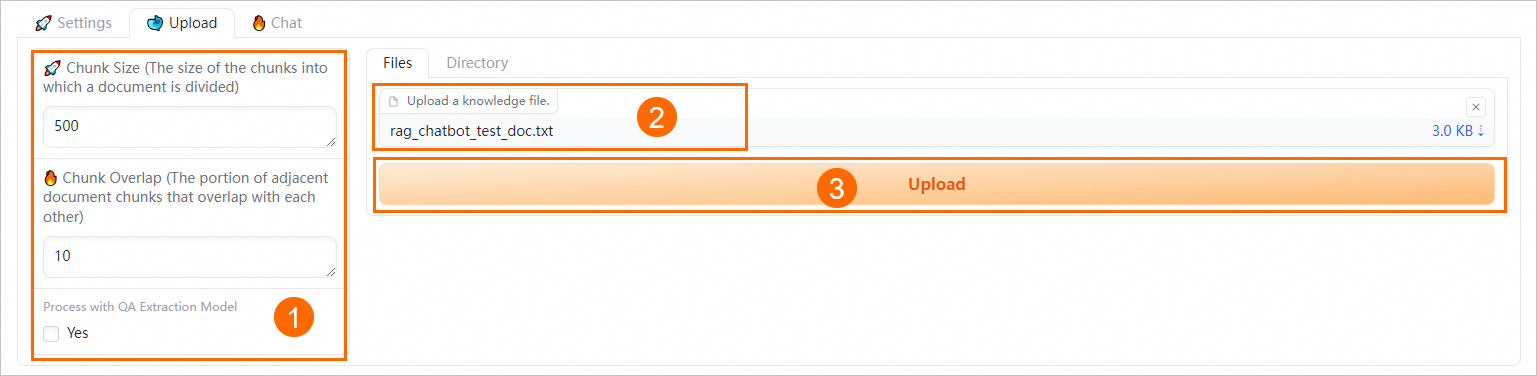

2、上传指定的业务数据文件

在Upload页签中,上传指定的业务数据文件,类型为.txt、.pdf、Excel(.xlsx或.xls)、.csv、Word(.docx或.doc)、Markdown或.html。

设置语义切块参数。

通过配置以下参数来控制文档切块粒度的大小和进行QA信息提取:

参数

描述

Chunk Size

指定每个分块的大小,单位为字节,默认为500。

Chunk Overlap

表示相邻分块之间的重叠量,默认为10。

Process with QA Extraction Model

通过选中Yes复选框启动QA信息提取功能,系统将在您上传业务数据文件后自动抽取出QA对,以获得更好的检索和回答效果。

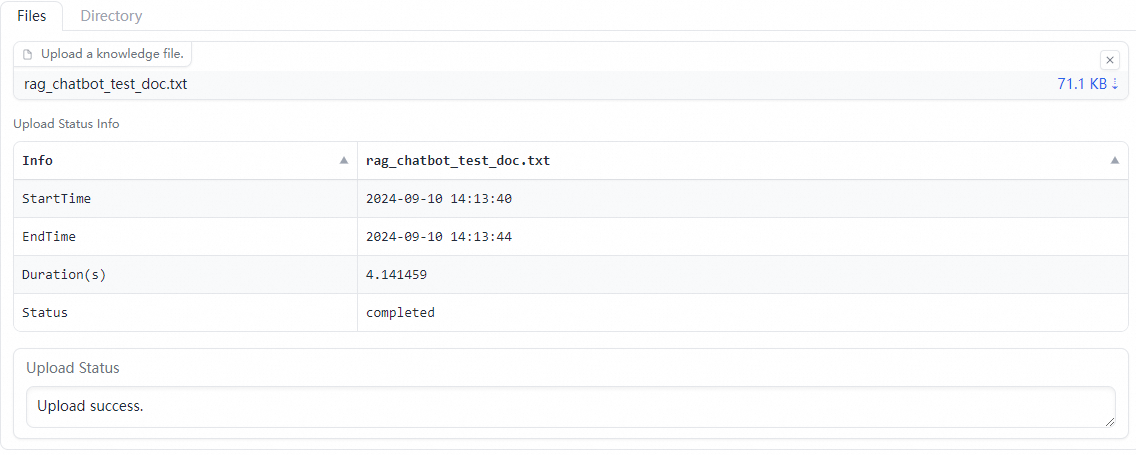

在Files或Directory页签下上传业务数据文件(支持多文件上传)或对应目录。例如rag_chatbot_test_doc.txt。

选中文件后,系统会先对上传的文件进行数据清洗(文本提取、超链接替换等)和语义切块,然后进行上传。

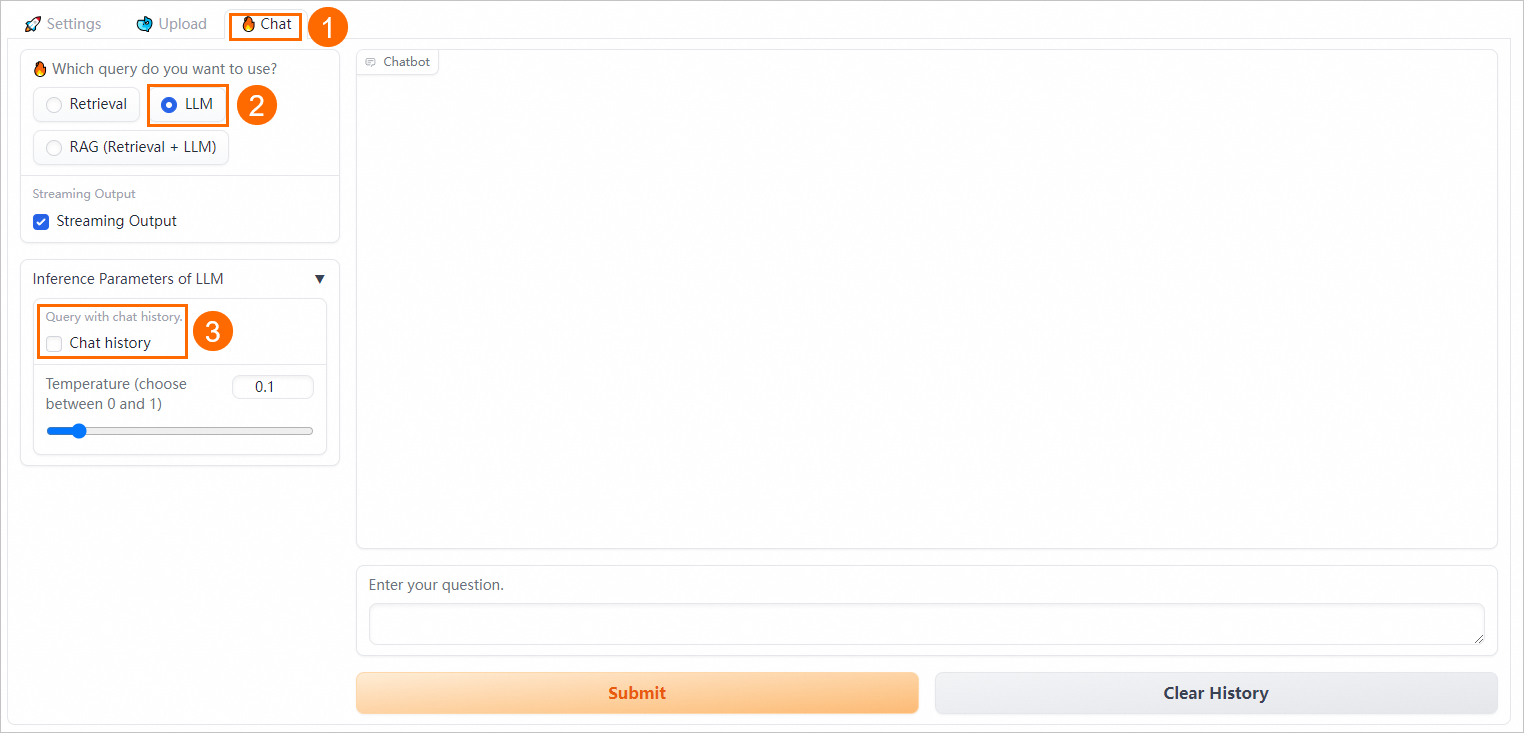

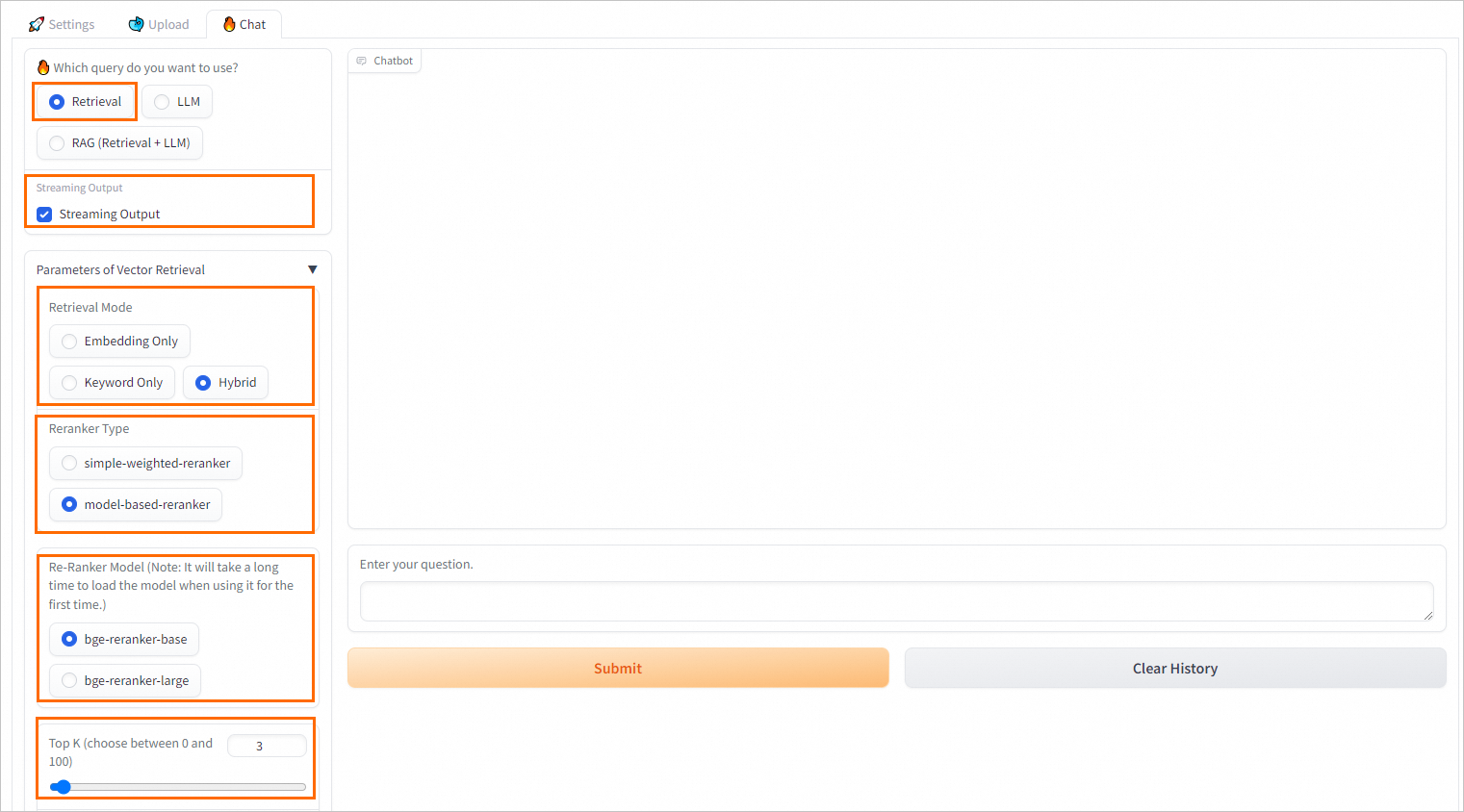

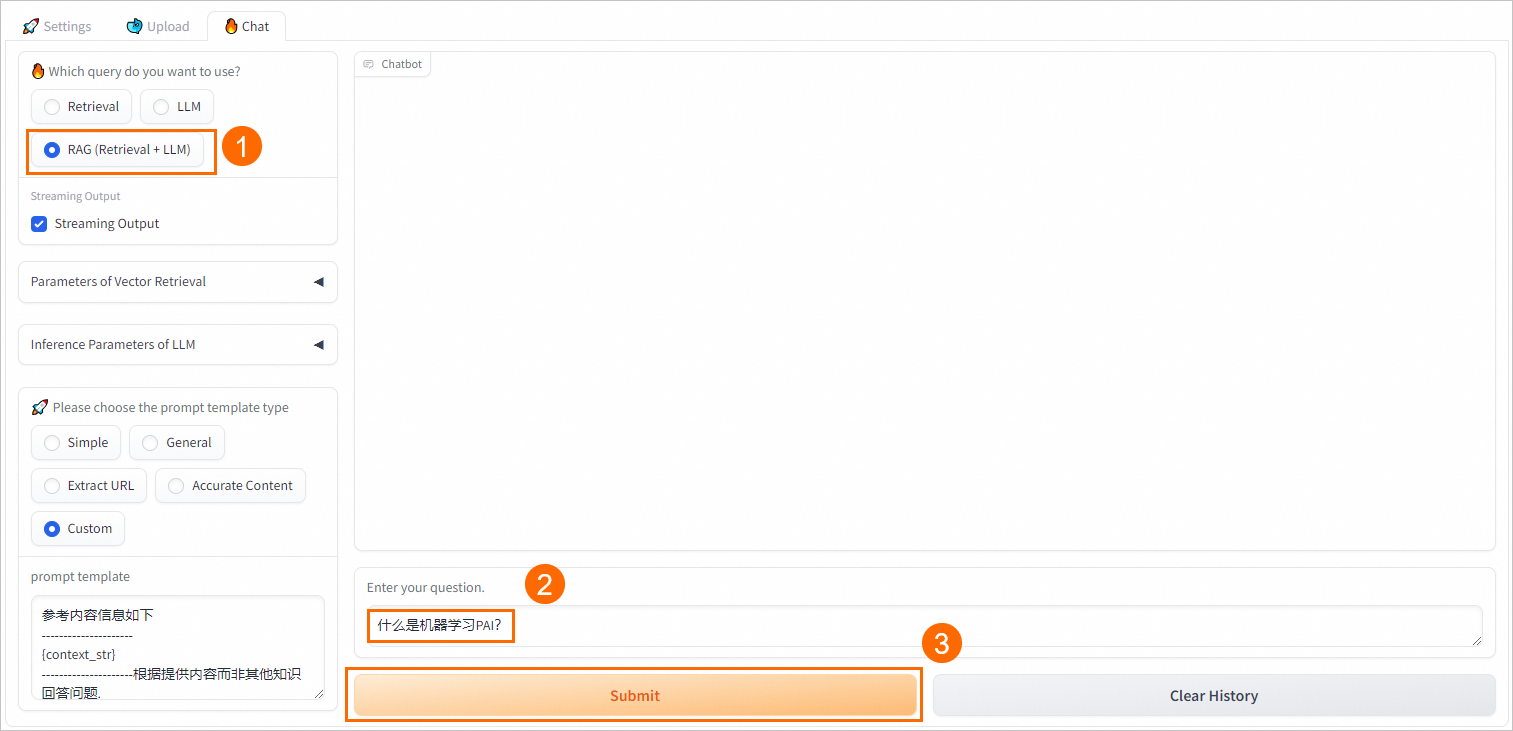

3、配置模型推理参数

在Chat页签中,配置问答策略。

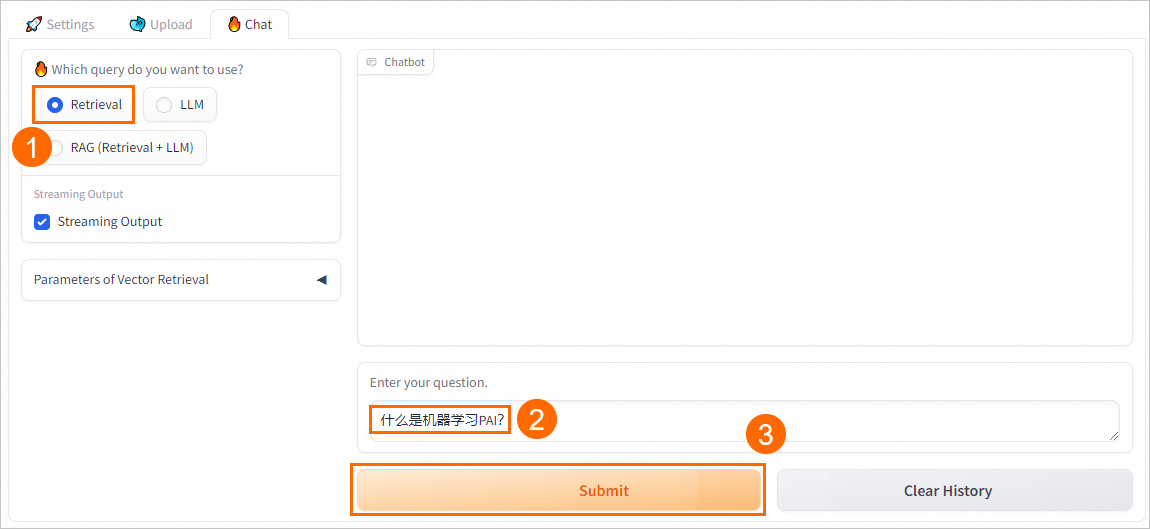

配置Retrieval问答策略

参数 | 说明 |

Streaming Output | 选中Streaming Output后,系统将以流式方式输出结果。 |

Retrieval Model | 支持以下三种检索方式:

说明 在大多数复杂场景下,向量数据库检索召回都能有较好的表现。但在某些语料稀缺的垂直领域,或要求准确匹配的场景,向量数据库检索召回方法可能不如传统的稀疏检索召回方法。稀疏检索召回方法通过计算用户查询与知识文档的关键词重叠度来进行检索,因此更为简单和高效。 RDS PostgreSQL通过pg_jieba插件实现对中文的分词,用于关键词召回。更多pg_jieba插件的使用说明,请参见中文分词(pg_jieba)。 |

Reranker Type | 大多数向量数据库为了计算效率会牺牲一定程度的准确性,这使其检索结果存在一定随机性,原始返回的Top K不一定最相关。您可以选择模型simple-weighted-reranker或model-based-reranker,对向量数据库第一次召回的Top K结果进行精度更高的Re-Rank操作,以得到相关度更高、更准确的知识文档。 说明 首次使用时,加载模型可能需要较长时间,请根据需要进行选择。 |

Top K | 向量检索库返回的相似结果数,即从向量数据库中召回Top K条相似结果。 |

Similarity Score Threshold | 相似度阈值,值越大,相似度越高。 |

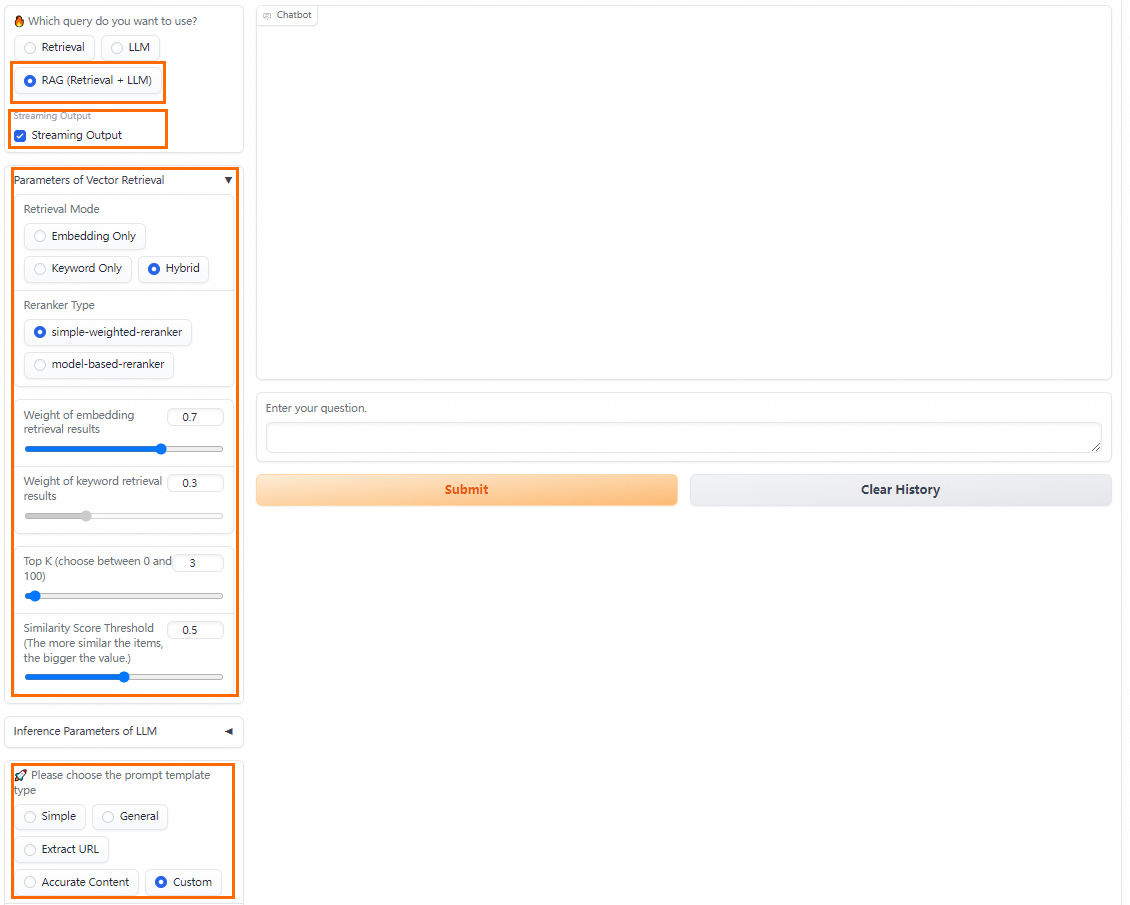

配置RAG(Retrieval + LLM)问答策略

PAI提供多种不同的Prompt策略,您可以选择合适的预定义Prompt模板或输入自定义的Prompt模板以获得更好的推理效果。

此外RAG(Retrieval + LLM)问答方式还支持配置Streaming Output、Retrieval Mode和Reranker Type等,关于这些参数的配置说明,请参见大模型RAG对话系统。

4、模型推理验证

Retrieval

直接从向量数据库中检索并返回Top K条相似结果。

LLM

直接与EAS-LLM对话,返回大模型的回答。

RAG(Retrieval + LLM)

将检索返回的结果与用户的问题输入至已选择的Prompt模板中,送入EAS-LLM服务,从中获取问答结果。

步骤四:通过API调用进行模型推理验证

获取RAG服务的调用信息。

单击RAG服务名称,进入服务详情页面。

在基本信息区域,单击查看调用信息。

在调用信息对话框的公网地址调用页签,获取服务访问地址和Token。

您还可以根据已生成的符合PAI-RAG格式的表结构,将企业知识库自行上传到向量检索库中。

通过API调用服务。

PAI提供了三种调用API的对话方式:

service/query/retrieval(Retrieval)、service/query/llm(LLM)和service/query(RAG)。具体调用方法如下:cURL 命令

发送单轮对话请求

方式一:

service/query/retrieval(Retrieval)curl -X 'POST' '<service_url>service/query/retrieval' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question": "什么是人工智能平台PAI?"}' # <service_url>替换为步骤1获取的服务访问地址;<service_token>替换为步骤1获取的服务Token。方式二:

/service/query/llm(LLM)curl -X 'POST' '<service_url>service/query/llm' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question": "什么是人工智能平台PAI?"}' # <service_url>替换为步骤1获取的服务访问地址;<service_token>替换为步骤1获取的服务Token。支持添加其他可调推理参数,例如

{"question":"什么是人工智能平台PAI?", "temperature": 0.9}。方式三:

service/query(RAG)curl -X 'POST' '<service_url>service/query' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question": "什么是人工智能平台PAI?"}' # <service_url>替换为步骤1获取的服务访问地址;<service_token>替换为步骤1获取的服务Token。支持添加其他可调推理参数,例如

{"question":"什么是人工智能平台PAI?", "temperature": 0.9}。

发送多轮对话请求

其中对话方式RAG和LLM支持发送多轮对话请求,以RAG对话为例,具体配置方法如下:

# 发送请求。 curl -X 'POST' '<service_url>service/query' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question": "什么是人工智能平台PAI?"}' # 传入上述请求返回的session_id(对话历史会话唯一标识),传入session_id后,将对话历史进行记录,调用大模型将自动携带存储的对话历史。 curl -X 'POST' '<service_url>service/query' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question": "它有什么优势?","session_id": "ed7a80e2e20442eab****"}' # 传入chat_history(用户与模型的对话历史),list中的每个元素是形式为{"user":"用户输入","bot":"模型输出"}的一轮对话,多轮对话按时间顺序排列。 curl -X 'POST' '<service_url>service/query' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question":"它有哪些功能?", "chat_history": [{"user":"PAI是什么?", "bot":"PAI是阿里云的人工智能平台......"}]}' # 同时传入session_id和chat_history,会用chat_history对存储的session_id所对应的对话历史进行追加更新。 curl -X 'POST' '<service_url>service/query' -H 'Authorization: <service_token>' -H 'accept: application/json' -H 'Content-Type: application/json' -d '{"question":"它有哪些功能?", "chat_history": [{"user":"PAI是什么?", "bot":"PAI是阿里云的人工智能平台......"}], "session_id": "1702ffxxad3xxx6fxxx97daf7c"}'

Python脚本

发送单轮对话请求,代码示例如下:

import requests EAS_URL = 'http://xxxx.****.cn-beijing.pai-eas.aliyuncs.com' headers = { 'accept': 'application/json', 'Content-Type': 'application/json', 'Authorization': 'MDA5NmJkNzkyMGM1Zj****YzM4M2YwMDUzZTdiZmI5YzljYjZmNA==', } def test_post_api_query_llm(): url = EAS_URL + '/service/query/llm' data = { "question":"什么是人工智能平台PAI?" } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"======= Question =======\n {data['question']}") print(f"======= Answer =======\n {ans['answer']} \n\n") def test_post_api_query_retrieval(): url = EAS_URL + '/service/query/retrieval' data = { "question":"什么是人工智能平台PAI?" } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"======= Question =======\n {data['question']}") print(f"======= Answer =======\n {ans['docs']}\n\n") def test_post_api_query_rag(): url = EAS_URL + '/service/query' data = { "question":"什么是人工智能平台PAI?" } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"======= Question =======\n {data['question']}") print(f"======= Answer =======\n {ans['answer']}") print(f"======= Retrieved Docs =======\n {ans['docs']}\n\n") # LLM test_post_api_query_llm() # Retrieval test_post_api_query_retrieval() # RAG(Retrieval+LLM) test_post_api_query_rag()其中:EAS_URL配置为RAG服务的访问地址,您需要将访问地址末尾的

/删除;Authorization配置为RAG服务的Token。发送多轮对话请求

LLM和RAG(Retrieval+LLM)支持发送多轮对话请求,代码示例如下:

import requests EAS_URL = 'http://xxxx.****.cn-beijing.pai-eas.aliyuncs.com' headers = { 'accept': 'application/json', 'Content-Type': 'application/json', 'Authorization': 'MDA5NmJkN****jNlMDgzYzM4M2YwMDUzZTdiZmI5YzljYjZmNA==', } def test_post_api_query_llm_with_chat_history(): url = EAS_URL + '/service/query/llm' # Round 1 query data = { "question":"什么是人工智能平台PAI?" } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"=======Round 1: Question =======\n {data['question']}") print(f"=======Round 1: Answer =======\n {ans['answer']} session_id: {ans['session_id']} \n") # Round 2 query data_2 = { "question": "它有什么优势?", "session_id": ans['session_id'] } response_2 = requests.post(url, headers=headers, json=data_2) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans_2 = dict(response_2.json()) print(f"=======Round 2: Question =======\n {data_2['question']}") print(f"=======Round 2: Answer =======\n {ans_2['answer']} session_id: {ans_2['session_id']} \n\n") def test_post_api_query_rag_with_chat_history(): url = EAS_URL + '/service/query' # Round 1 query data = { "question":"什么是人工智能平台PAI?" } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"=======Round 1: Question =======\n {data['question']}") print(f"=======Round 1: Answer =======\n {ans['answer']} session_id: {ans['session_id']}") print(f"=======Round 1: Retrieved Docs =======\n {ans['docs']}\n") # Round 2 query data = { "question":"它可以做什么?", "session_id": ans['session_id'] } response = requests.post(url, headers=headers, json=data) if response.status_code != 200: raise ValueError(f'Error post to {url}, code: {response.status_code}') ans = dict(response.json()) print(f"=======Round 2: Question =======\n {data['question']}") print(f"=======Round 2: Answer =======\n {ans['answer']} session_id: {ans['session_id']}") print(f"=======Round 2: Retrieved Docs =======\n {ans['docs']}") # LLM test_post_api_query_llm_with_chat_history() # RAG(Retrieval+LLM) test_post_api_query_rag_with_chat_history()其中:EAS_URL配置为RAG服务的访问地址,您需要将访问地址末尾的

/删除;Authorization配置为RAG服务的Token。

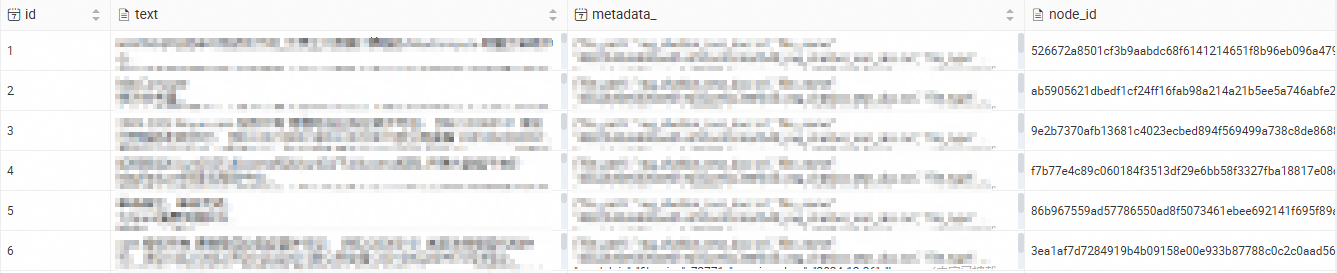

RDS PostgreSQL特色功能支持

连接作为向量检索库的RDS PostgreSQL数据库后,可以查看已导入的知识库内容。连接数据库请参见连接PostgreSQL实例。

相关文档

通过EAS,您还可以完成以下场景化部署:

部署支持WebUI和API调用的LLM大语言模型,并在部署LLM应用后,利用LangChain框架集成企业知识库,实现智能问答和自动化功能。详情请参见5分钟使用EAS一键部署LLM大语言模型应用。

部署基于ComfyUI和Stable Video Diffusion模型的AI视频生成服务,帮助您完成社交平台短视频内容生成、动画制作等任务。详情请参见AI视频生成-ComfyUI部署。

常见问题

如何关闭RAG服务的with chat history功能

在RAG服务的WebUI页面中,去勾选Chat history复选框。