如果需要将表格存储中新增和变化的数据定期同步到OSS中备份或者使用,您可以通过在DataWorks数据集成控制台新建和配置离线同步任务来实现周期性增量数据同步。

注意事项

准备工作

已开通OSS服务并创建存储空间Bucket。具体操作,请参见开通OSS服务和通过控制台创建存储空间。

已确认和记录表格存储中要同步到OSS的实例、数据表或者时序表信息。

已开通DataWorks服务并创建工作空间。具体操作,请参见开通DataWorks服务和创建工作空间。

已创建RAM用户并为RAM用户授予OSS完全管理权限(AliyunOSSFullAccess)和管理表格存储权限(AliyunOTSFullAccess)。具体操作,请参见创建RAM用户和为RAM用户授权。

由于配置时需要填写访问密钥AccessKey(AK)信息来执行授权,为避免阿里云账号泄露AccessKey带来的安全风险,建议您通过RAM用户来完成授权和AccessKey的创建。

已为RAM用户创建AccessKey。具体操作,请参见创建AccessKey。

已新增表格存储数据源和OSS数据源。具体操作,请参见步骤一:新增表格存储数据源和步骤二:新增OSS数据源。

步骤一:新建同步任务节点

进入数据开发页面。

登录DataWorks控制台,切换至目标地域后,单击左侧导航栏的,在下拉框中选择对应工作空间后单击进入数据开发。

在DataStudio控制台的数据开发页面,单击业务流程节点下的目标业务流程。

如果需要新建业务流程,请参见创建业务流程。

在数据集成节点上右键选择新建节点 > 离线同步。

在新建节点对话框,选择路径并填写节点名称。

单击确认。

在数据集成节点下会显示新建的离线同步节点。

步骤二:配置离线同步任务并启动

配置表格存储到OSS的增量数据同步任务,请根据所用数据存储模型选择相应任务配置方式。

如果所用的数据存储模型是宽表模型(即使用数据表存储数据),则需要同步数据表中的数据,请按照同步数据表数据的任务配置进行配置。

如果所用的数据存储模型是时序模型(即使用时序表存储数据),则需要同步时序表中的数据,请按照同步时序表数据的任务配置进行配置。

步骤三:配置调度属性

通过调度配置,您可以配置同步任务的执行时间、重跑属性、调度依赖等。

单击任务右侧的调度配置。

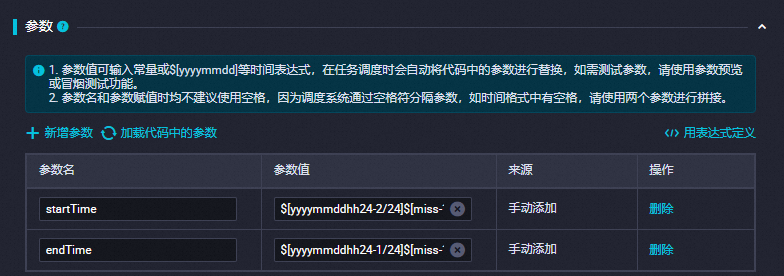

在调度配置面板的参数部分,单击新增参数,根据下表说明新增参数。更多信息,请参见调度参数支持的格式。

参数

参数值

参数

参数值

startTime

$[yyyymmddhh24-2/24]$[miss-10/24/60]

endTime

$[yyyymmddhh24-1/24]$[miss-10/24/60]

配置示例如下图所示。

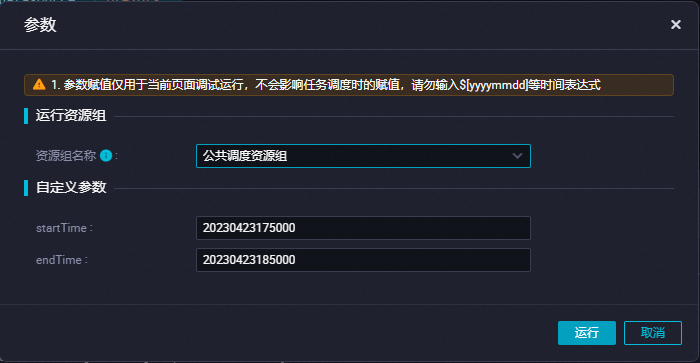

假如任务运行时的时间为2023年04月23日19:00:00点,则startTime为20230423175000,endTime为20230423185000。任务将会同步17:50到18:50时段内新增的数据。

在时间属性部分,配置时间属性。更多信息,请参见时间属性配置说明。

此处以任务整点每小时自动运行为例介绍配置,如下图所示。

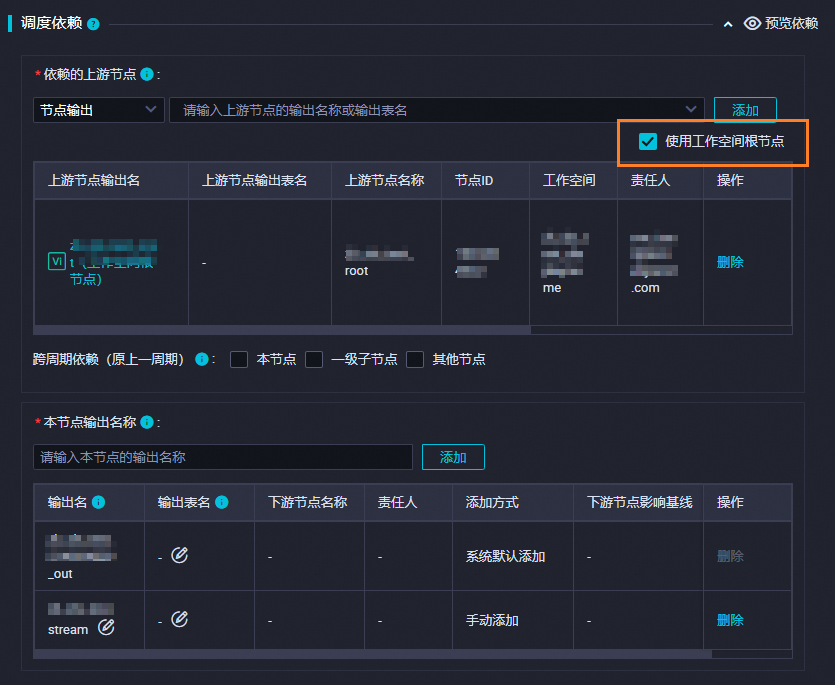

在调度依赖部分,选中使用工作空间根节点复选框,系统会自动生成依赖的上游节点信息。

使用工作空间根节点表示该任务无上游的依赖任务。

配置完成后,关闭配置调度面板。

步骤四:调试代码并提交任务

(可选)根据需要调试脚本代码。

通过调试脚本代码,确保同步任务能成功同步表格存储的增量数据到OSS中。

调试脚本代码时配置的时间范围内的数据可能会多次导入到OSS中,相同数据行会覆盖写入到OSS中。

单击

图标。

图标。在参数对话框,选择运行资源组的名称,并配置自定义参数。

自定义参数的格式为

yyyyMMddHHmmss,例如20230423175000。

单击运行。

提交同步任务。

提交同步任务后,同步任务会按照配置的调度属性进行运行。

单击

图标。

图标。在提交对话框,根据需要填写变更描述。

单击确认。

步骤五:查看任务执行结果

在DataWorks控制台查看任务运行状态。

单击同步任务工具栏右侧的运维。

在周期实例页面的实例视角页签,查看实例的运行状态。

在OSS管理控制台查看数据同步结果。

登录OSS管理控制台。

在Bucket列表页面,找到目标Bucket后,单击Bucket名称。

在文件列表页签,选择相应文件,下载后可查看内容是否符合预期。

常见问题

相关文档

- 本页导读 (1)

- 注意事项

- 准备工作

- 步骤一:新建同步任务节点

- 步骤二:配置离线同步任务并启动

- 同步数据表数据的任务配置

- 同步时序表数据的任务配置

- 步骤三:配置调度属性

- 步骤四:调试代码并提交任务

- 步骤五:查看任务执行结果

- 常见问题

- 相关文档

图标,保存配置。

图标,保存配置。 图标,然后在弹出的对话框中单击确认。

图标,然后在弹出的对话框中单击确认。