为了有效排查和解决GPU云服务器的相关问题,本文为您汇总了使用GPU时遇到的一些常见问题。

类别 | 相关问题 |

GPU实例 | |

GPU显卡 | |

GPU显存 | |

GPU驱动 | |

GPU监控 | |

其他 |

GPU实例

GPU实例支持安卓模拟器吗?

仅部分GPU实例支持安装安卓模拟器。

除GPU计算型弹性裸金属服务器实例规格族ebmgn7e、ebmgn7ex、ebmgn7i、ebmgn7、ebmgn6ia、ebmgn6e、ebmgn6v、ebmgn6i以及sccgn7ex支持安卓模拟器外,其他类型的GPU实例均不支持安卓模拟器。

GPU实例的配置支持变更吗?

仅部分GPU实例的配置支持变更。

详细的实例规格变配支持情况,请参见规格变更限制与自检。

普通ECS实例规格族是否支持升级或变更为GPU实例规格族?

普通ECS实例规格族不支持直接升级或变更为GPU实例规格族。

详细的实例规格变配支持情况,请参见规格变更限制与自检。

如果您的业务涉及AI推理相关内容,您可以购买弹性加速计算实例EAIS,通过该服务实现为ECS实例远程增加GPU显卡的效果。EAIS能够将CPU资源与GPU资源解耦,帮助您将GPU资源附加到ECS实例上,构建成您希望得到的GPU实例规格。关于弹性加速计算实例EAIS的更多信息,请参见什么是弹性加速计算实例EAIS。

如何在GPU实例和普通ECS实例间传输数据?

无需特别设置即可传输数据。

GPU实例除了GPU加速能力外,保留了与普通ECS实例一致的使用体验。同一安全组内的GPU实例和ECS实例之间默认内网互通,所以您无需特别设置。

GPU与CPU有什么区别?

GPU与CPU的对比如下表所示:

对比项 | ||

算术运算单元(ALU) | 拥有大量擅长处理大规模并发计算的算术运算单元(ALU)。 | 拥有强大的算术运算单元(ALU),但数量较少。 |

逻辑控制单元 | 拥有相对简单的逻辑控制单元。 | 拥有复杂的逻辑控制单元。 |

缓存 | 拥有很少的缓存,且缓存用于服务线程,而不是用于保存访问的数据。 | 拥有大量的缓存结构,能够将数据保存至缓存,从而提高访问速度,降低时延。 |

响应方式 | 需要将全部任务整合后,再进行批处理。 | 实时响应,对单个任务的响应速度较高。 |

适用场景 | 适用于计算密集,相似度高,且多线程并行的高吞吐量运算场景。 | 适用于对响应速度有要求,且逻辑复杂的串行运算场景。 |

GPU显卡

购买GPU实例后,为什么执行nvidia-smi命令找不到GPU显卡?

问题原因:当您执行nvidia-smi命令无法找到GPU显卡时,通常是由于您的GPU实例未安装或者未成功安装Tesla或GRID驱动。

解决措施:请根据您所购买的GPU实例规格选择对应的操作来安装相应驱动,才能正常使用GPU实例的高性能特性。具体说明如下:

GPU虚拟化型实例,请务必安装GRID驱动。具体操作,请参见:

GPU计算型实例,可以安装Tesla驱动或GRID驱动。具体操作,请参见:

如何查看GPU显卡的详细信息?

不同操作系统的GPU实例,查看GPU显卡信息的操作有所不同,具体说明如下:

针对Linux操作系统,您可以执行

nvidia-smi命令查看GPU显卡的详细信息。针对Windows操作系统,您可以在中查看GPU显卡的详细信息。

普通ECS实例可以增加GPU显卡吗?

可以。

如果您的业务涉及AI推理相关内容,您需要购买弹性加速计算实例EAIS,该服务能够将CPU资源与GPU资源解耦,帮助您将GPU资源附加到ECS实例上,构建成您希望得到的GPU实例规格,从而实现为ECS实例远程增加GPU显卡。关于弹性加速计算实例EAIS的更多信息,请参见什么是弹性加速计算实例EAIS。

在Linux系统上使用GPU时出现GPU初始化失败(如RmInitAdapter failed!)问题

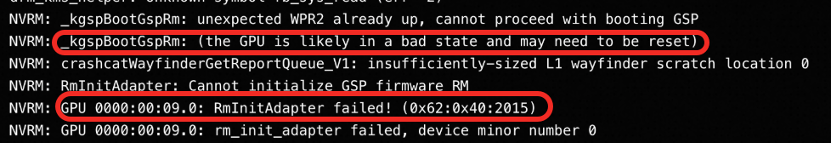

问题现象:使用GPU实例时出现GPU设备离线,系统无法识别显卡设备。例如在Linux系统上使用GPU时,出现GPU卡初始化失败的错误提示。执行

sh nvidia-bug-report.sh命令后,在生成的日志中,看到RmInitAdapter failed错误信息,如下图所示:

问题原因:可能是GPU的GSP(GPU System Processor)组件运行状态异常,导致触发设备离线,系统无法识别显卡设备。

解决方案:通过控制台重启实例,可完成一次彻底的GPU reset,通常可解决此问题。如果问题仍然存在,请参考使用GPU时出现XID 119/XID 120错误导致GPU掉卡进一步处理,建议关闭GSP功能。

GPU显存

为什么48G显存的GPU实例,nvidia-smi显示的总显存少了约3G?

这是因为开启了ECC(错误检查和纠正)功能,ECC会按比例占用部分显存(48G实例约占用2-3G)。可通过nvidia-smi命令检查ECC状态,OFF代表未开启,ON代表开启。

如何禁用GPU的ECC功能以释放显存?

命令行操作: 停止所有使用GPU的进程,执行

nvidia-smi -e 0禁用,再执行nvidia-smi -r重置GPU。启动脚本操作: 将

nvidia-smi -e 0和nvidia-smi -r写入/etc/rc.local(部分系统为/etc/rc.d/rc.local)启动脚本首行,重启实例。

用nvidia-smi -e 0 禁用ecc出现报错提示the following GPUs cloud not another client如何处理?

报错说明仍有组件或进程在使用GPU。请确保机器上无GPU进程运行。如果无法手动停止,建议做好快照备份后,将nvidia-smi -e 0和nvidia-smi -r命令写入启动脚本/etc/rc.local(部分系统为/etc/rc.d/rc.local),重启实例生效。

GPU服务器支持单独扩容显存吗?

不支持。显存大小与实例规格绑定。如需更大显存:

方式一更换规格: 升级到更高配置的实例,请在业务低峰期操作并备份数据。GPU计算型(gn/ebm/scc系列)

方式二使用EAIS: 通过弹性加速计算实例EAIS挂载额外的GPU资源。

GPU驱动

GPU虚拟化型实例需要安装什么驱动?

GPU虚拟化型实例需要安装GRID驱动。

针对通用计算场景或图形加速场景,您可以在创建GPU实例时同步加载GRID驱动,也可以在创建GPU实例后通过云助手方式安装GRID驱动,安装方式如下:

创建新实例时,同步加载GRID驱动。具体操作,请参见通过预装驱动的镜像加载GRID驱动。

创建实例后,通过云助手安装GRID驱动。具体操作,请参见:

GPU虚拟化型实例是否支持将CUDA升级到12.4或将NVIDIA驱动升级到550以上?

不支持。

虚拟化GPU实例依赖于平台提供的GRID驱动,其版本更新受限,无法随意安装NVIDIA官网驱动。如需升级,可使用gn/ebm系列GPU实例。

在GPU计算型实例上使用OpenGL、Direct3D等工具做图形加速时,需要安装什么驱动?

请根据您所使用的GPU实例的操作系统来安装相应驱动。具体说明如下:

针对Linux操作系统的GPU计算型实例,请安装Tesla驱动。具体操作,请参见:

针对Windows操作系统的GPU计算型实例,请安装GRID驱动。具体操作,请参见:

为什么创建GPU实例时选择的CUDA版本与安装完成后查看到的CUDA版本不一致?

您执行命令nvidia-smi查询到的CUDA版本代表您的GPU实例能够支持的最高CUDA版本,并不代表您创建GPU实例时选择的CUDA版本。

GPU实例(Windows系统)安装GRID驱动后,通过控制台VNC远程连接该实例出现黑屏怎么办?

问题原因:当Windows操作系统的GPU实例安装了GRID驱动后,虚拟机(VM)的显示输出被GRID驱动接管,VNC无法再获取到集成显卡的画面,因此,VNC显示会变成黑屏状态,属于正常现象。

解决方案:使用Workbench连接GPU实例。具体操作,请参见使用Workbench登录Windows实例。

如何获取GRID License?

请根据您使用的操作系统查看对应的获取方式,具体说明如下:

针对在Windows操作系统的GPU实例上安装GRID驱动,请通过预装驱动镜像方式或者手动方式获取。

针对在Linux操作系统的GPU实例上安装GRID驱动,请通过预装驱动镜像方式或者云助手方式获取。

如何升级GPU驱动(Tesla驱动或GRID驱动)?

GPU驱动(Tesla驱动或GRID驱动)不能直接升级版本,需要先卸载之前的旧版本驱动,然后重启系统来安装新版本驱动,具体操作,请参见升级Tesla或GRID驱动。

建议您在业务低峰期升级驱动,升级前请先创建快照备份云盘数据,避免数据丢失,具体操作,请参见手动创建单个快照。

安装 NVIDIA 驱动版本 570.124.xx(Linux)或 572.61(Windows)后系统崩溃,出现kernel NULL pointer dereference错误

问题现象:在部分实例规格中,安装570.124.xx(Linux)/572.61(Windows)版本NVIDIA驱动或安装后执行

nvidia-smi命令时,系统报错kernel NULL pointer dereference。日志如下所示:解决方案:请避免使用570.124.xx(Linux)/572.61(Windows)版本驱动,推荐使用570.133.20(Linux)/572.83(Windows)或更高版本。

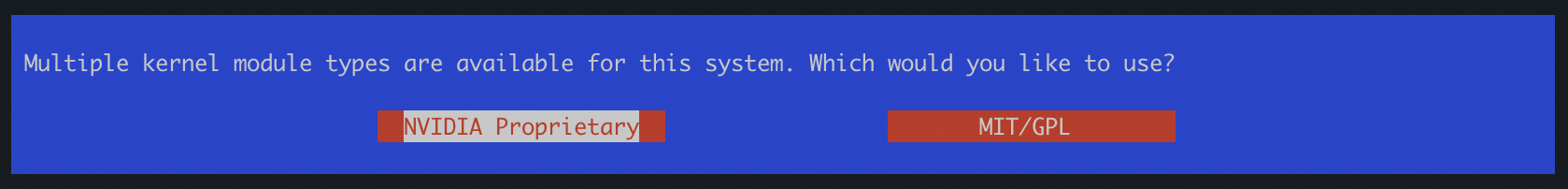

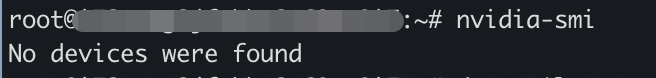

安装驱动时kernel module types选择NVIDIA Proprietary,执行nvidia-smi命令报错No devices were found

问题现象:在部分实例规格中,安装驱动时kernel module types选择NVIDIA Proprietary,安装完成后执行nvidia-smi命令报错

No devices were found(找不到GPU设备)。

问题原因:不是所有的GPU型号都兼容NVIDIA Proprietary驱动。

kernel module types配置建议:

对于Blackwell架构GPU:必须使用开源驱动(选择

MIT/GPL)。对于Turing、Ampere、Ada Lovelace、Hopper架构GPU:推荐使用开源驱动(选择

MIT/GPL)。对于Maxwell、Pascal、Volta架构GPU:仅支持选择

NVIDIA Proprietary。

GPU监控

如何查看GPU实例的资源使用量(vCPU、网络流量、带宽以及磁盘等)?

如需查看实例的vCPU使用率、内存、系统平均负载、内网带宽 、公网带宽、网络连接数、磁盘使用与读取、GPU使用率,显存使用量、GPU功率等监控数据,请通过以下方法查询。

云产品控制台

云服务器ECS控制台:提供vCPU使用率、网络流量、磁盘I/O以及GPU监控等指标信息。具体操作,请参见通过ECS控制台查看监控信息。

云监控控制台:提供更加精细化的监控粒度,例如查看基础监控、操作系统监控、GPU监控、网络监控、进程监控以及云盘监控等指标信息,更多信息,请参见主机监控。

费用与成本中心

在查看用量明细页面,通过筛选以下字段(以查看ECS实例的流量使用情况为例),即包括待查询的时间周期、商品名称(云产品名称)、计费项名称,计量规格以及计量粒度字段,单击导出CSV,导出实例的相关资源使用量信息。具体操作,请参见账单详情。

说明

说明用量明细所提供的数据为资源的原始用量,与账单明细所提供的参与计费的用量数据不一致,查询结果仅供参考,不作为对账依据。

其他

如何安装cGPU服务?

无论您是企业认证用户还是个人实名认证用户,推荐您通过ACK的Docker运行时环境安装和使用cGPU服务。具体操作,请参见管理共享GPU调度组件。

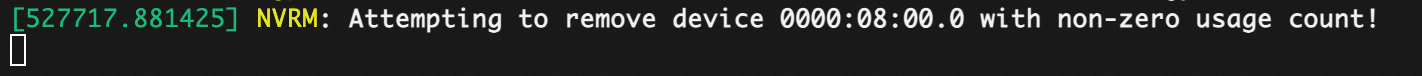

安装cGPU服务后执行nvidia-smi -r卡住

问题现象:在已加载 cGPU 服务(可通过

lsmod | grep cgpu确认)的环境下,执行nvidia-smi -r重置 GPU 时,命令卡死且无法被终止(kill),同时dmesg系统日志中出现报错信息。

问题原因:cGPU 组件仍占用了 GPU 设备,导致硬件重置操作被阻塞。

解决方案:

卸载 cGPU:请先卸载 cGPU 组件,卸载后

nvidia-smi -r会恢复执行并返回结果。重启实例:若卸载后仍存在问题,请在控制台重启实例(在实例内部执行reboot无效)。

重要加载cGPU时请勿重置GPU(如执行

nvidia-smi -r、解绑设备或重装驱动)。请务必先卸载cGPU再进行操作,以免引发故障。