音视频终端SDK(后续统称“MediaBox音视频SDK”)集成了直播推流、视频播放、短视频创作、美颜特效、音频特效等核心能力为您提供一体化SDK,支持移动端、桌面端、Web端等多终端接入,搭配开源UI组件和产品级Demo,您可以根据业务需求集成对应SDK或采用低代码方式快速搭建所需应用。

产品架构

底层依托视频直播、视频点播、智能媒体服务,覆盖直播、点播业务中的拍摄、编辑、上传、推流到播放等核心环节,同时融合端侧增强、美颜特效等音视频AI能力,提供产品级Demo、低代码快速集成AUI Kits。

产品优势

提供一体化SDK集成方案

融合直播和点播核心能力,复用核心组件,缩小SDK包体积。

一次性批量接入多个功能模块,提升集成效率,节省研发对接成本。

提供单独的SDK集成方案

按照业务需要自由组合功能模块,按需打包贴合业务场景。

产品级Demo

产品级Demo提供直播、点播全功能能力,便于快速整合。

服务多样

完善的指标体系确保服务质量,音视频AI提升音视频利用和分发效率。

功能稳定

经过数亿级请求量的打磨,音视频服务质量稳定可靠,为您提供流畅清晰的体验。

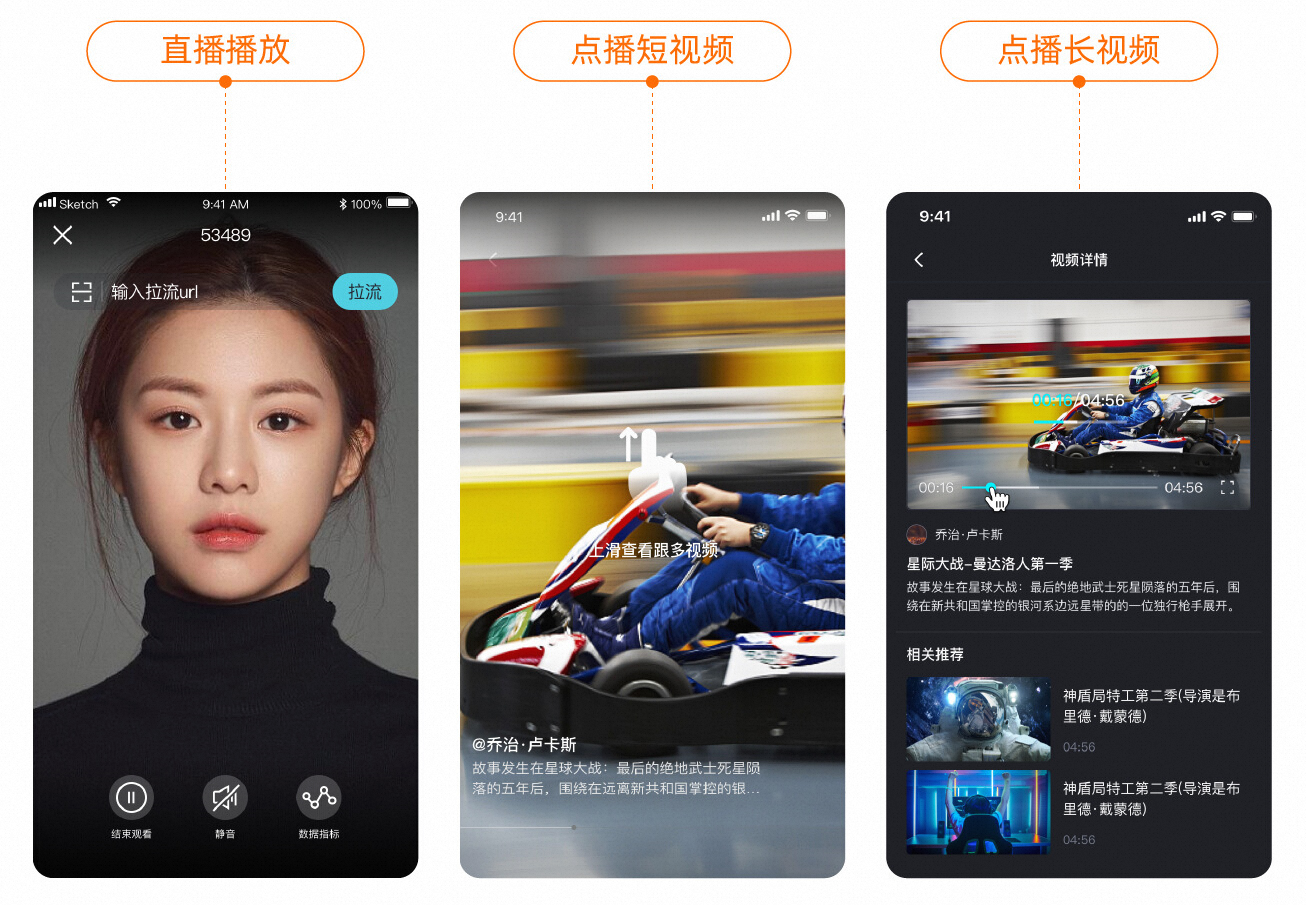

Demo体验

MediaBox音视频SDK Demo提供完整的产品级的交互UI和业务源码,帮助开发者快速实现业务需求,节约开发时间和成本。Demo下载及详细说明,请参见Demo体验。

应用场景

音视频播放

提供高稳定、高性能、全平台的音视频解码能力,适用于视频直播、视频点播、音频收听等音视频消费场景。

应用场景 | 说明 |

短视频 | 使用播放器SDK搭配网络优化、预加载、本地缓存等功能,实现首屏秒开,提供流畅的播放体验。 |

长视频 | 使用播放器SDK提供的多码率自适应、变速不变调、端侧画质增强等功能,结合云端服务为长视频观看提供进度条缩略图、防遮弹幕、ASS字幕等多样玩法,同时配合多重安全策略确保视频安全。 |

在线教育 | 播放器SDK全端覆盖充分满足业务需求,现已支持移动端(Android、iOS)、桌面端(Windows、macOS、Linux)和跨端方案(Web、Flutter),同时支持标准加密、私有加密和DRM加密方案有效的实现版权保护。 |

直播与直播转点播 | 播放器SDK同时支持视频直播、点播常见协议,无缝对接直播服务,支持直播时移、伪直播、直播录制视频回看,实现音视频业务闭环。 |

直播推流与连麦互动

提升网络波动抵抗力和传输速度,提供稳定、极速的直播体验,常用于教育、娱乐、游戏、连麦等场景。

应用场景 | 说明 |

教育直播 | 提供互动消息SDK实现文字实时互动,提升师生间的互动;提供直播推流SDK让教师随时随地为学生解惑答疑;提供云端录制、转码等功能,学生可以随时回看课程,温习知识点,增强学习效果。 |

娱乐直播 | 提供实时聊天、点赞和打赏等功能,增强主播与观众的互动;同时对内容的安全性(如涉黄、暴恐等)进行严格把关,借助直播智能审核功能有效降低审核成本。 |

游戏直播 | 提供录屏技术将当前游戏画面和摄像头采集画面合并,通过直播推流SDK发起推流,推流 SDK支持录屏功能;同时提供互动消息SDK实现聊天、点赞和打赏等交互行为;提供直播录制回放,对游戏中的精彩内容进行回放。 |

连麦互动 | 提供稳定、高质量、超低延时的互动实时音视频服务。支持主播与主播、主播与观众实时连麦、主播跨房间互动等多画面实时视频互动,并可将互动视频流推送至直播中心进行大规模分发,推送给未连麦的观众。 |

短视频创作

快速上线短视频采集、制作和播放等必备功能,适用于娱乐、社交、教育、新闻资讯、电商等对短视频拍摄制作和多创意玩法有需求的场景。

应用场景 | 说明 |

新闻资讯短视频 | 提供移动端短视频录制,可实时拍摄新闻内容,分享最新资讯,集编辑、上传、转码、存储、资源管理和云端编辑于一体,实现新闻的快速制作和发布。 |

社交娱乐短视频 | 通过移动端快速拍摄,搭配美颜滤镜、人脸贴图、动态贴纸、字幕音乐、剪辑拼接等功能,可制作专属视频,实现快速上传和实时分享。 |

电商产品短视频 | 提供快速拍摄和短片制作能力,全面和立体的展示商品特色。配合动图、字幕、音乐等特效,同时结合物品识别、智能推荐、边看边买等技术,有效提升购买转化。 |

功能特性

一体化SDK

MediaBox音视频SDK目前提供四个场景的一体化SDK:基础直播SDK、互动直播SDK、短视频场景SDK、标准一体化SDK。

一体化SDK | 基础直播SDK | 互动直播SDK | 短视频场景SDK | 标准一体化SDK |

SDK名称 | AliVCSDK_BasicLive | AliVCSDK_InteractiveLive | AliVCSDK_UGC | AliVCSDK_Standard |

包含的SDK |

|

|

|

|

适用场景 | 适用于在线教育、音乐教学、等直播场景。 | 在基础直播场景上,提供稳定流畅的点对点和多人实时音视频通话服务,支持多人音视频或纯音频互动。 | 适用于端到端的短视频创作,搭配强大的视频播放功能提供流畅高清的播放体验,满足主流音视频场景的玩法。 | 适用于各类直播场景,如生活直播、在线教育、视频社交、游戏娱乐等场景,提供人脸美颜、美型、美妆、滤镜、贴纸等编辑加工能力,通过美颜特效支持更多直播和视频制作创意玩法。 |

各模块独立SDK

各模块独立SDK主要包括:播放器SDK、直播推流SDK、短视频SDK、美颜特效SDK。

功能 | 播放器SDK | 直播推流SDK | ARTC SDK | 短视频SDK | 美颜特效SDK |

主播开播 | 支持 | ||||

| 支持 (互动版) | 支持 | |||

音视频通话 | 支持 | ||||

视频录制 | 支持 | ||||

视频编辑 | 支持 | ||||

视频上传 | 支持 | ||||

直播播放 | 支持 | ||||

点播播放 | 支持 | ||||

美颜特效 | 支持 | ||||

手势识别 | 支持 | ||||

智能抠图 | 支持 |

您可以根据实际需求选择相应的SDK或其组合,各场景详细组合方式说明及SDK选择,请参见SDK选择与下载。建议您使用MediaBox音视频SDK的标准一体化SDK,可有效解决单独集成多款SDK时引起的依赖库冲突问题。

AUI Kits低代码应用方案

AUI Kits提供场景化方案的技术实现。您可以根据业务需要复用方案中的功能模块,快速搭建互动直播、互动课堂、远程监考等功能场景,可有效降低研发成本和周期,提升业务效果。

更多信息请参见什么是AUI Kits。

License管理

播放器移动端SDK、美颜特效SDK等都已经正式收费,其他部分SDK虽不收费,但需要License授权。您可以选择免费试用或通过音视频终端SDK购买页购买正式版,同时还有更优惠的组合购买套餐供您选择,详情请参见播放器SDK计费。购买后授权操作指引接入License。