本文为您介绍如何通过EAS一键部署Llama3的开源大模型服务,以及该服务支持的WebUI界面化操作。

背景信息

Llama-3开源80亿参数和700亿参数两个尺寸,同步开源基座和对话模型。Llama-3在模型架构上继承前代整体结构,将上下文长度从4K增加到了8K。在具体性能评测中,Llama-3基座模型和对话模型相比前代模型,在学科能力、推理能力、知识能力、理解能力等多个能力维度的评测集上均获得很高的效果提升。

部署EAS服务

进入模型在线服务页面。

登录PAI控制台。

在左侧导航栏单击工作空间列表,在工作空间列表页面中单击待操作的工作空间名称,进入对应工作空间内。

在工作空间页面的左侧导航栏选择模型部署>模型在线服务(EAS),进入模型在线服务页面。

在模型在线服务(EAS)页面,单击部署服务,然后在场景化模型部署区域,单击LLM大语言模型部署。

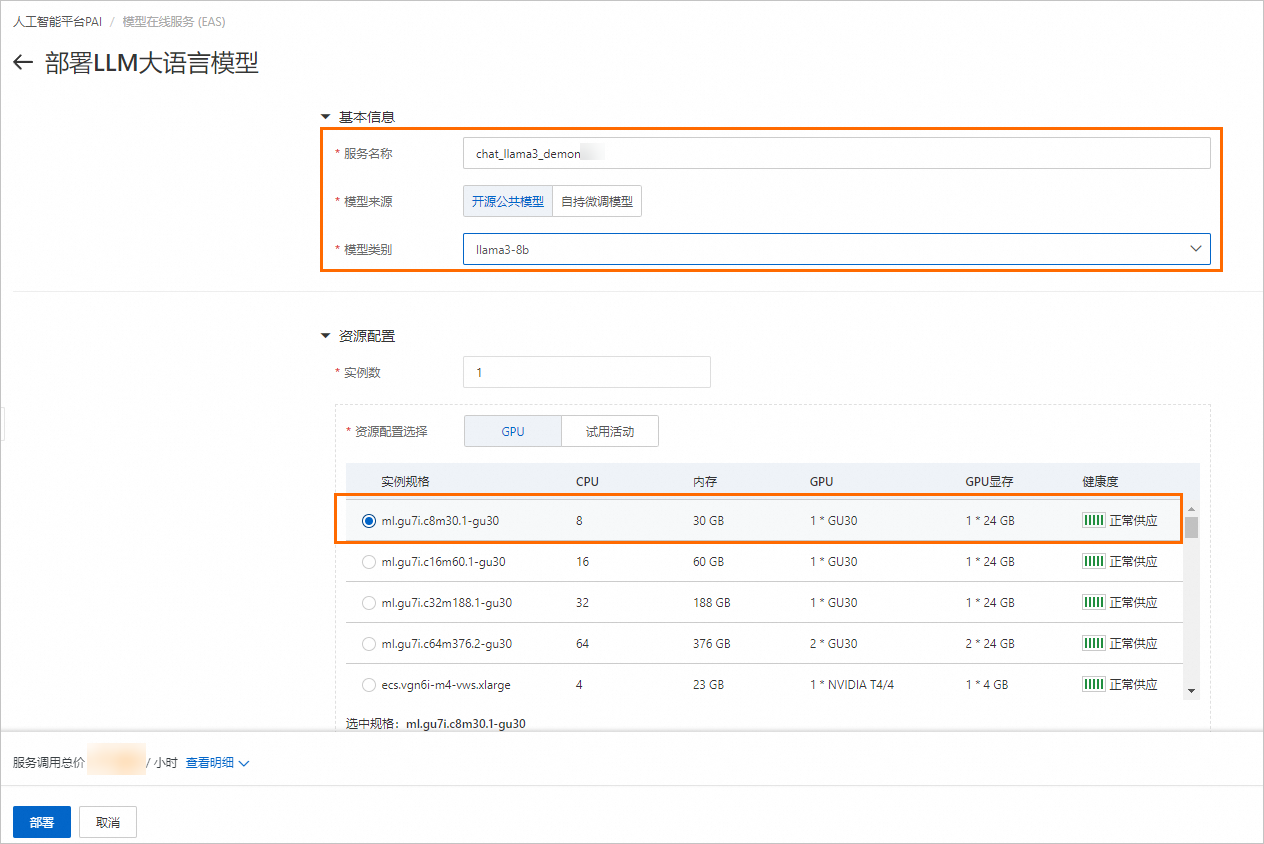

在部署LLM大语言模型页面,配置以下关键参数,其他参数使用默认配置。

参数

描述

参数

描述

服务名称

自定义服务名称。本方案使用的示例值为:chat_llama3_demo。

模型来源

选择开源公共模型。

模型类别

选择llama3-8b。

资源配置选择

推荐使用华北2(北京)地域,实例规格推荐使用ml.gu7i.c8m30.1-gu30。

如果上述资源库存不足,也可使用ecs.gn6i-c24g1.12xlarge规格。

单击部署,持续时间大约为3分钟,即可完成模型部署。

当服务状态为运行中时,表示服务部署成功。

启动WebUI进行模型推理

单击目标服务的服务方式列下的查看Web应用。

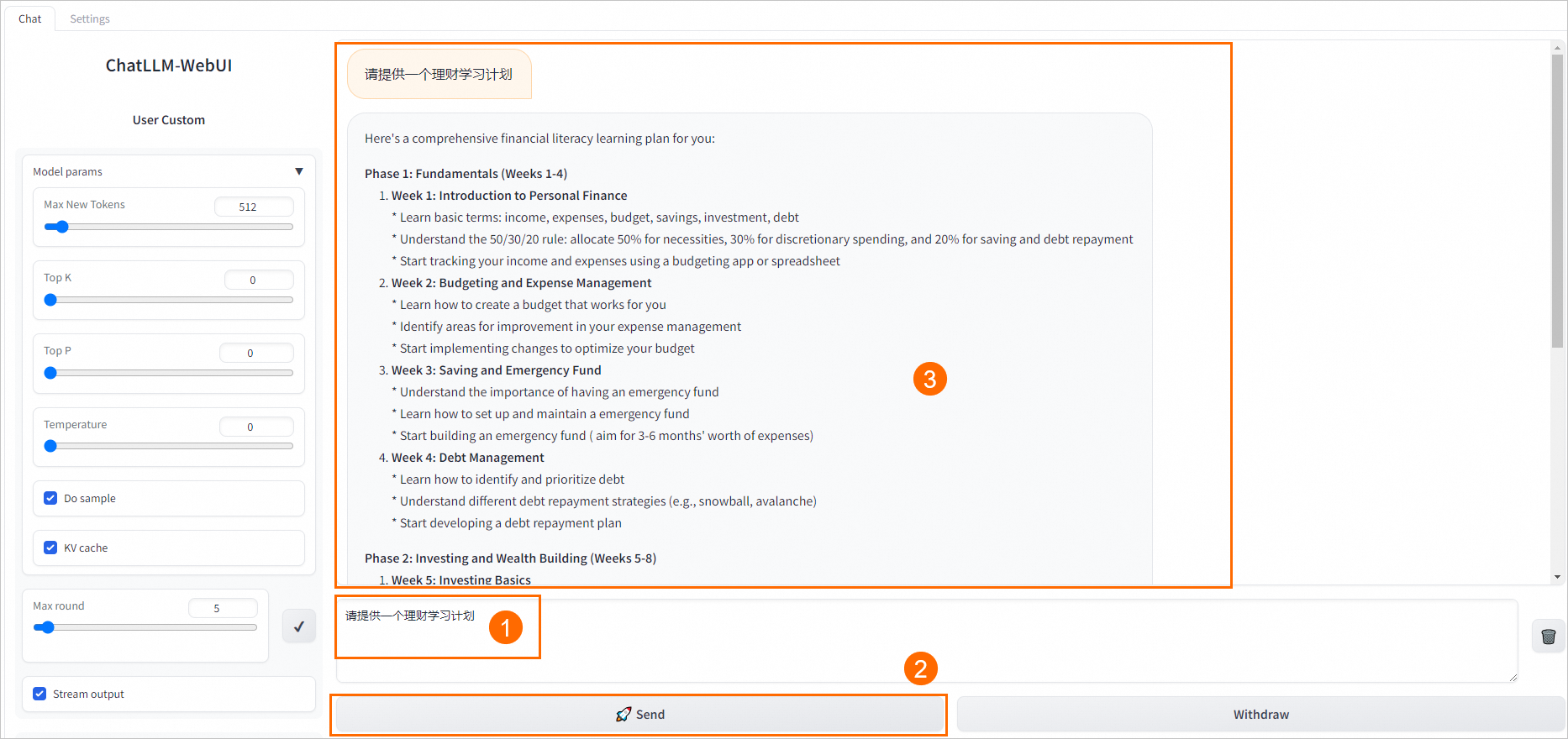

在WebUI页面,进行模型推理验证。

在对话框下方的输入界面输入对话内容,例如

请提供一个理财学习计划,单击Send,即可开始对话。

相关文档

若需了解ChatLLM-WebUI的重要版本发布信息,请参见ChatLLM-WebUI版本发布详情。

该文章对您有帮助吗?

- 本页导读 (1)

- 背景信息

- 部署EAS服务

- 启动WebUI进行模型推理

- 相关文档