在重复性强的 AI 请求场景,通过将大语言模型(LLM)生成的响应结果缓存到 Redis 数据库中,避免重复调用大语言模型,提升响应速度。本文将为您介绍缓存策略的功能优势,以及开启步骤。

策略说明

提升性能:通过快速从缓存中获取结果,显著降低响应时间以及后端服务器的负载压力。

减少重复计算:对于相同的AI请求,直接返回缓存中的响应数据,避免重复调用大语言模型。

快速响应:发起重复请求时,能够立即获得响应,无需等待二次处理,显著提升用户的满意度和体验。

前提条件

已完成AI API创建。

操作步骤

登录云原生API网关控制台。

在左侧导航栏,选择API,并在顶部菜单栏选择地域。

单击AI API页签。在AI API列表中,单击目标API,进入目标API详情页面。

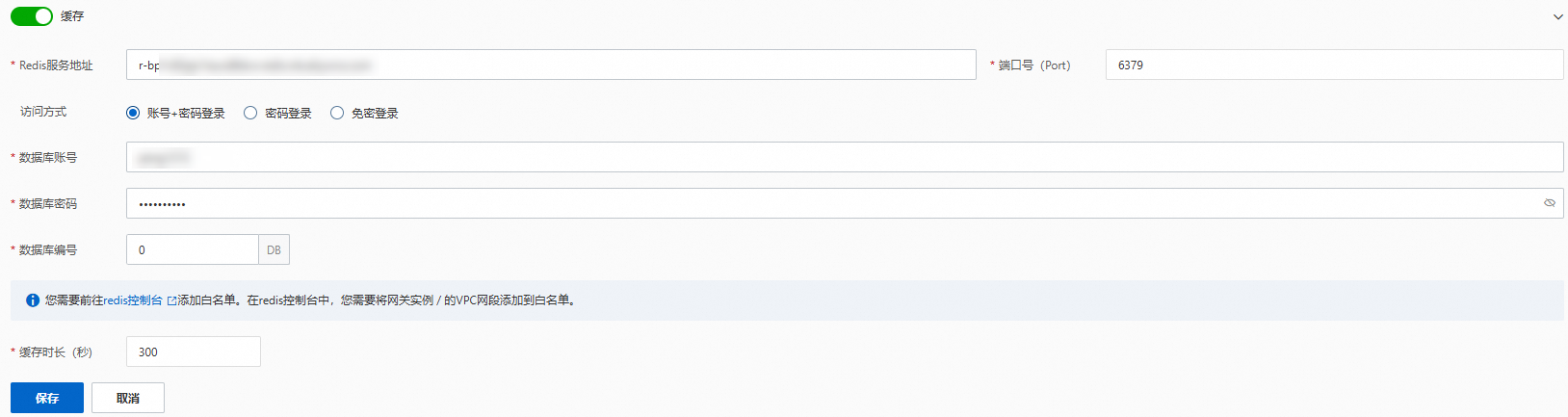

选择策略与插件页签,开启缓存,配置相关参数,单击保存。

请前往Redis控制台添加白名单。在Redis控制台中,您需要将网关实例的VPC网段添加至白名单。

携带请求头

x-higress-skip-ai-cache: on时,当前请求将不会使用缓存中的内容,而是直接转发给后端服务,同时也不会缓存该请求返回响应的内容。

配置项

说明

配置项

说明

缓存

开启或关闭缓存开关,默认关闭。

Redis服务地址

Redis服务地址。

访问方式

Redis服务访问方式。

账号+密码登录。

密码登录。

免密登录。

数据库账号

数据库账号。

数据库密码

数据库密码。

数据库编号

指定的数据库编号。

缓存时长(秒)

缓存时长默认为1800秒,在缓存时长内,如果API接收到相同的AI请求,则会跳过LLM请求,直接返回缓存的响应数据。

该文章对您有帮助吗?

- 本页导读 (1)

- 策略说明

- 前提条件

- 操作步骤